这是本节的多页打印视图。

点击此处打印 .

返回本页常规视图 .

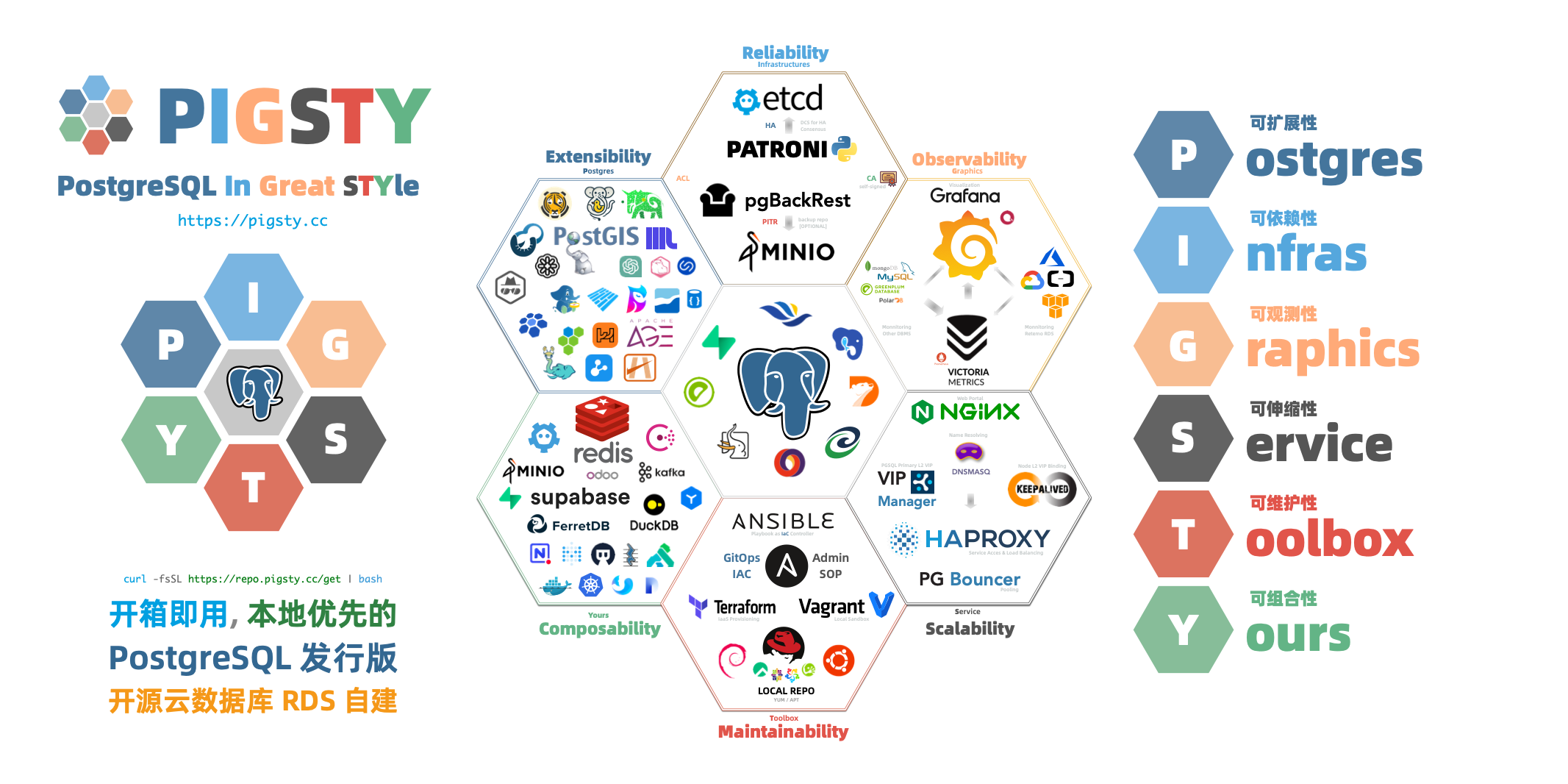

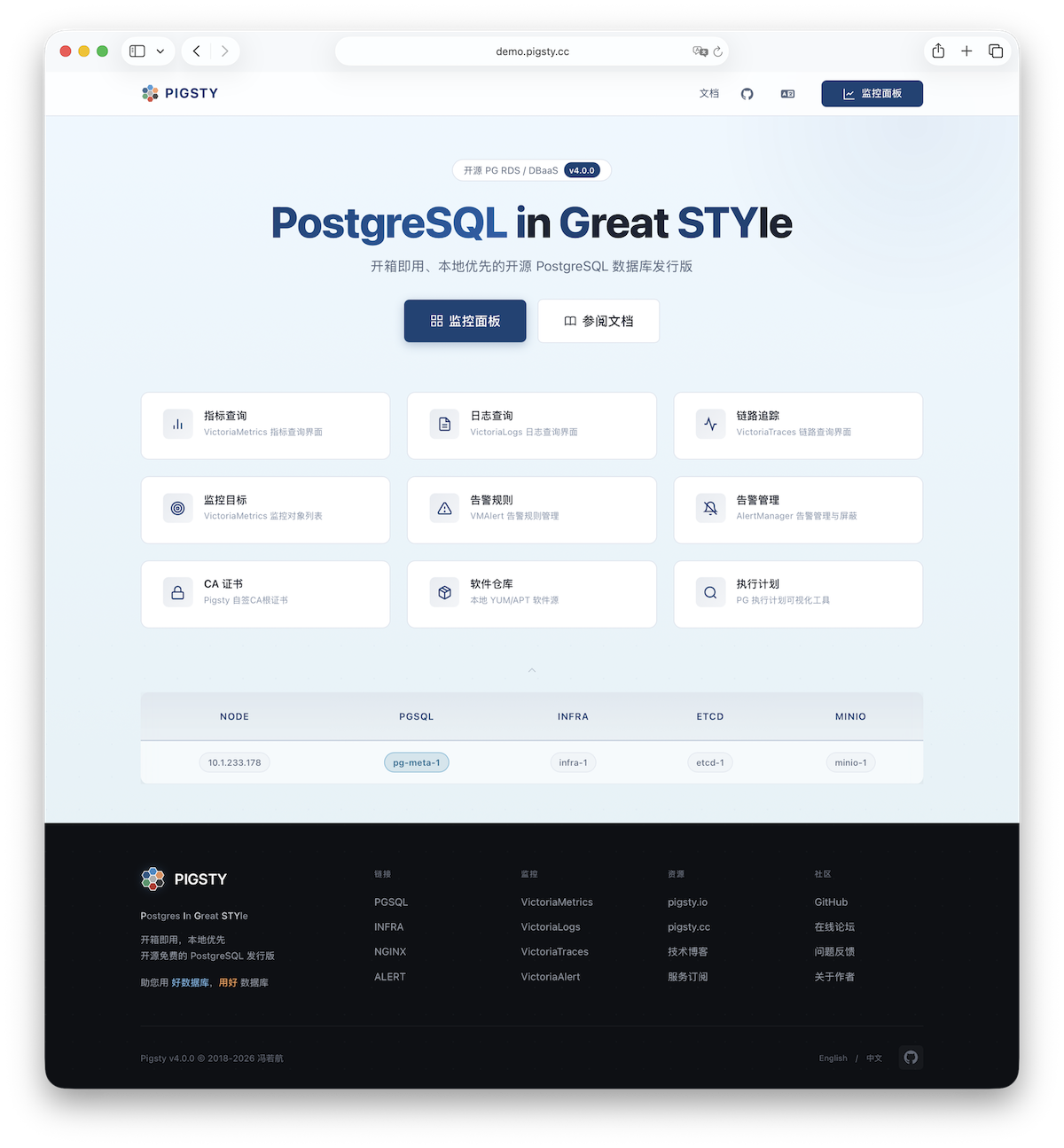

Pigsty 中文文档 v4.2 “P ostgreSQL I n G reat STY le”: P ostgres, I nfras, G raphics, S ervice, T oolbox, it’s all Y ours.

—— 开箱即用、本地优先的 PostgreSQL 发行版,开源 RDS 替代

仓库 | 演示 | 博客 | 论坛 | 微信 | EN Docs

快速上手 最新版本的 Pigsty:curl -fsSL https://repo.pigsty.cc/get | bash -s v4.2.0

关于 功能特性 | 历史沿革 | 活动新闻 | 加入社区 | 隐私政策 | 开源协议 | 赞助我们 | 服务订阅

概念 系统架构 | 集群模型 | 监控系统 | IaC | HA | PITR | 服务接入 | 安全加固

上手 单机安装 | 离线安装 | 资源准备 | 声明配置 | 执行剧本 | 安全考量 | 常见问题

部署 架构规划 | 资源准备 | 生产部署 | 沙箱环境 | Vagrant | Terraform

参考 操作系统 | 扩展列表 | 文件结构 | 同类产品 | 成本参考 | 应用模板 | 配置模板

模块 PGSQL | INFRA | NODE | ETCD | MINIO | REDIS | FERRET | DOCKER | PILOT

1 - PIGSTY 2 - 关于 了解 Pigsty 项目本身的方方面面:功能特性、历史发展,开源协议,隐私政策,社区活动与新闻。

2.1 - 亮点特性 Pigsty 的价值主张与亮点功能特性。

“P ostgreSQL I n G reat STY le”: P ostgres, I nfras, G raphics, S ervice, T oolbox, it’s all Y ours.

—— 开箱即用、本地优先的 PostgreSQL 发行版,开源 RDS 替代

价值主张

总览 Pigsty 是一个更好的本地开源 RDS for PostgreSQL 替代:

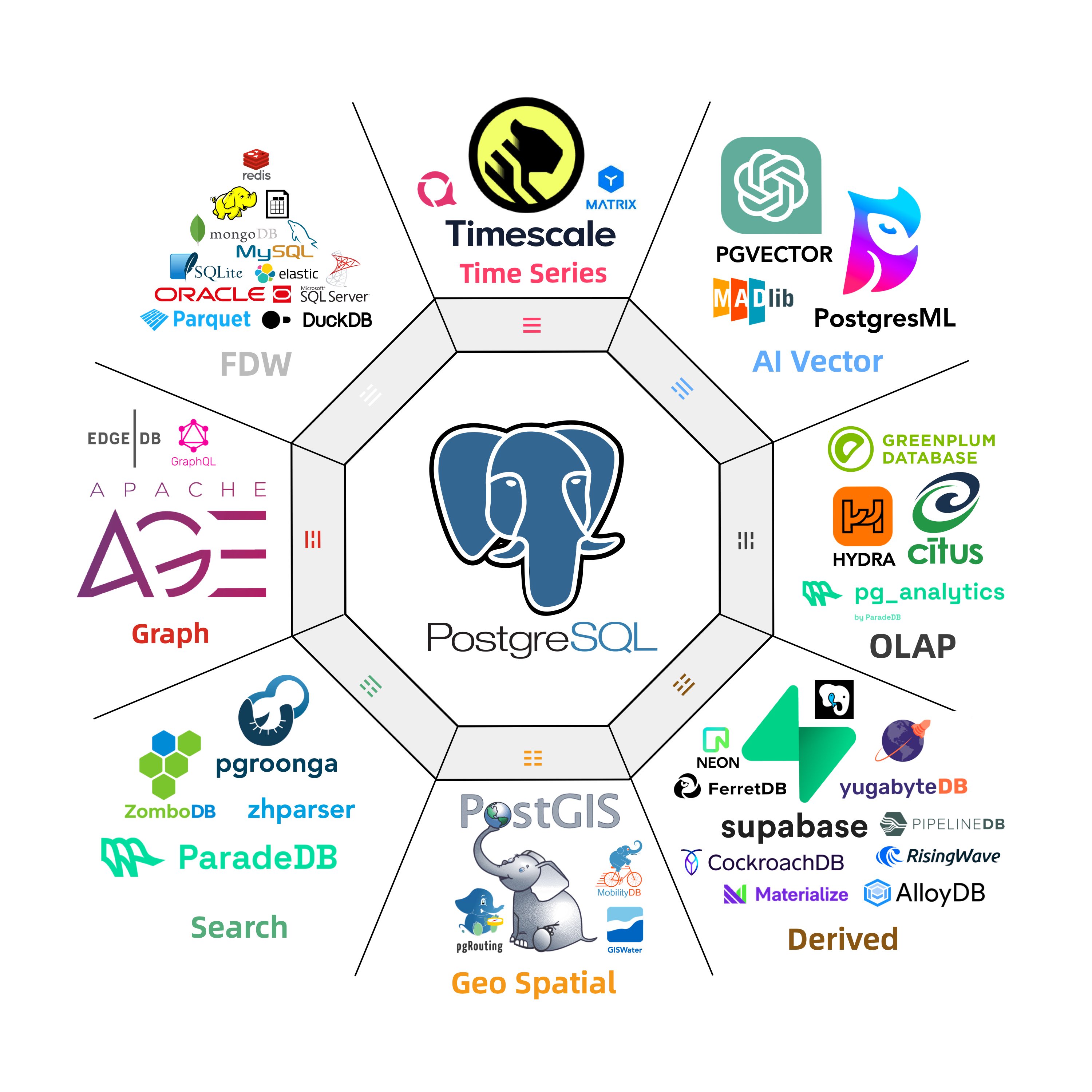

开箱即用的RDS :从内核到RDS发行版,在 EL/Debian/Ubuntu 下提供 13-18 版本的生产级 PG 数据库服务。丰富的扩展插件 :提供无可比拟的 451 扩展,提供开箱即用的分布式的时序地理空间图文向量多模态数据库能力。灵活的模块架构 :灵活组合,自由扩展:Redis/Etcd/MinIO/Mongo;可独立使用,监控现有RDS/主机/数据库。惊艳的观测能力 :基于现代可观测性技术栈 Prometheus/Grafana,提供令人惊艳,无可比拟的数据库观测能力。验证过的可靠性 :故障自愈的高可用架构:硬件故障自动切换,流量无缝衔接。并提供自动配置的 PITR 兜底删库!简单易用可维护 :声明式API,GitOps就位,傻瓜式操作,Database/Infra-as-Code 以及管理SOP封装管理复杂度!扎实的安全实践 :加密备份一应俱全,自带基础ACL最佳实践。只要硬件与密钥安全,您无需操心数据库的安全性!广泛的应用场景 :低代码数据应用开发,或使用预置的 Docker Compose 模板,一键拉起使用PostgreSQL的海量软件!开源的自由软件 :以云数据库1/10不到的成本拥有与更好的数据库服务!帮您真正“拥有”自己的数据,实现自主可控!PostgreSQL 整合了生态中的工具与最佳实践:

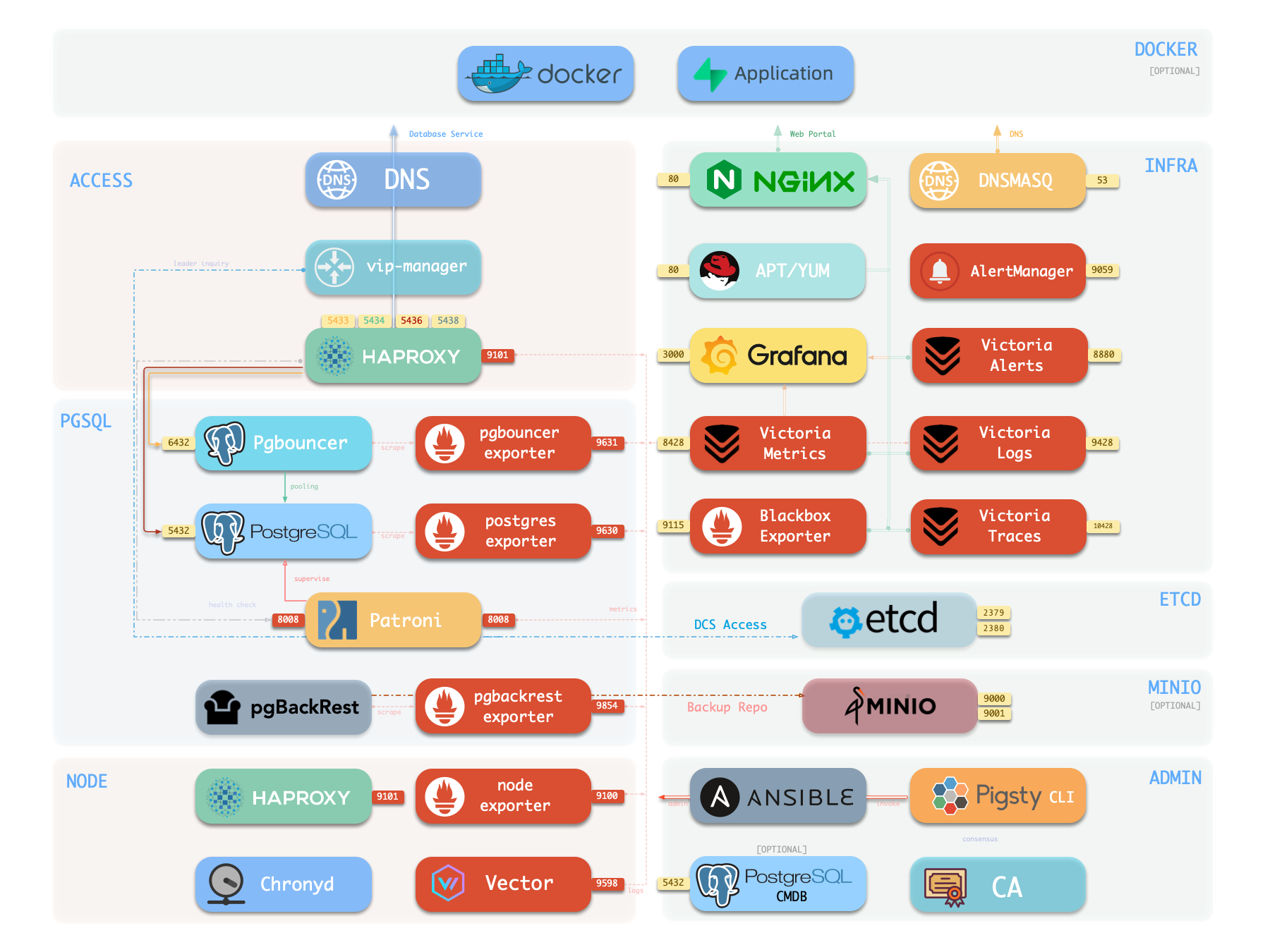

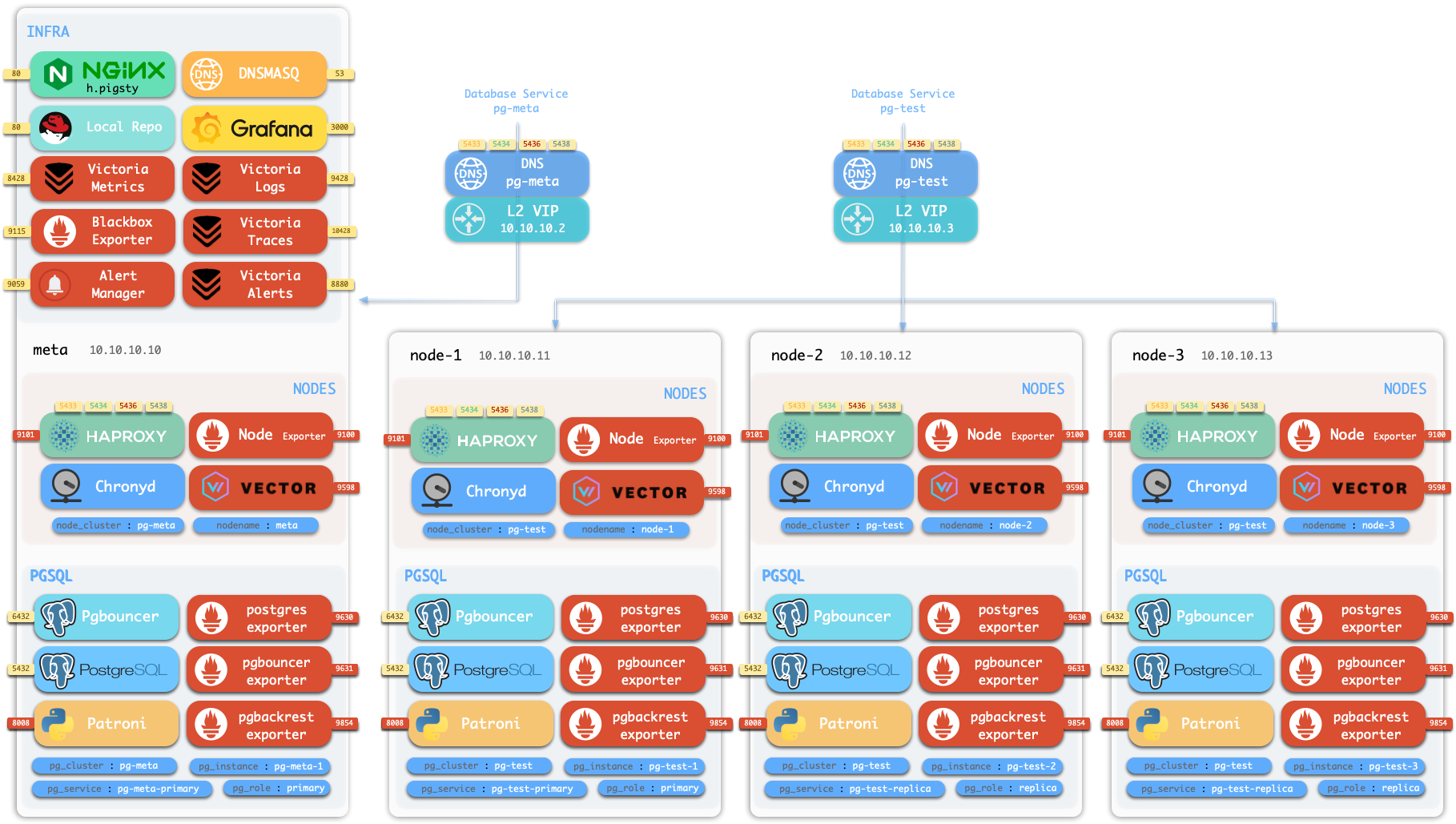

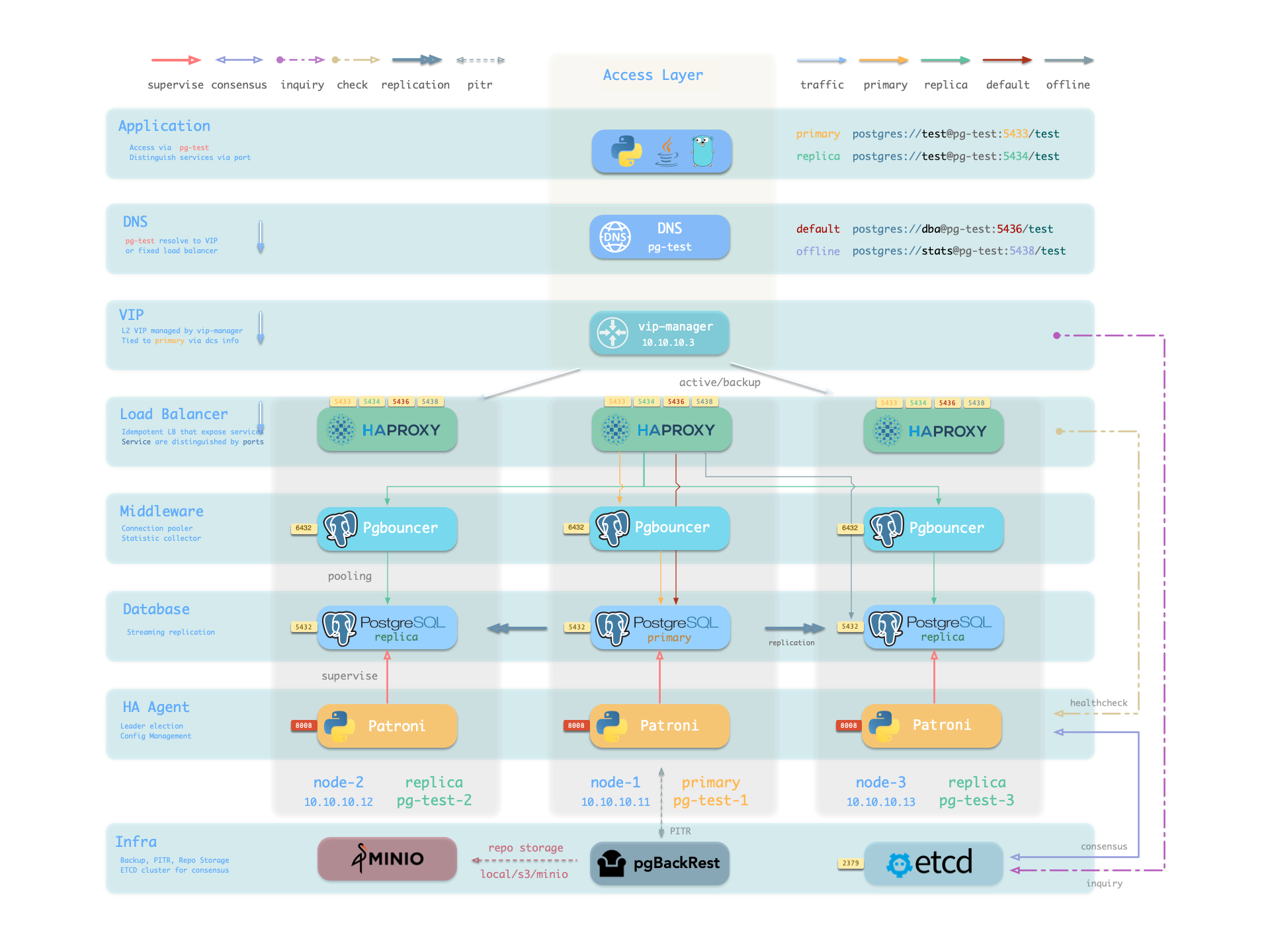

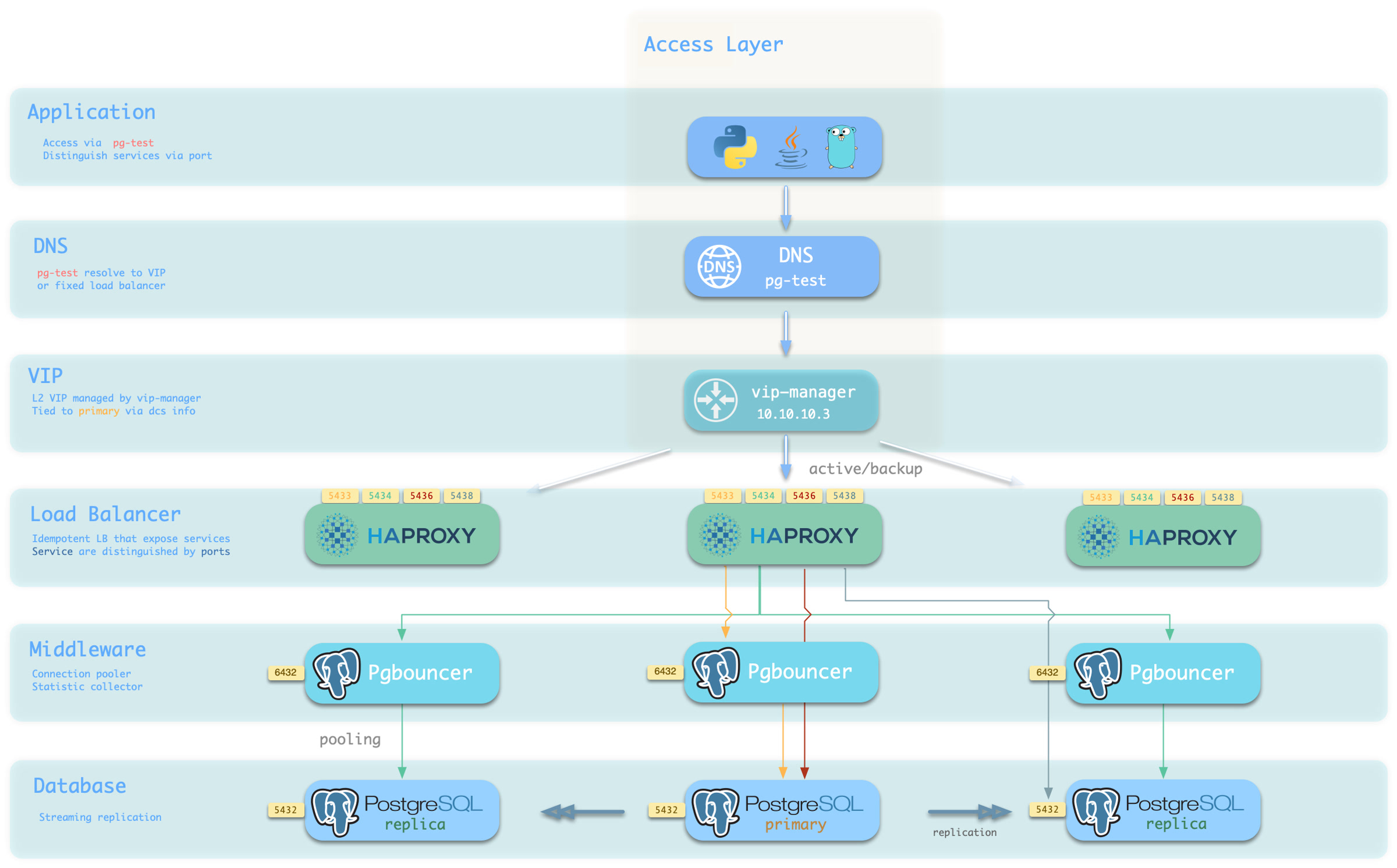

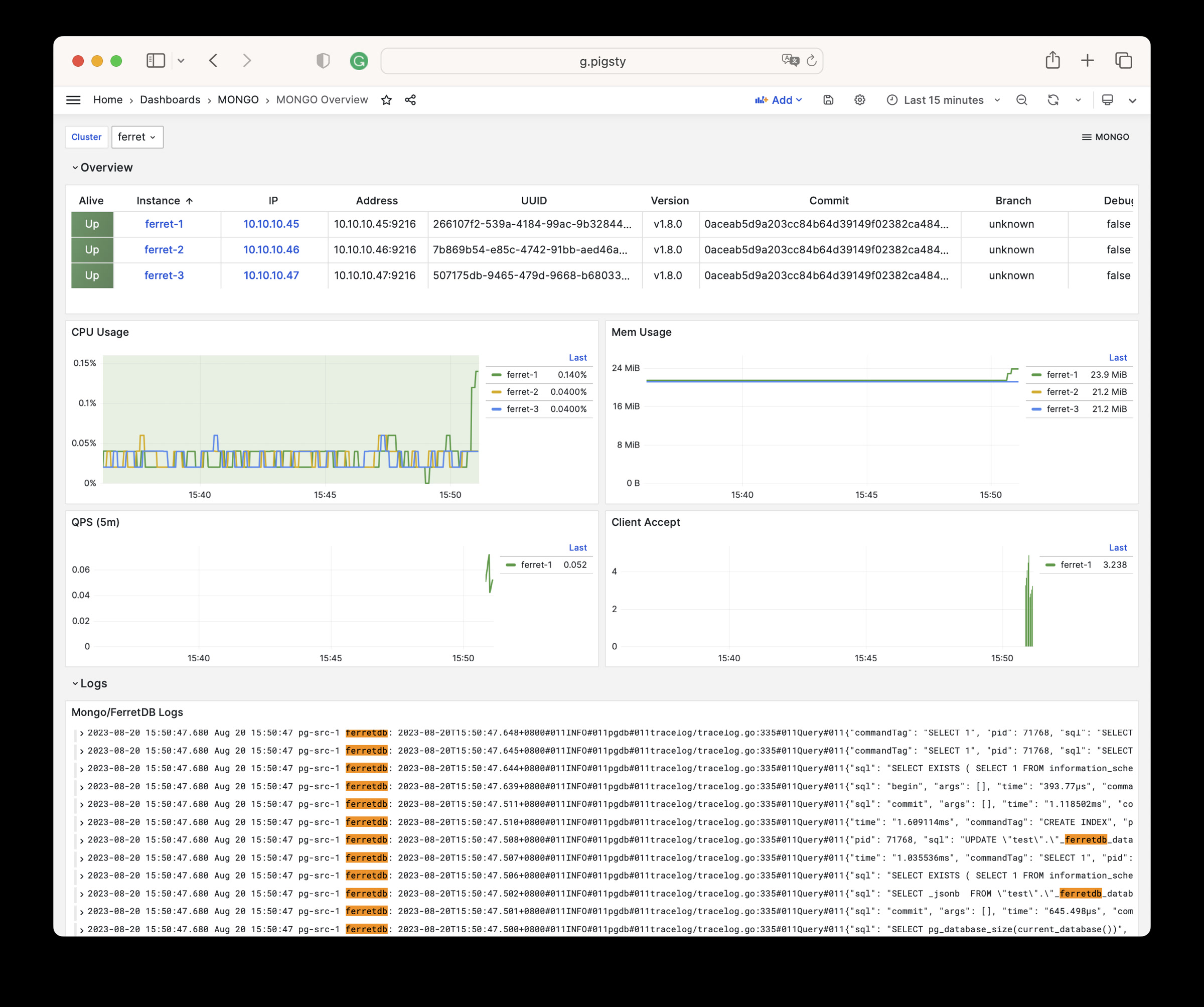

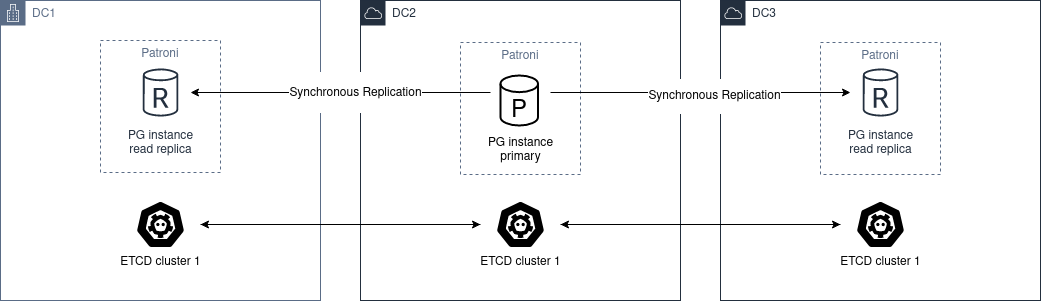

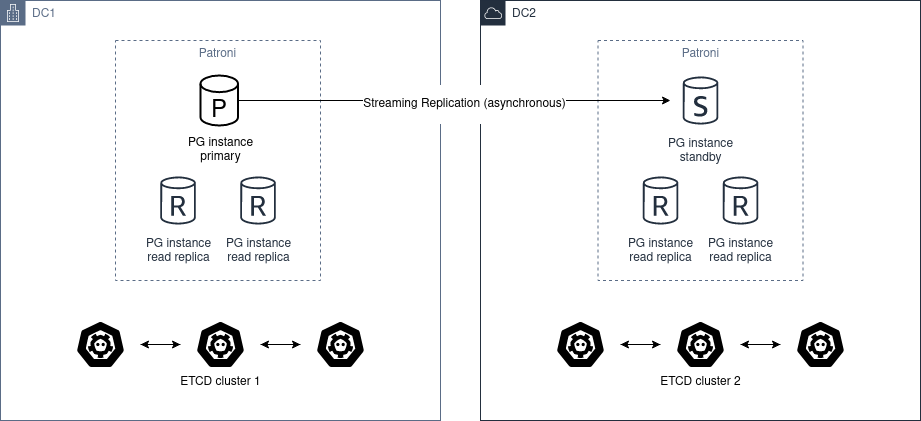

开箱即用的 PostgreSQL 发行版,深度整合地理、时序、分布式、图、向量、搜索、AI等 451 个 扩展插件 ! 运行于裸操作系统之上,无需容器支持,支持主流操作系统: EL 8/9/10, Ubuntu 22.04/24.04 以及 Debian 12/13。 基于 patroni , haproxy , 与 etcd ,打造故障自愈的高可用架构:硬件故障自动切换,流量无缝衔接。 基于 pgBackRest 与可选的 MinIO 集群提供开箱即用的 PITR 时间点恢复,为软件缺陷与人为删库兜底。 基于 Ansible 提供声明式的 API 对复杂度进行抽象,以 Database-as-Code 的方式极大简化了日常运维管理操作。 Pigsty用途广泛,可用作完整应用运行时,开发演示数据/可视化应用,大量使用 PG 的软件可用 Docker 模板一键拉起。 提供基于 Vagrant 的本地开发测试沙箱环境,与基于 Terraform 的云端自动部署方案,开发测试生产保持环境一致。 部署并监控专用的 Redis (主从,哨兵,集群),MinIO,Etcd,Haproxy,MongoDB (FerretDB ) 集群 开箱即用的RDS 让您立刻在本地拥有生产级的PostgreSQL数据库服务!

PostgreSQL 是一个足够完美的数据库内核,但它需要更多工具与系统的配合才能成为一个足够好的数据库服务(RDS),Pigsty 帮助 PostgreSQL 完成这一步飞跃。

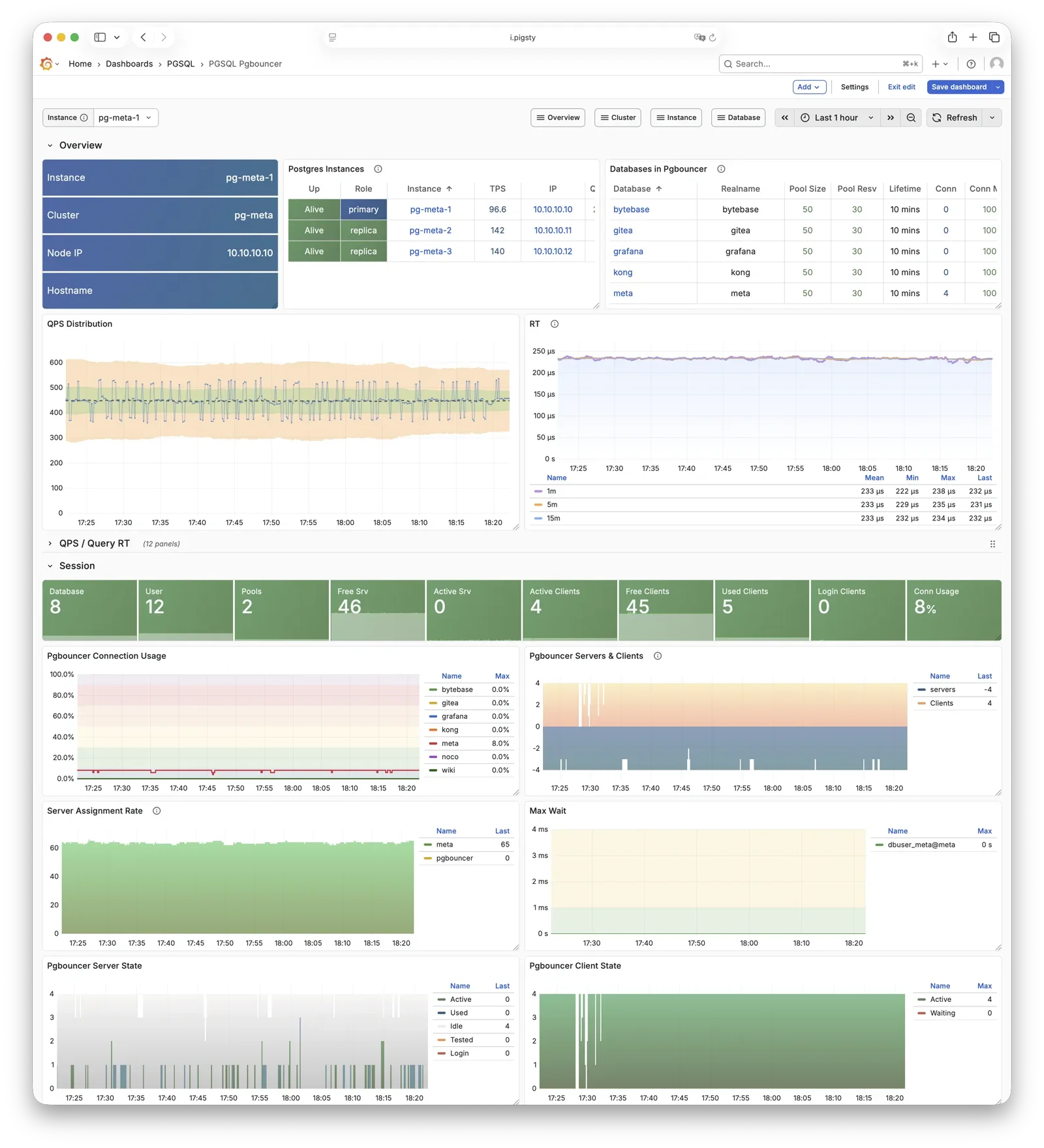

Pigsty 为您解决使用 PostgreSQL 中会遇到的各种难题:内核扩展安装,连接池,负载均衡,服务接入,高可用 / 自动故障切换,日志收集,指标监控,告警,备份恢复,PITR,访问控制,参数调优,安全加密,证书签发,NTP,DNS,参数调优,配置管理,CMDB,管理预案… 您无需再为这些细节烦心劳神!

Pigsty 支持 PostgreSQL 13 ~ 18 主干内核与其他兼容分支,可运行于 EL / Debian / Ubuntu 以及 兼容操作系统发行版 上,在 x86_64 与 ARM64 芯片架构上可用,且无需容器支持。

除了数据库内核与大量开箱即用的扩展插件以外,Pigsty 还提供了数据库服务所需的完整基础设施与运行时,以及本地沙箱 / 生产环境 / 云 IaaS 自动部署方案。

Pigsty 可以一键从裸机开始拉起整套环境,触达软件交付的最后一公里。普通研发运维均可快速上手并兼职进行数据库管理,无需数据库专家即可自建企业级RDS服务!

丰富的扩展插件 超融合多模态,一切皆用 PostgreSQL,一个PG替换所有数据库!

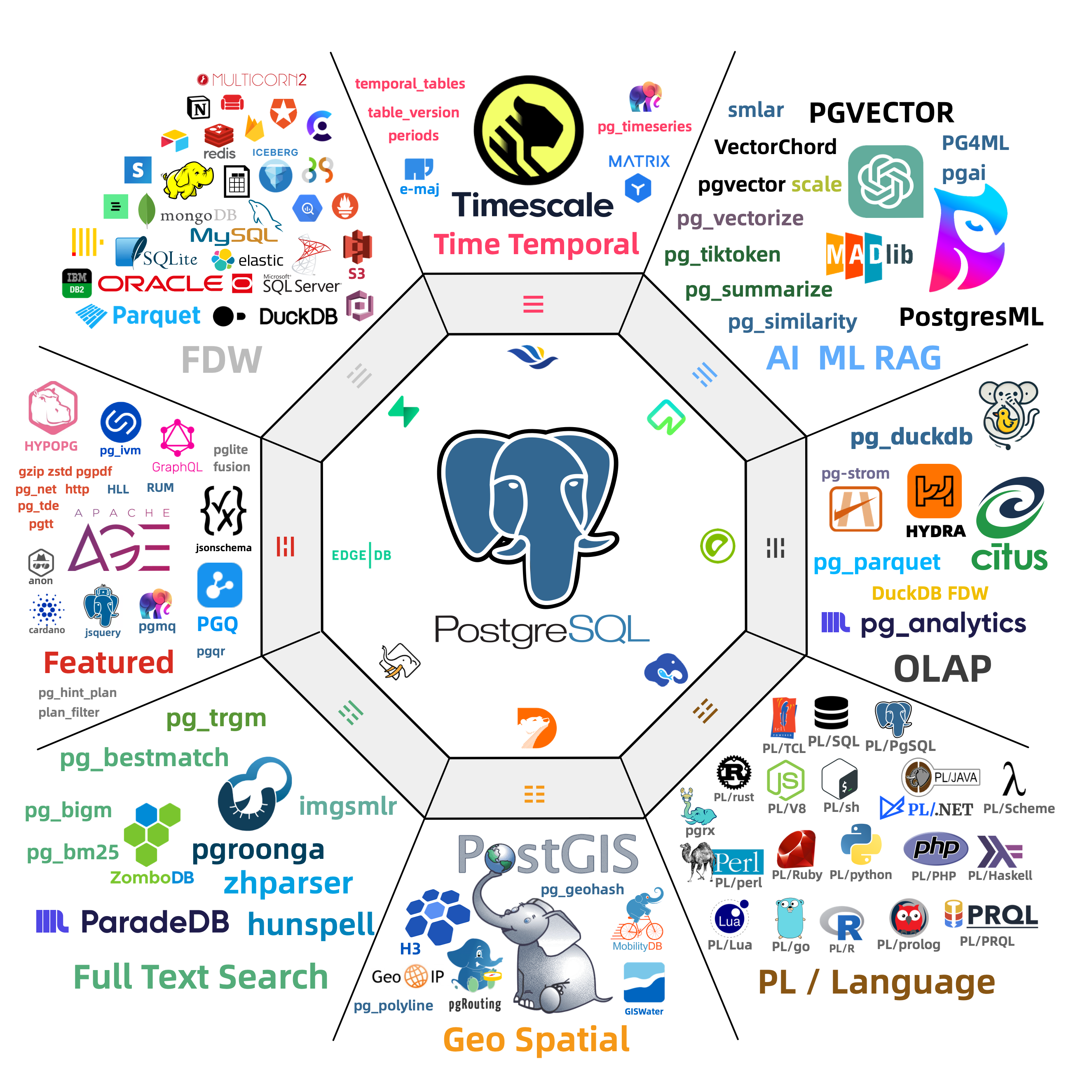

PostgreSQL 的灵魂在于其丰富的 扩展生态 451 扩展

插件间可以产生 协同效应 PostGIS TimescaleDB Citus PGVector ParadeDB pg_duckdb pg_mooncake

使用 PostgreSQL 单一组件替代 MySQL,Kafka,ElasticSearch,MongoDB,以及大数据分析技术栈已经成为一种最佳实践 —— 单一数据库选型能够显著降低系统复杂度,极大提高研发效能与敏捷性,实现程度惊人的软硬件,研发/运维人力降本增效。

灵活的模块架构 灵活组合,自由扩展,多数据库支持,监控现有RDS/主机/数据库

Pigsty 中的组件被抽象可独立部署的 模块 INFRANODEPGSQLETCD

除了上述四个 核心模块 之外,Pigsty 还提供一系列选装功能模块:MINIOREDISDOCKER

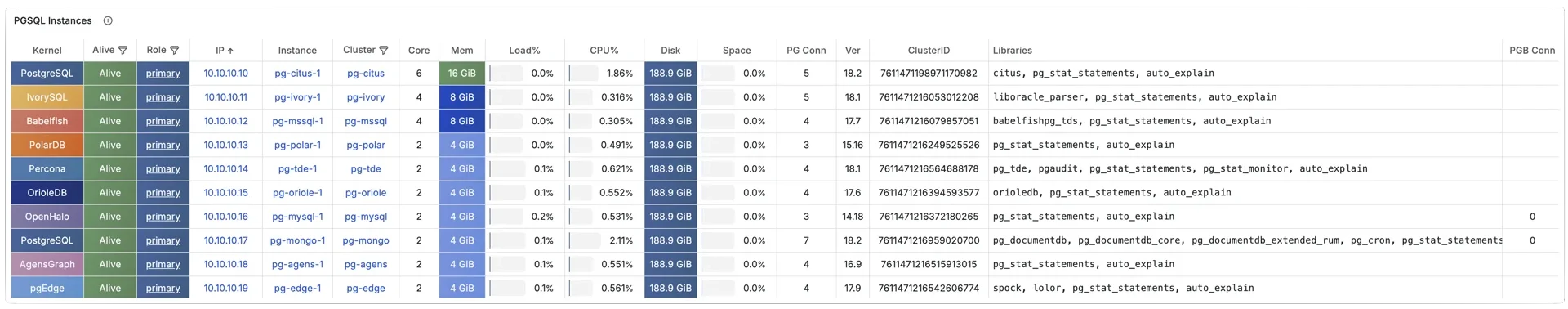

此外,Pigsty 还提供 PG 兼容 / 衍生内核的支持,您可以使用 BabelfishIvorySQLOpenHaloDBOrioleDB

不仅如此,你还可以使用 FerretDBSupabasePolarDBGPSQLKAFKA ,DUCKDB ,VICTORIA ,TIGERBEETLE ,KUBERNETES ,CONSUL ,JUPYTER ,GREENPLUM ,CLOUDBERRY ,MYSQL , …

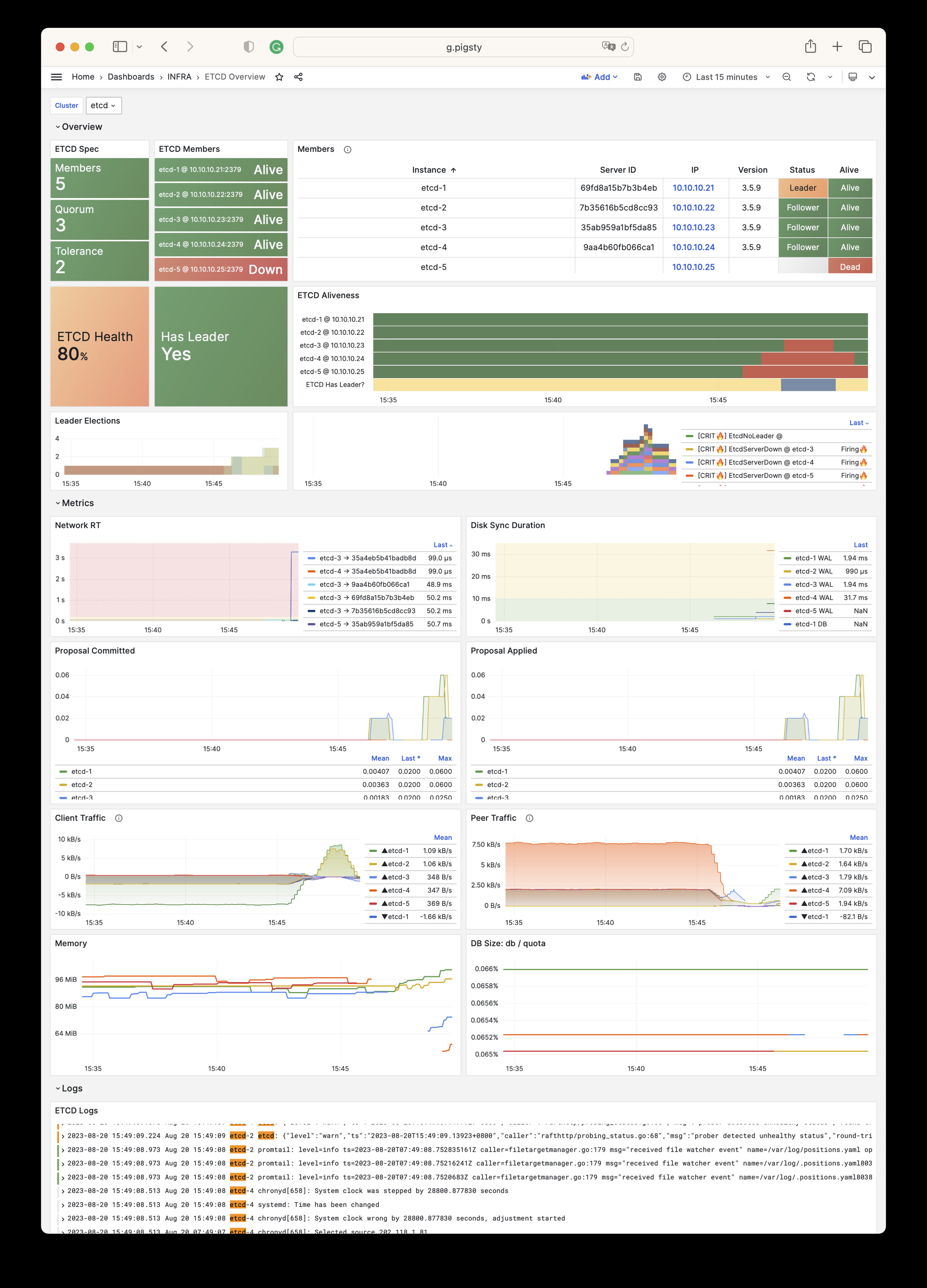

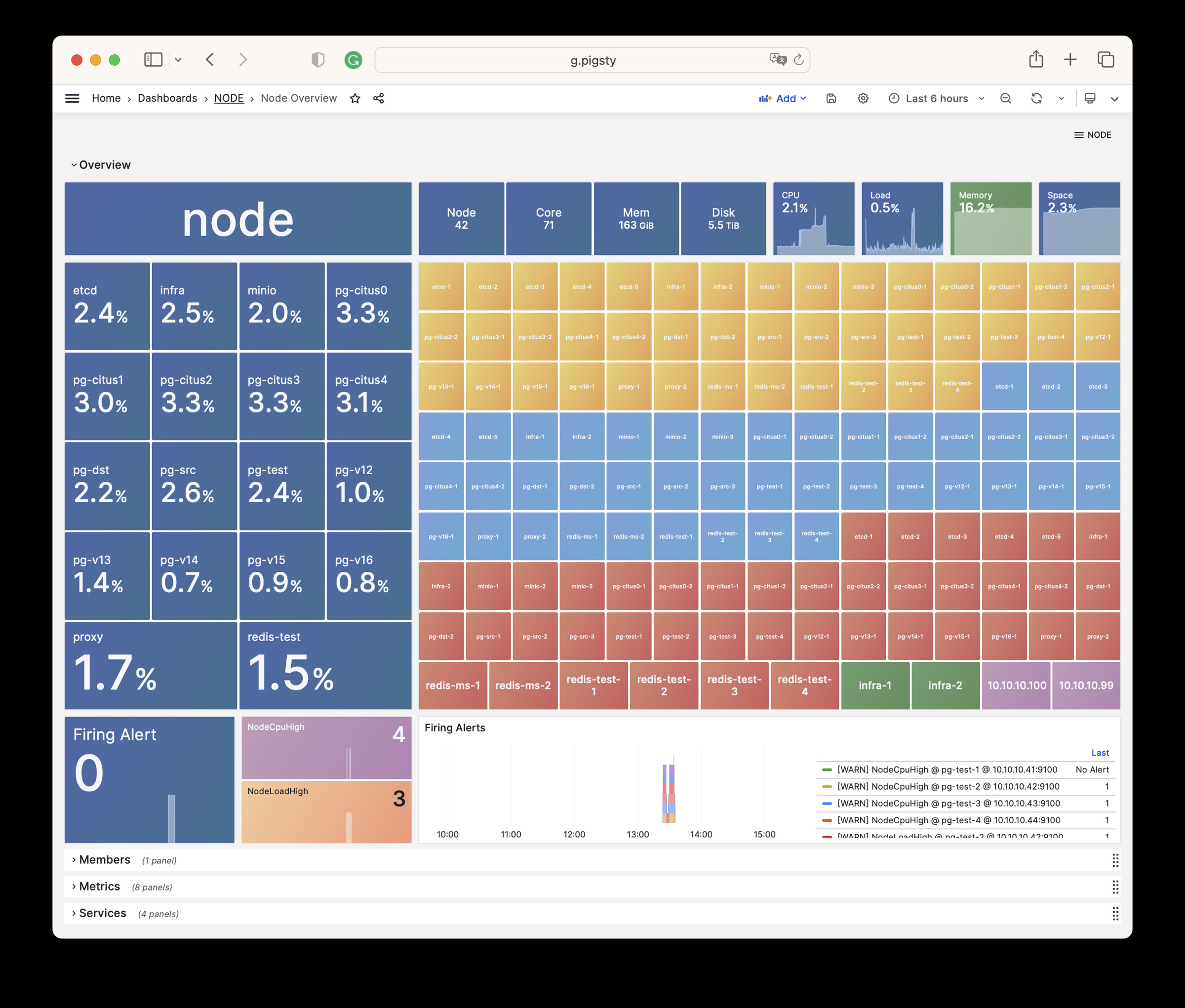

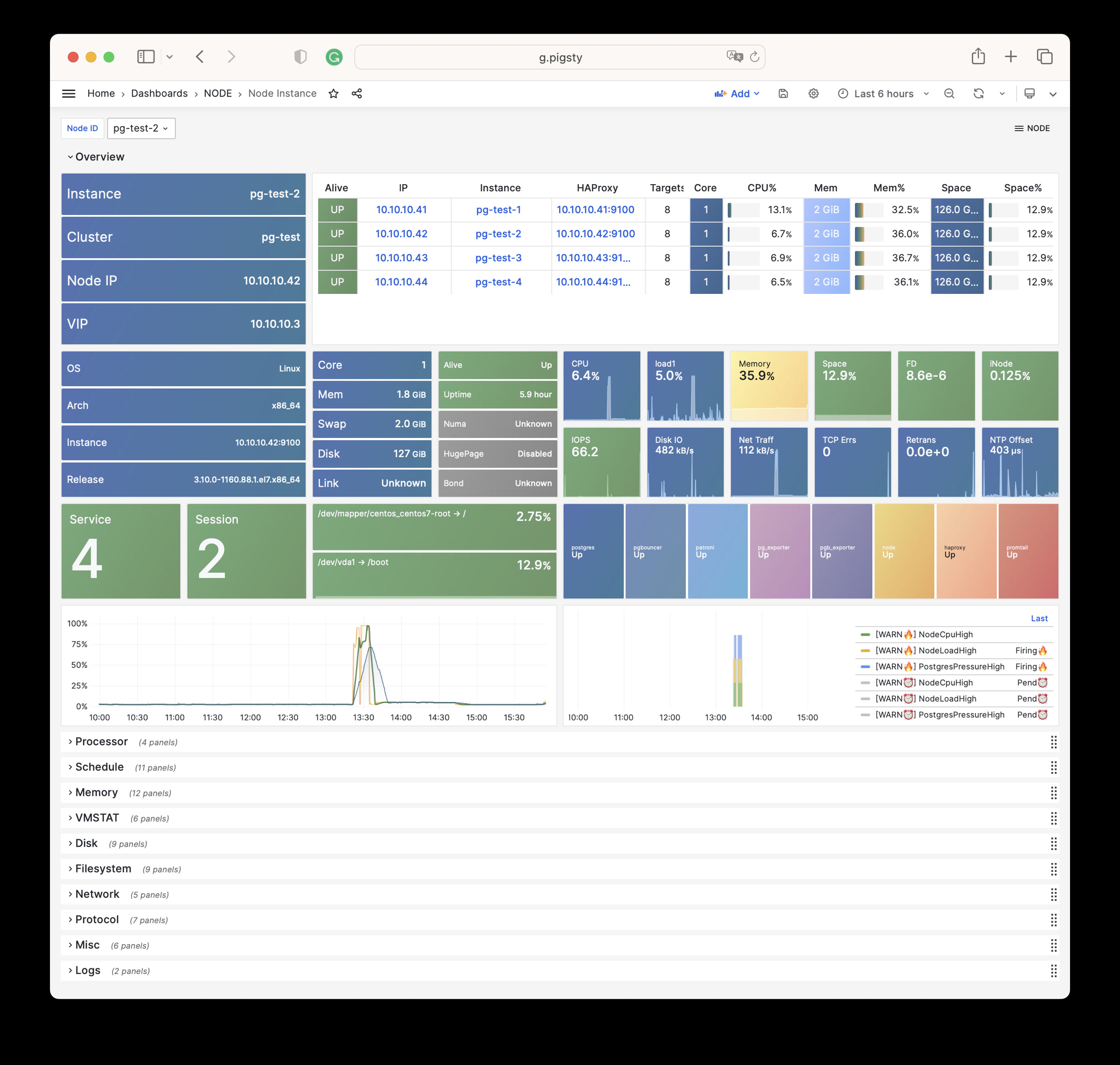

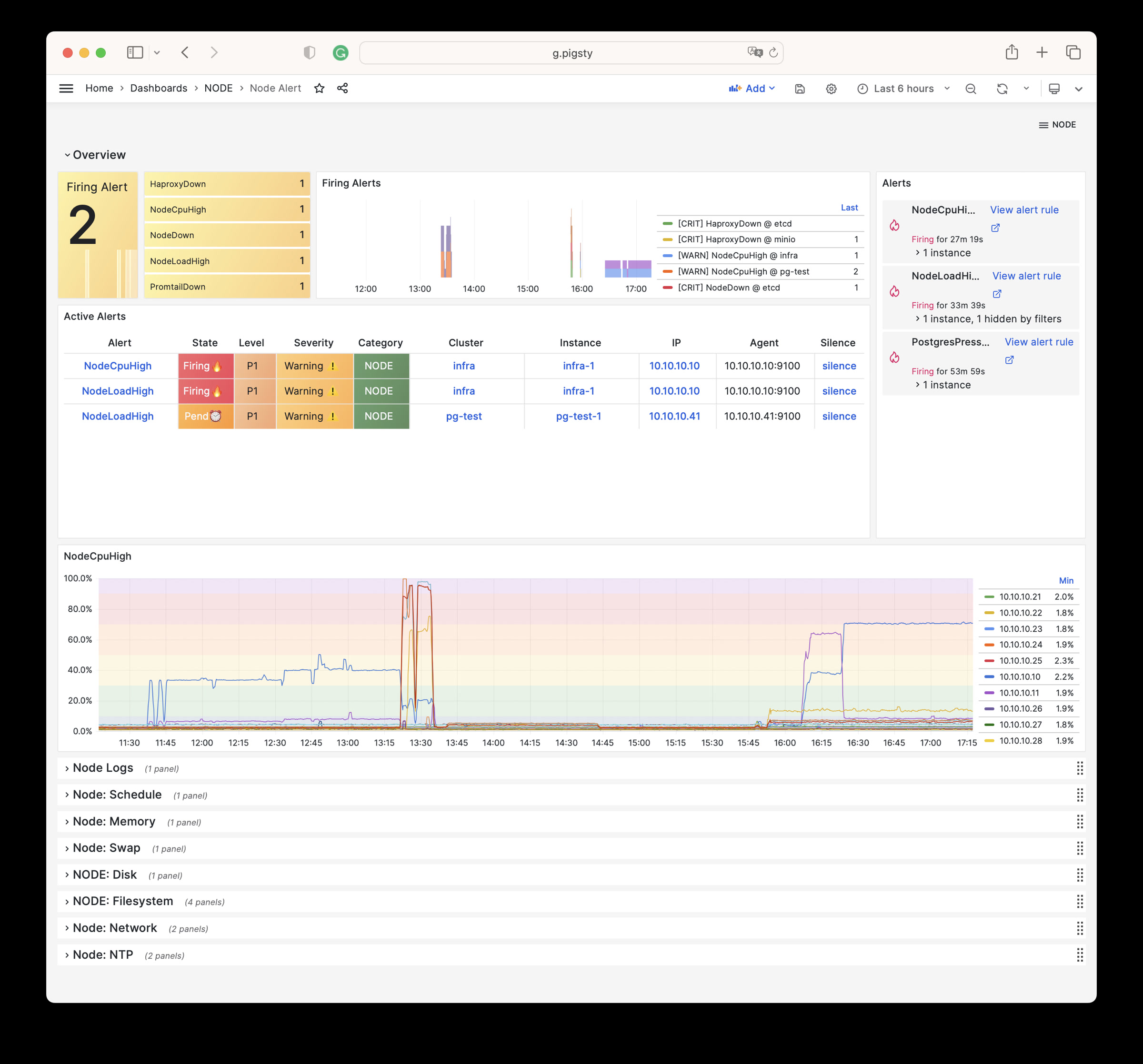

惊艳的观测能力 使用现代开源可观测性技术栈,提供无与伦比的监控最佳实践!

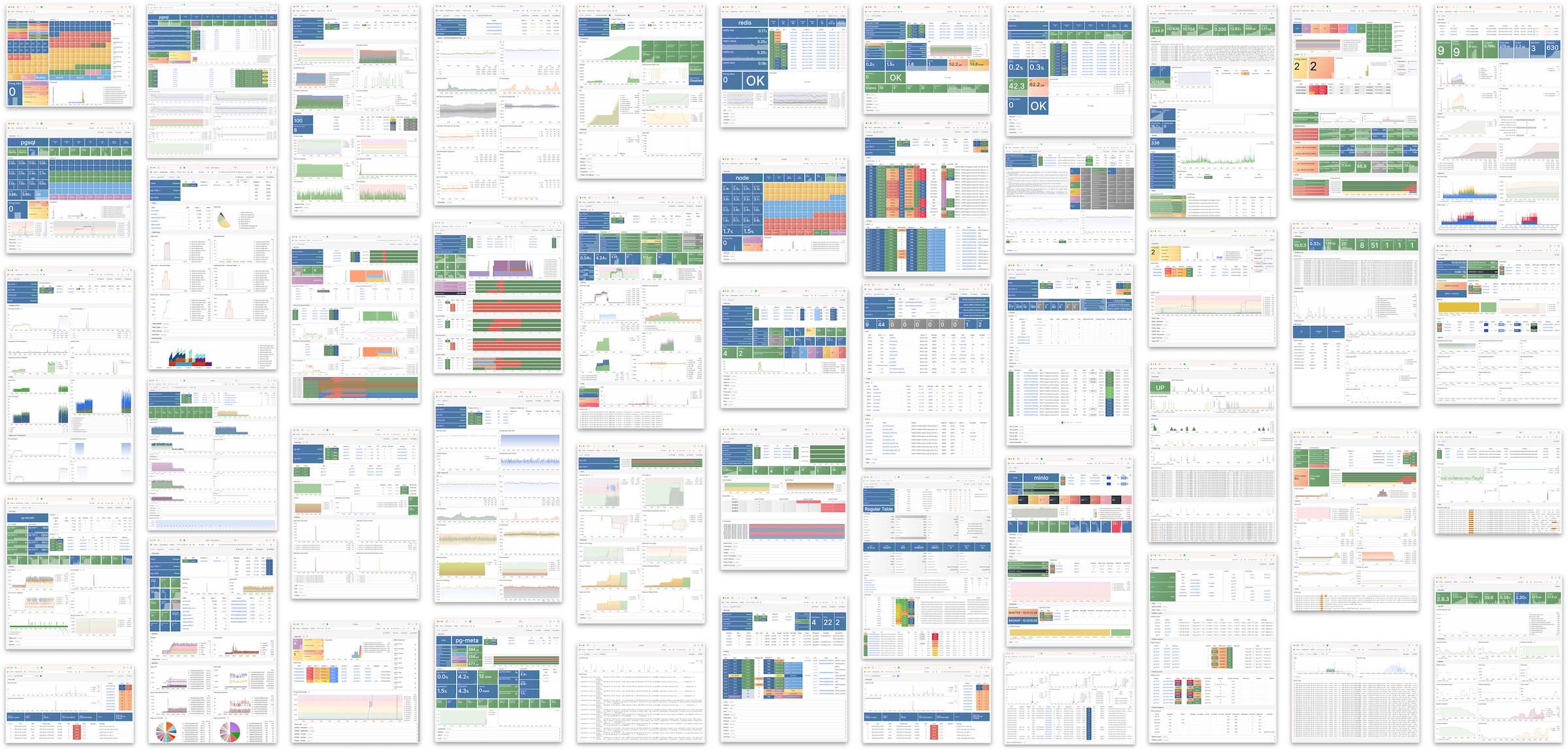

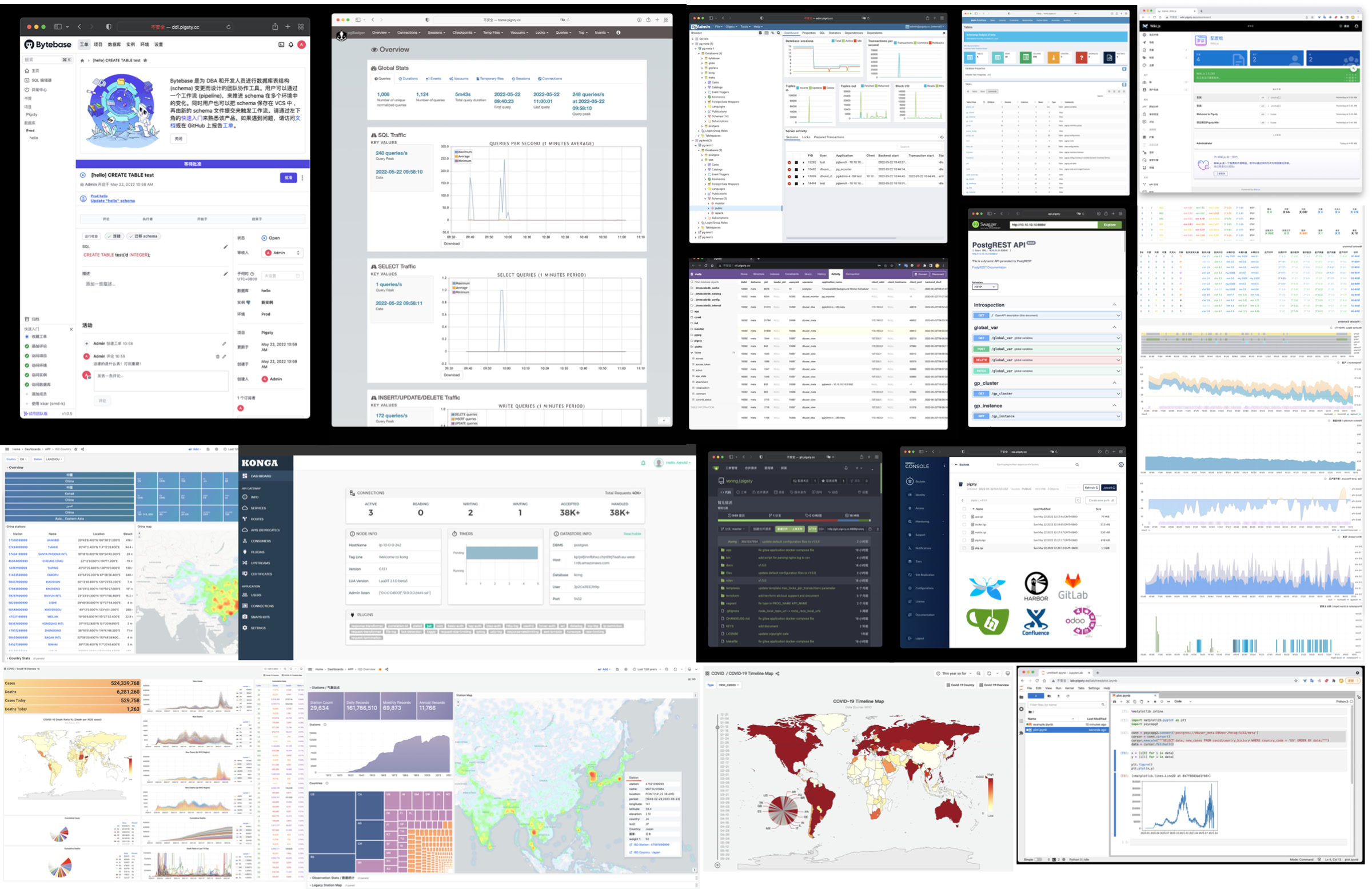

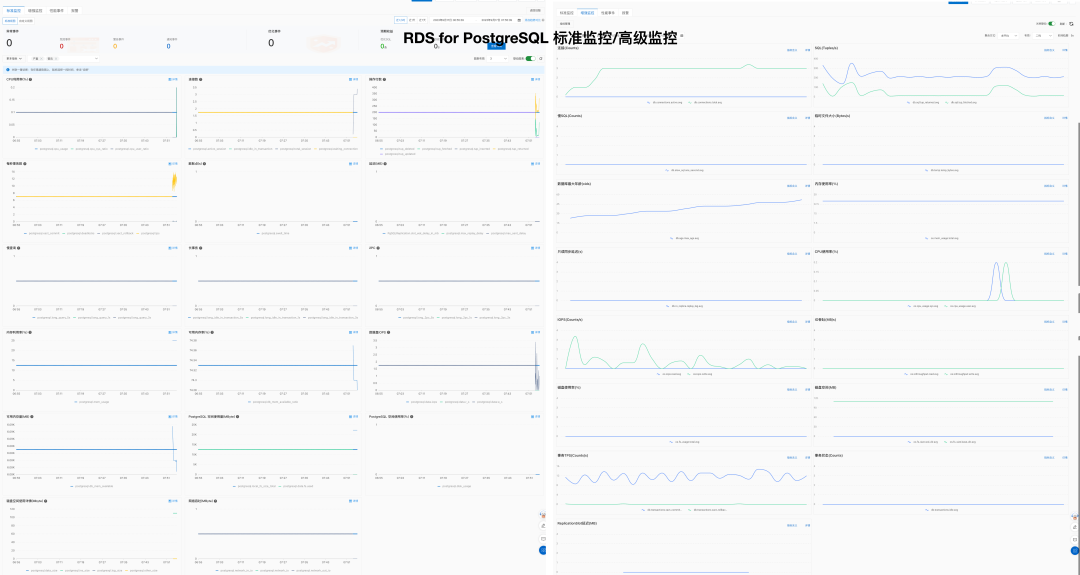

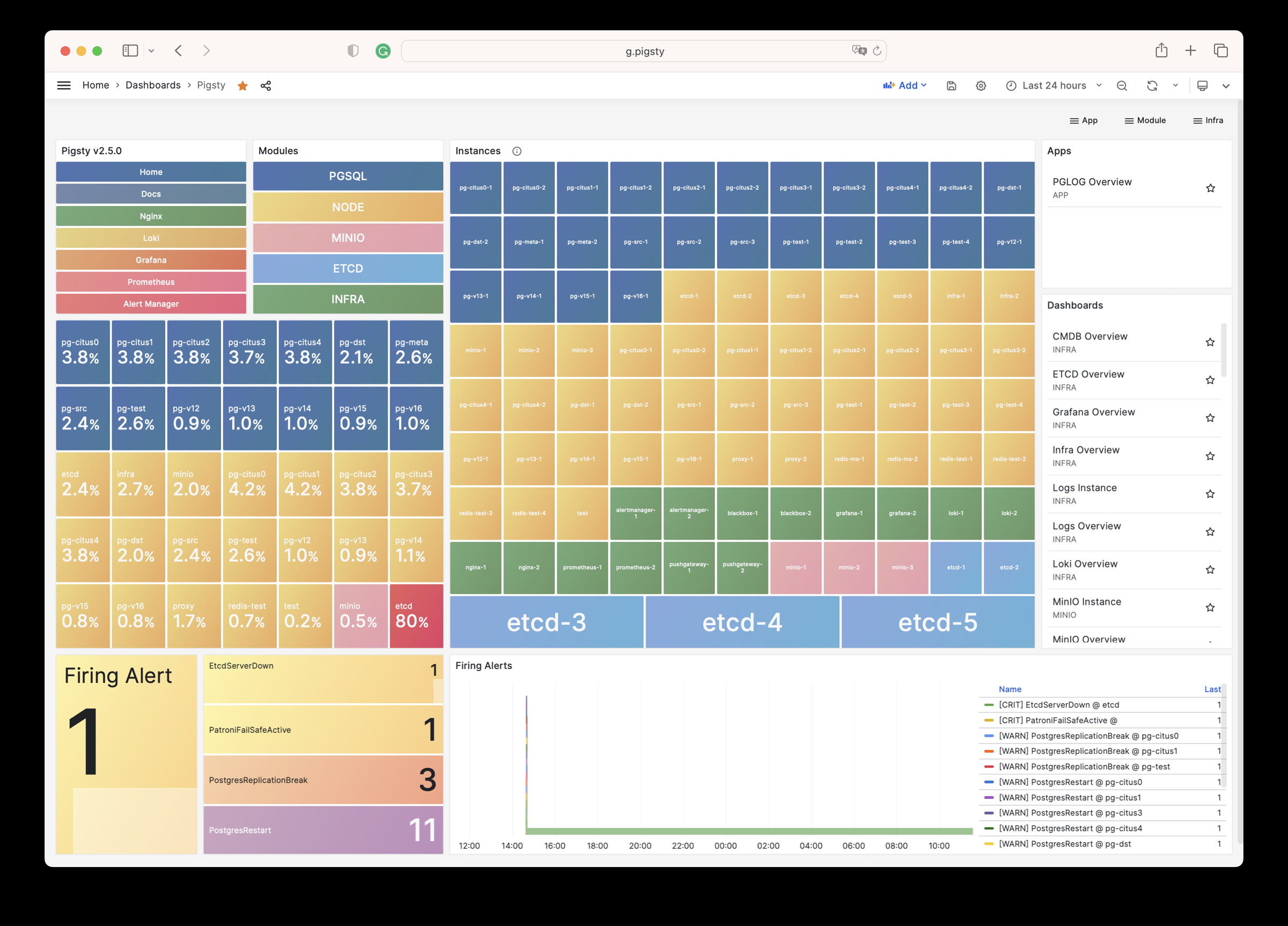

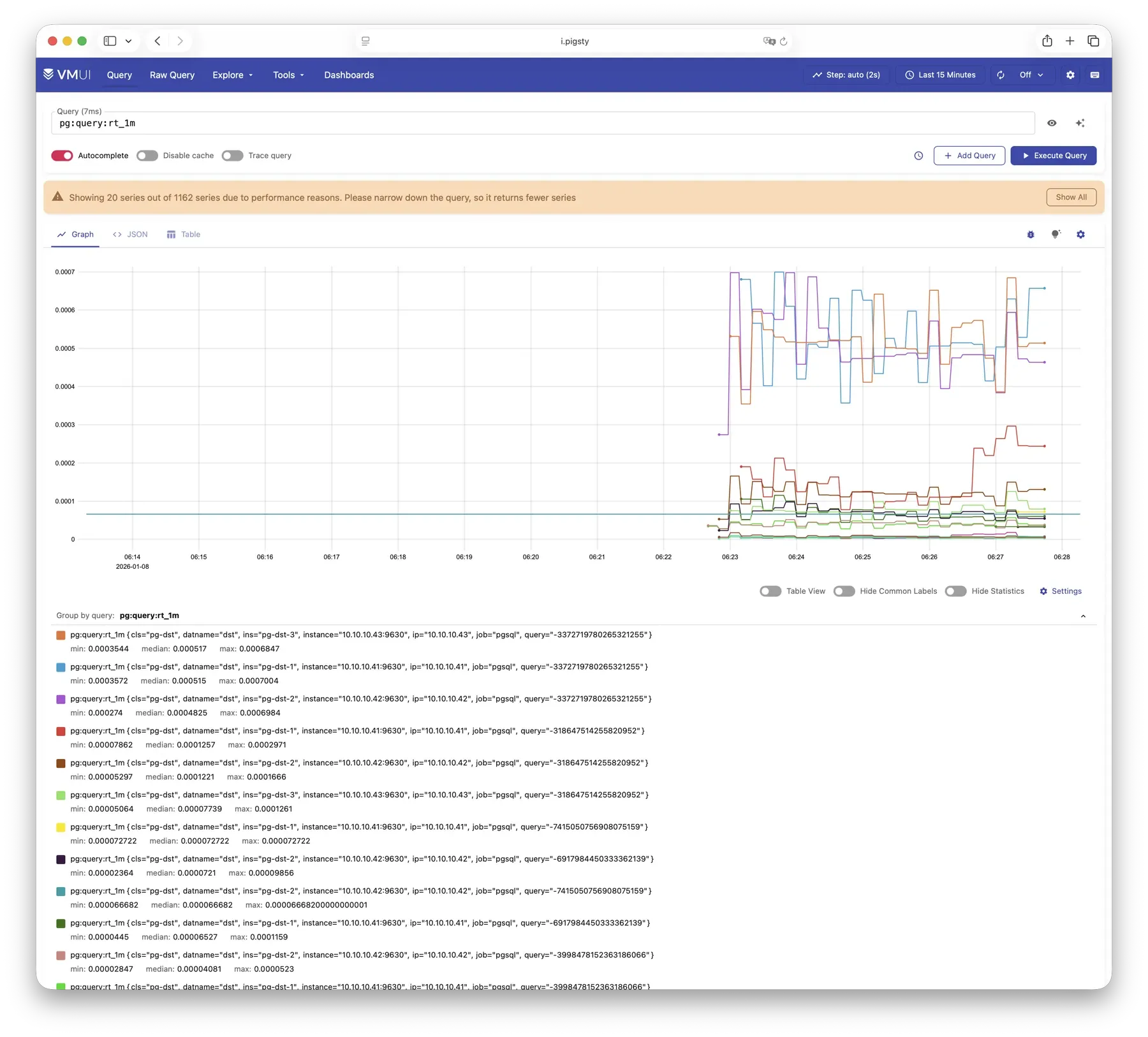

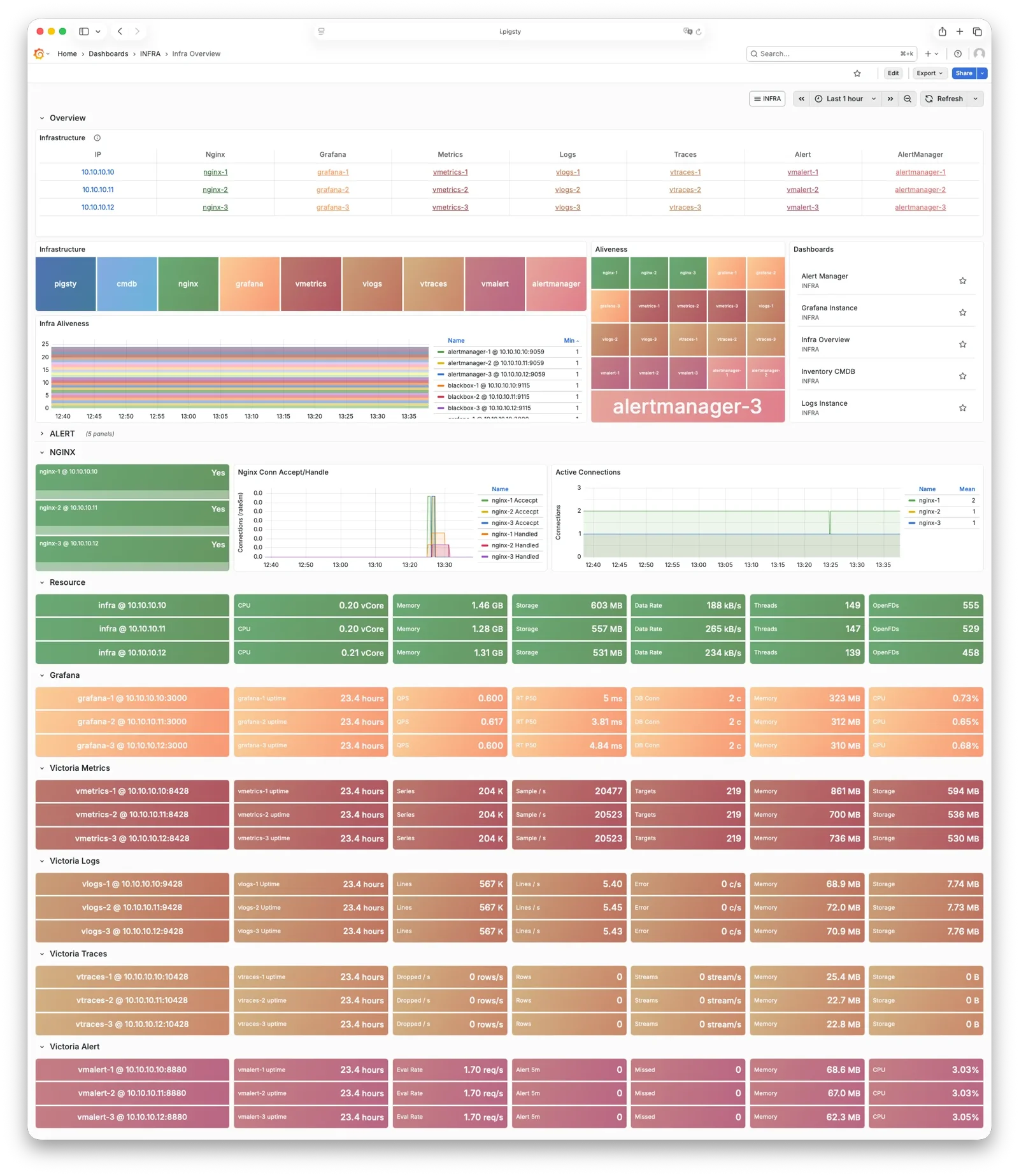

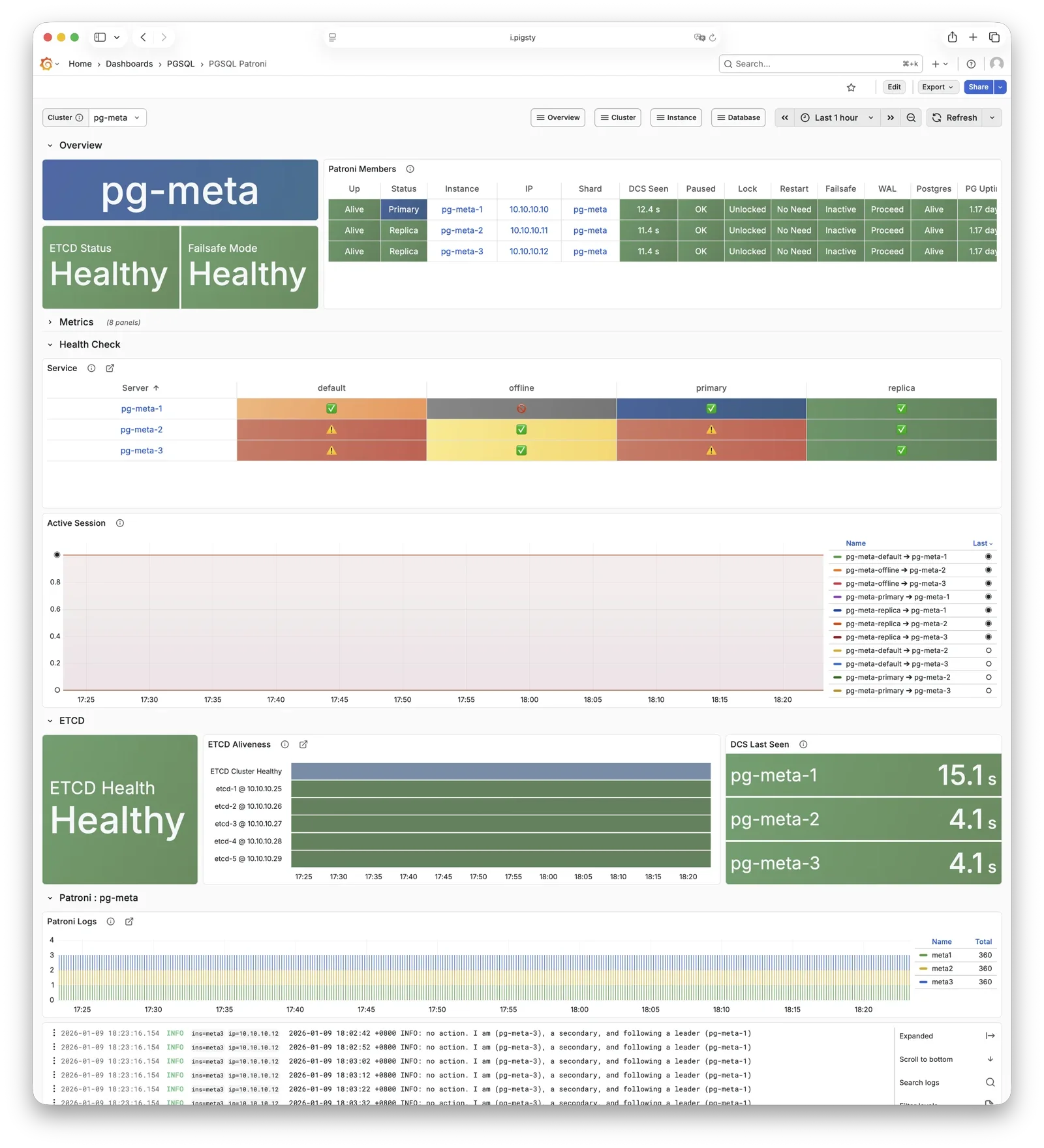

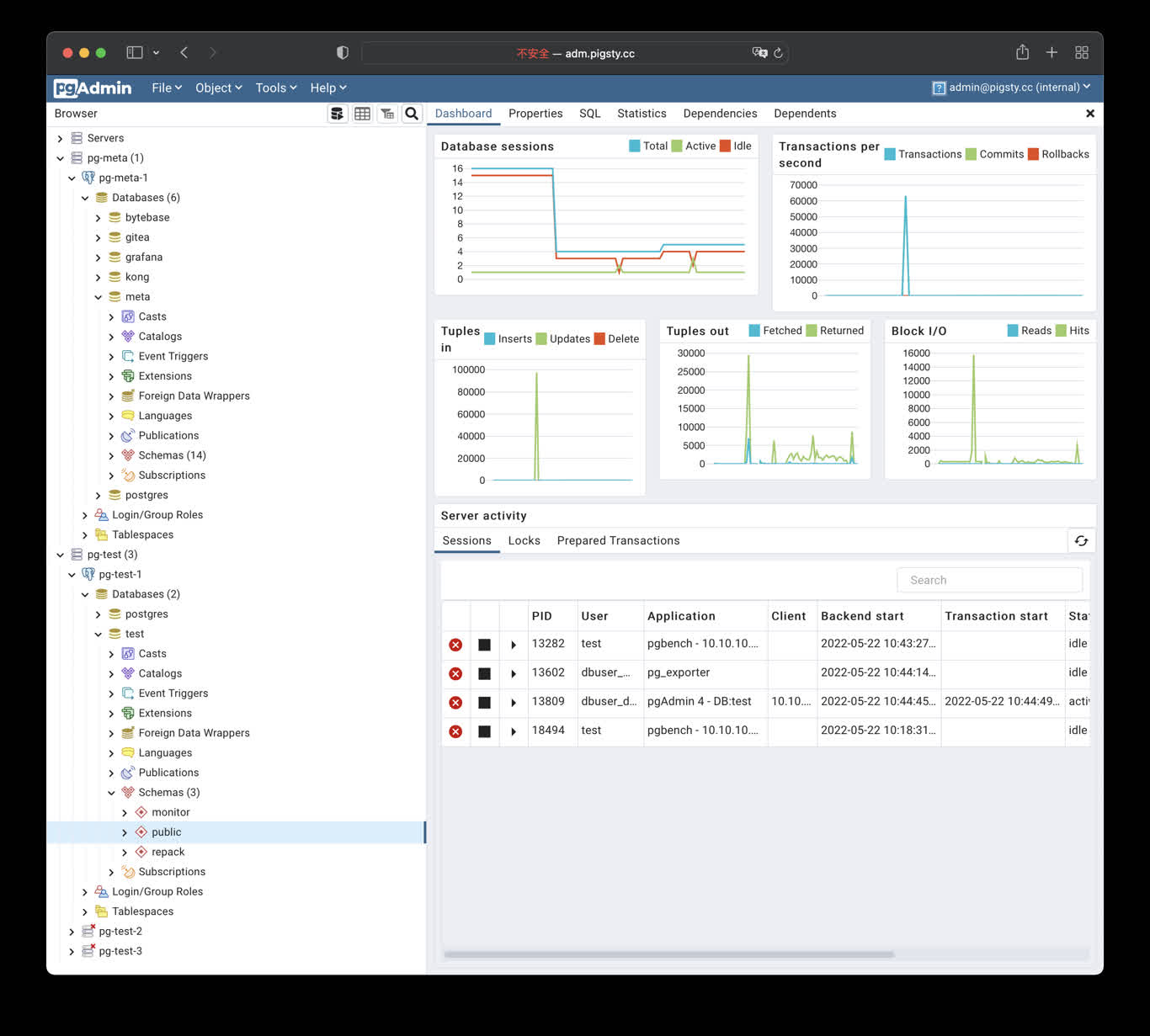

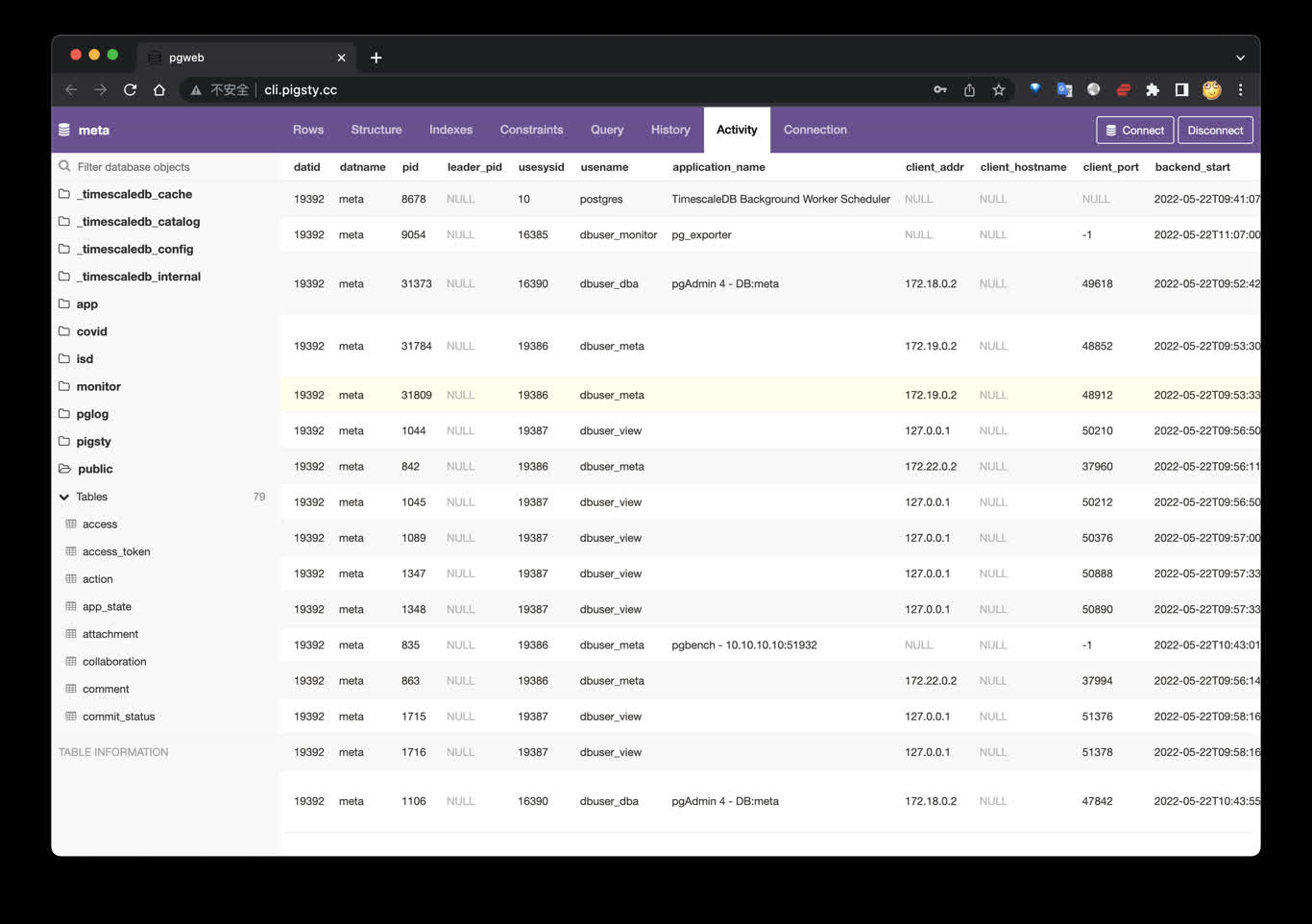

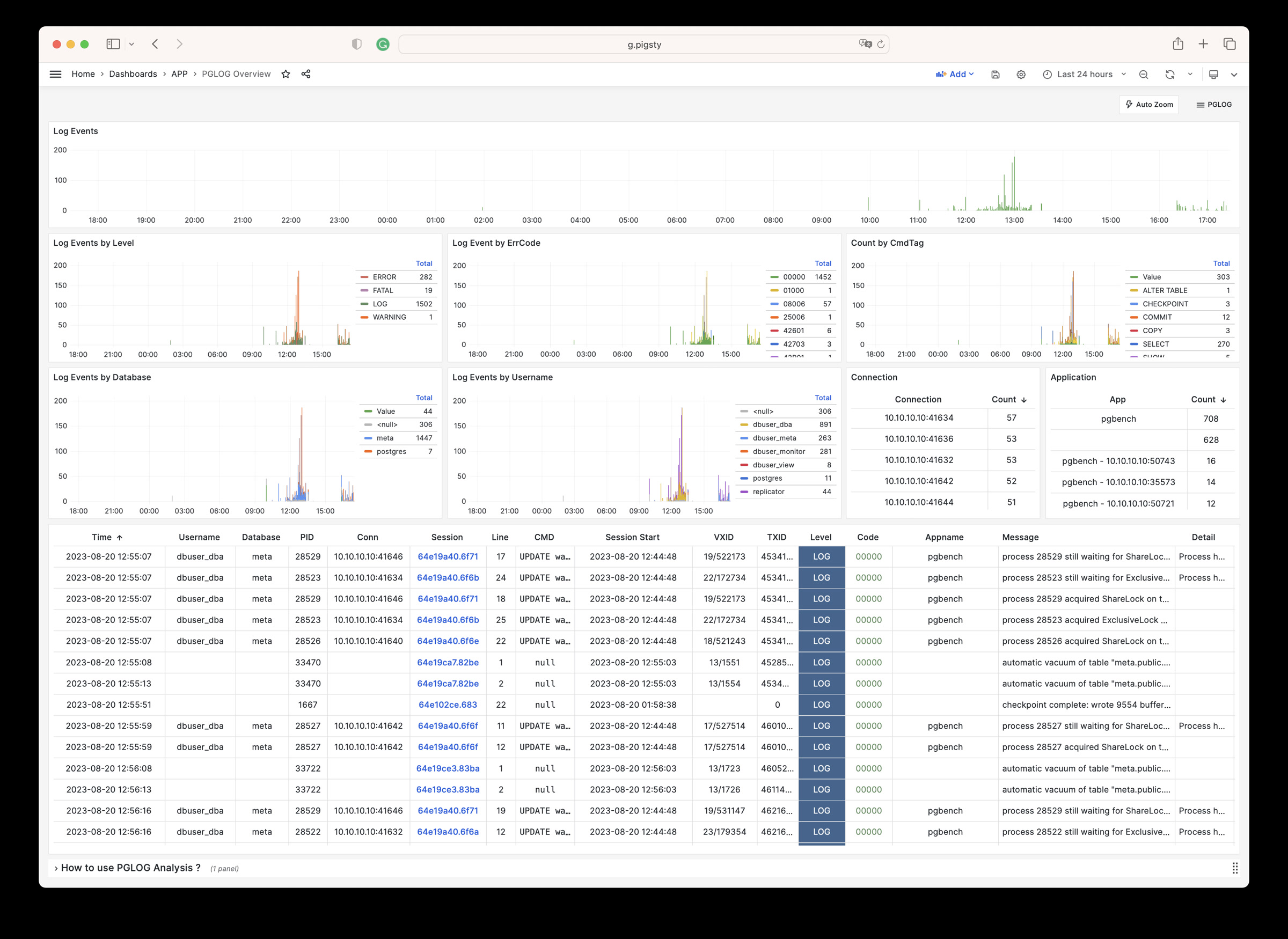

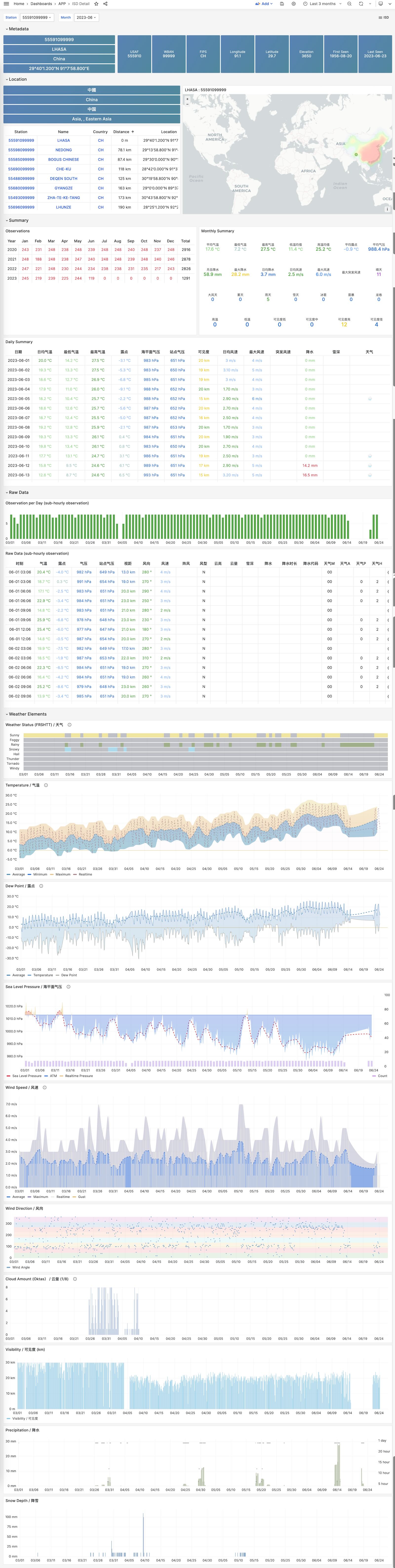

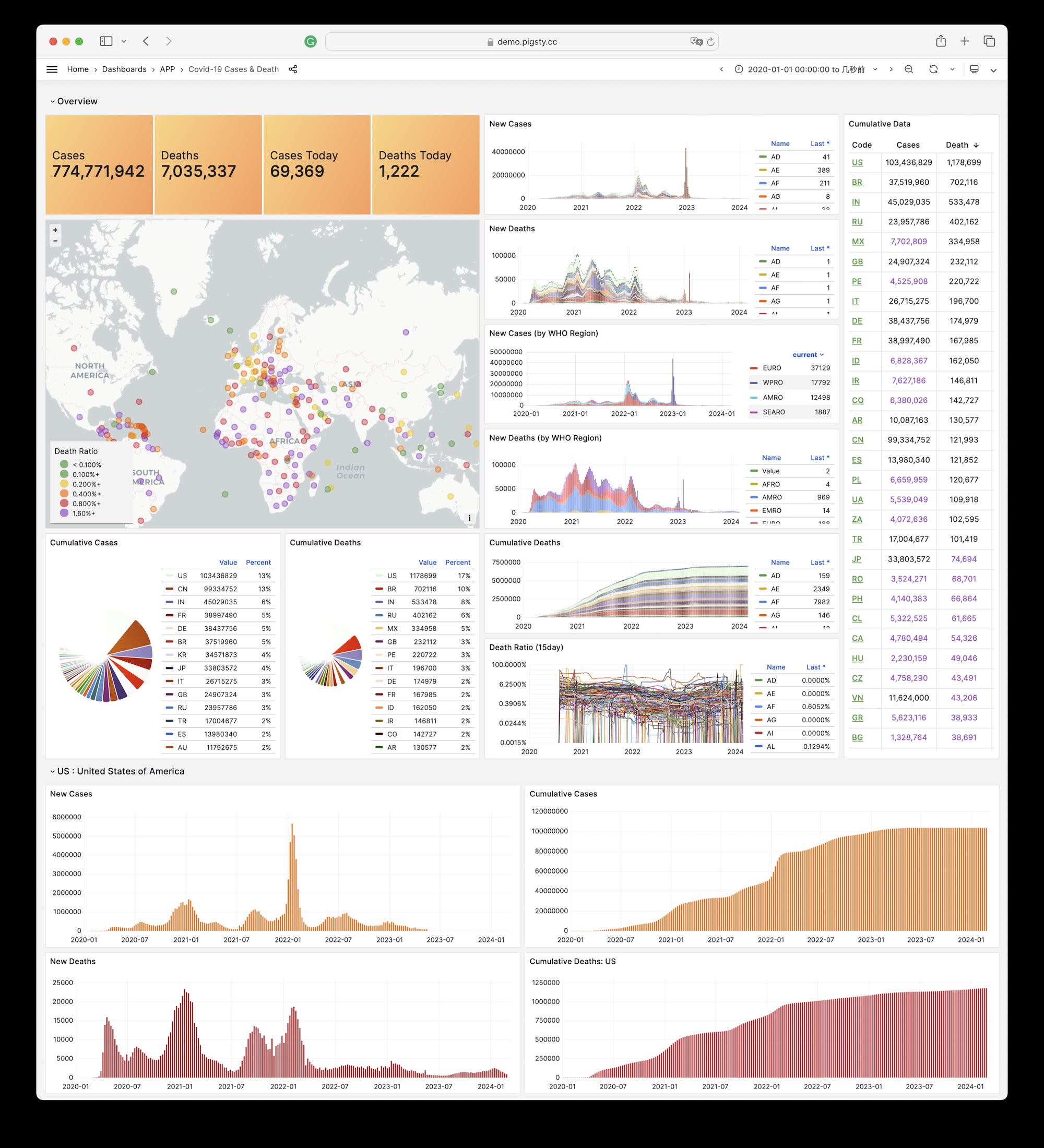

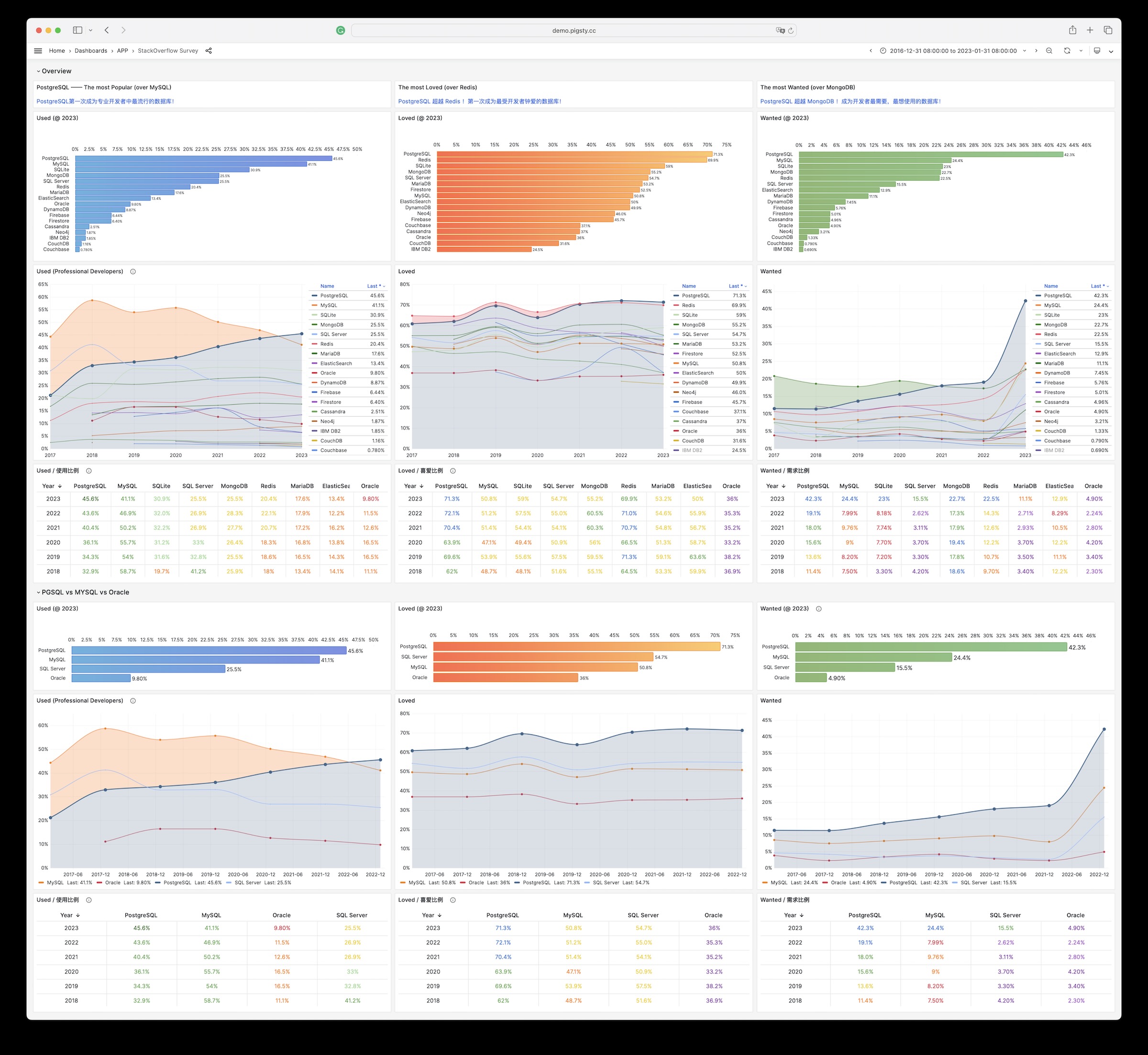

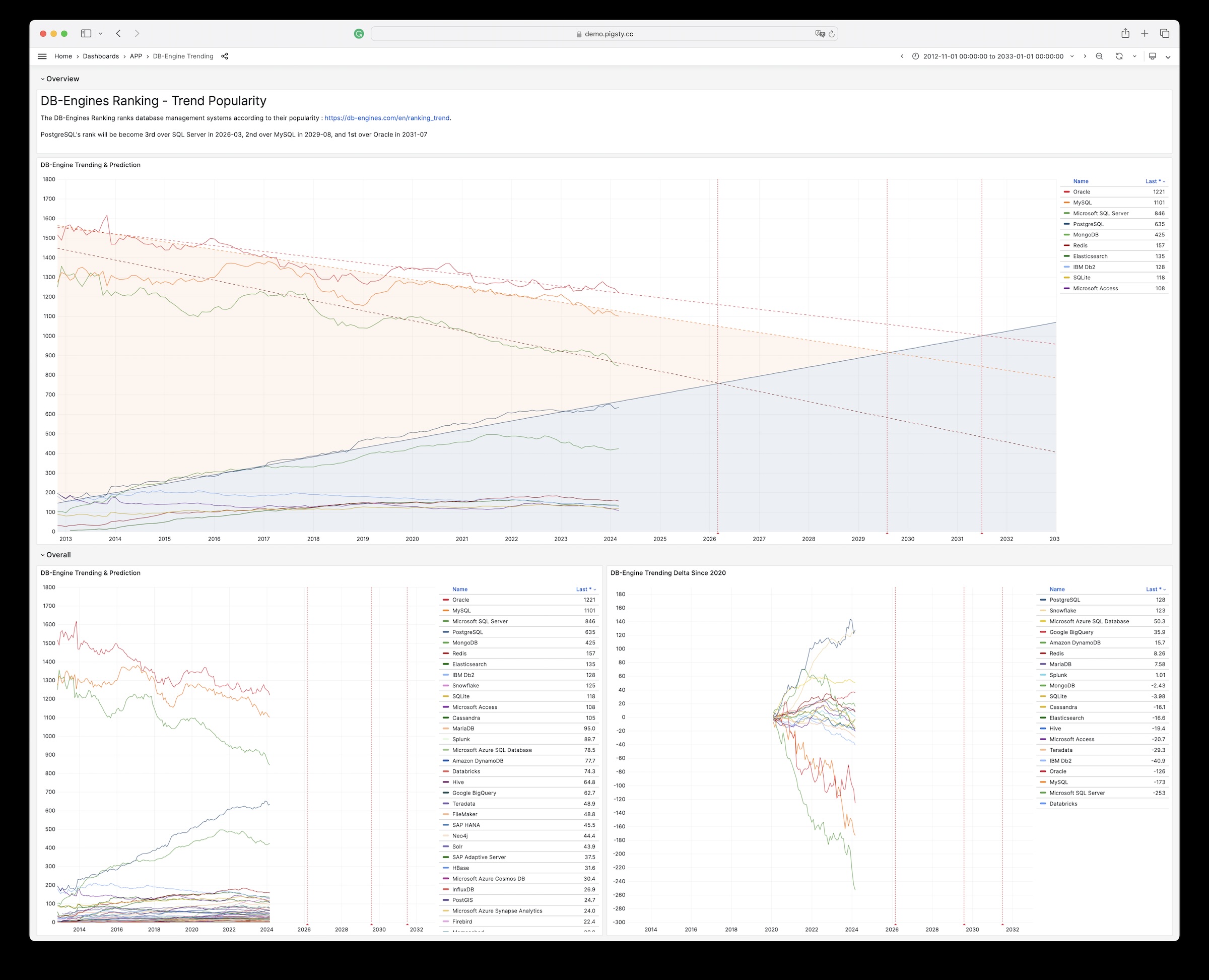

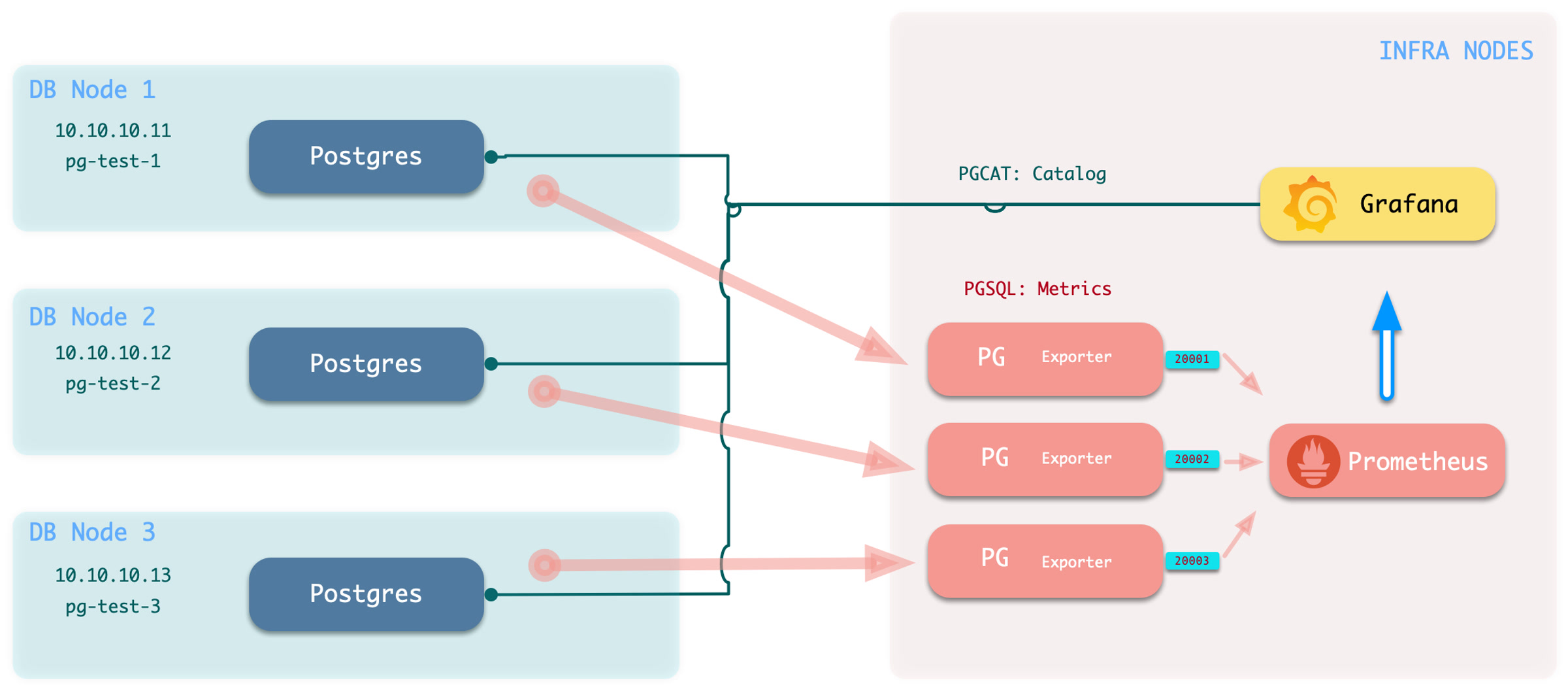

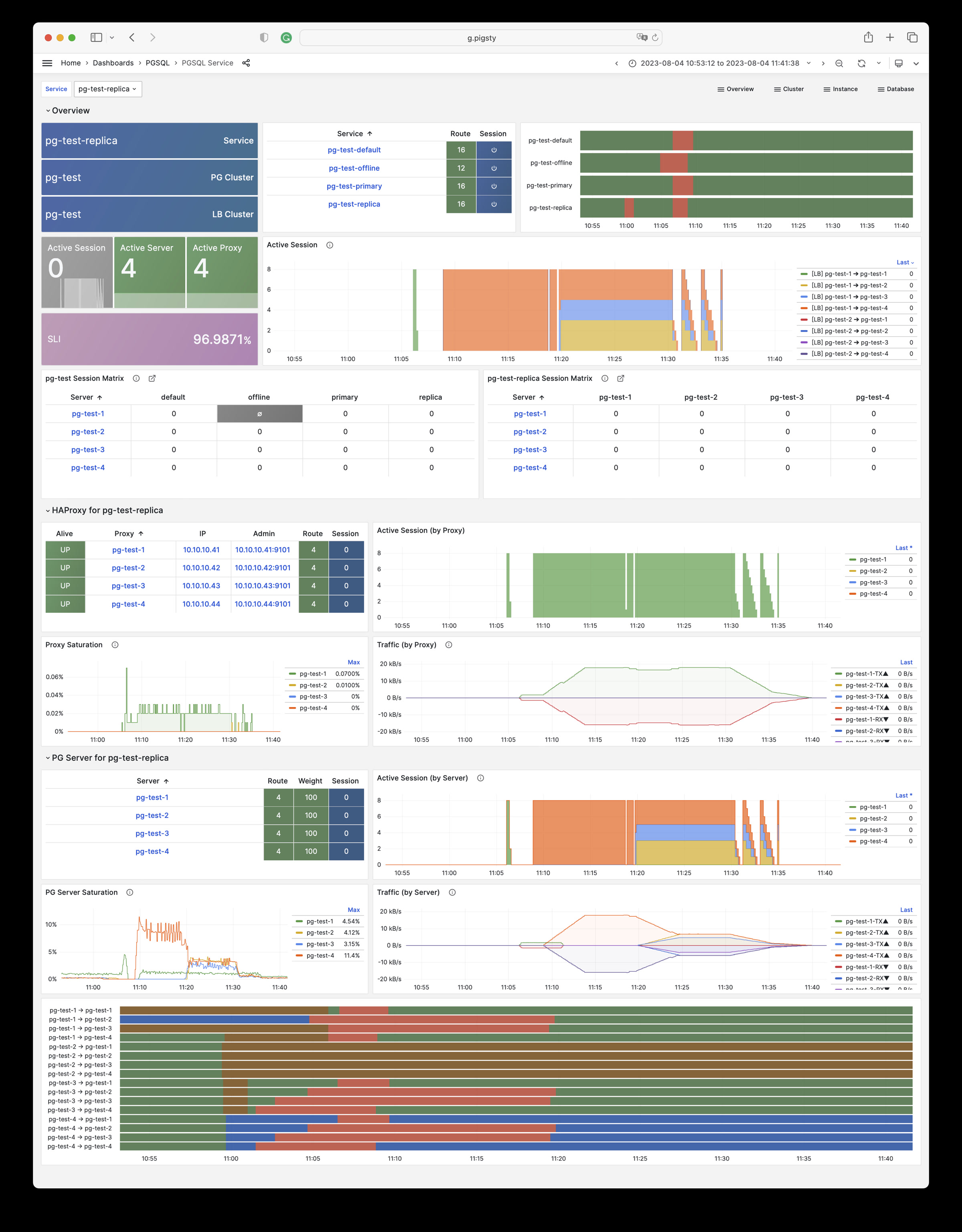

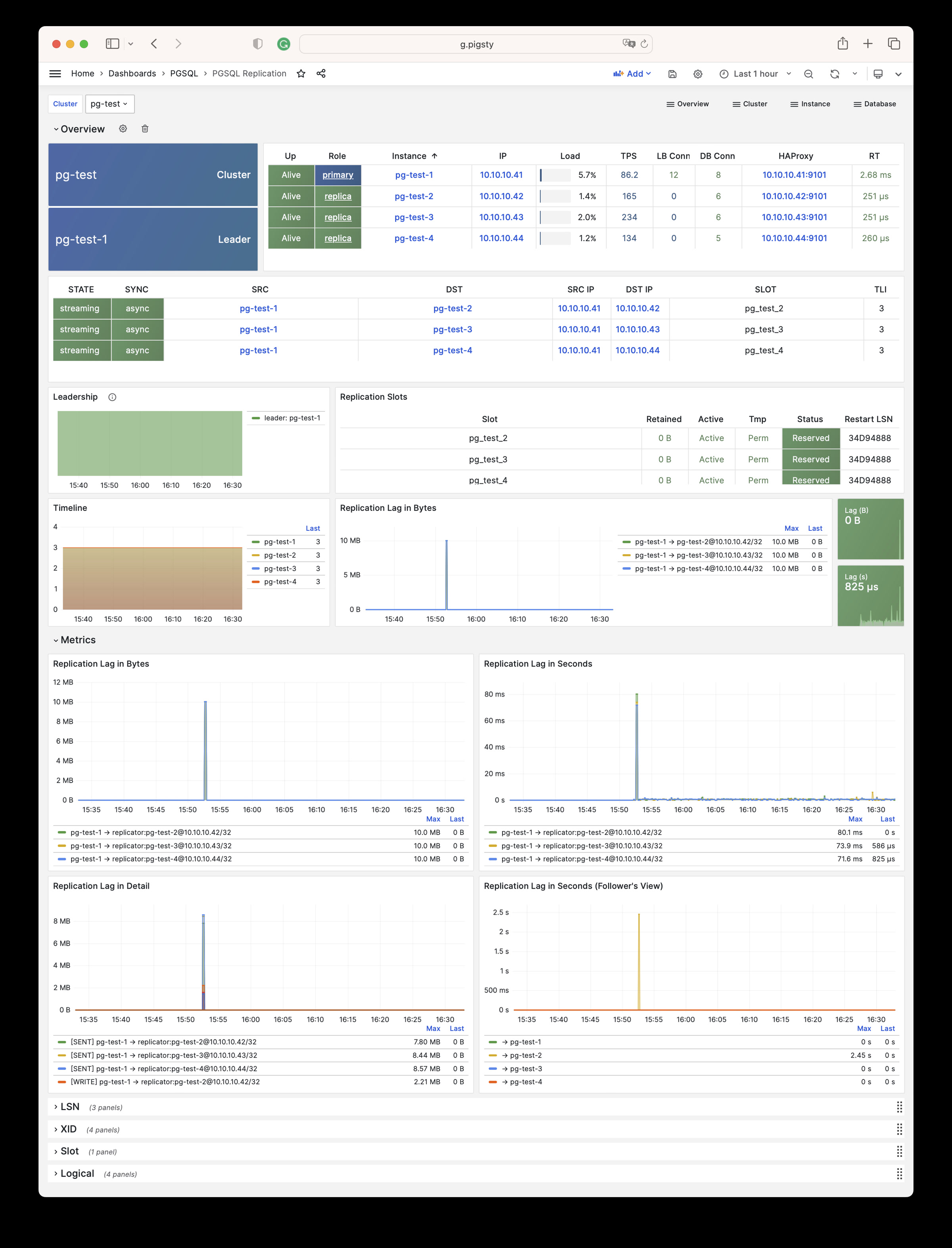

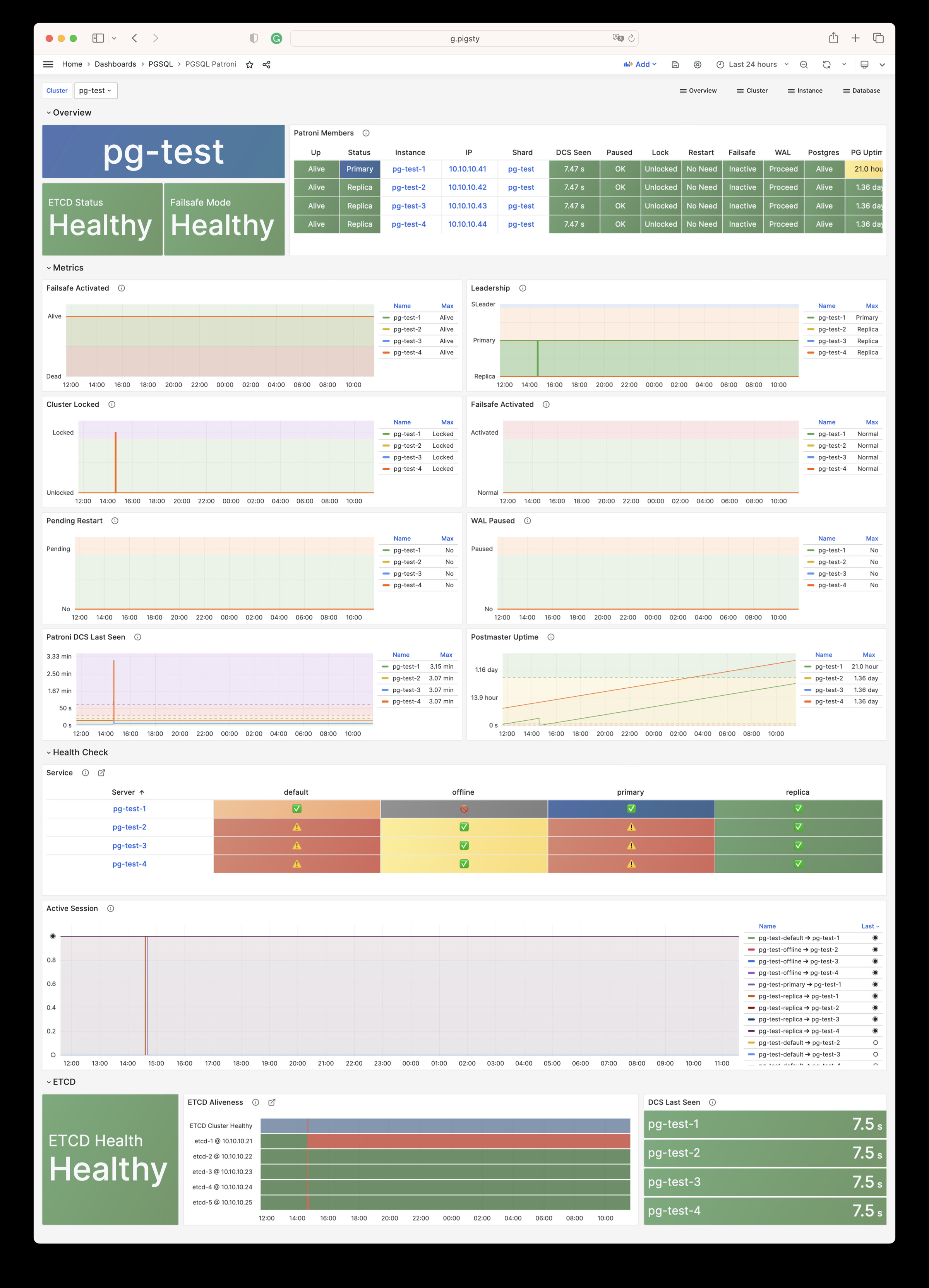

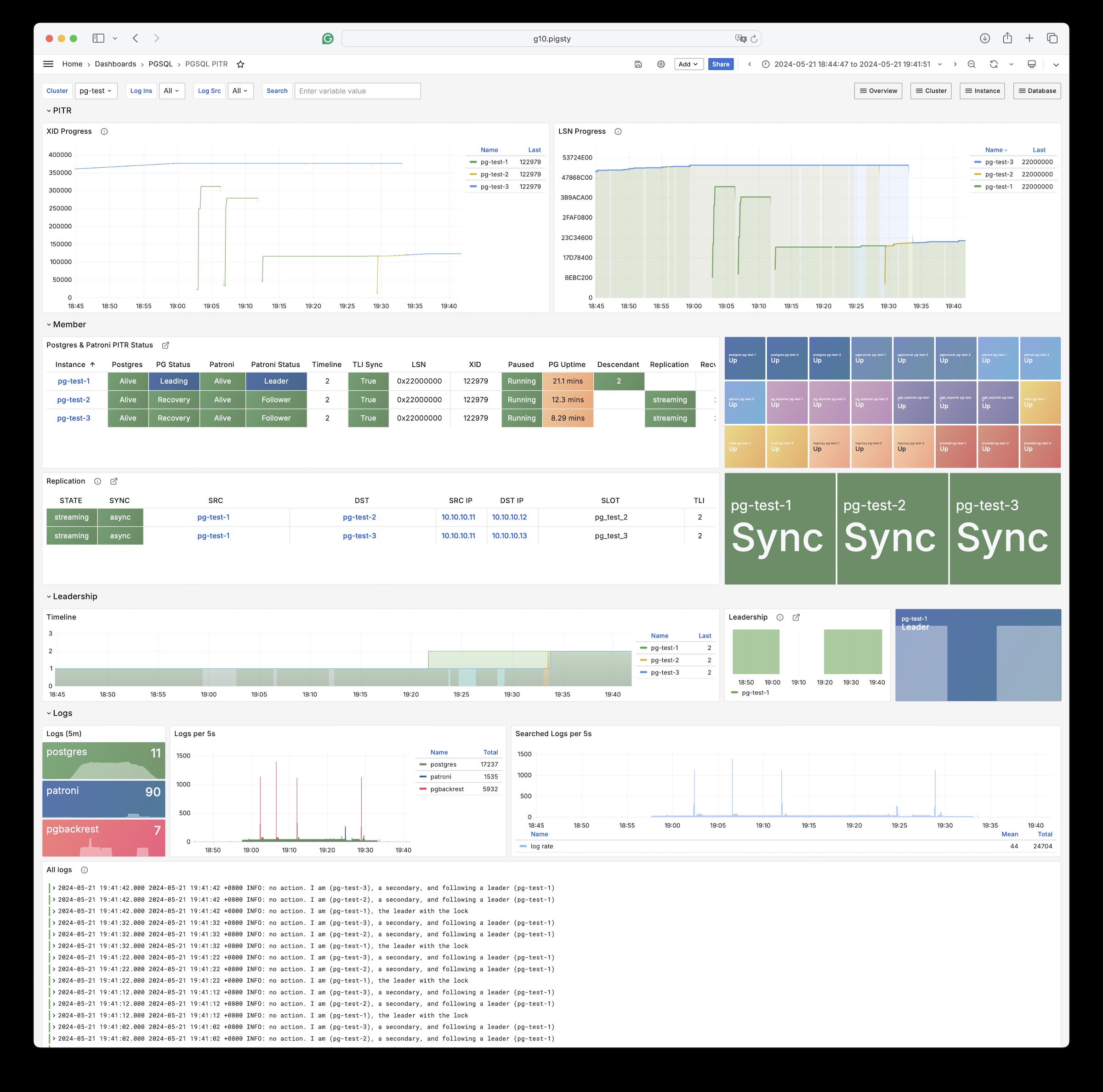

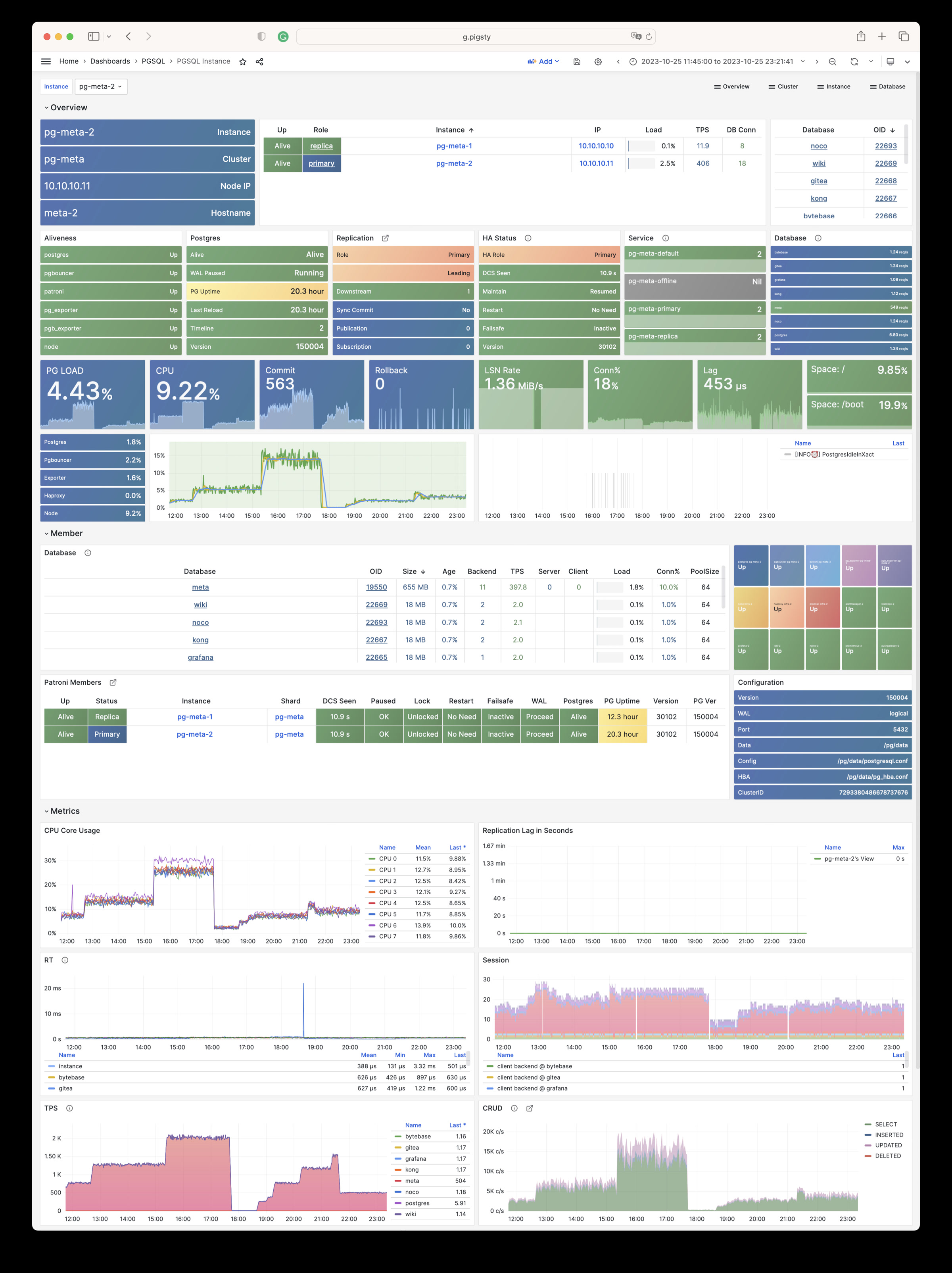

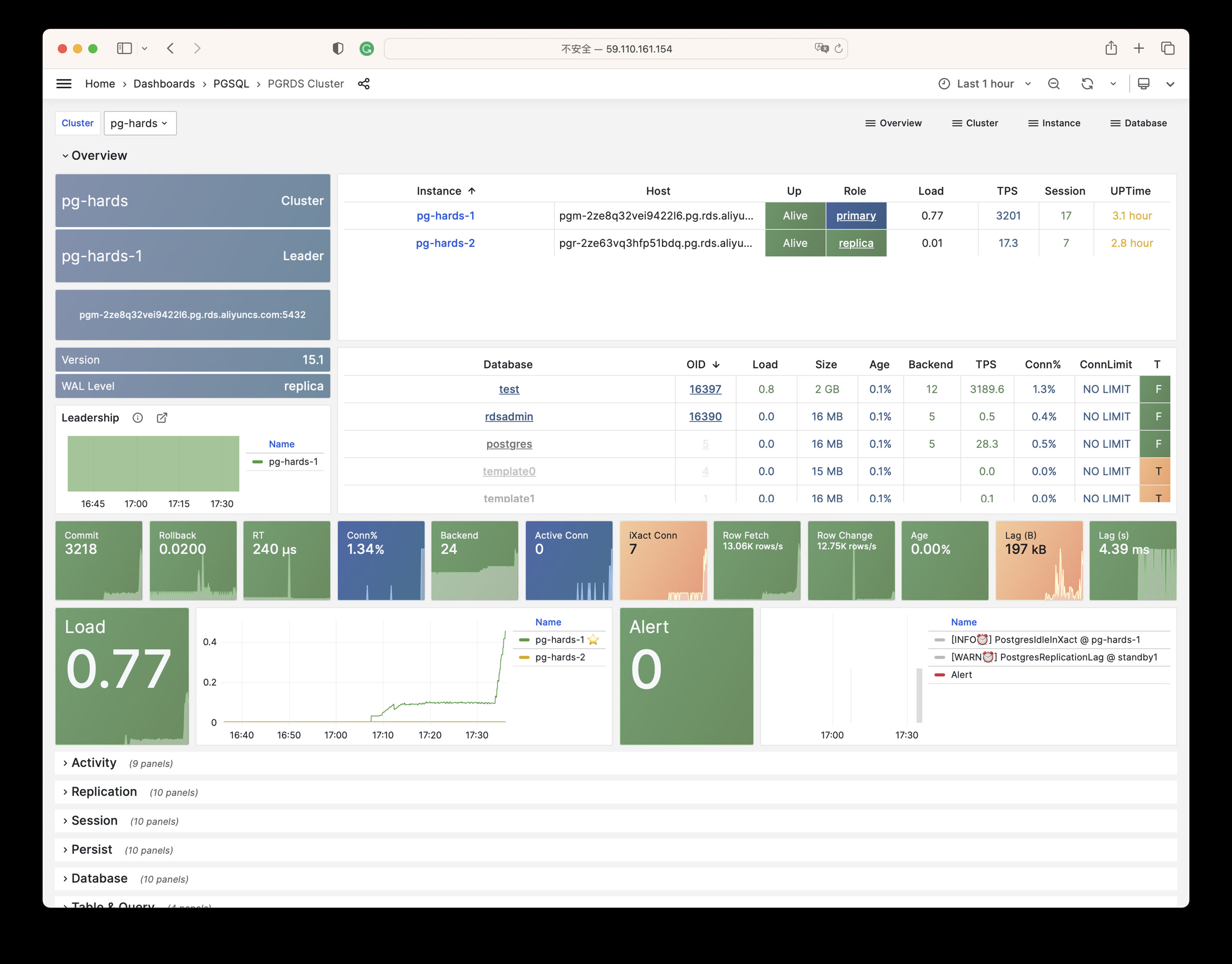

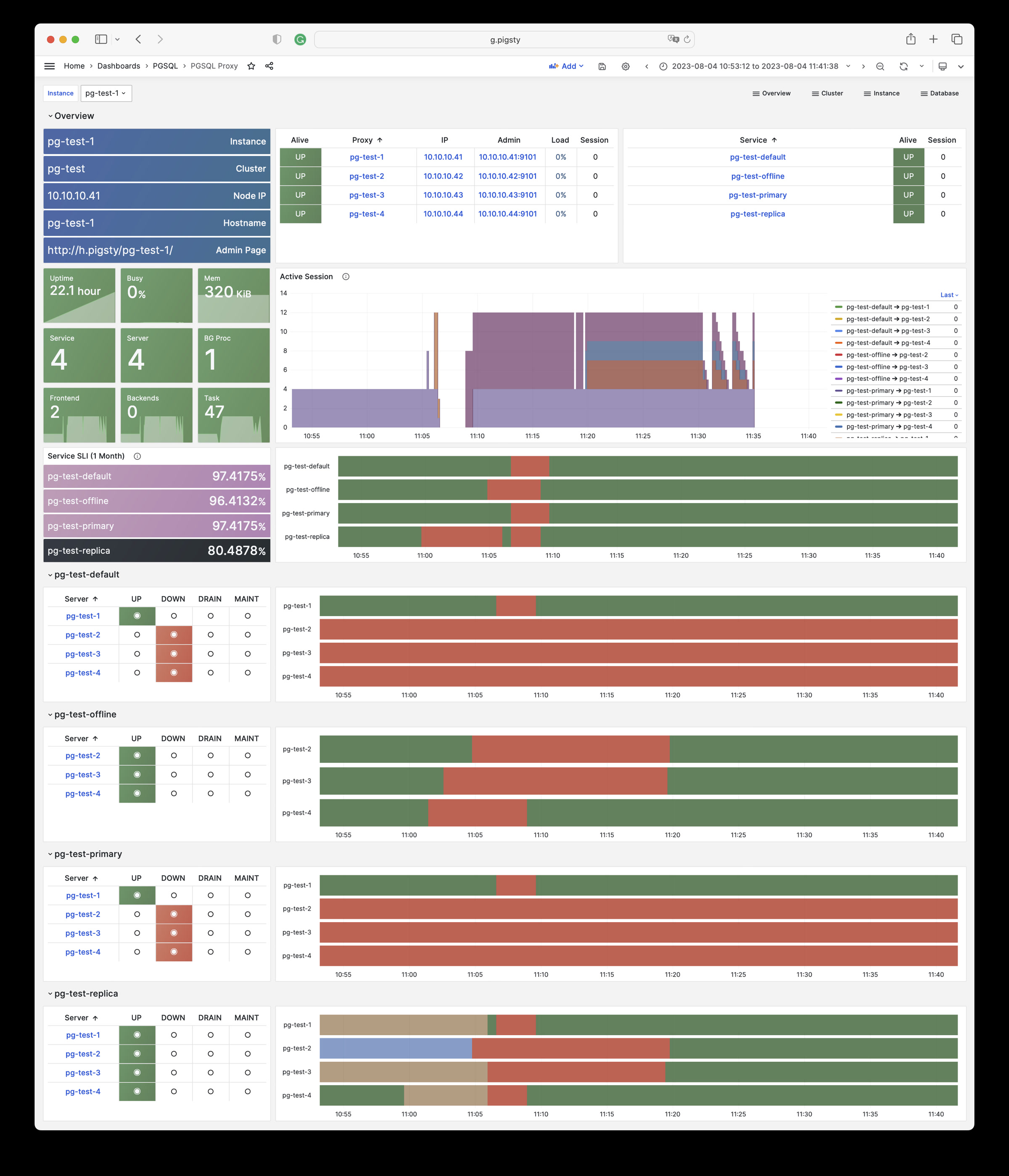

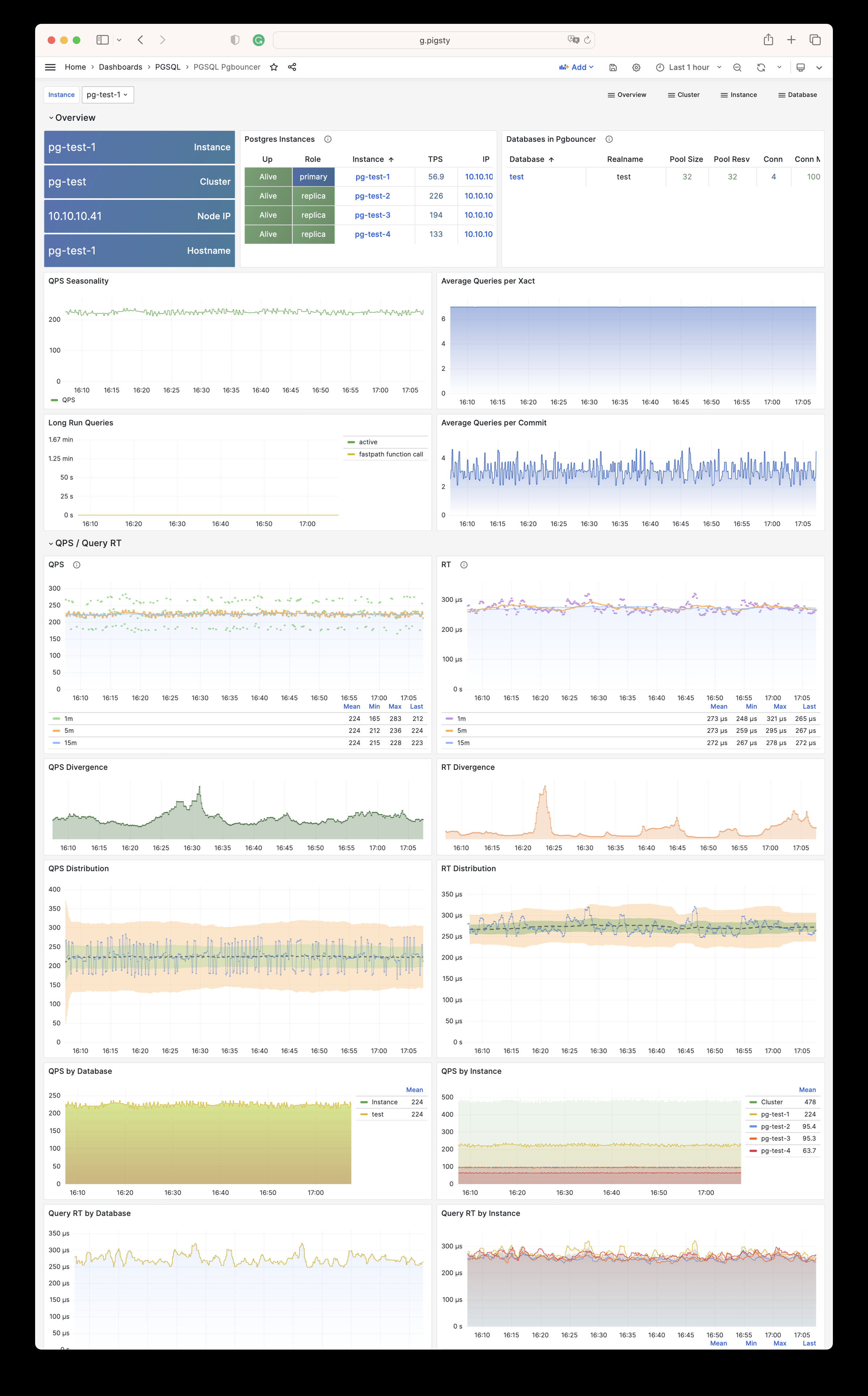

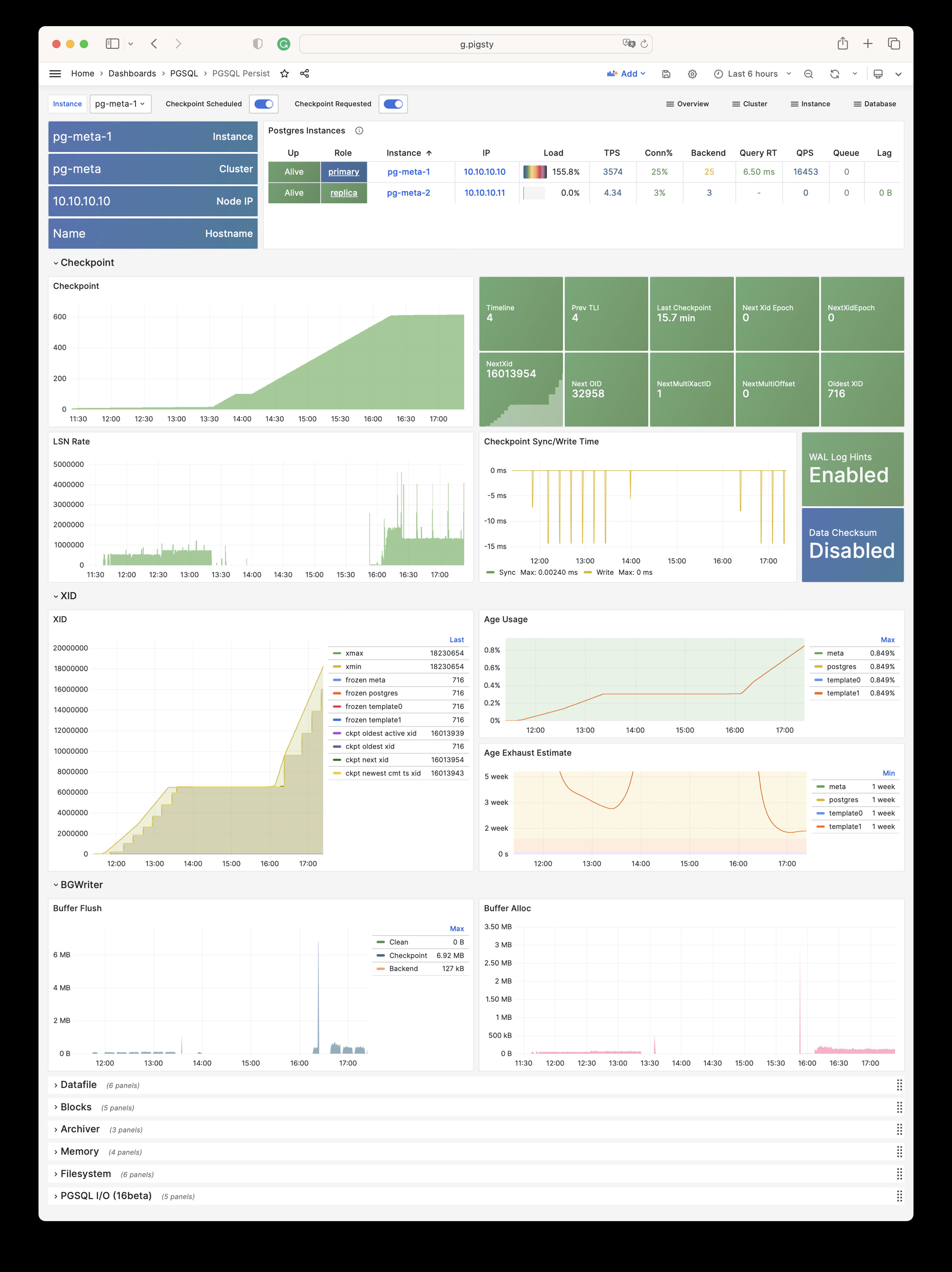

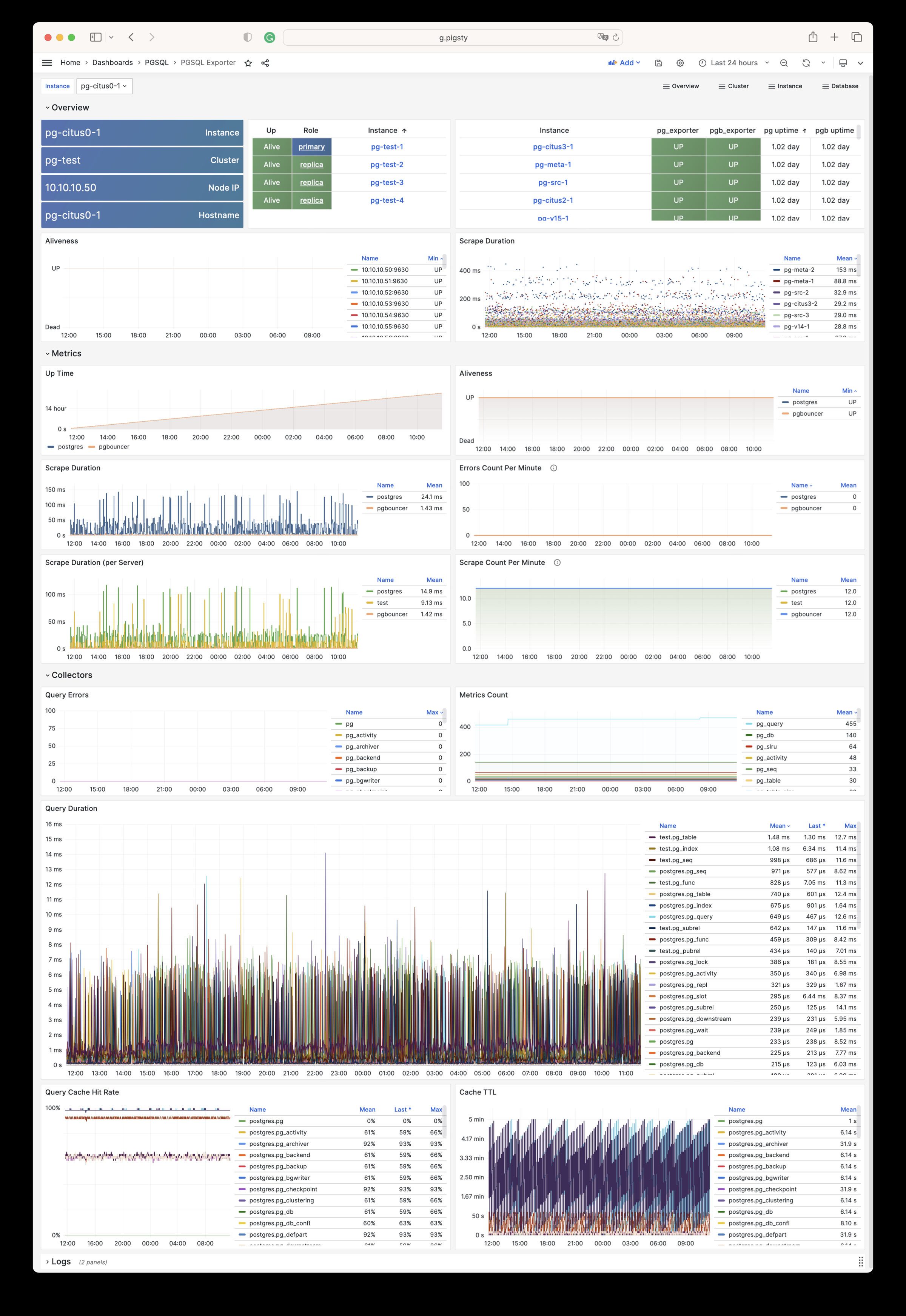

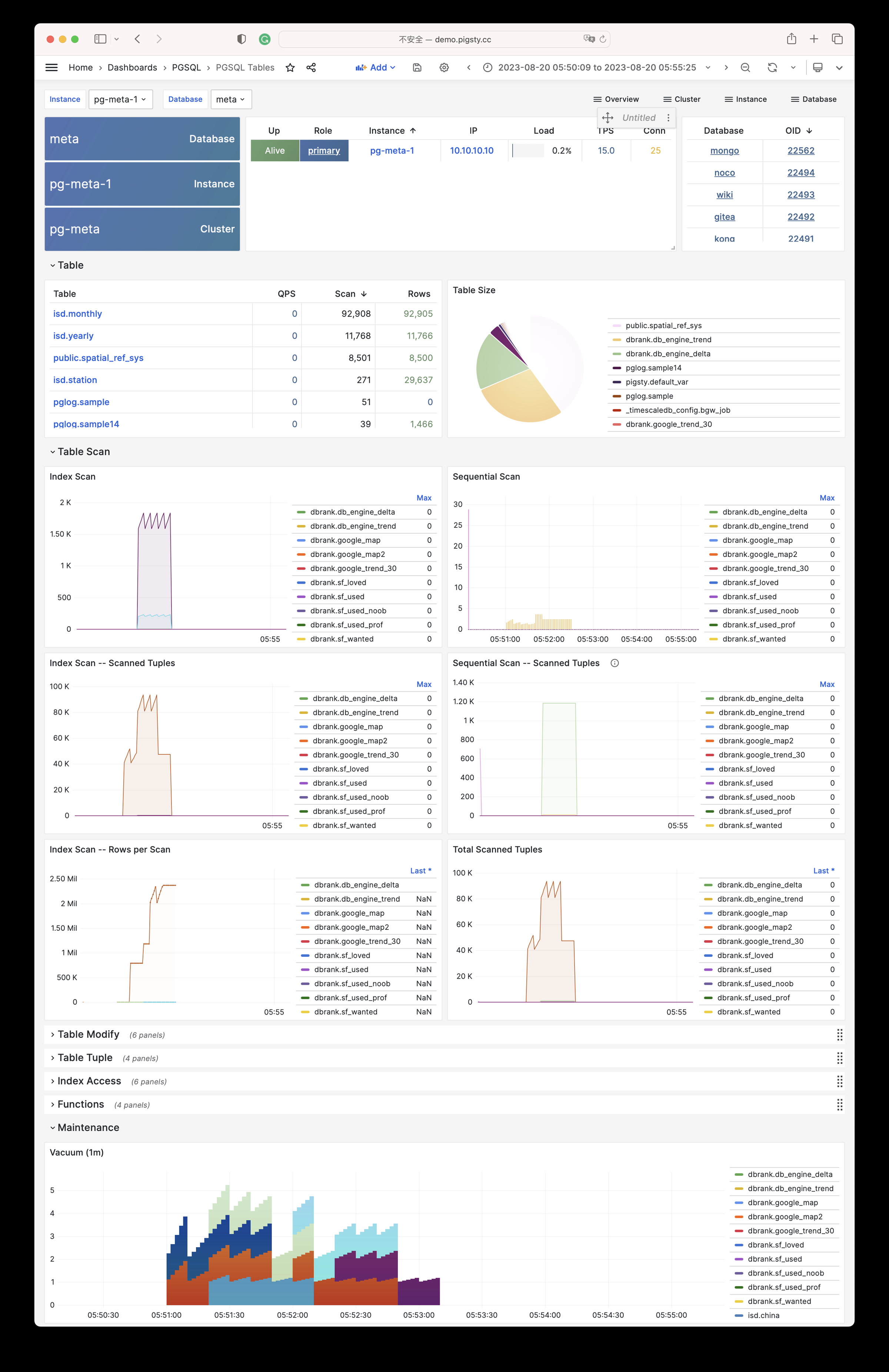

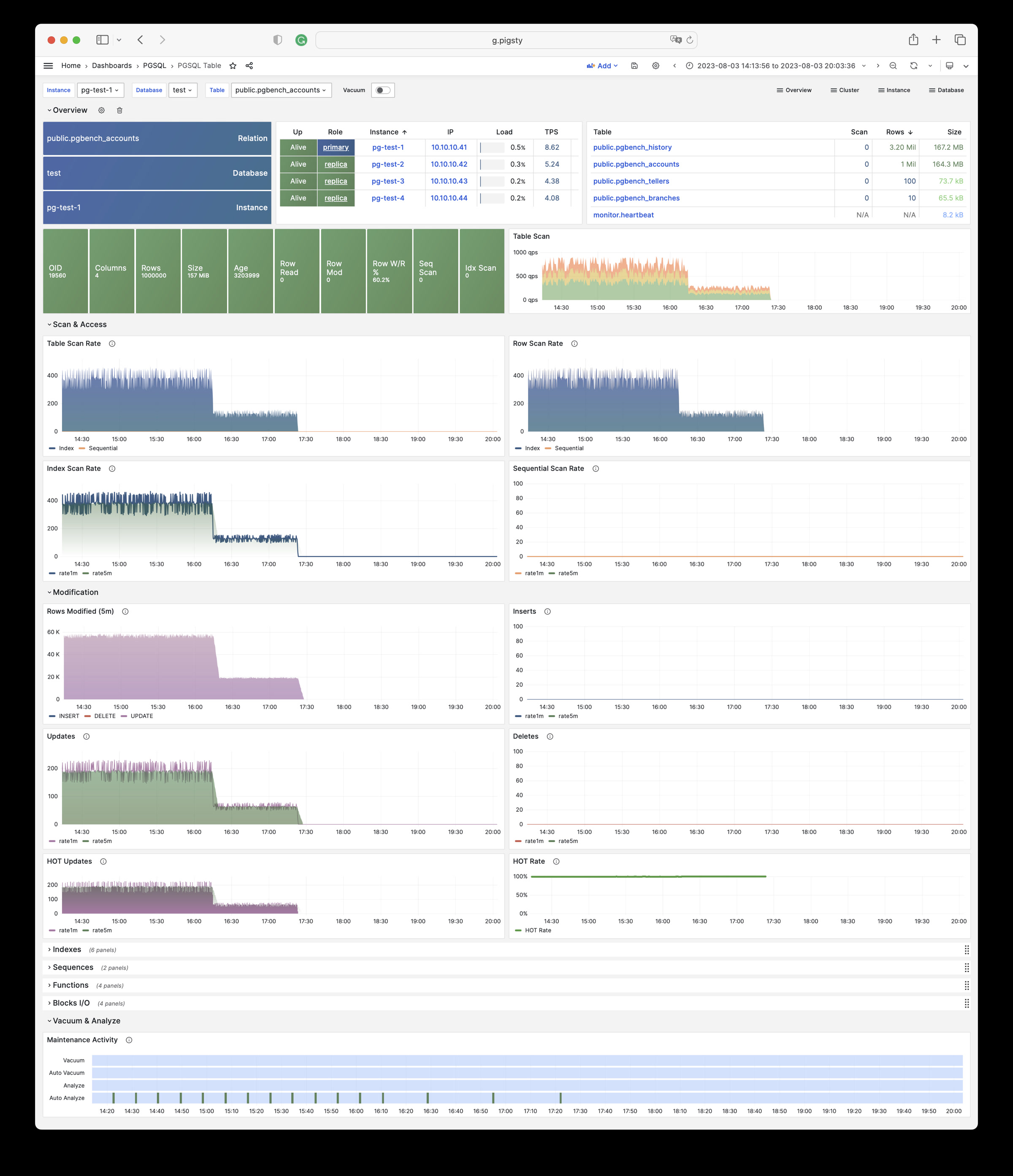

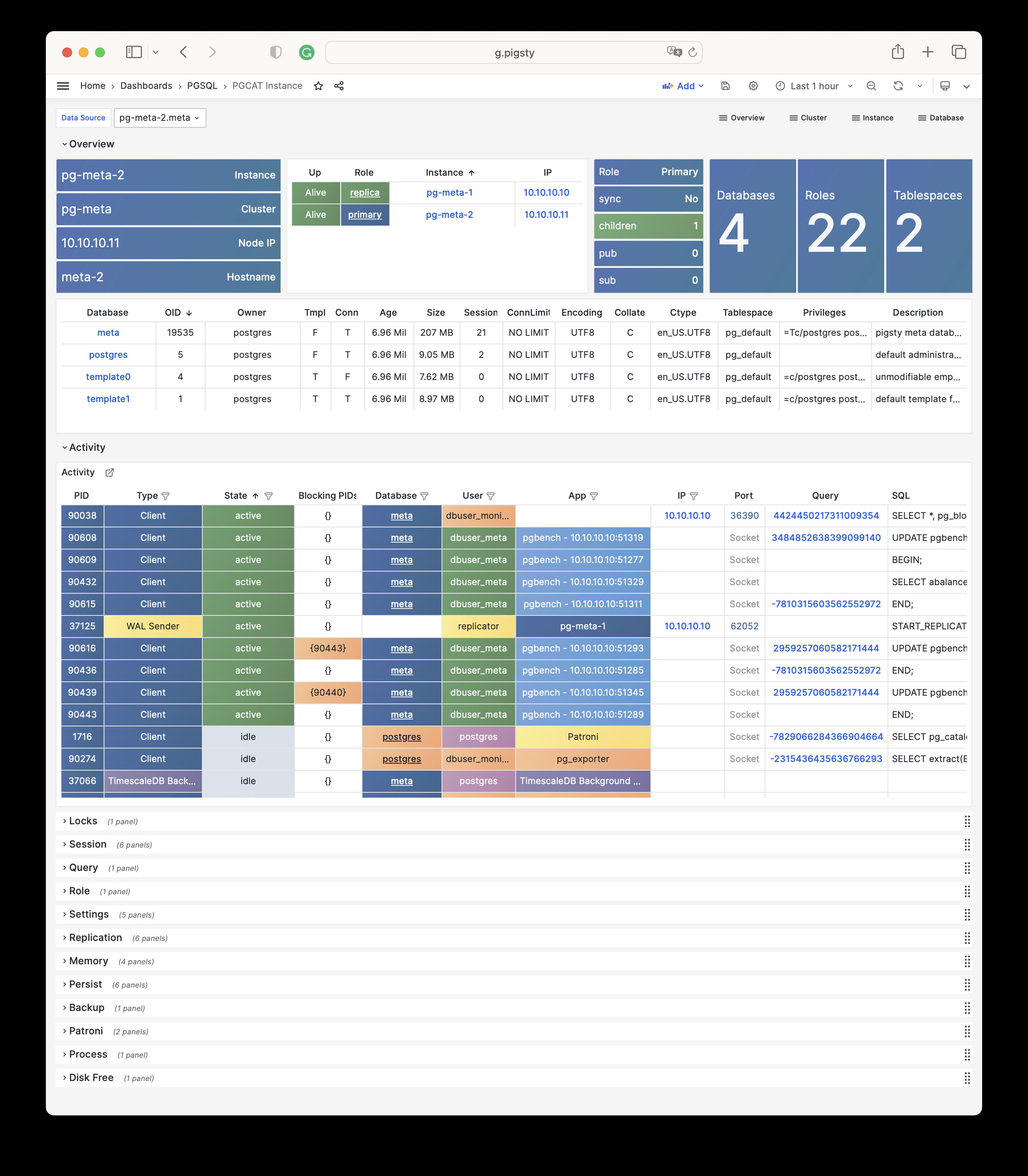

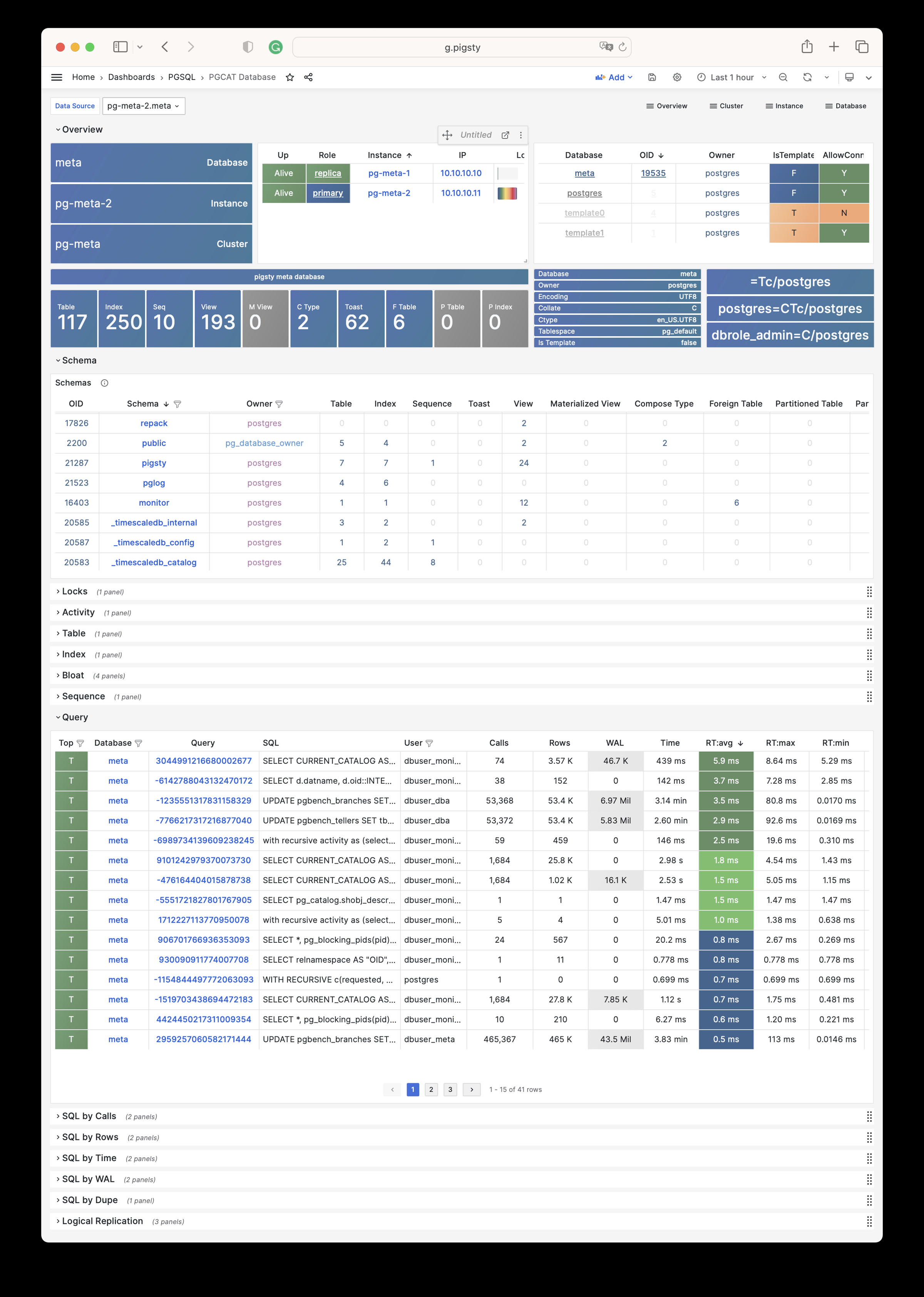

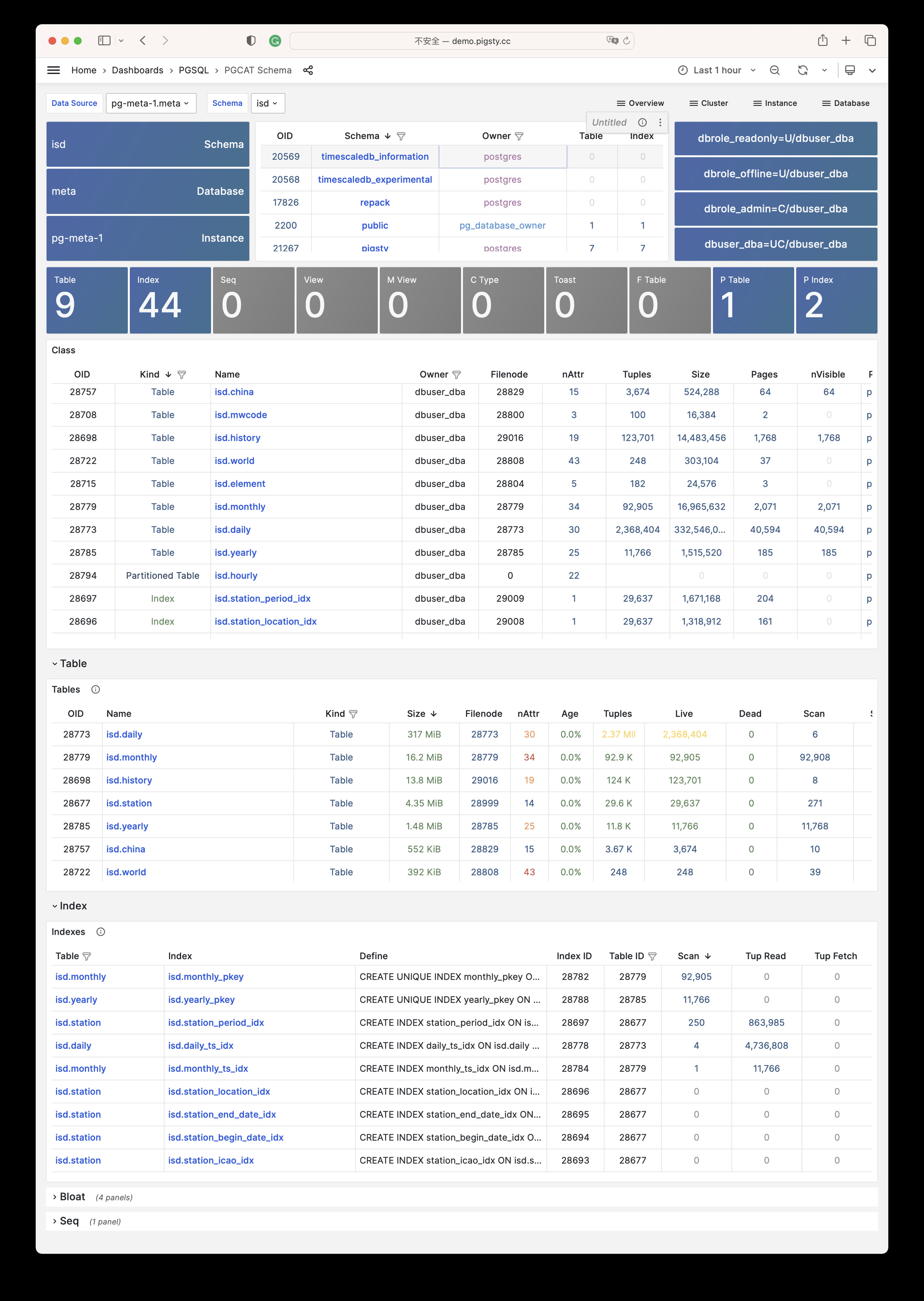

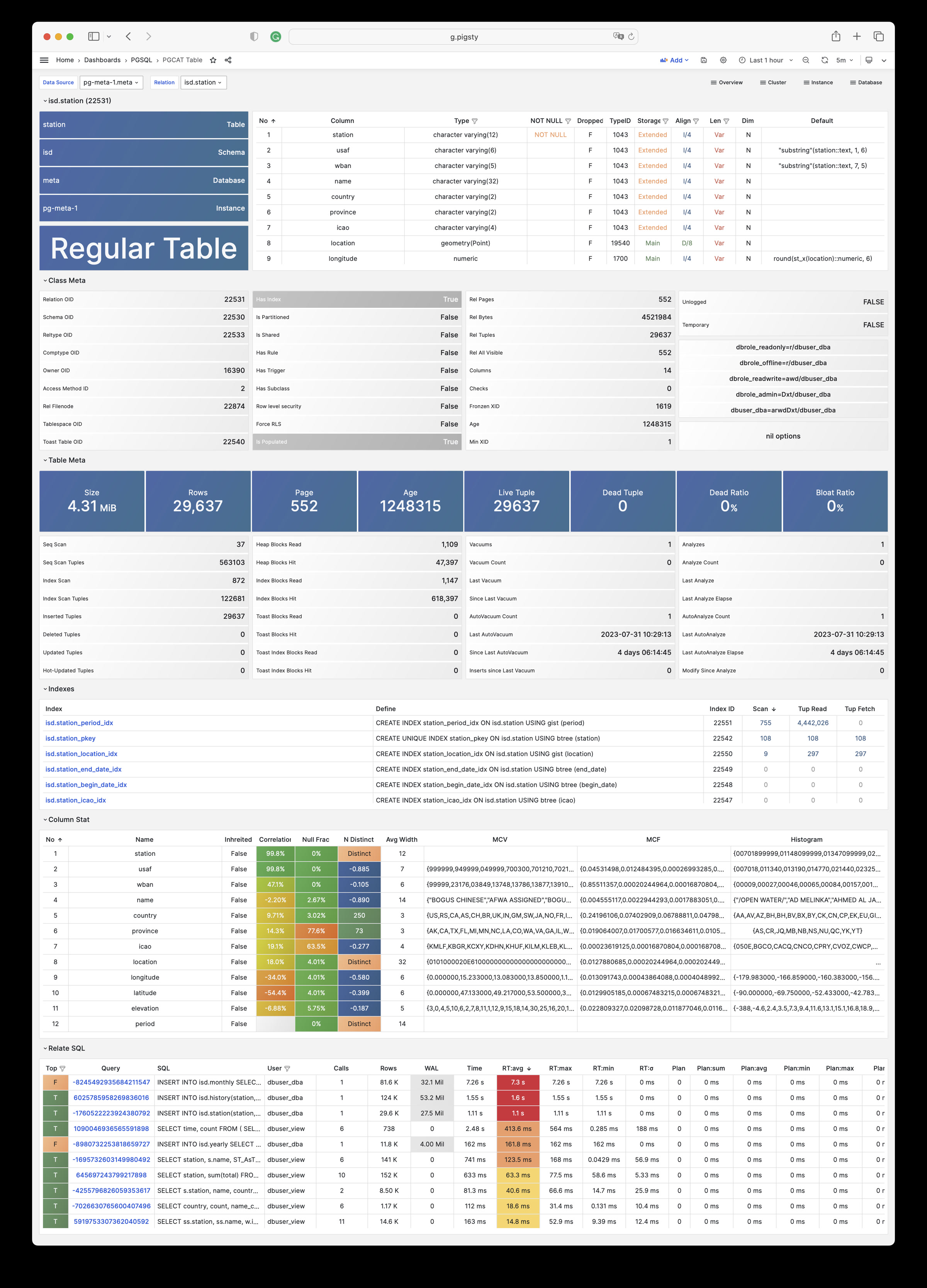

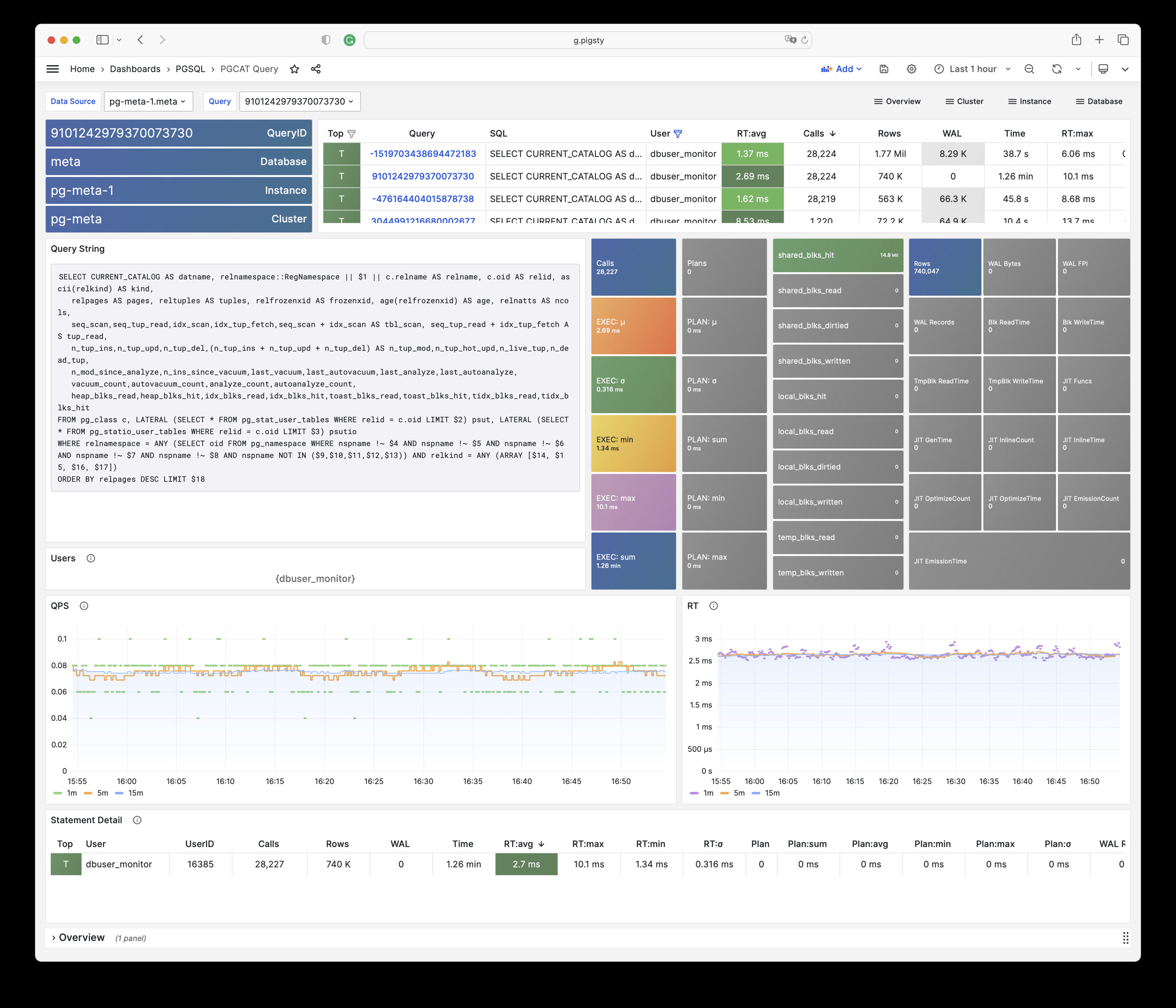

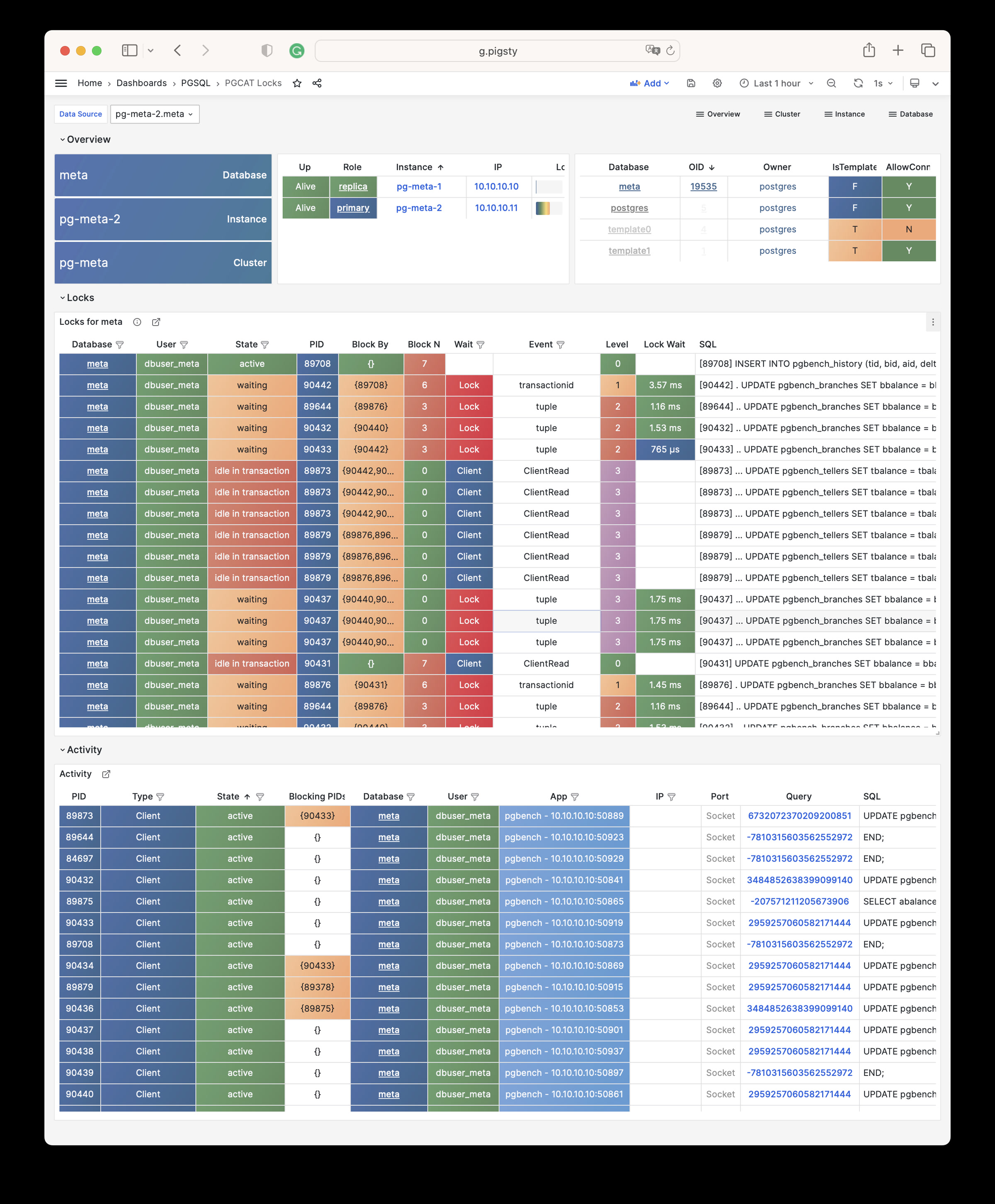

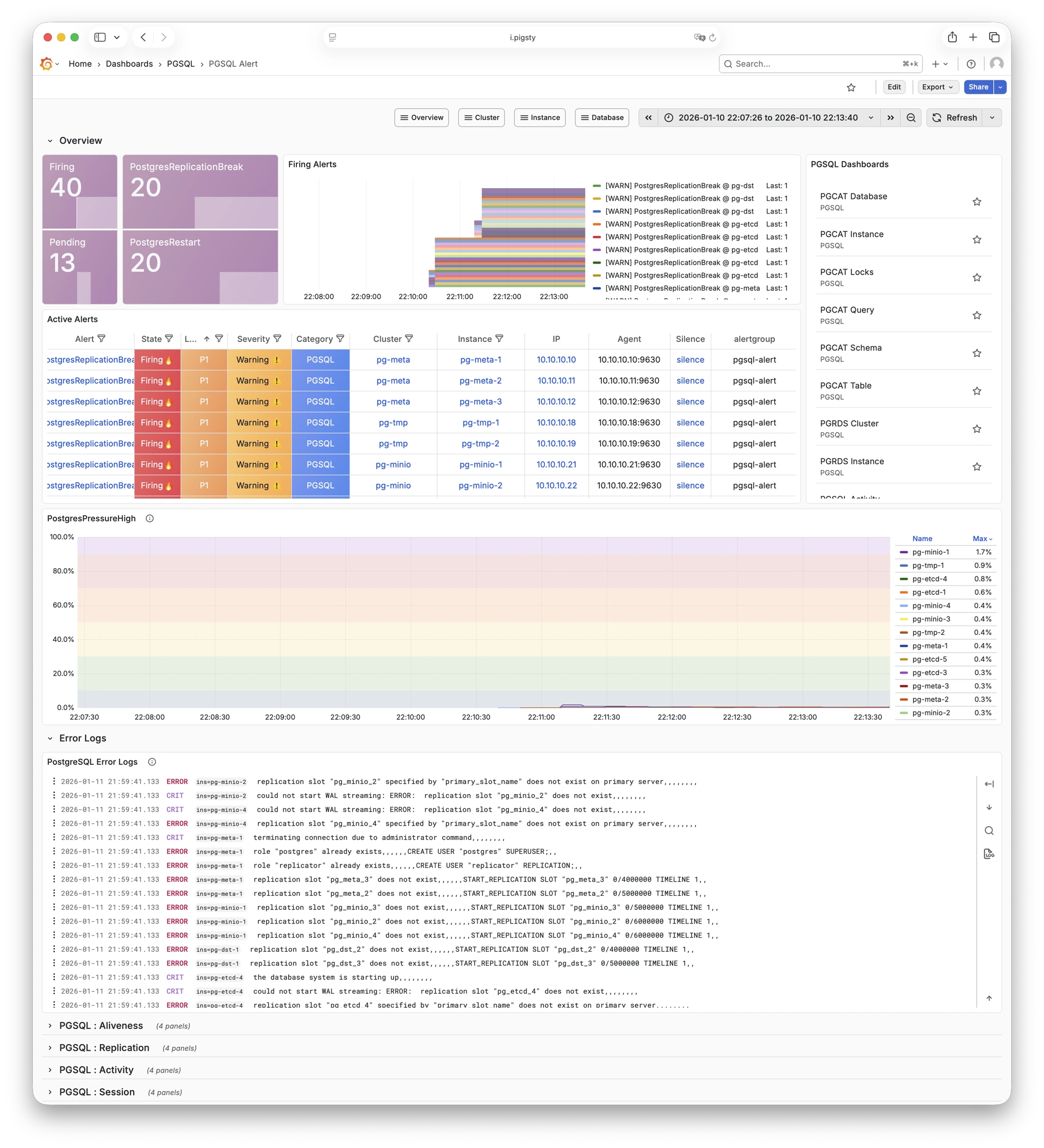

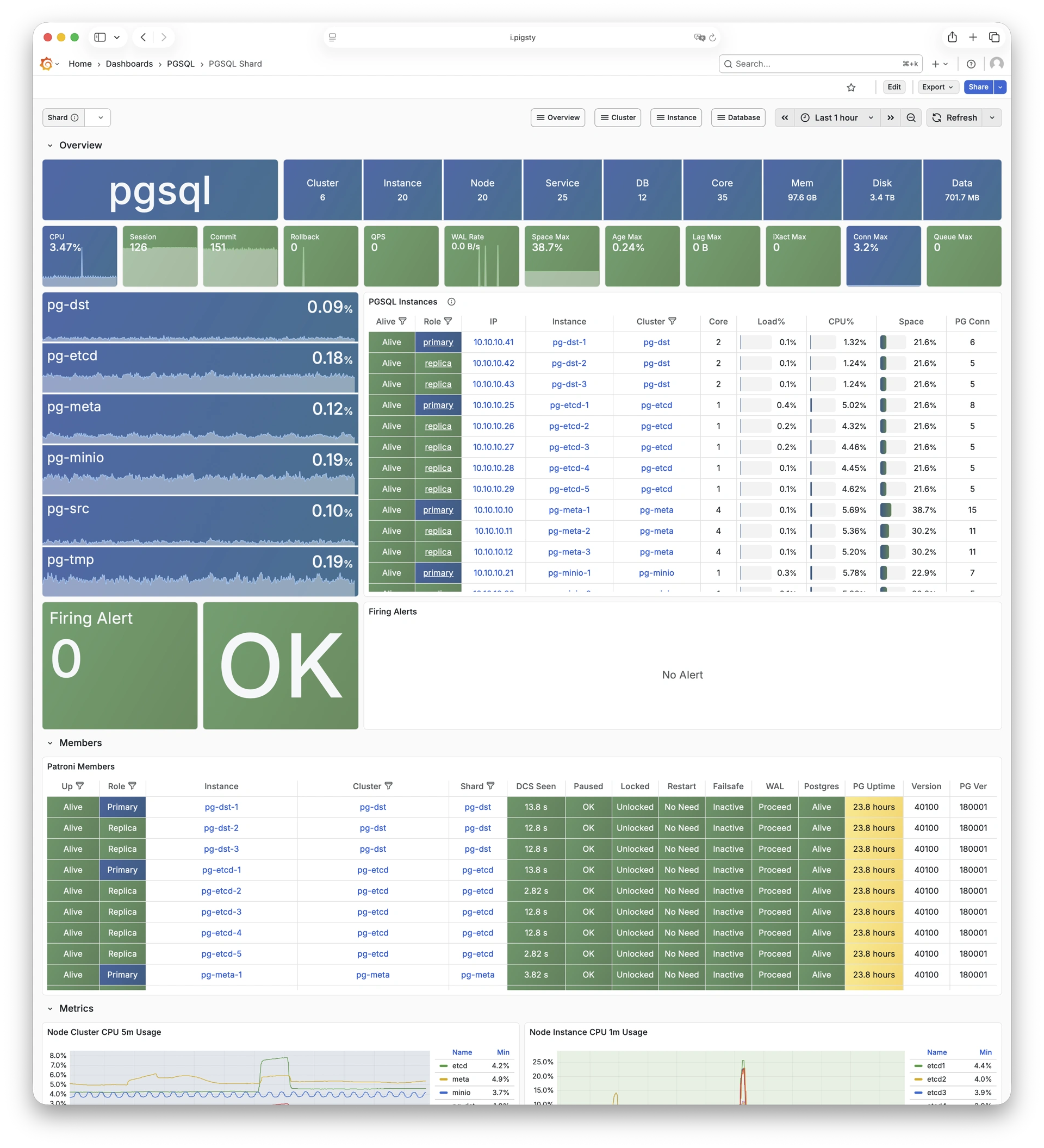

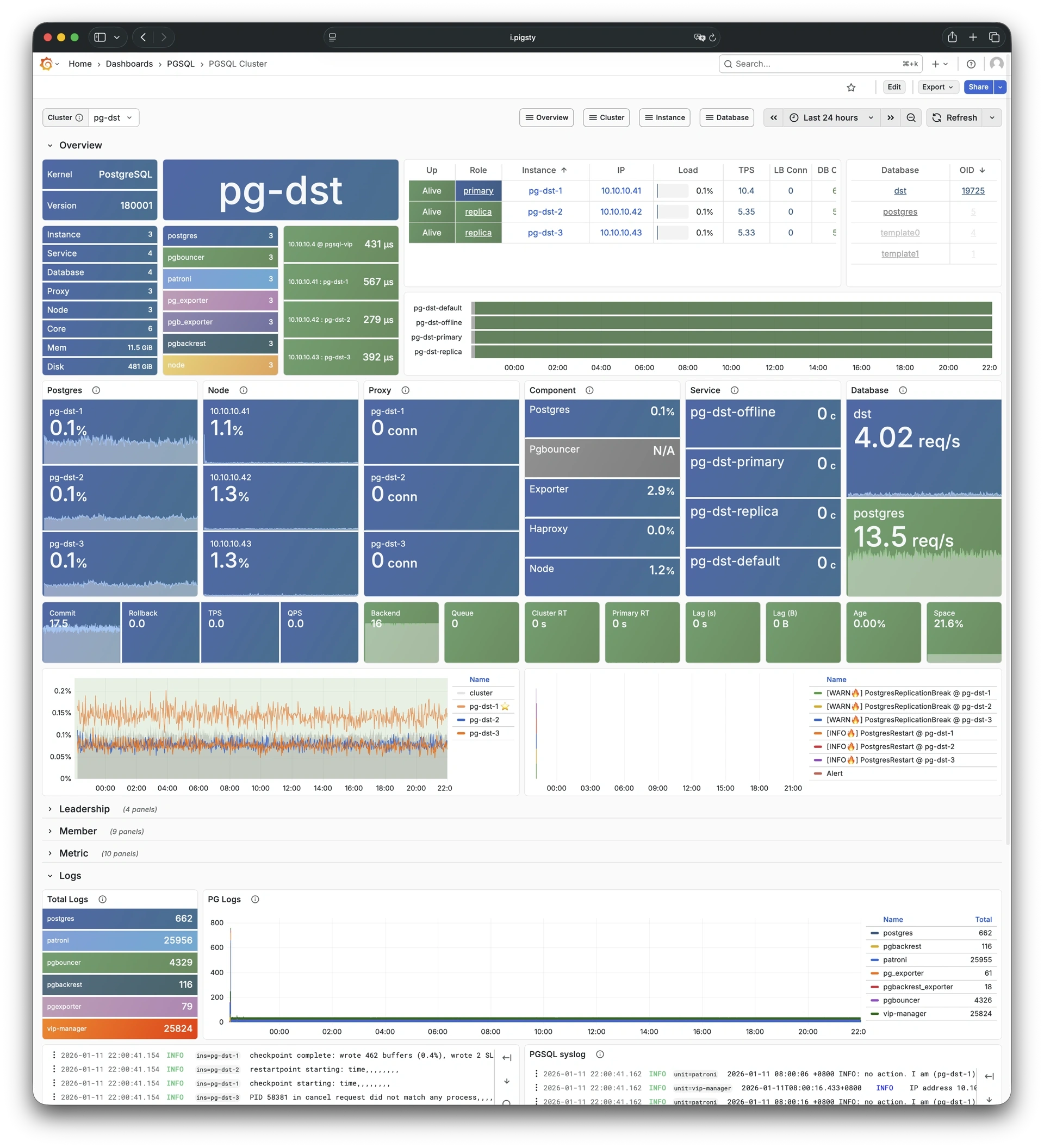

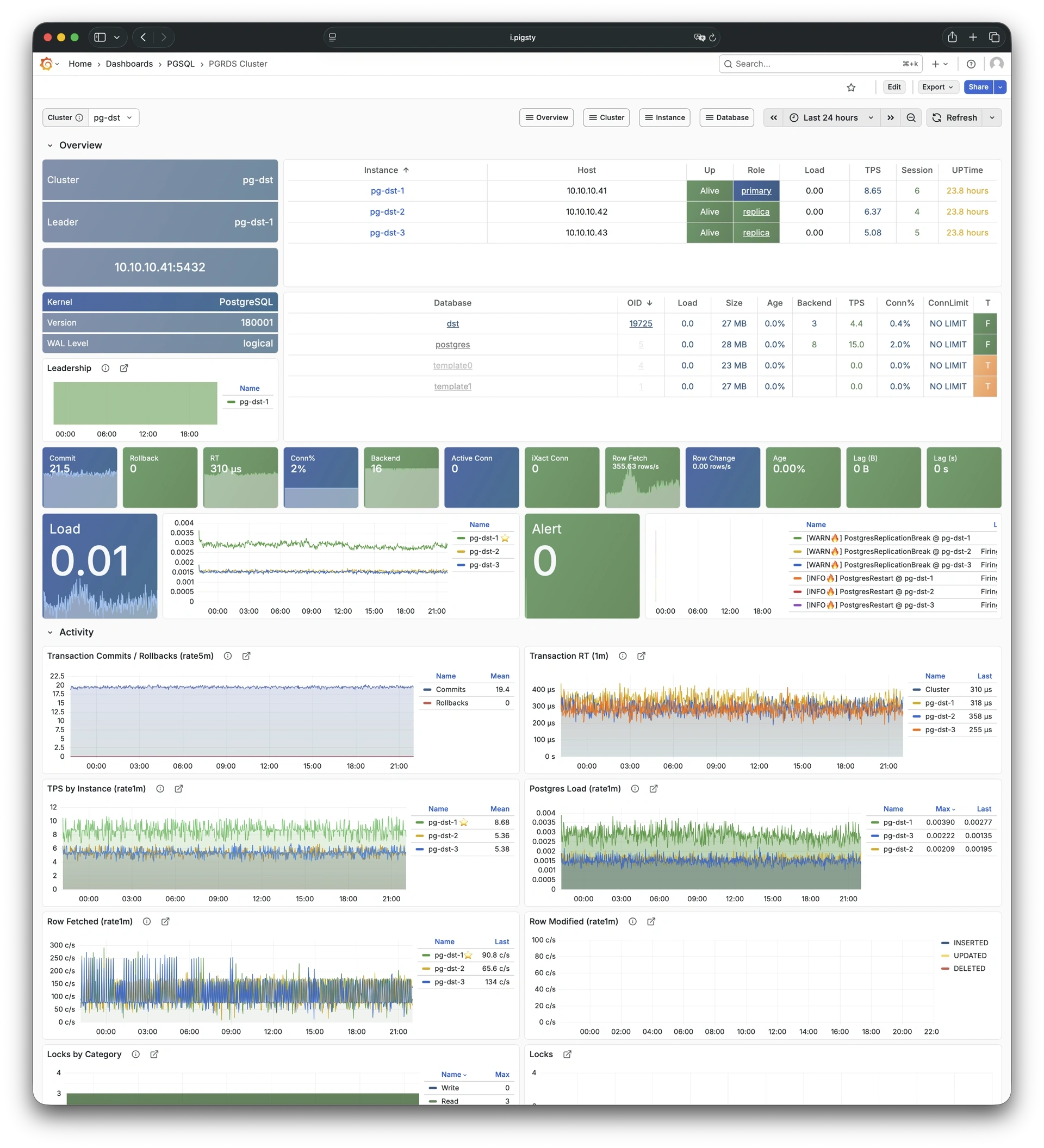

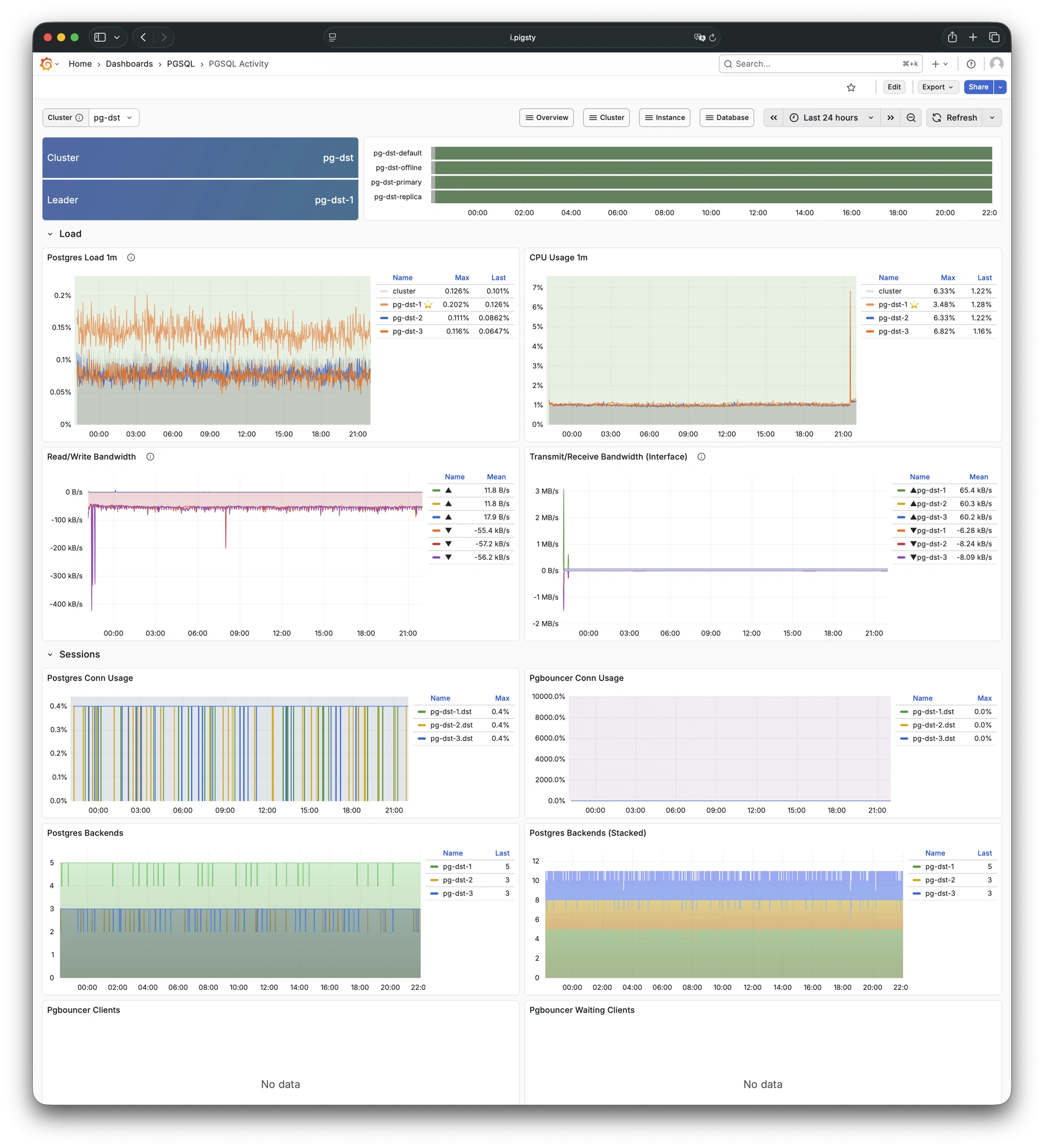

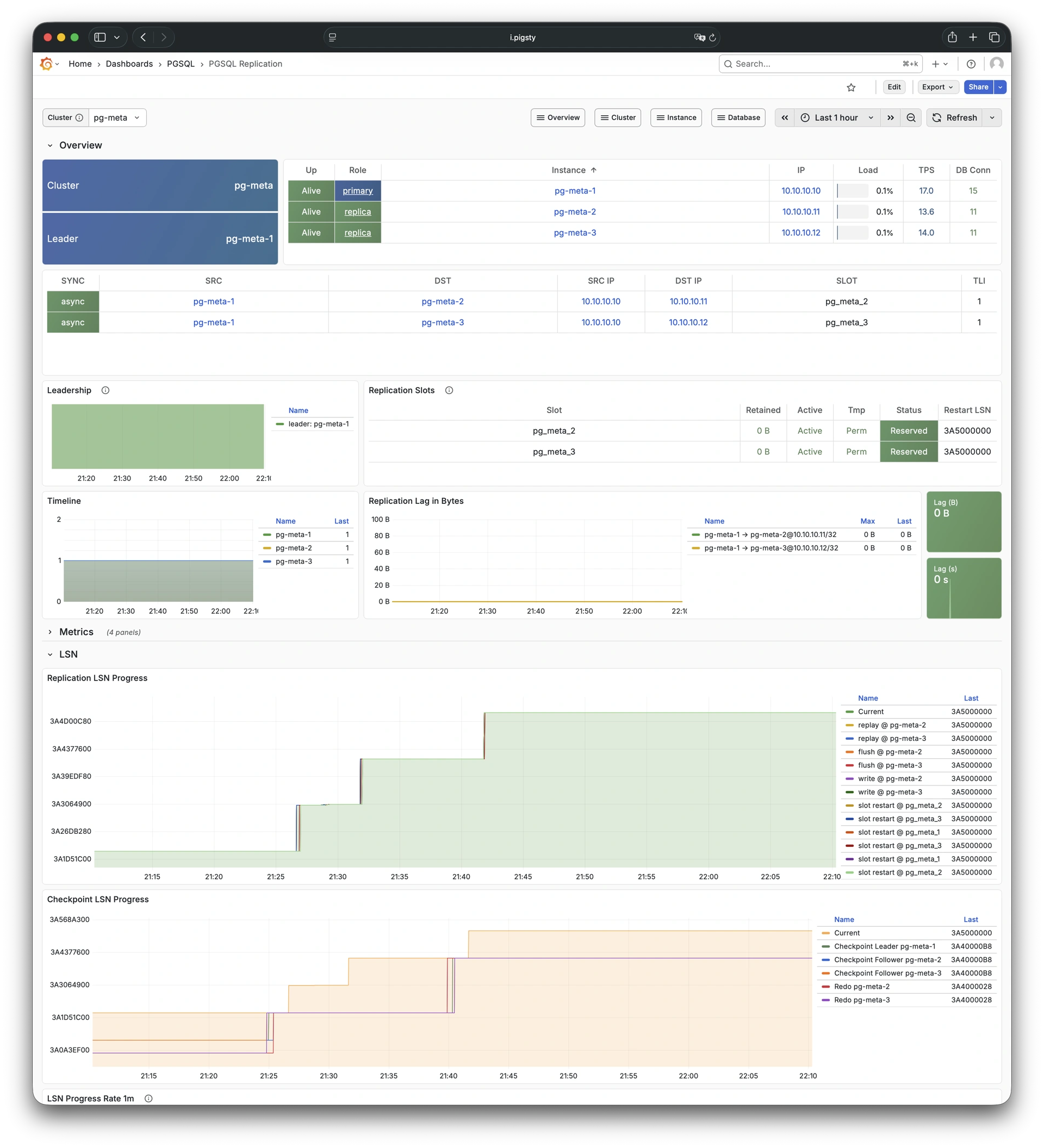

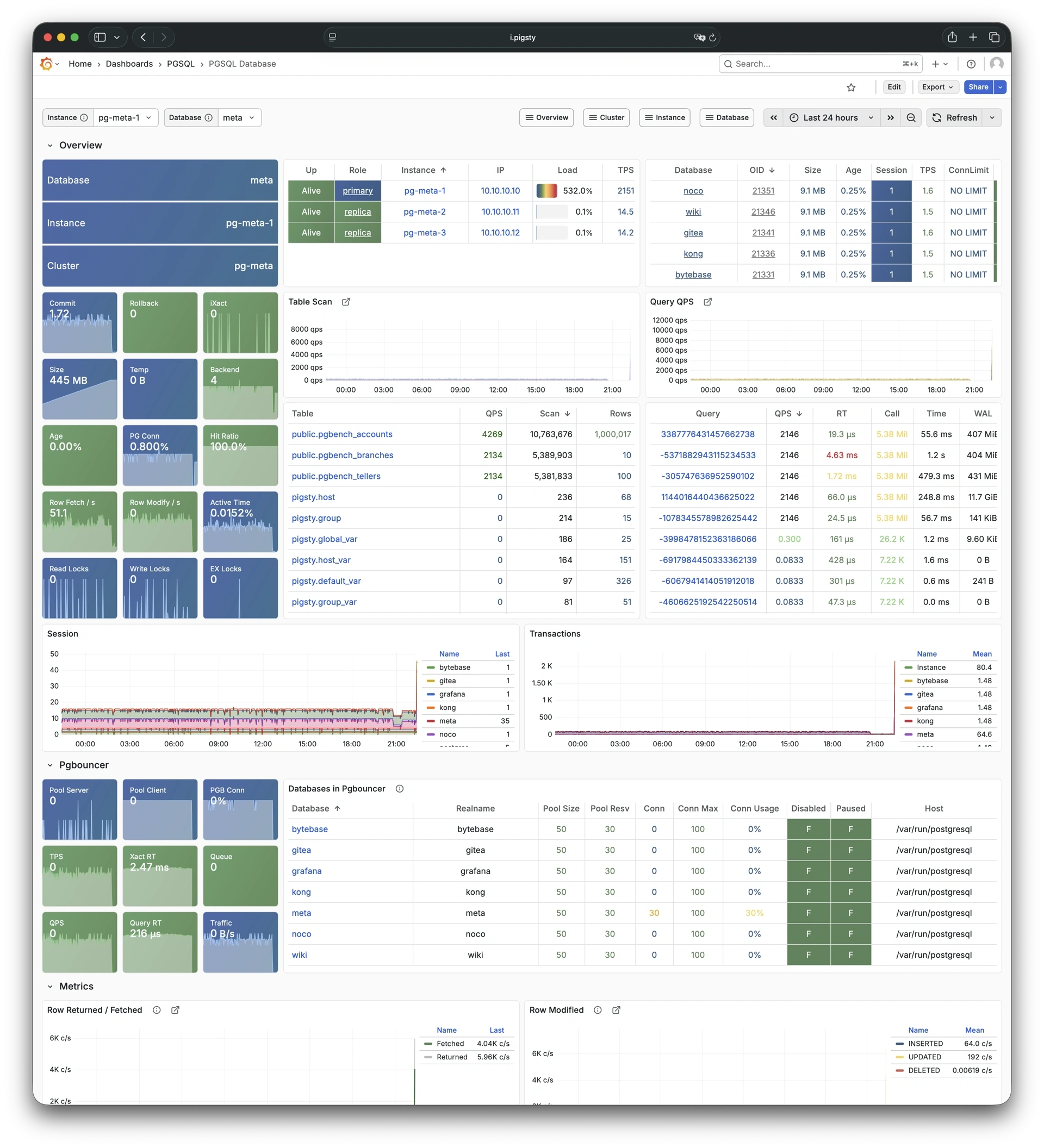

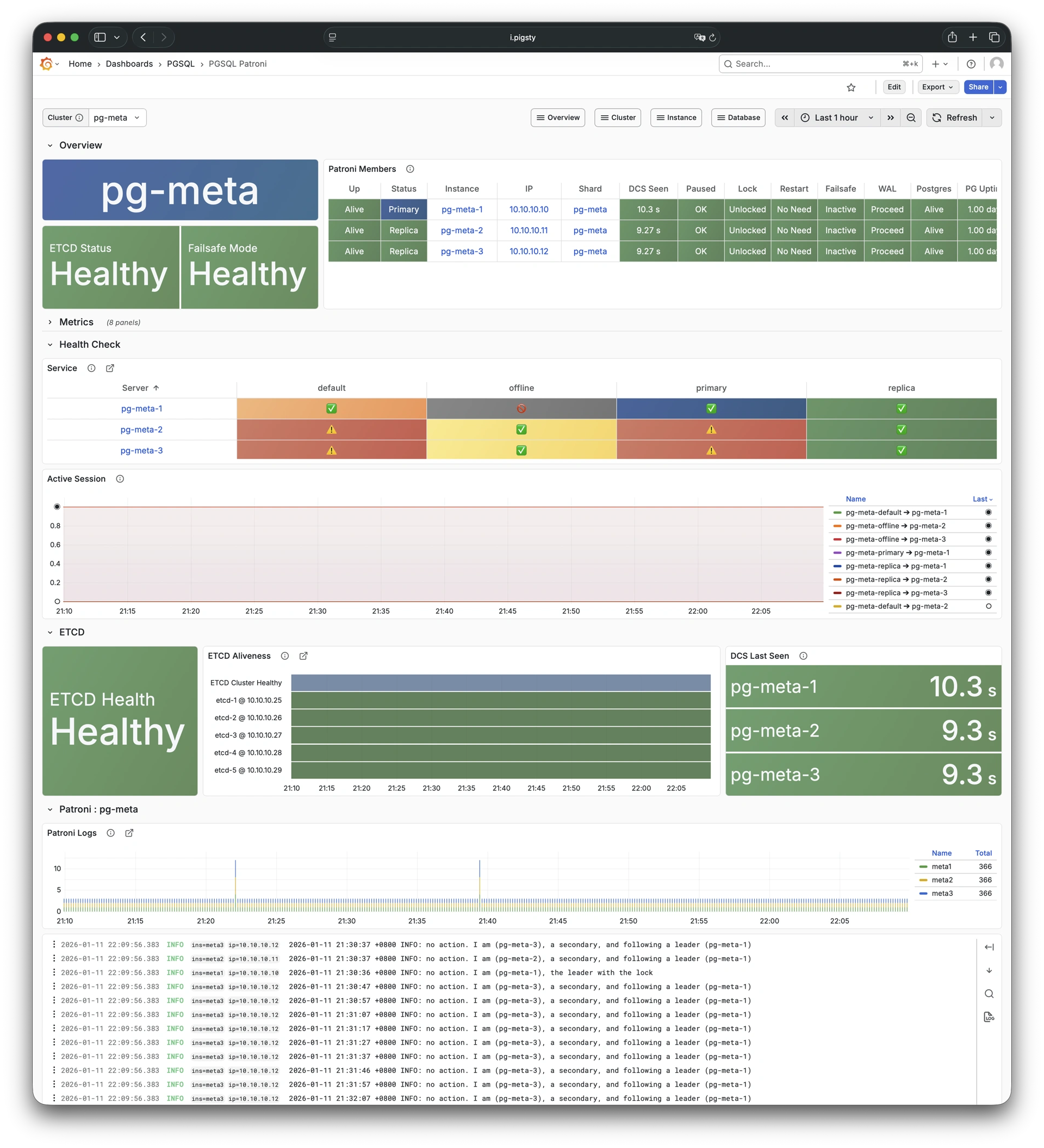

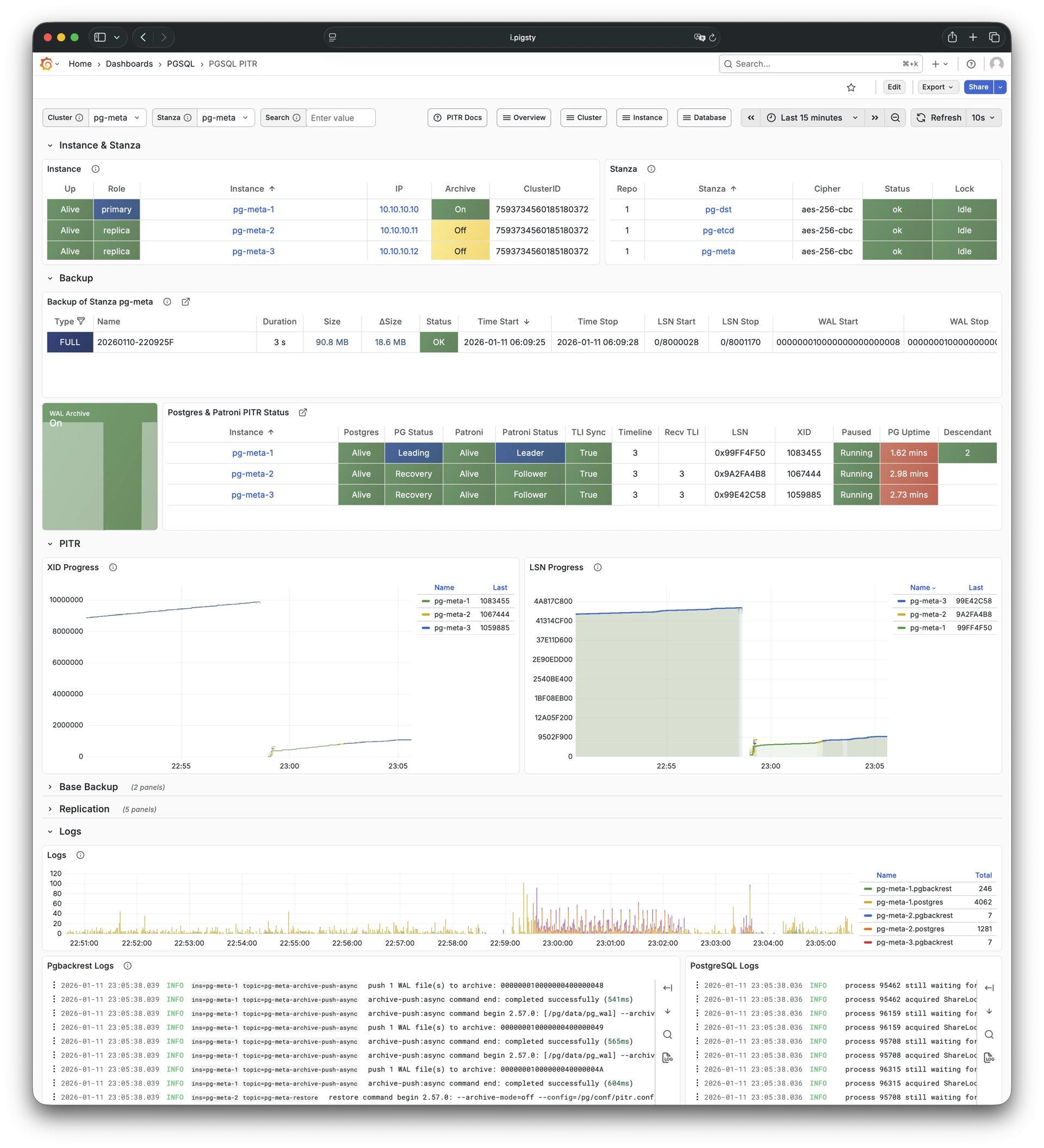

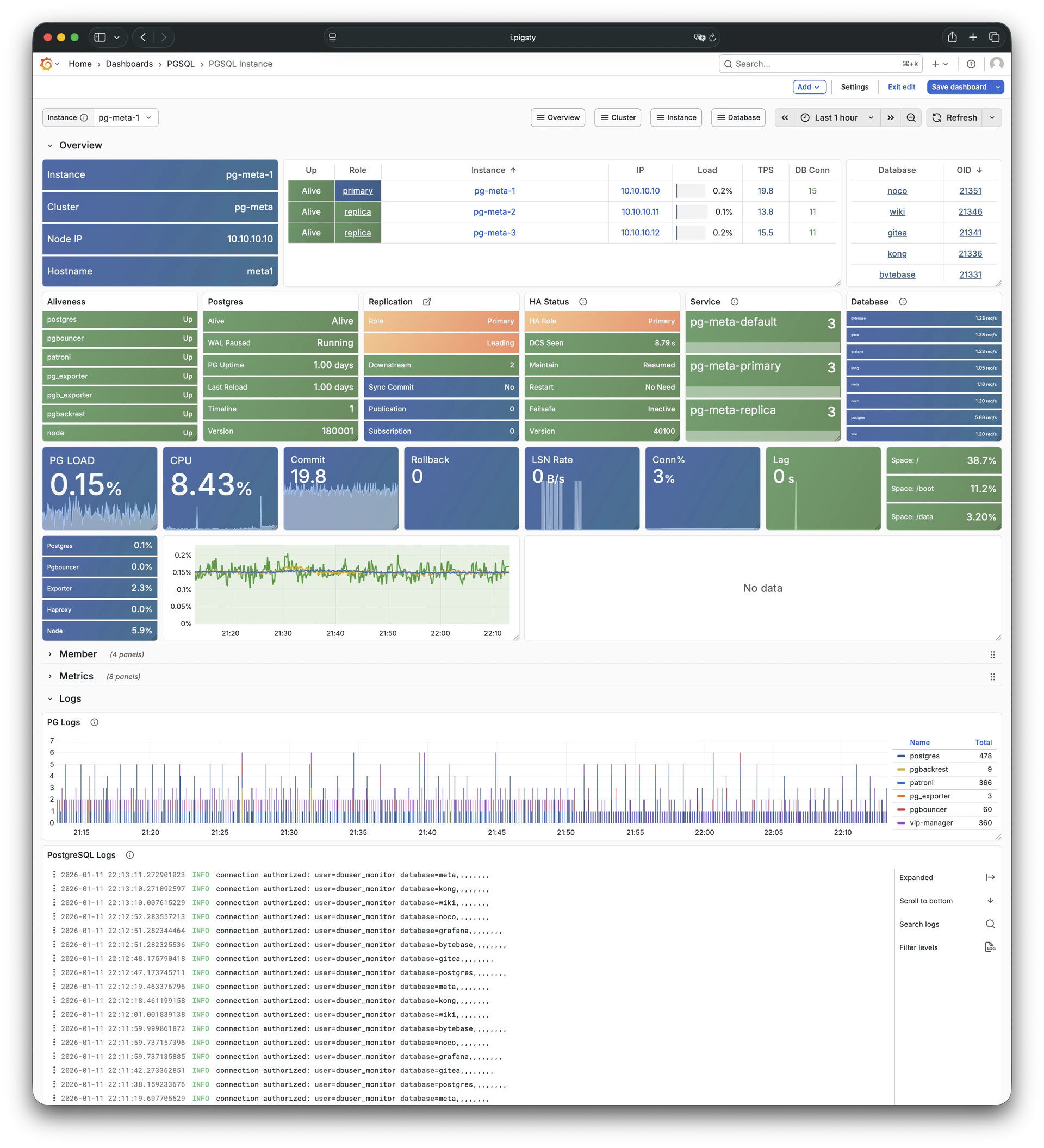

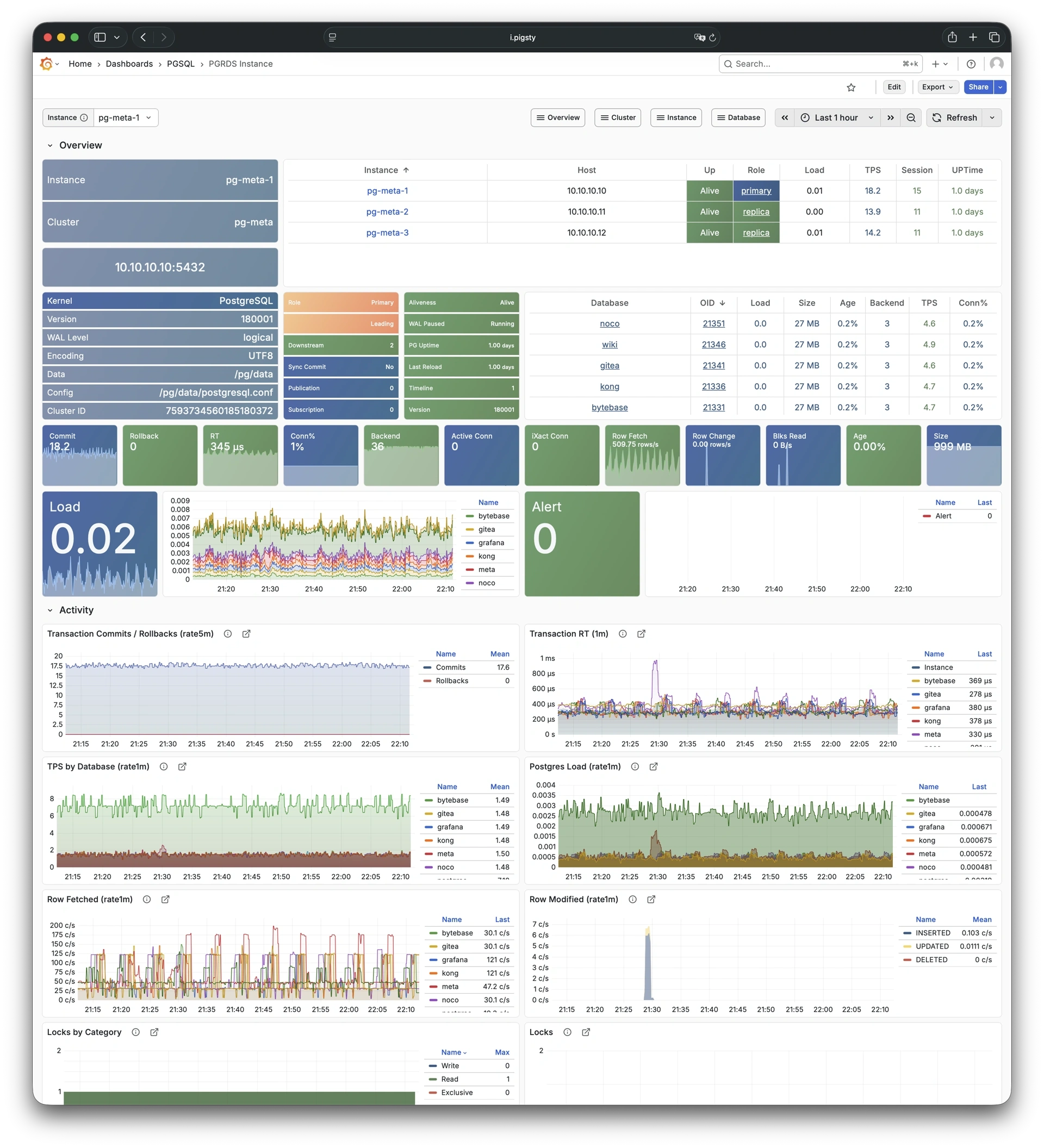

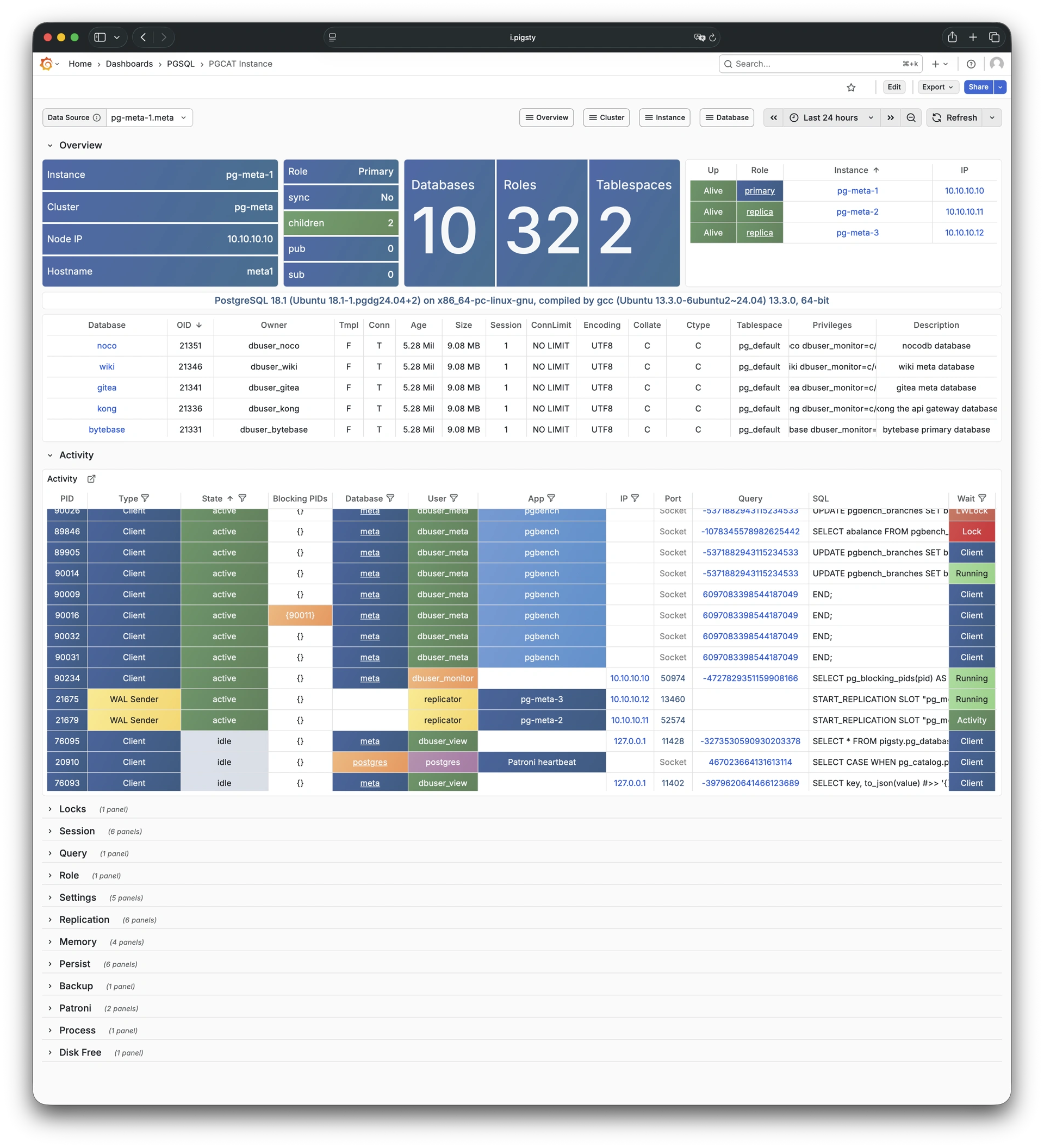

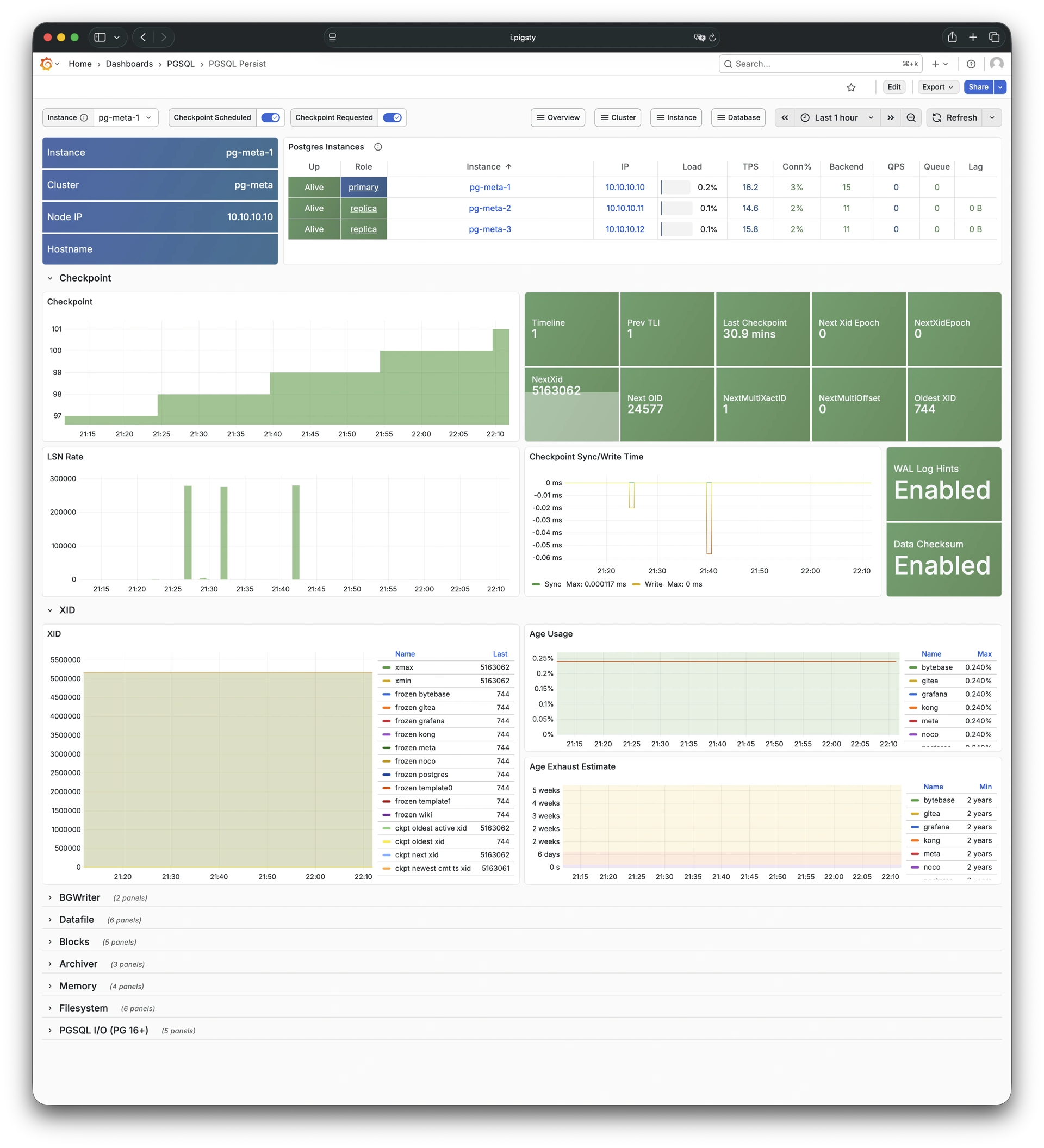

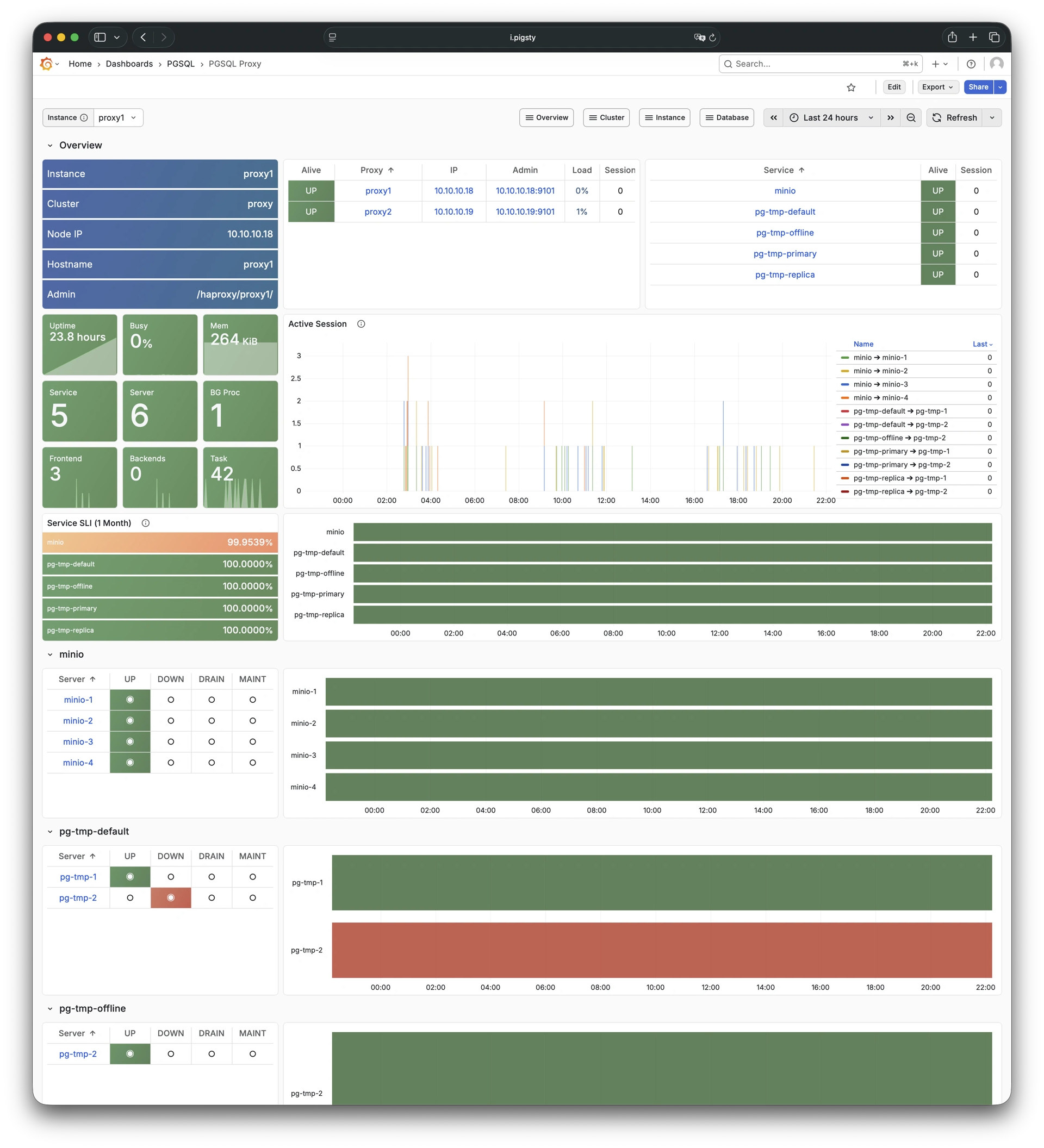

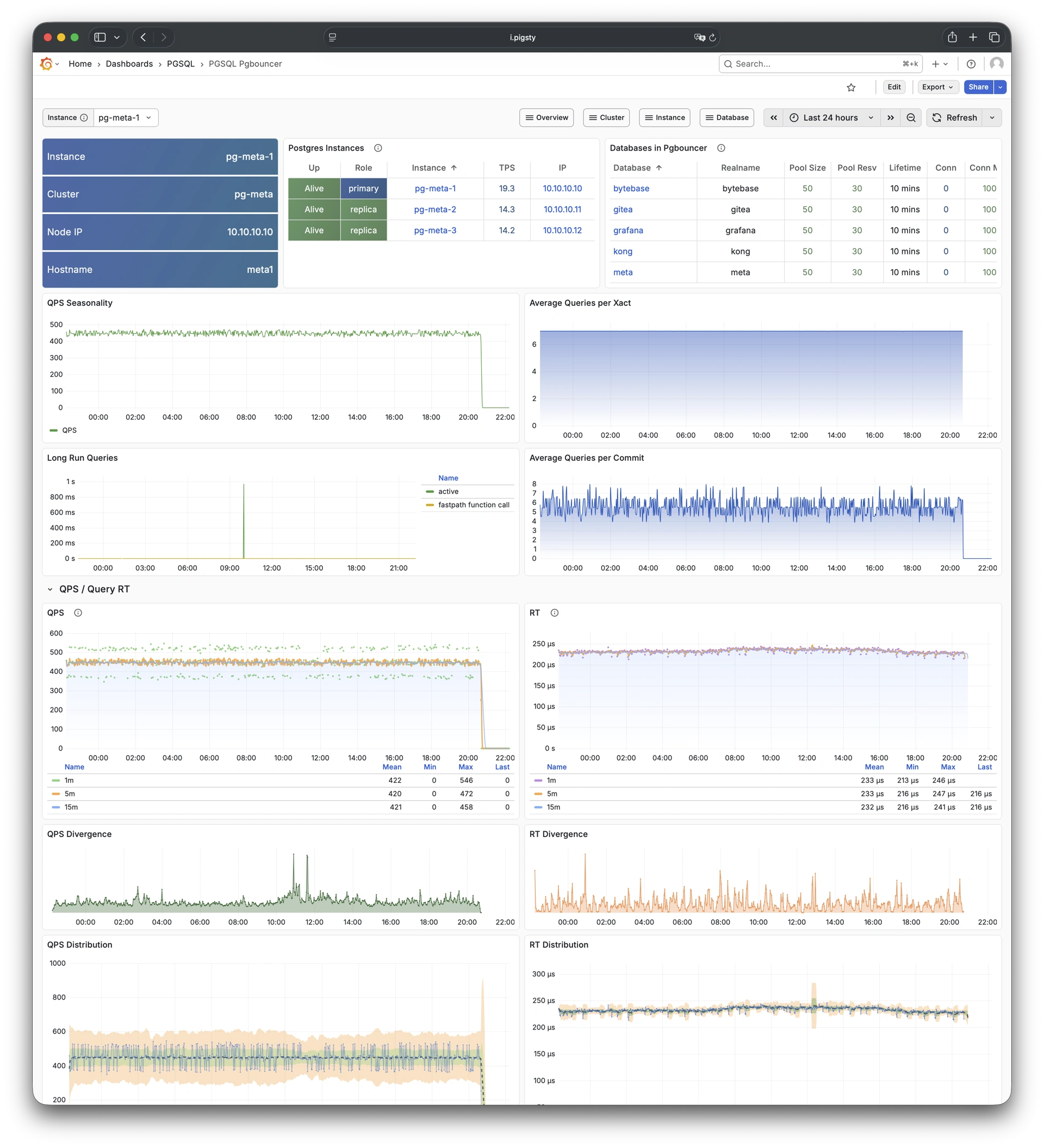

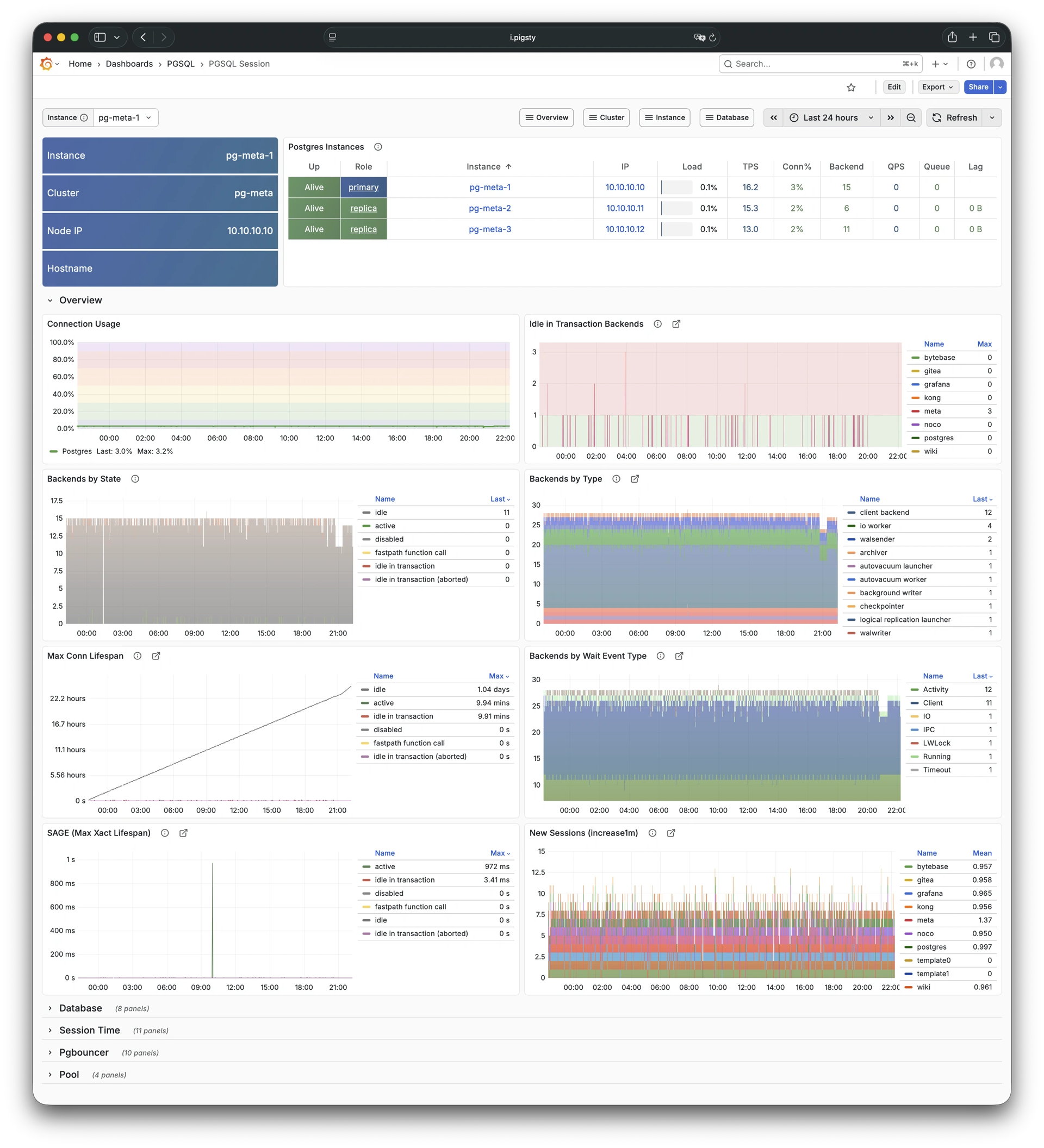

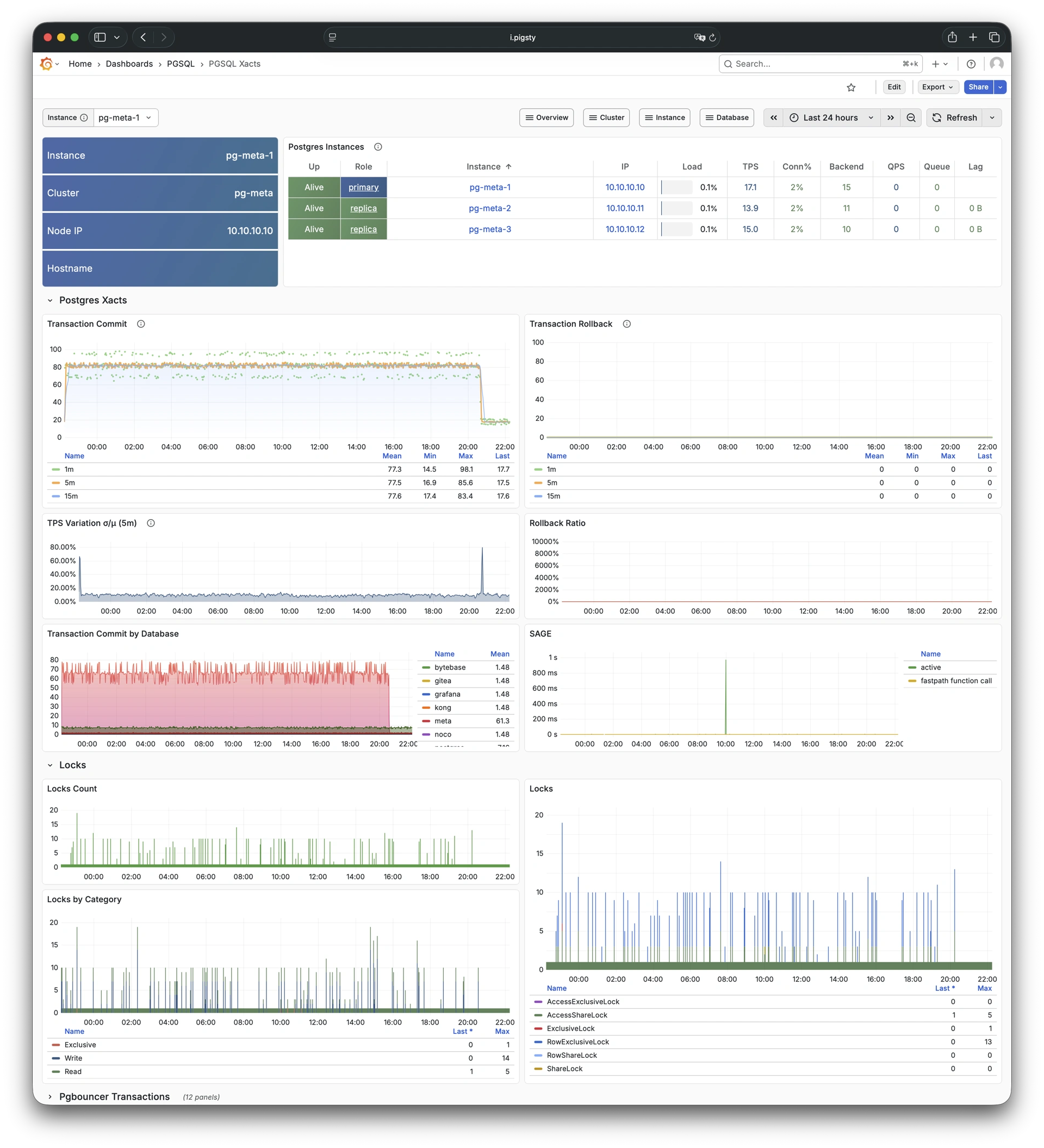

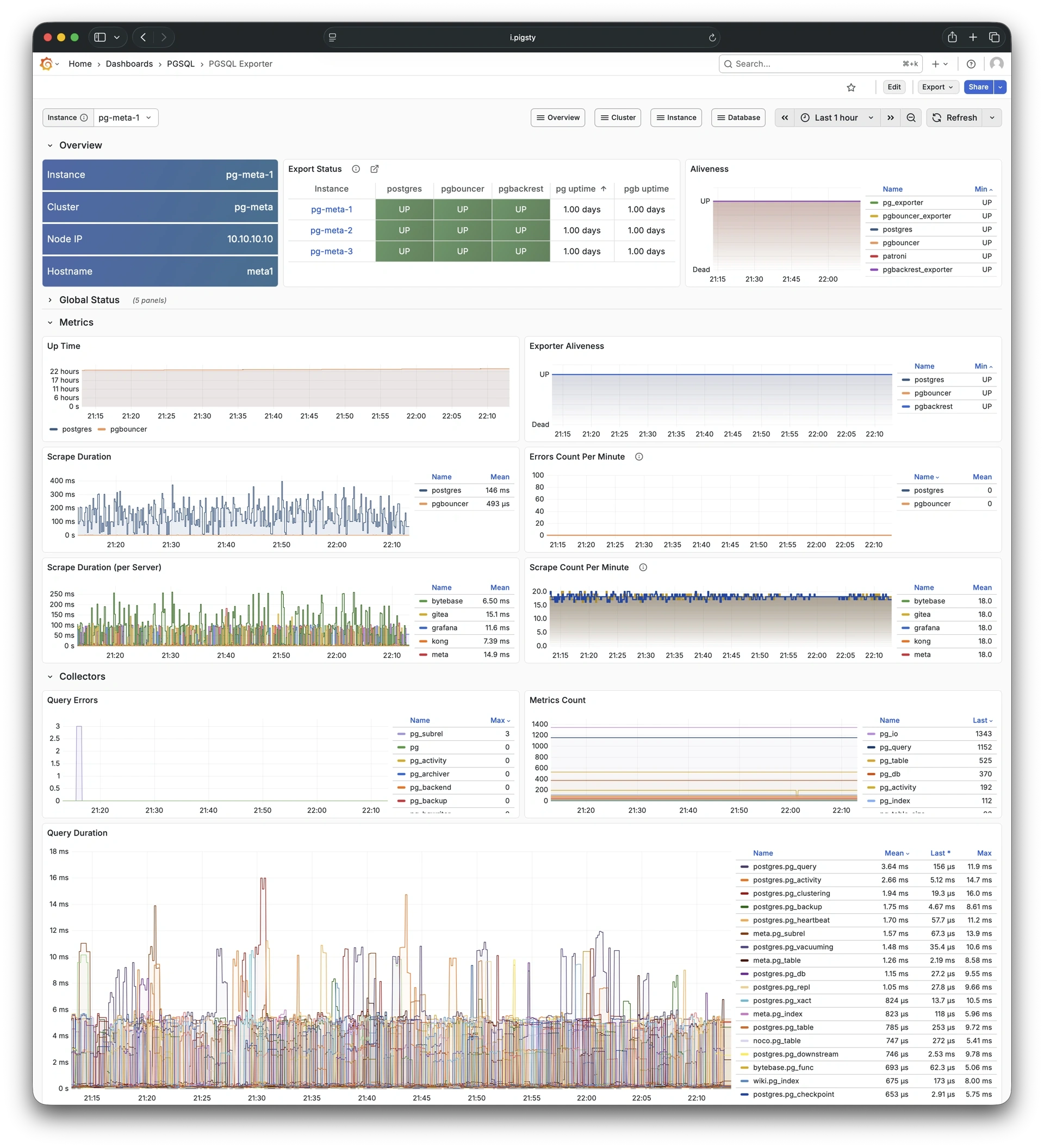

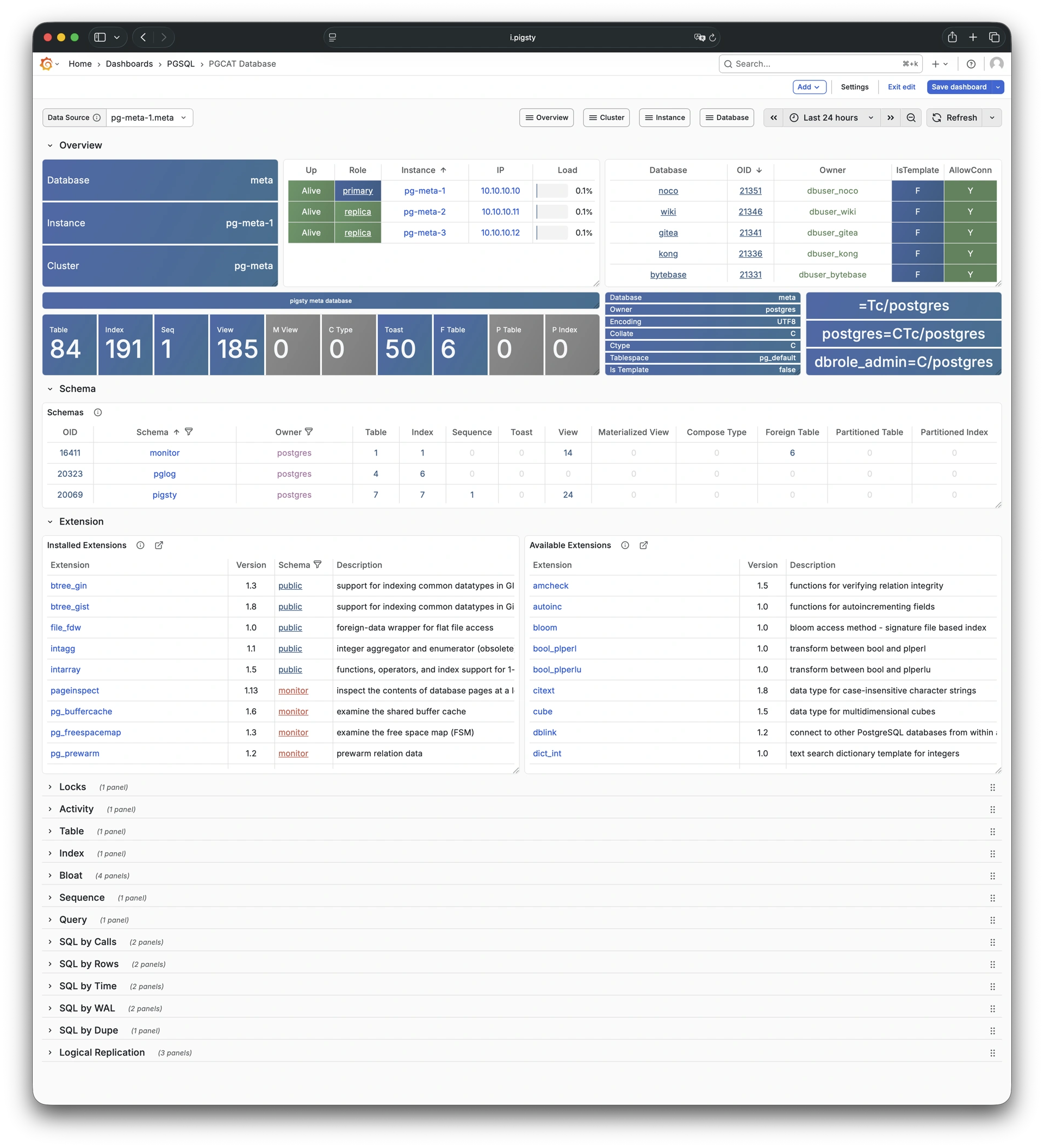

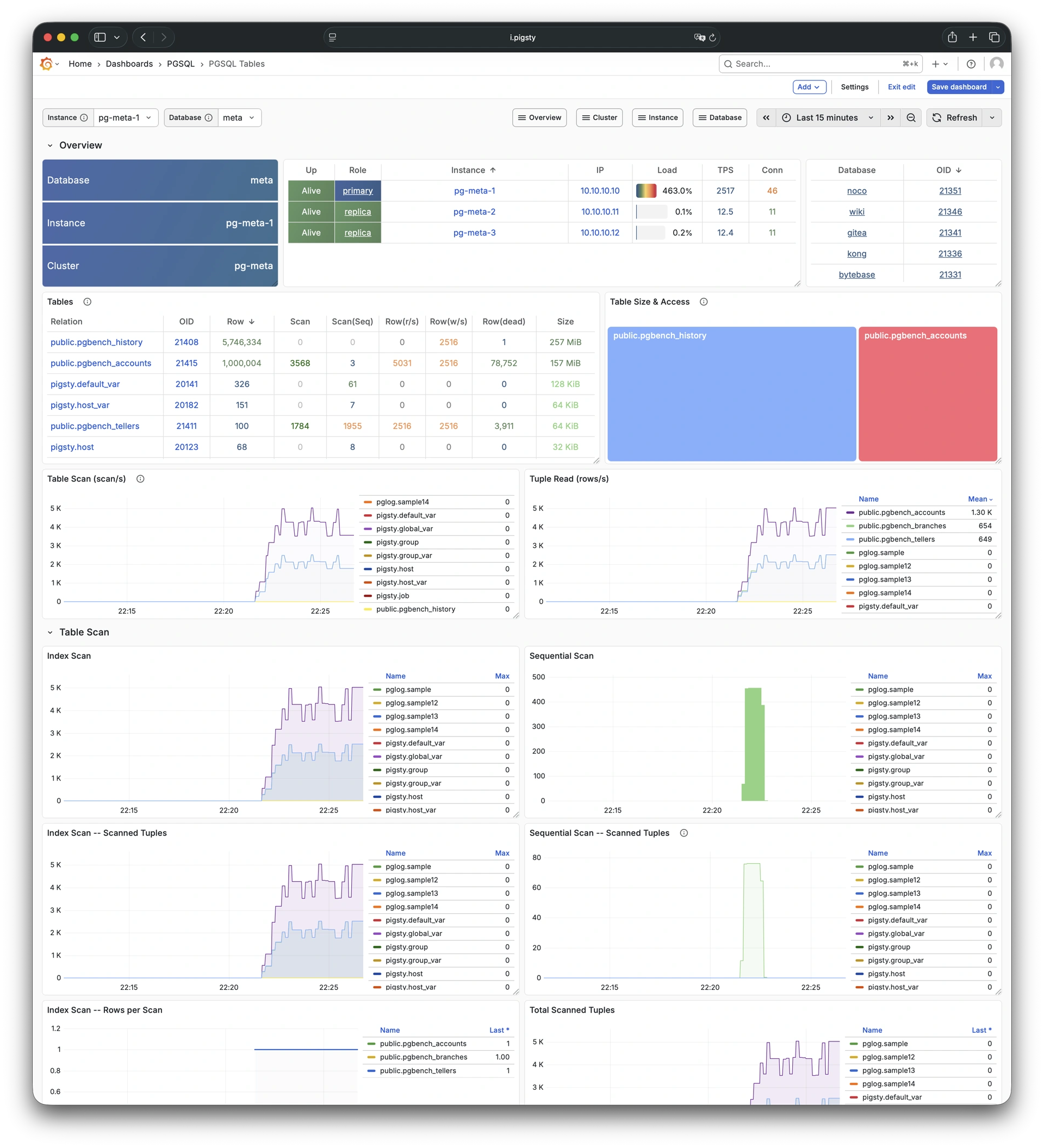

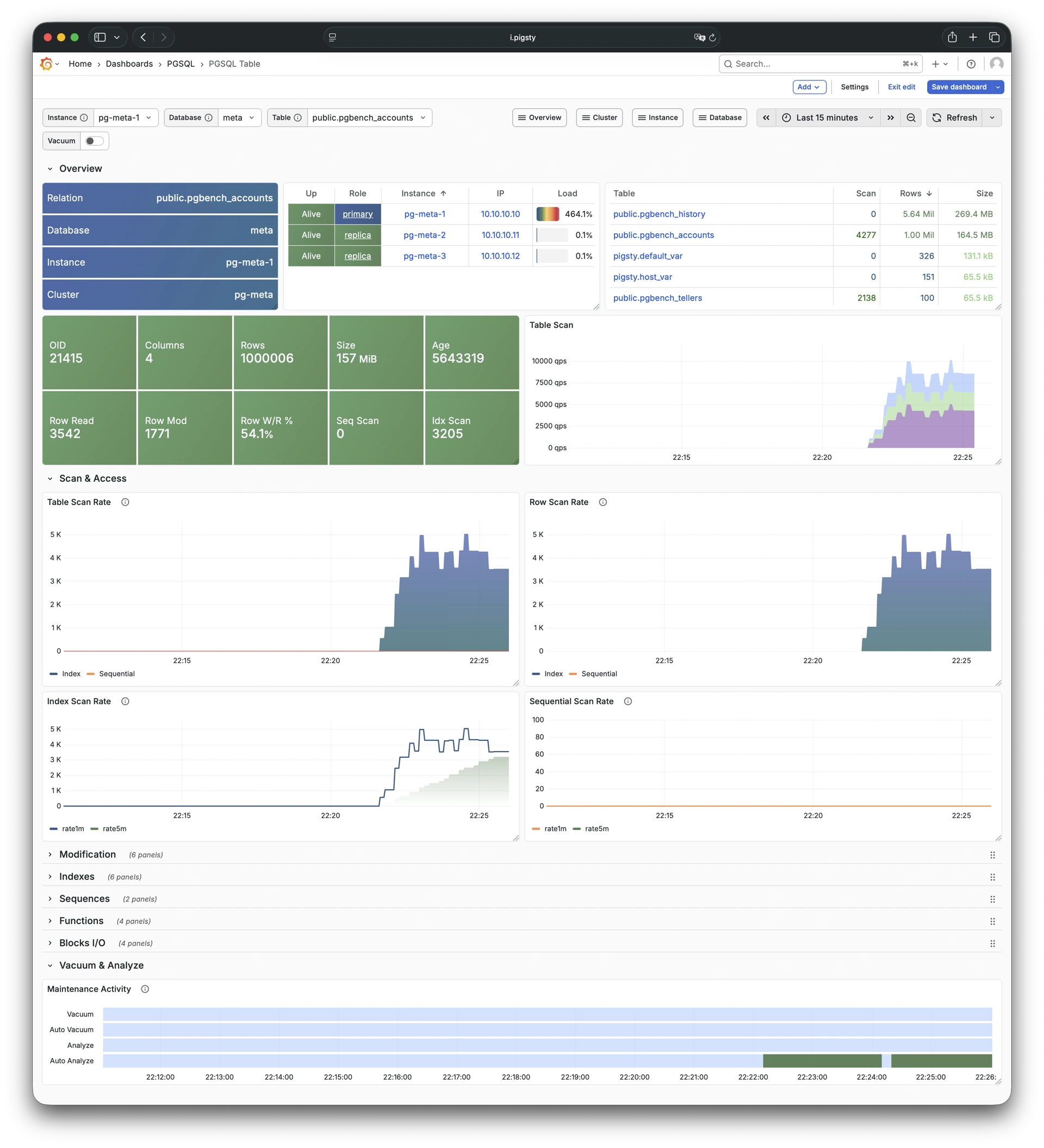

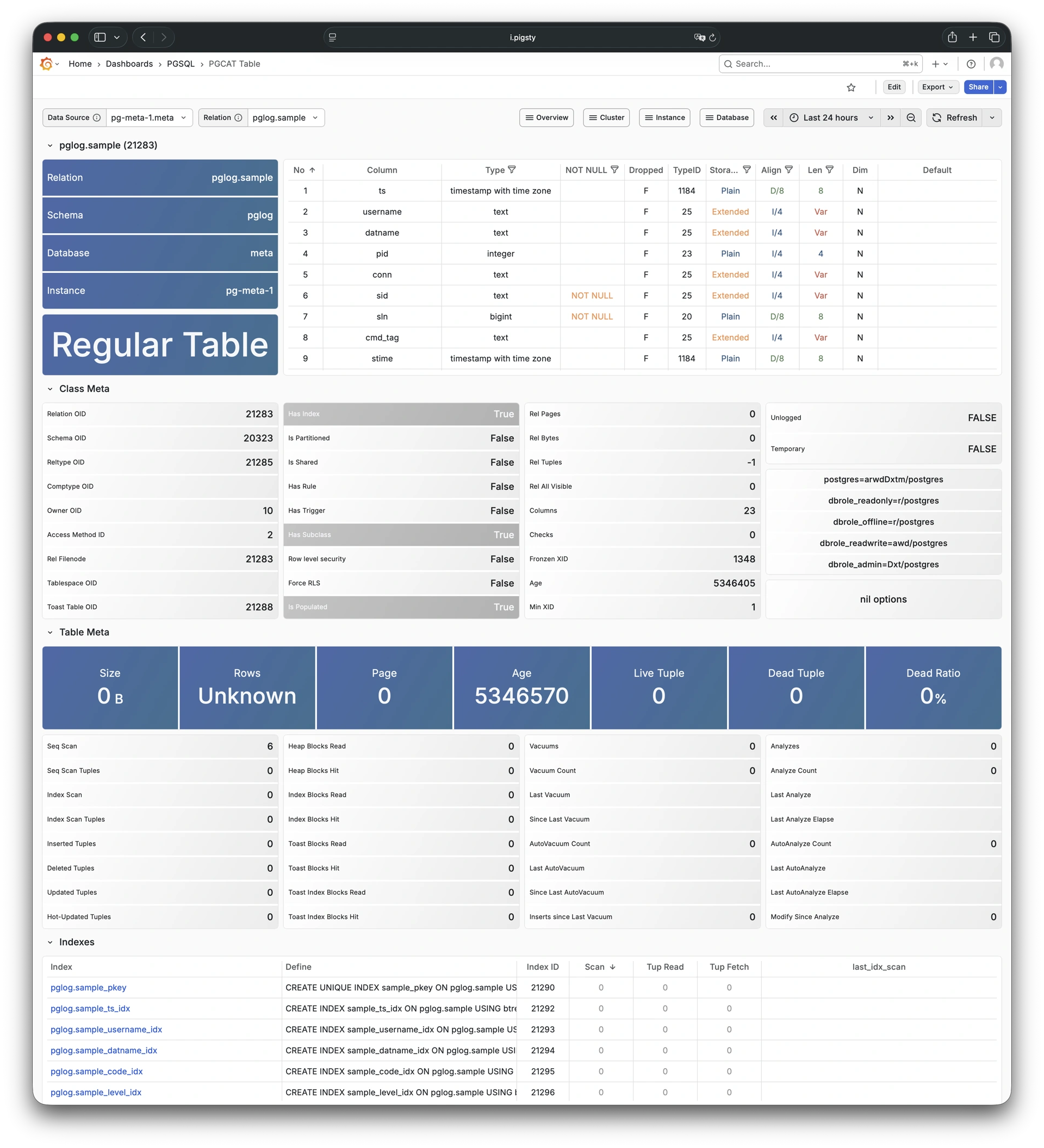

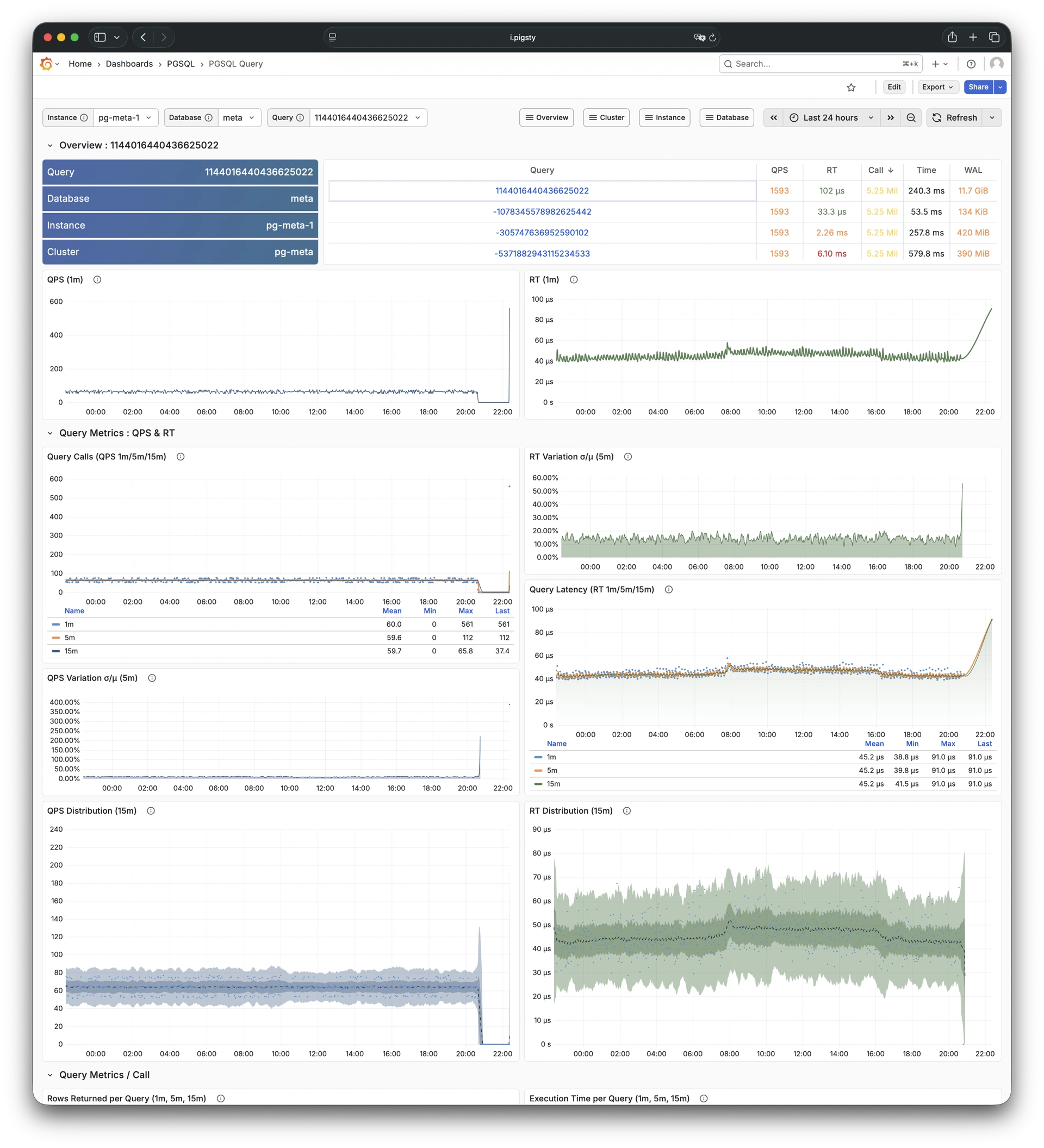

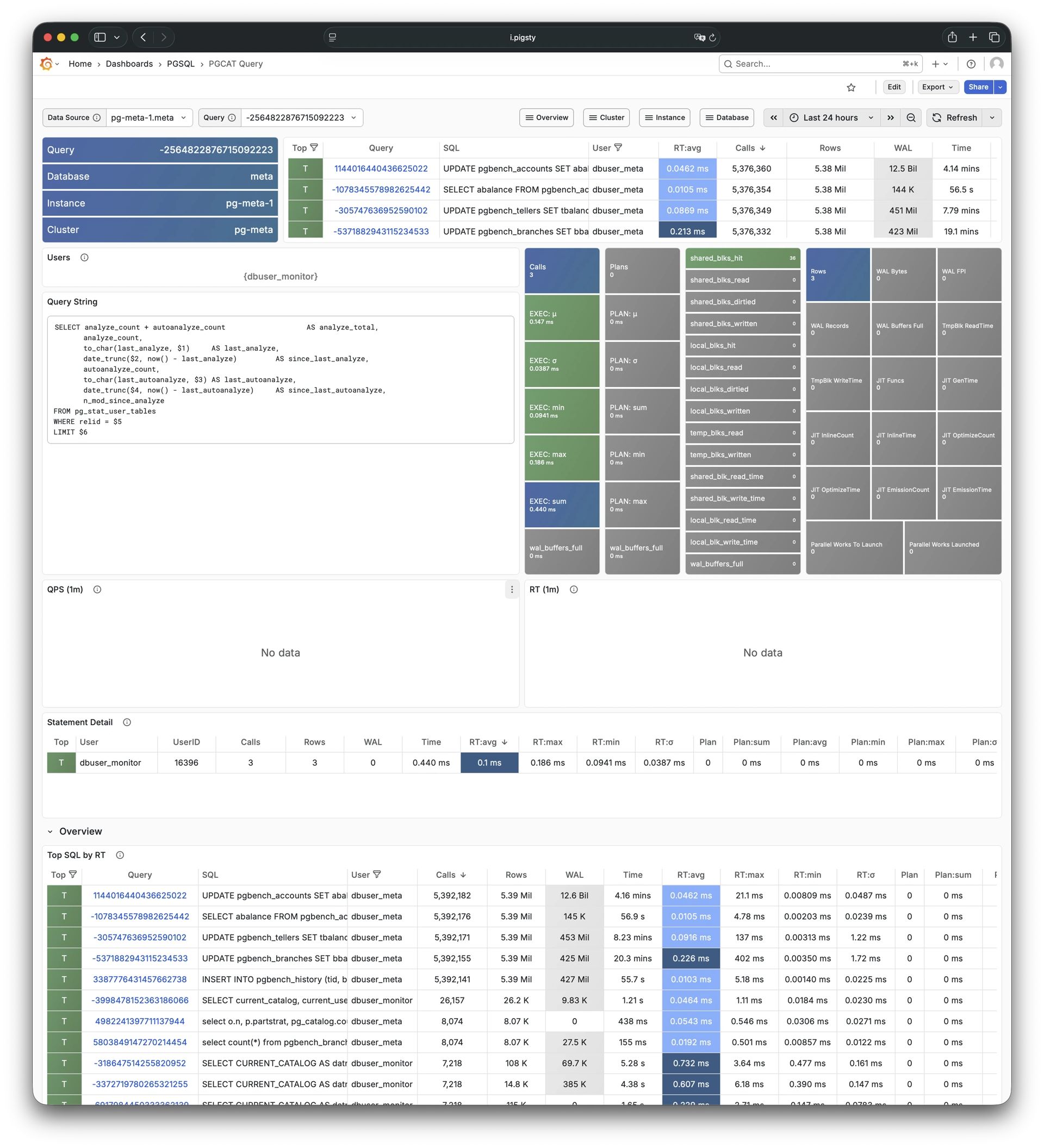

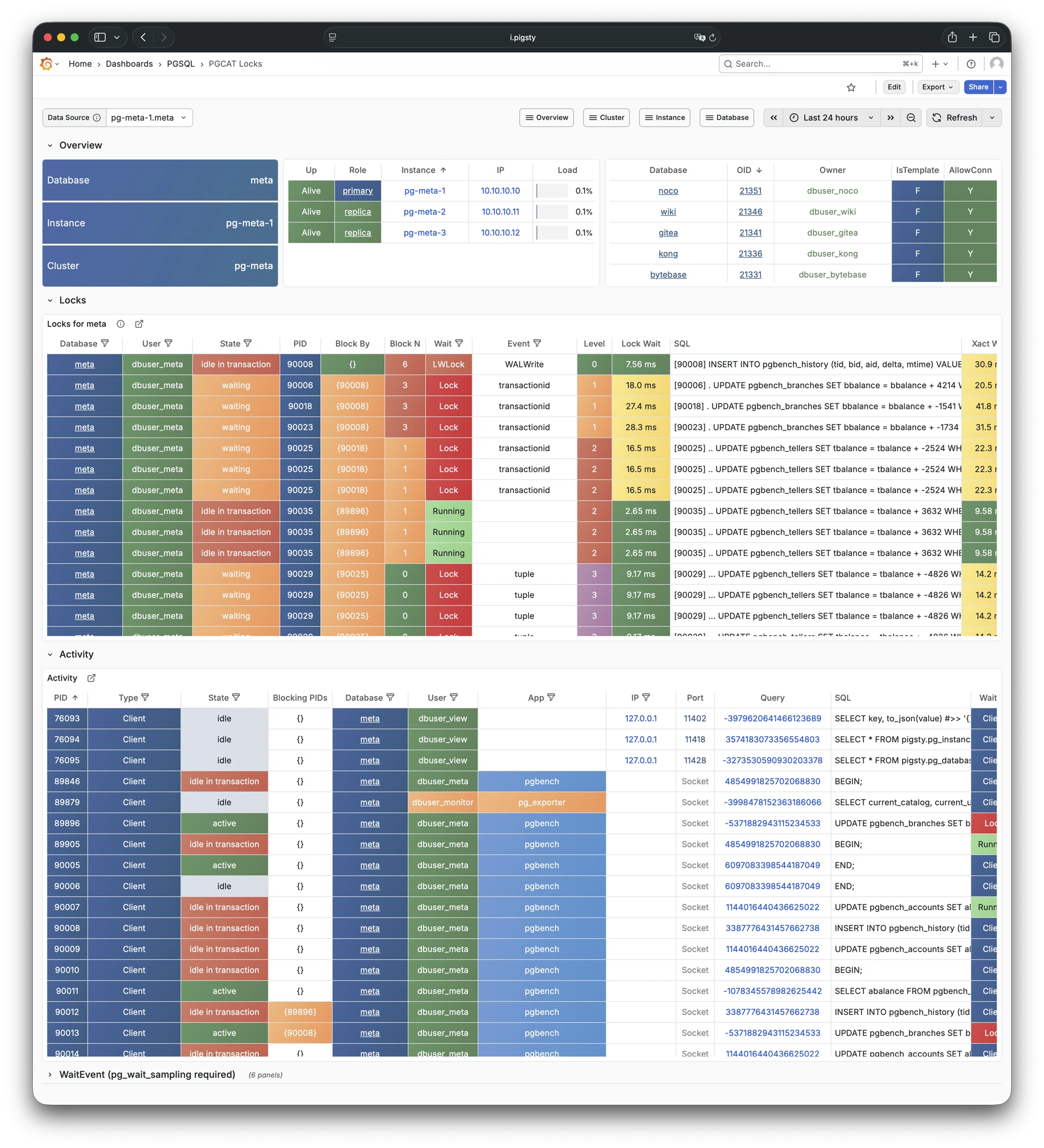

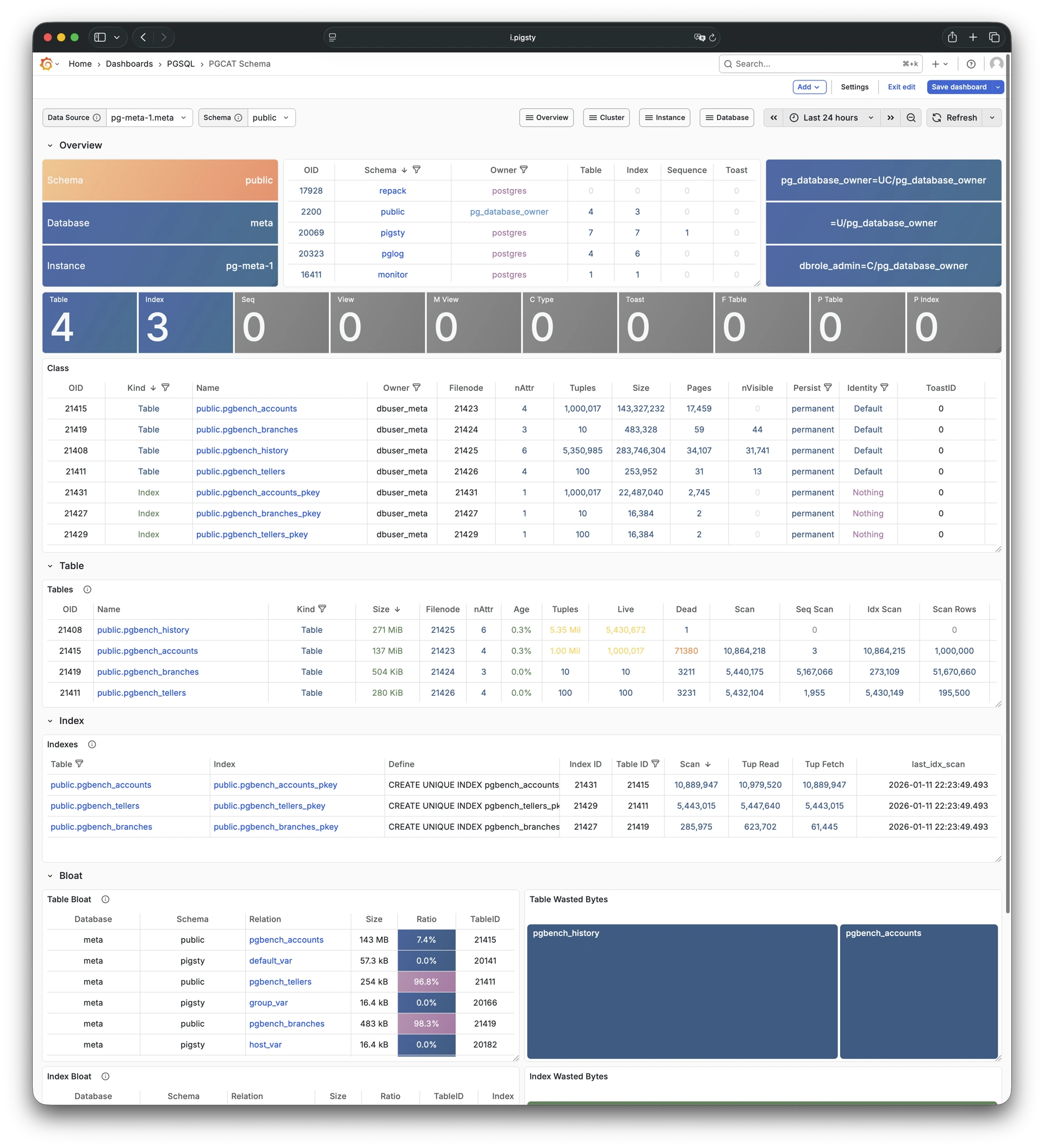

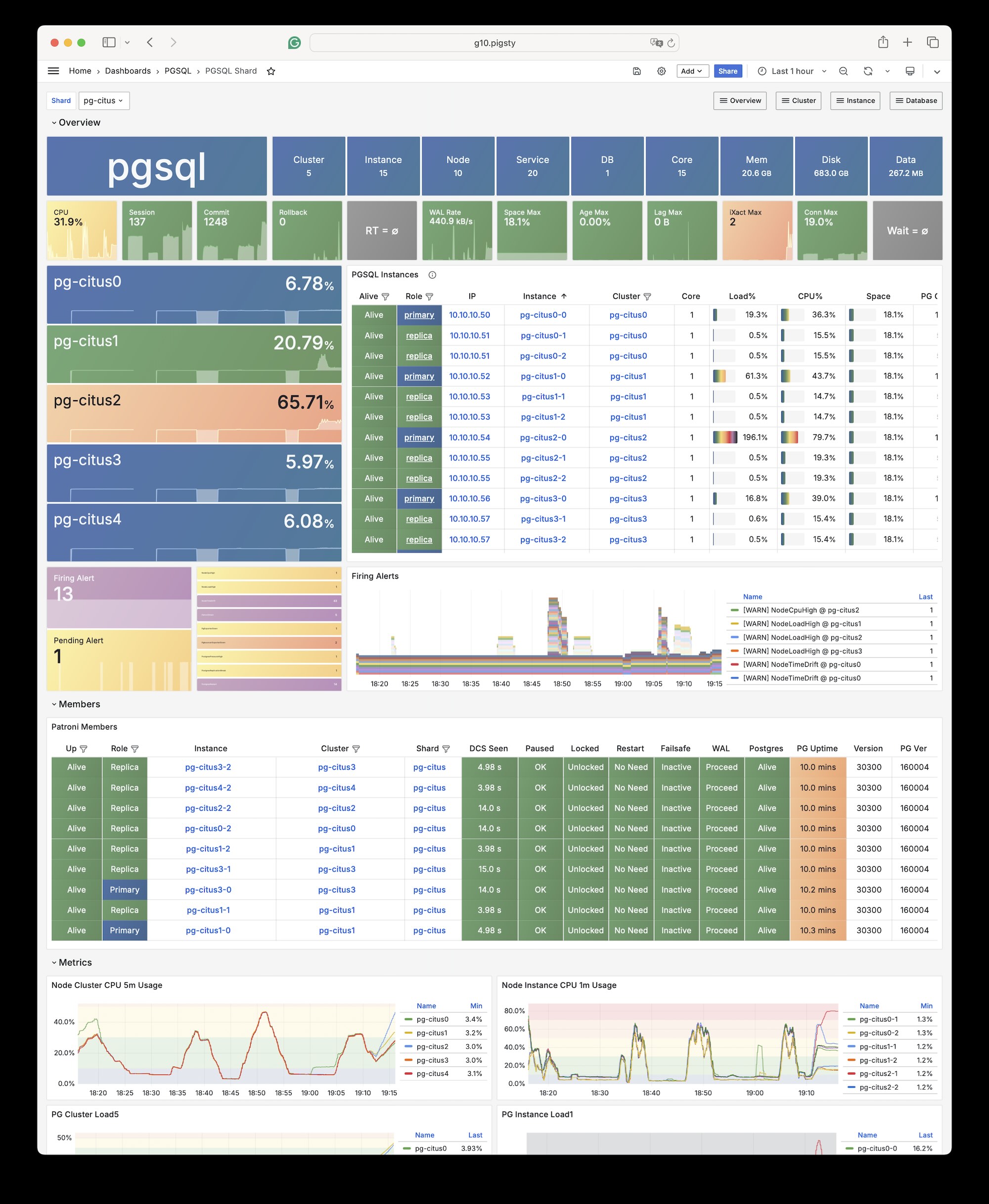

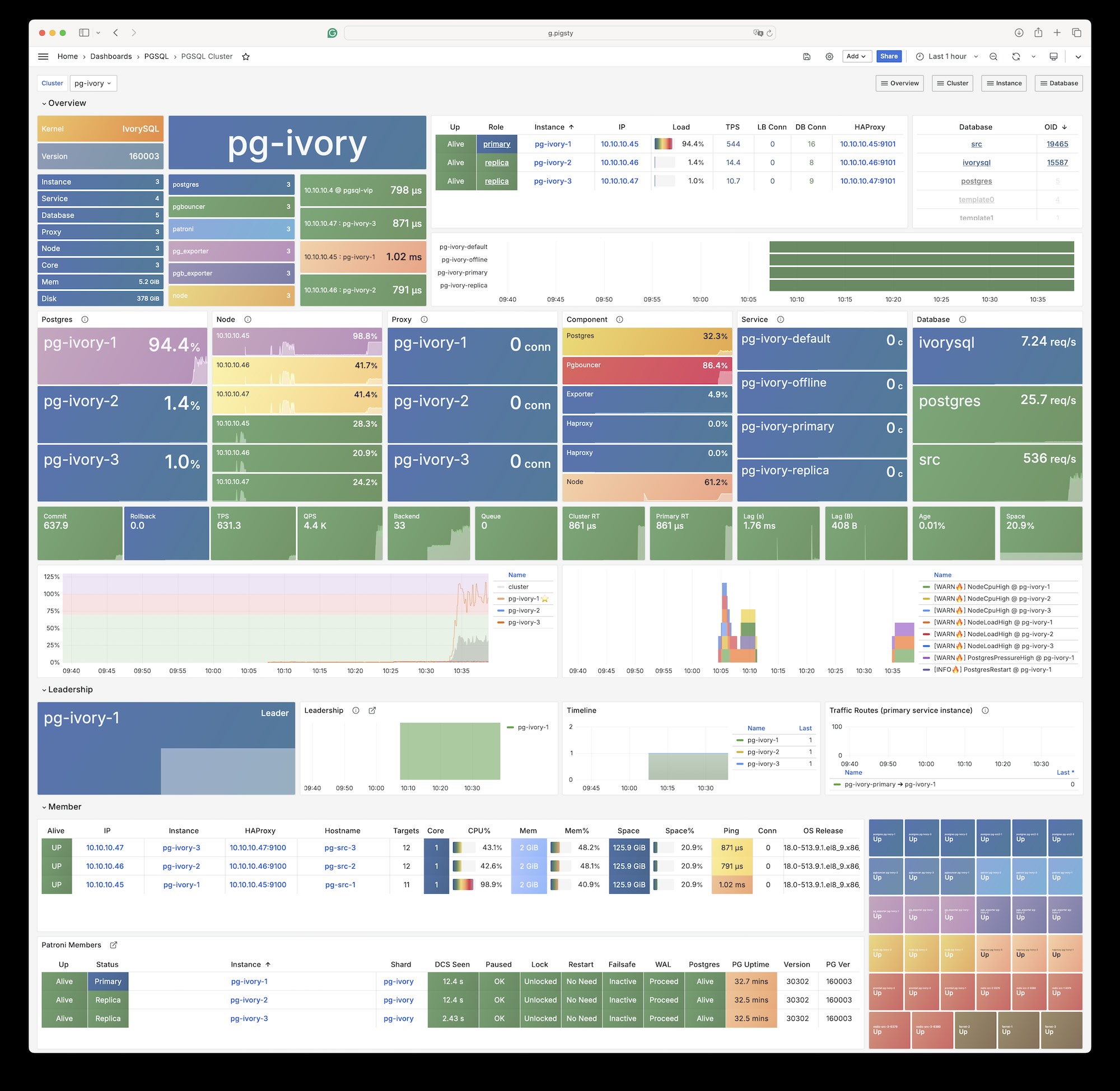

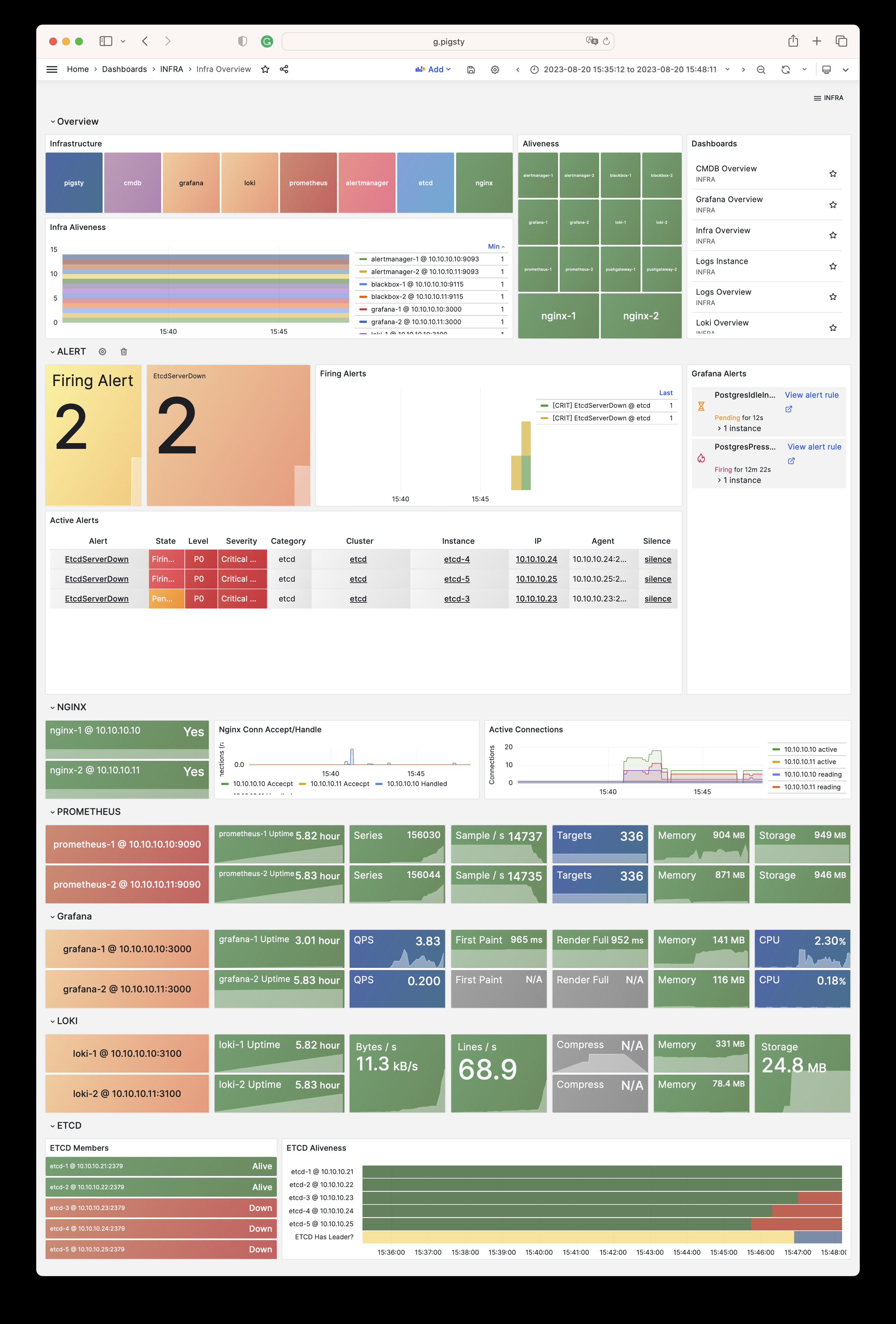

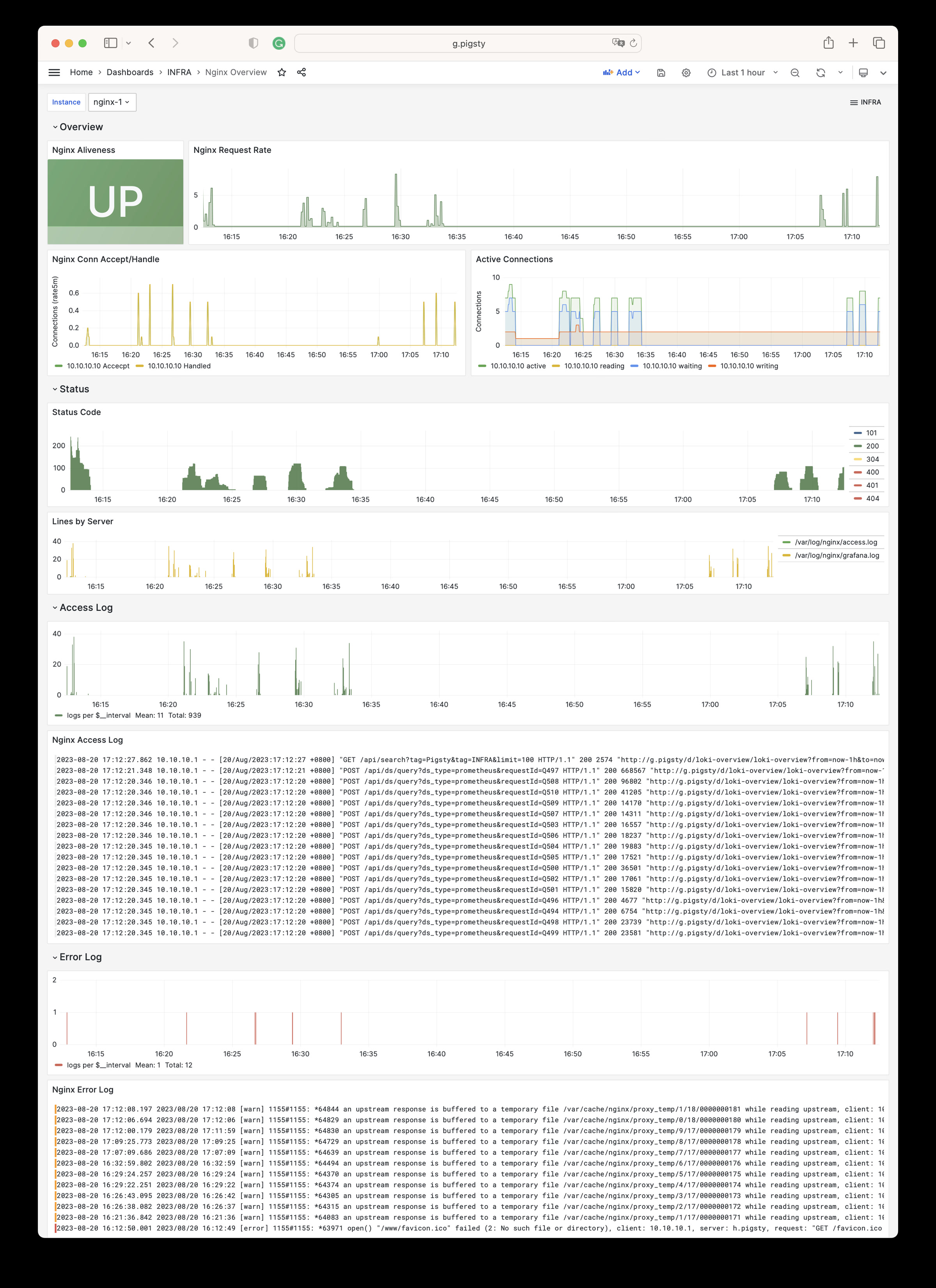

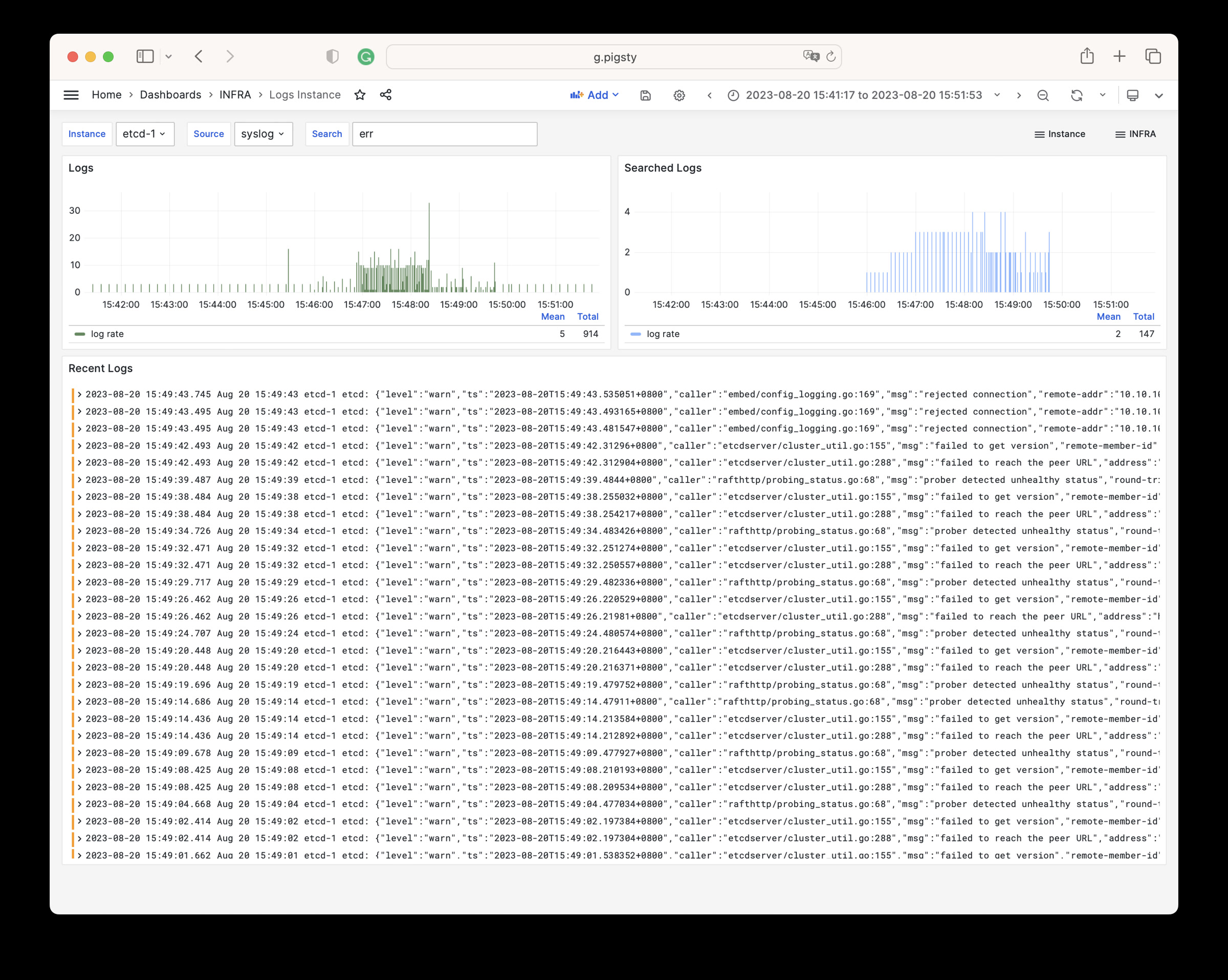

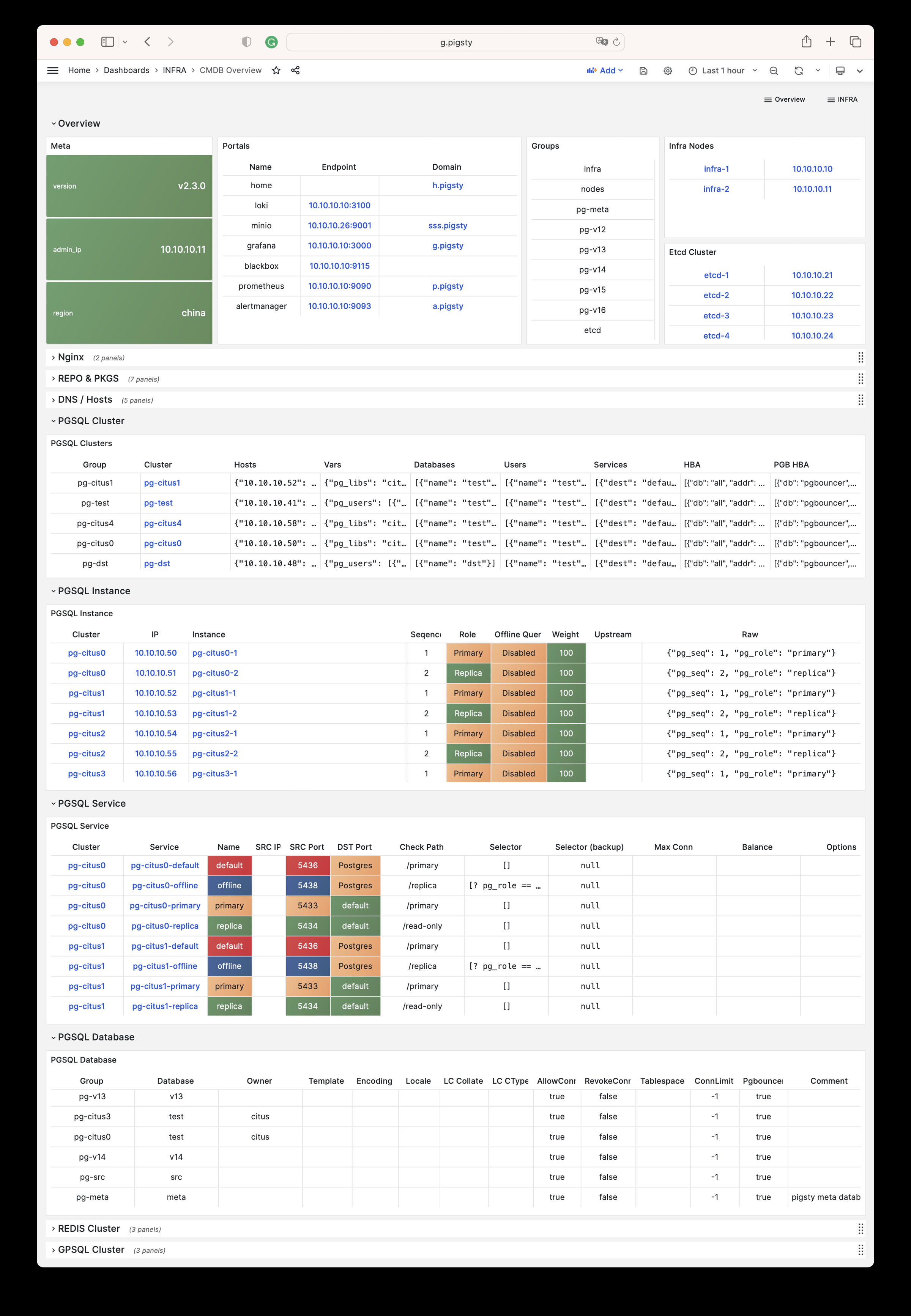

Pigsty 提供了基于开源的 Grafana / Prometheus 现代可观测性技术栈做 监控

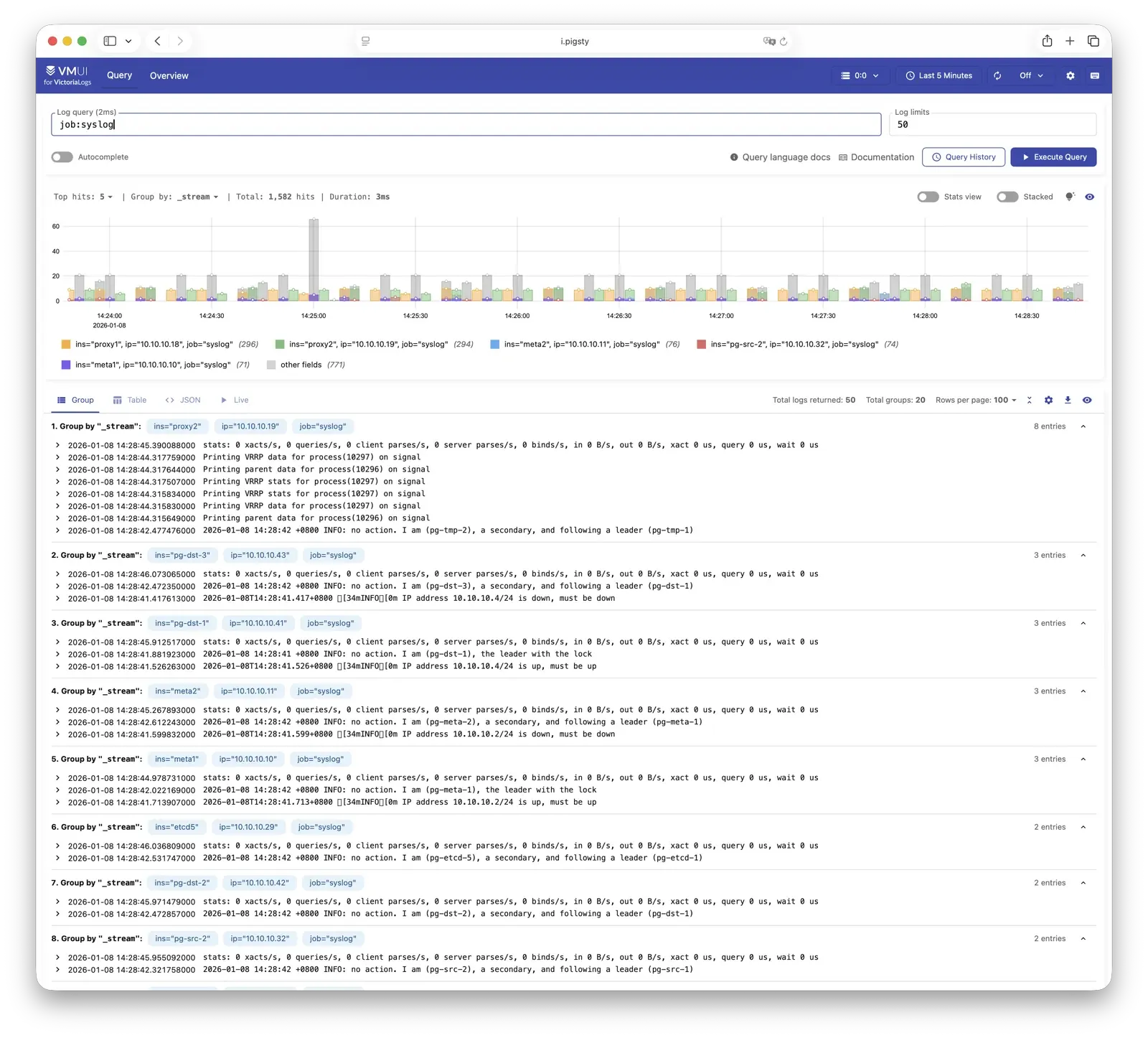

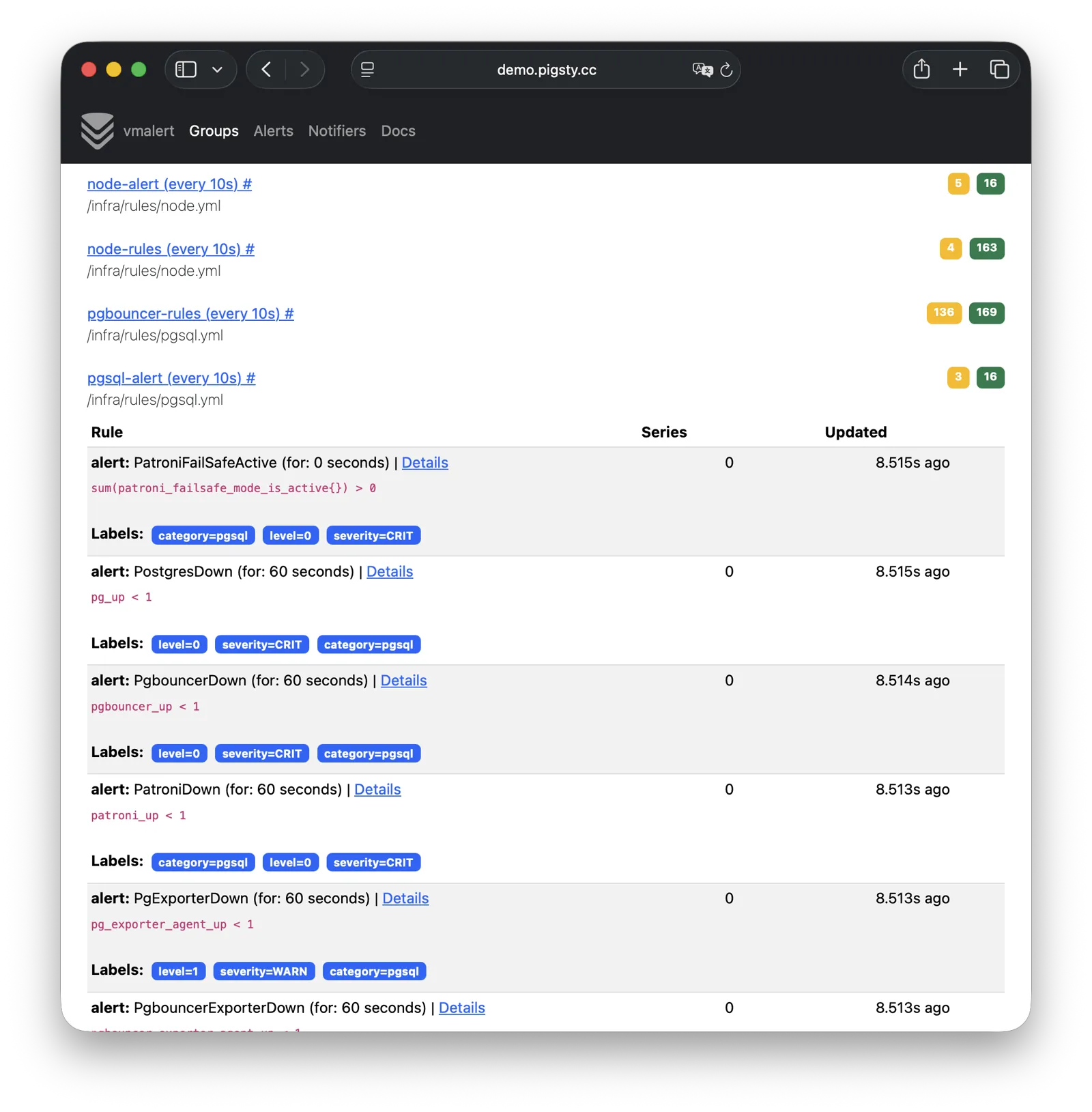

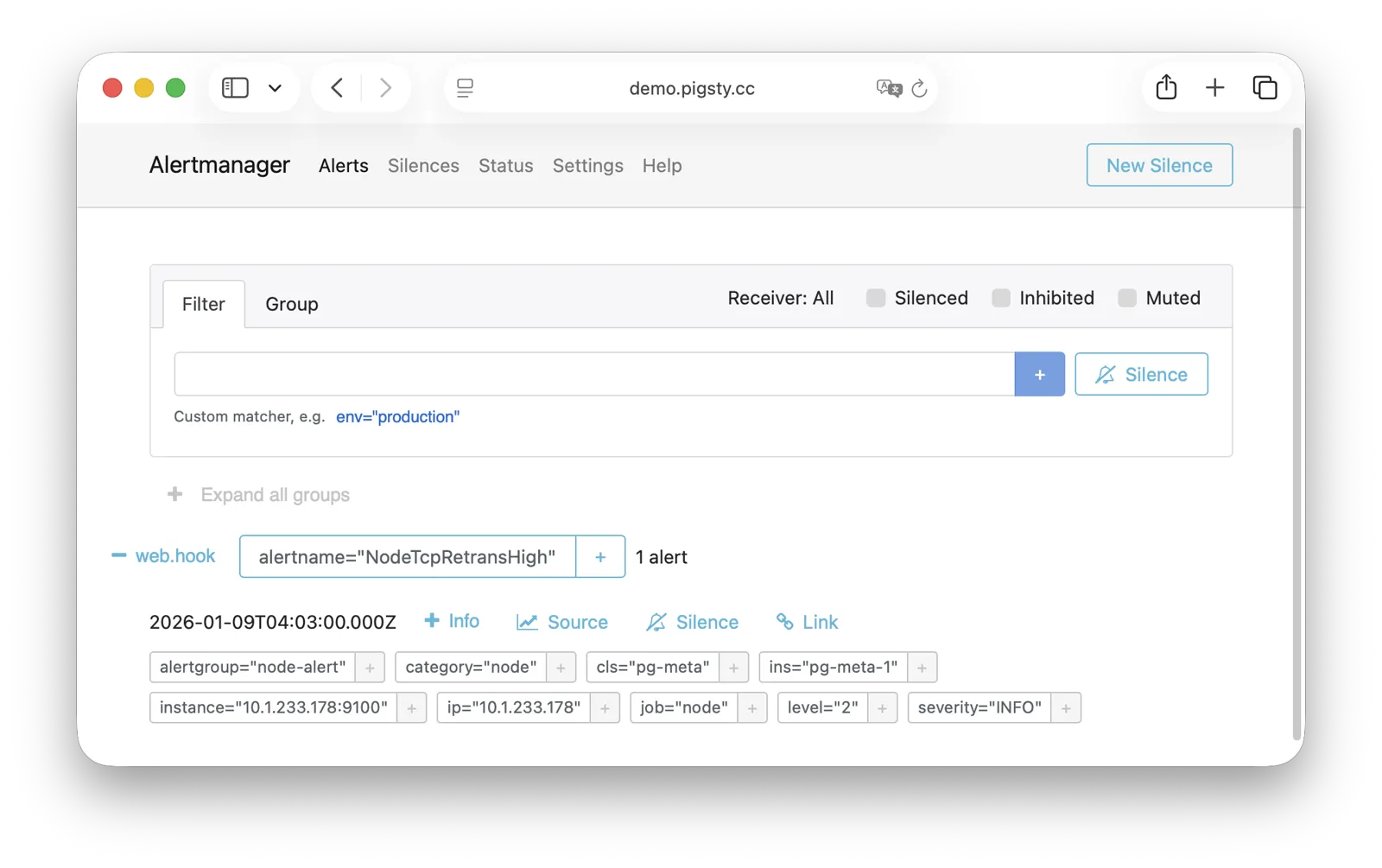

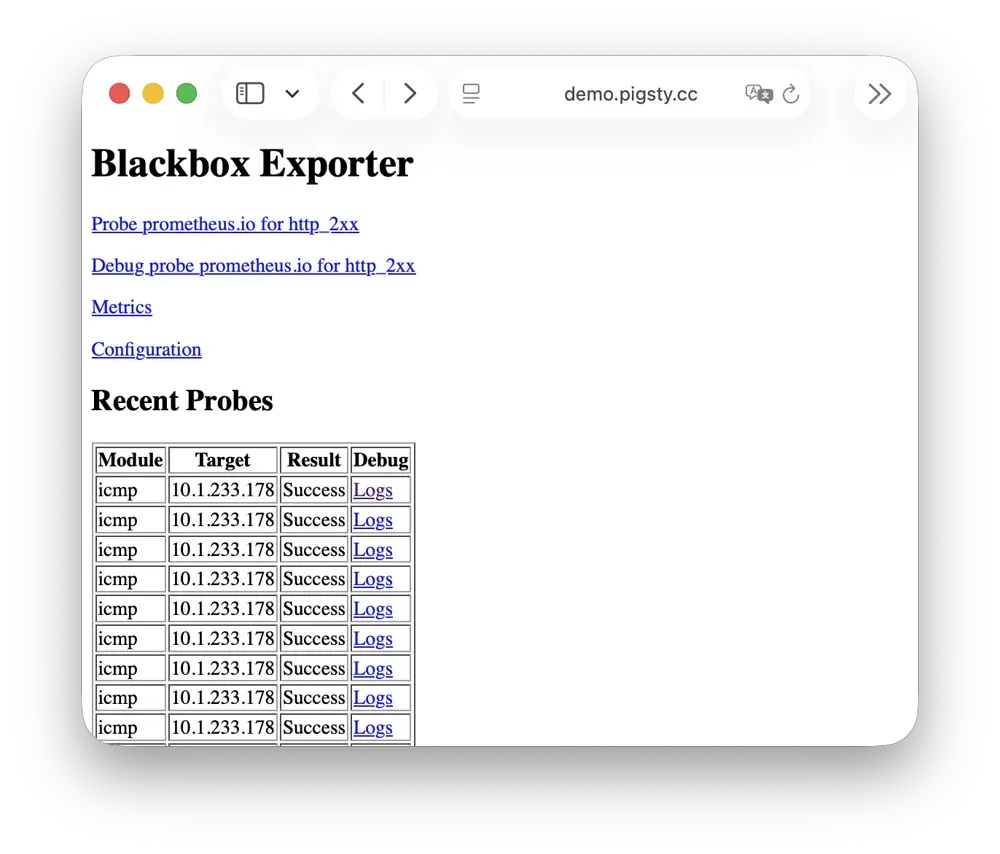

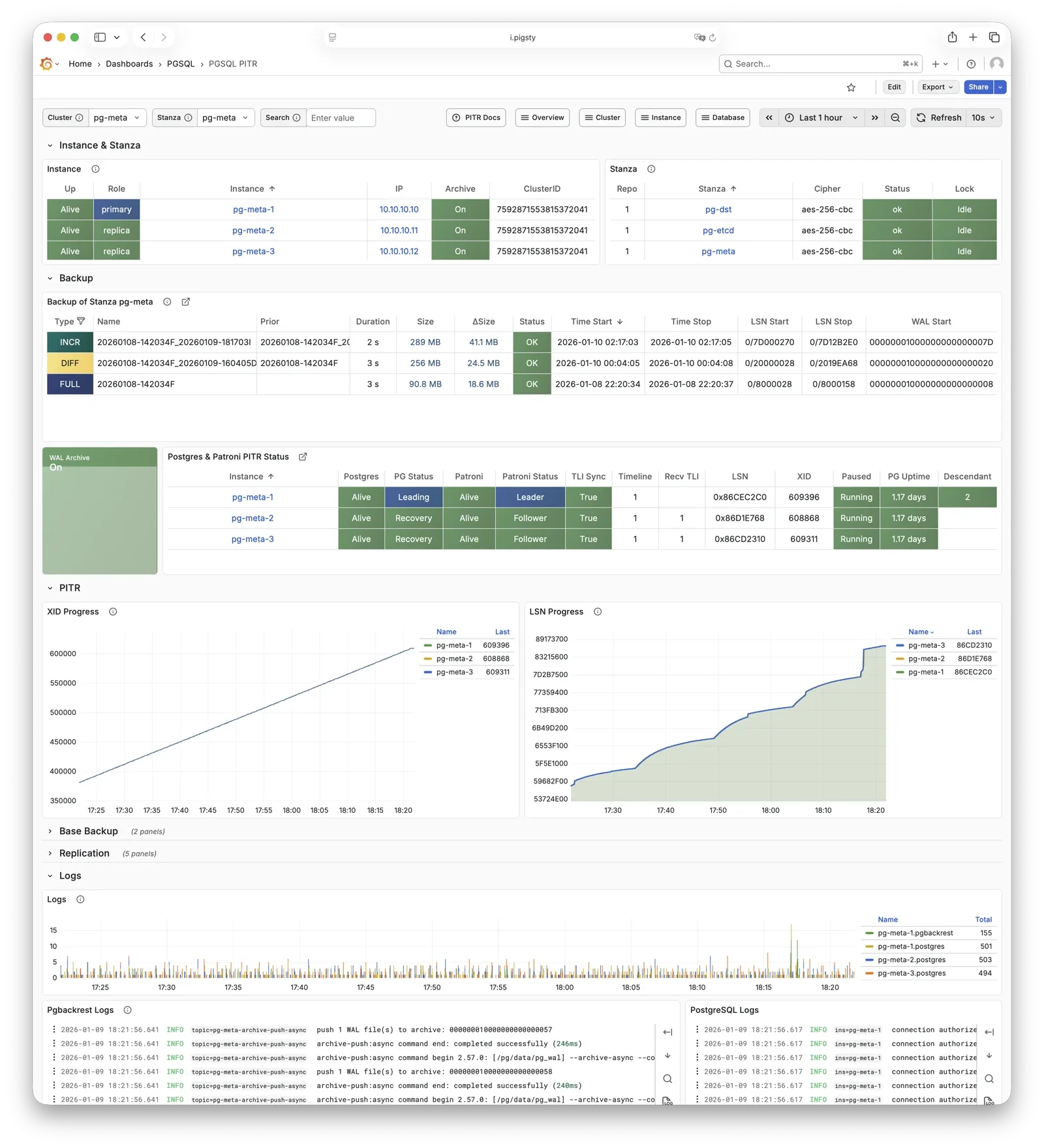

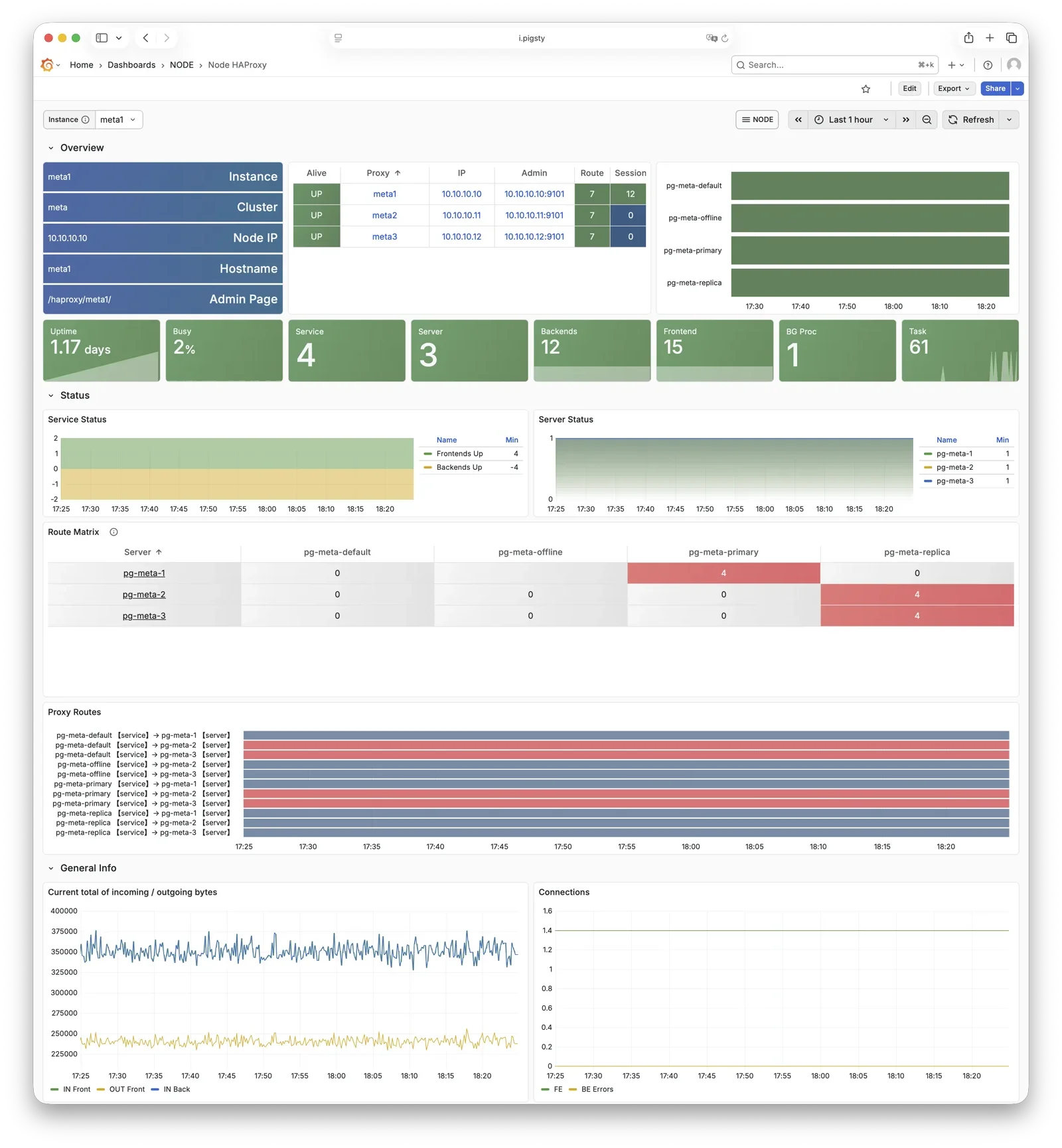

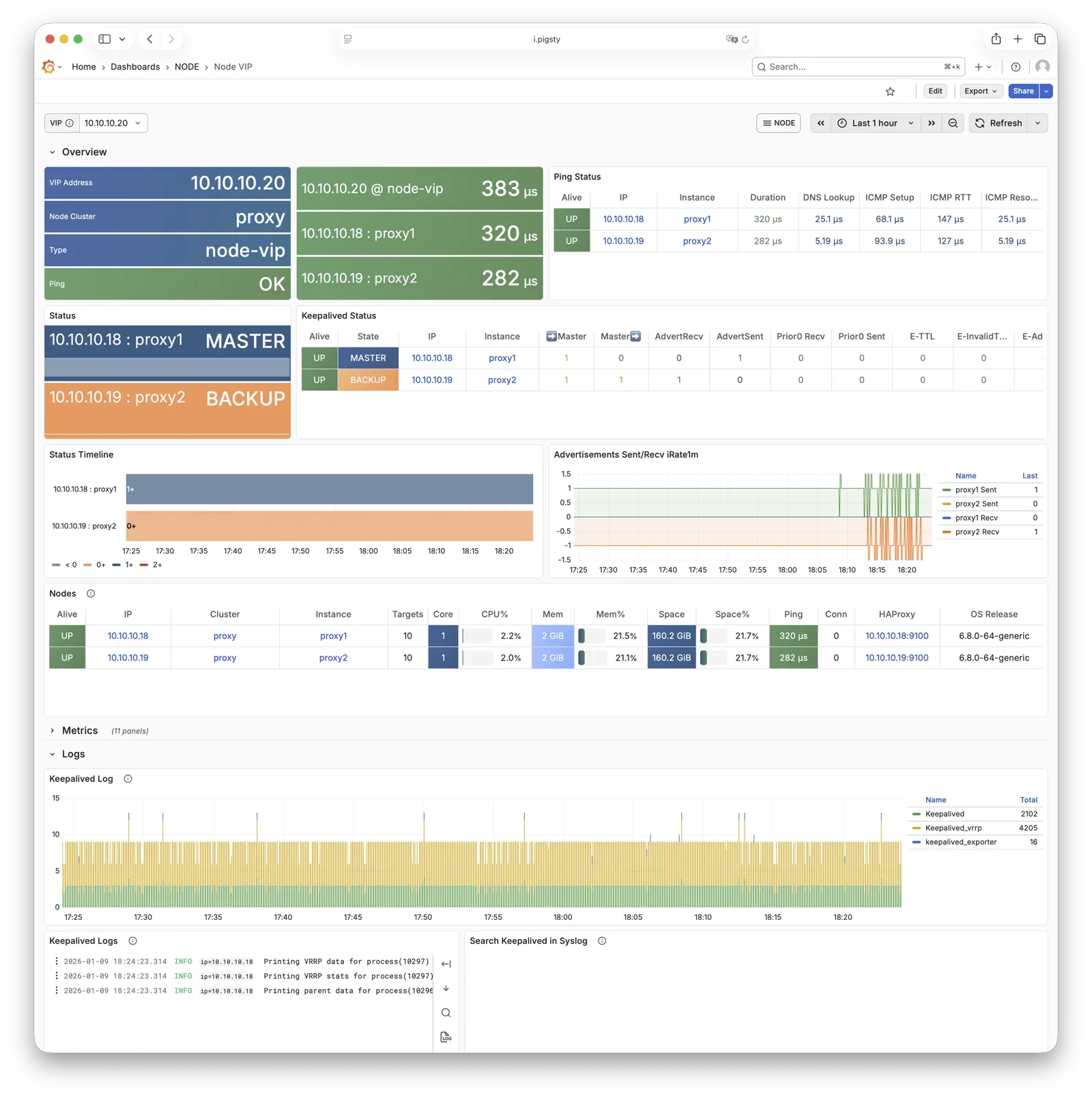

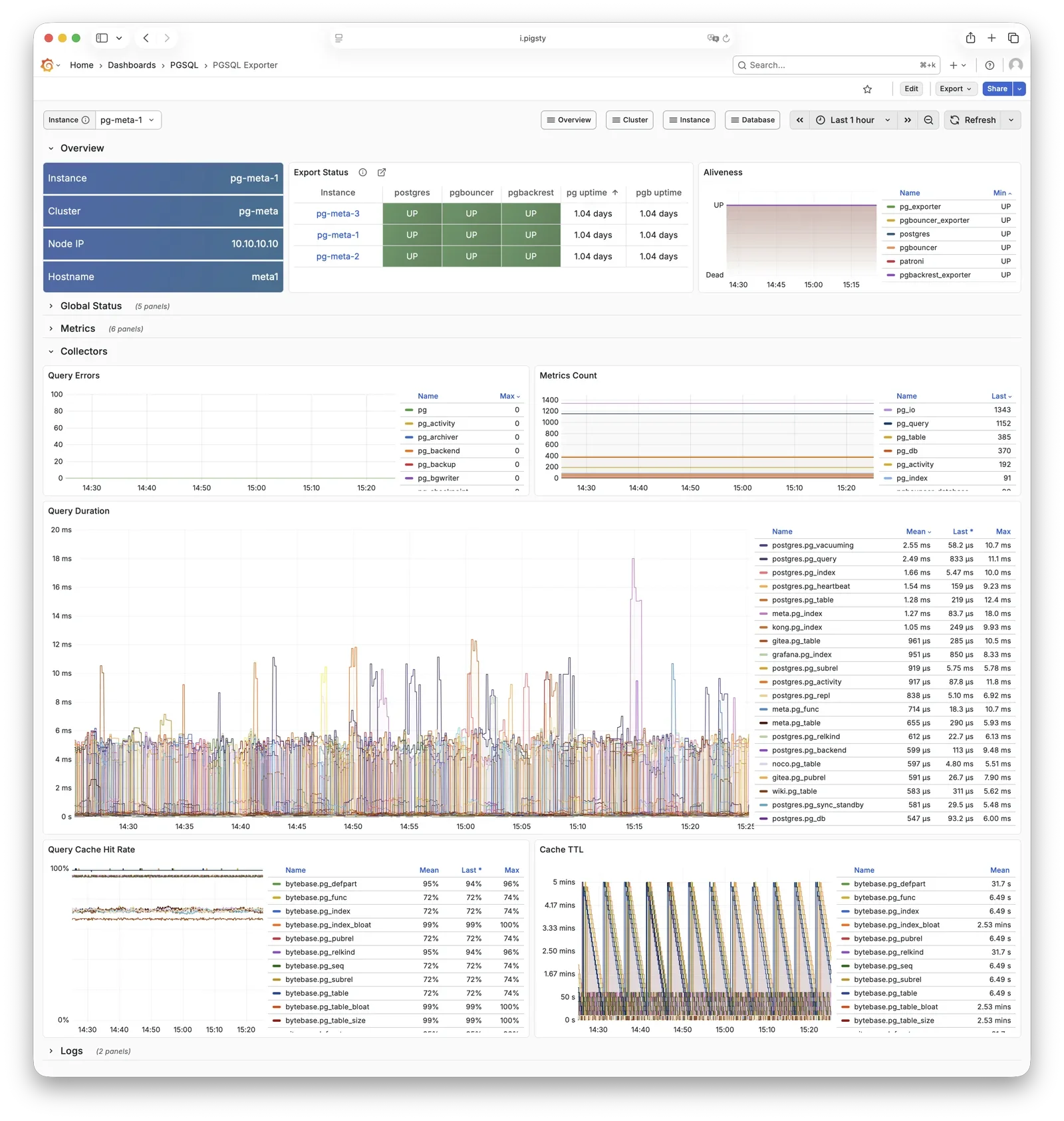

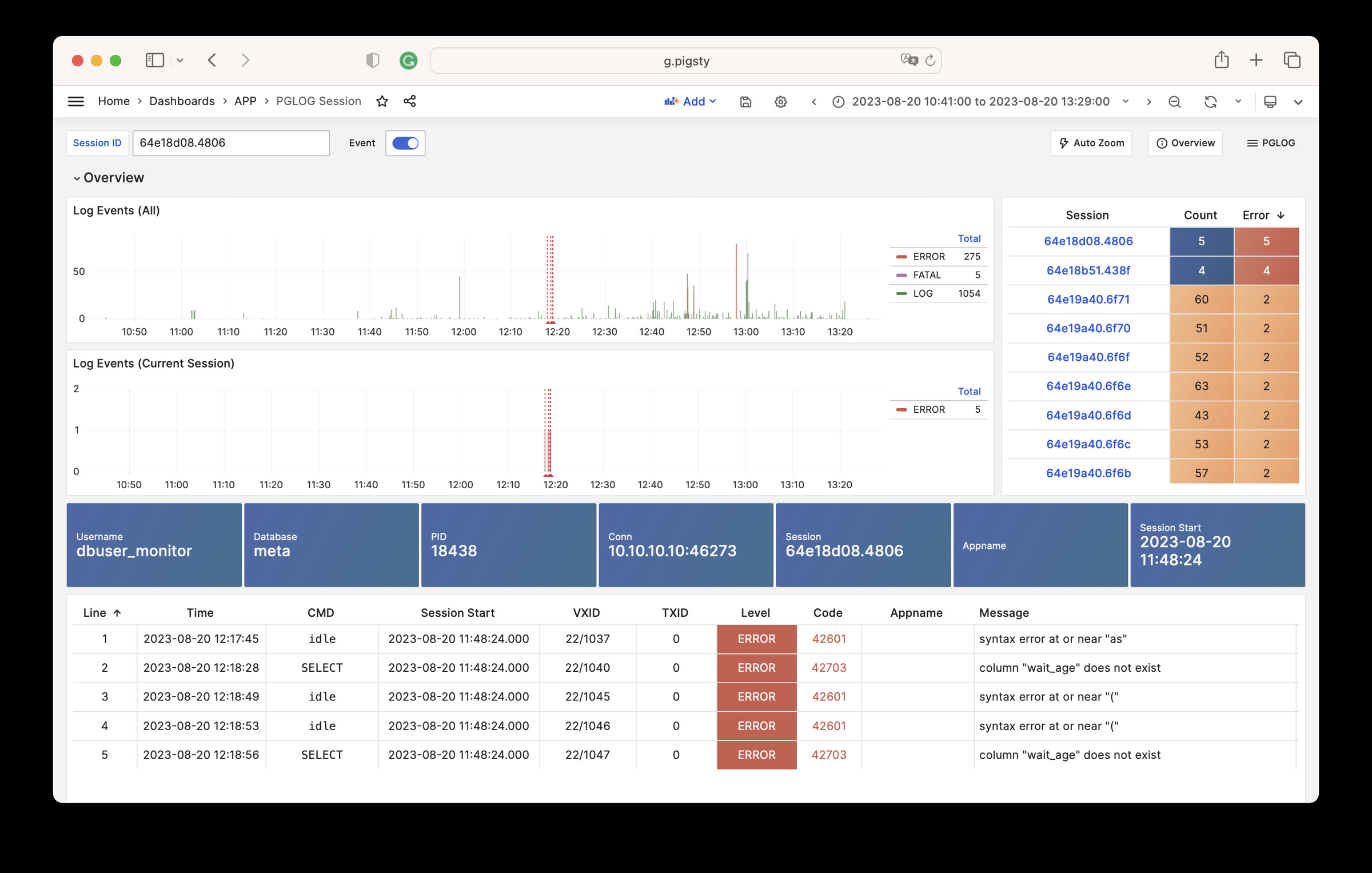

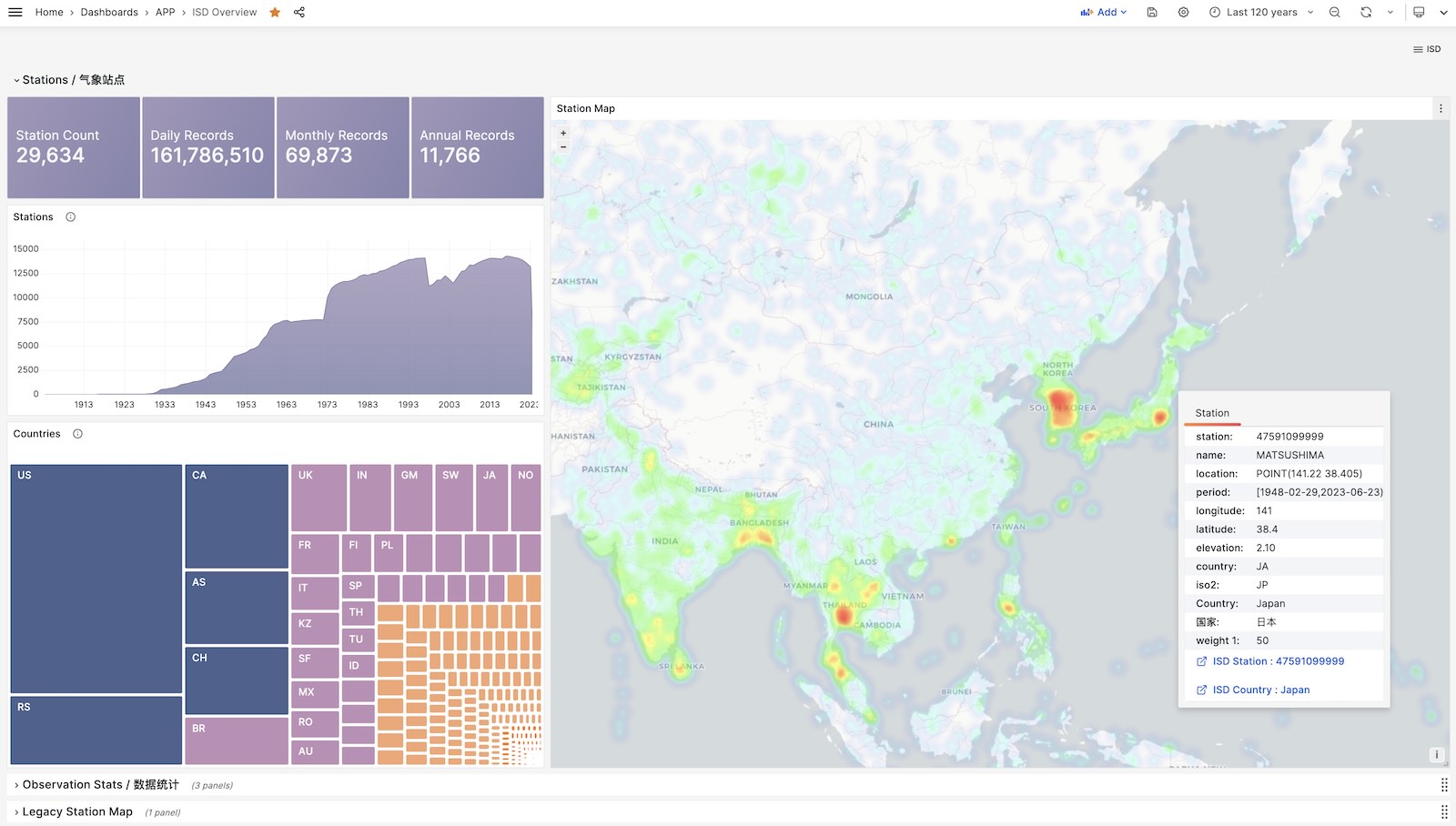

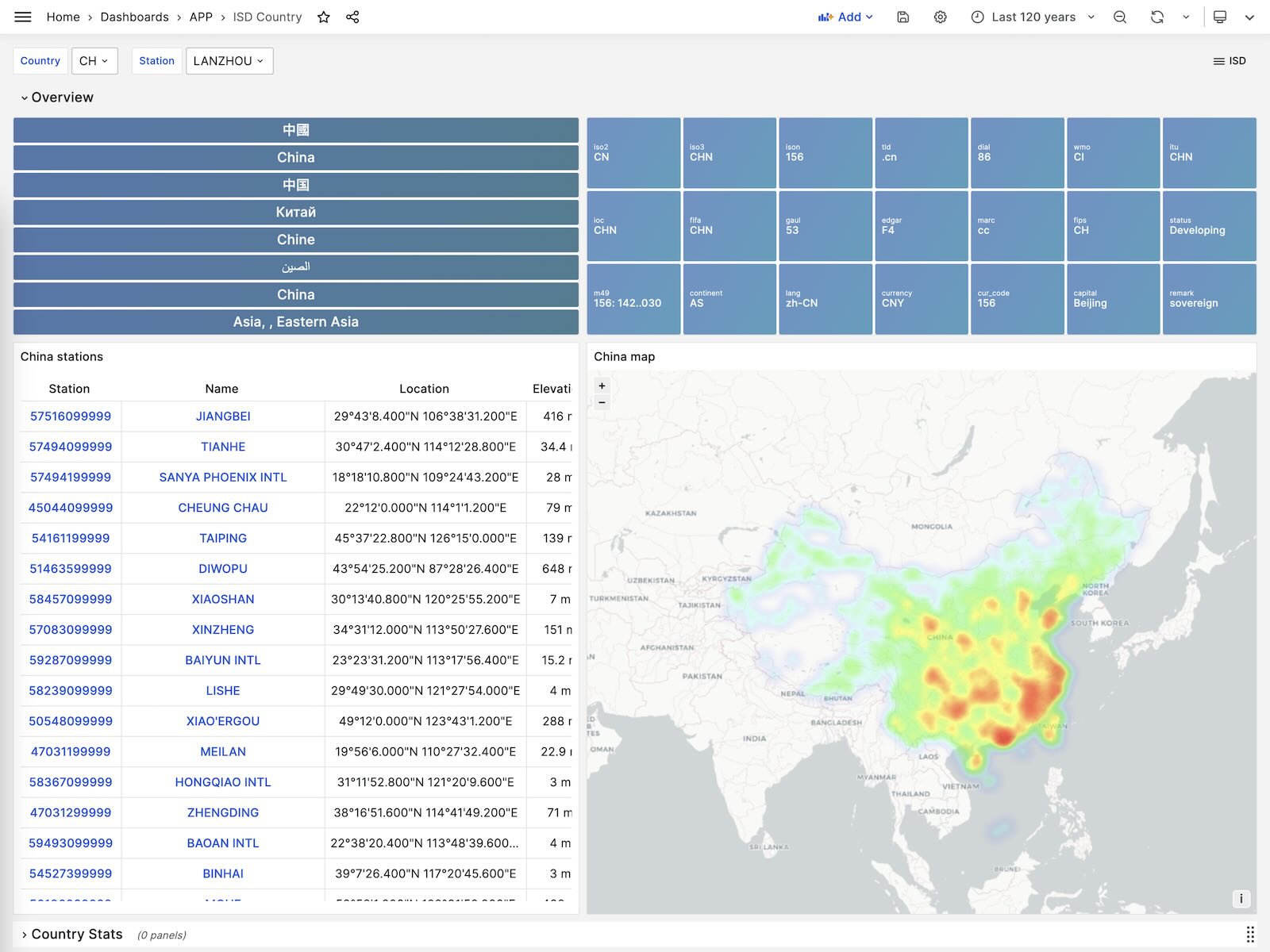

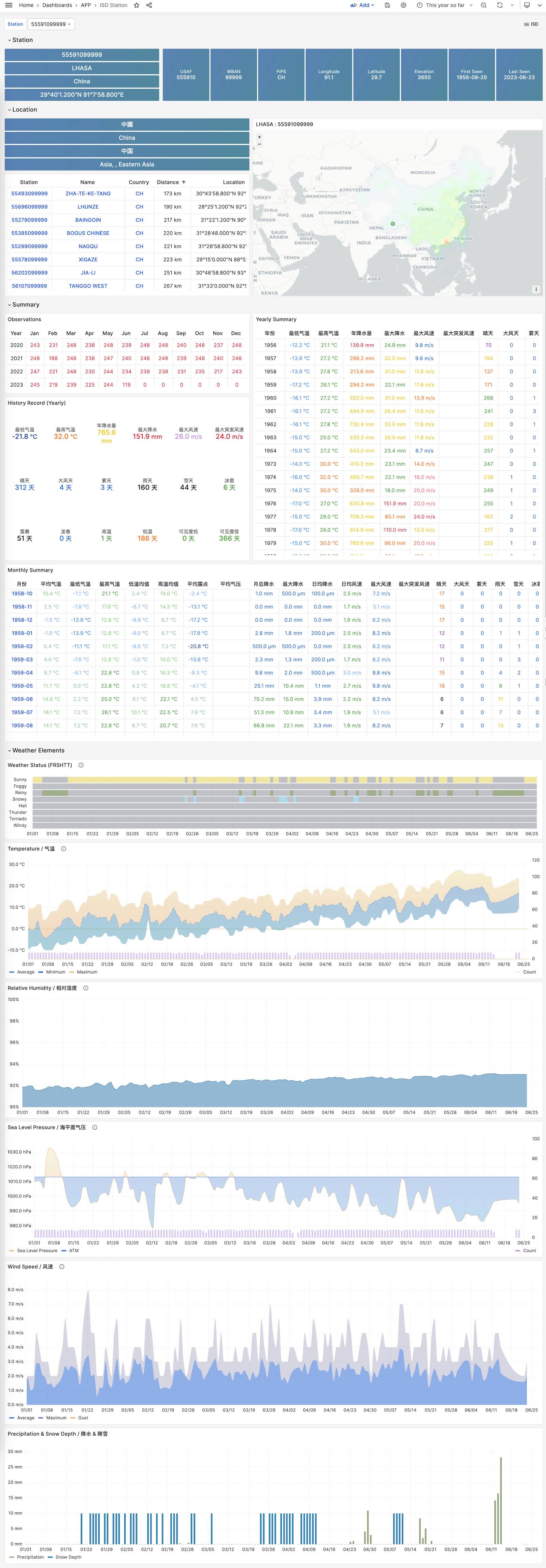

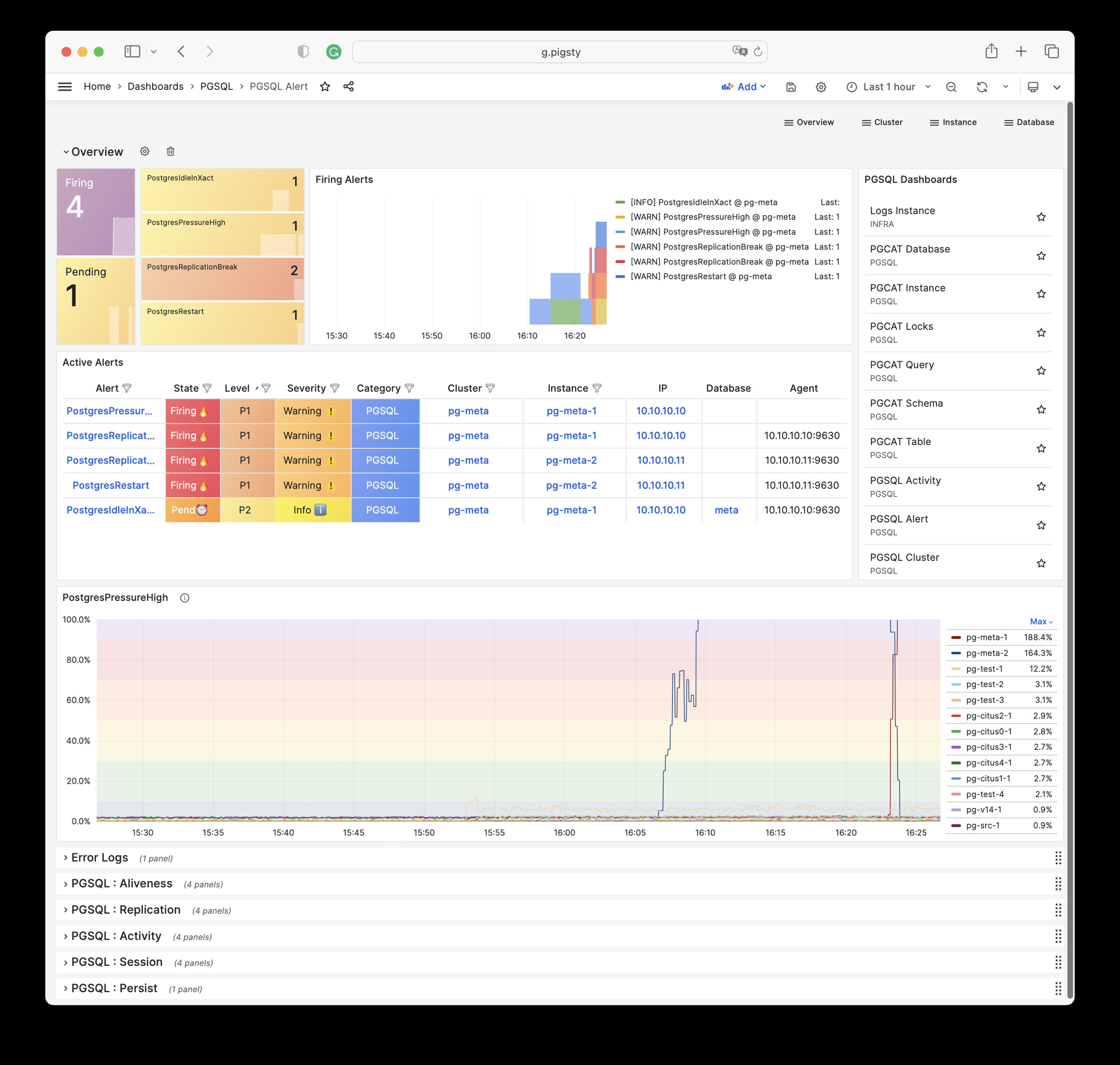

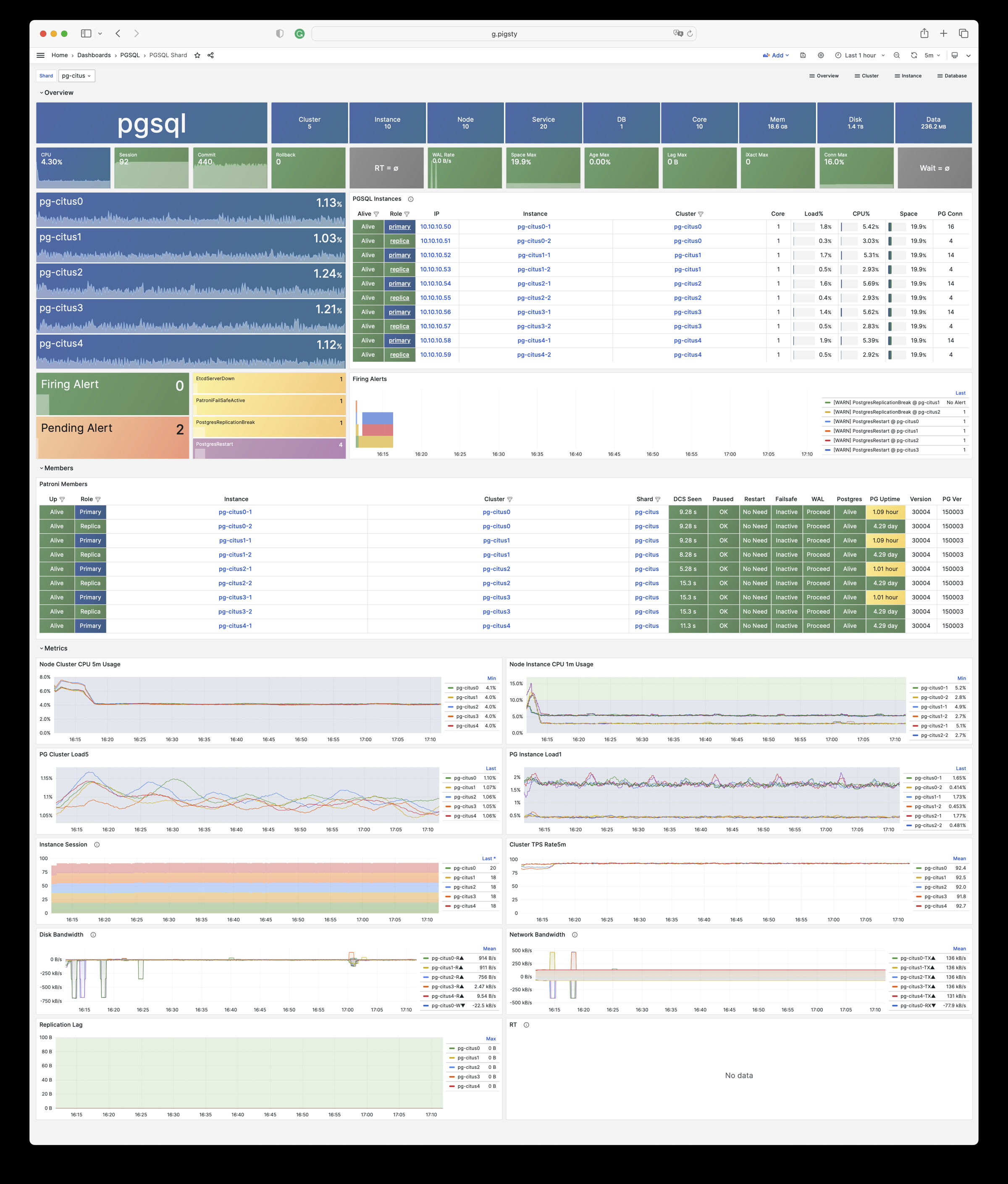

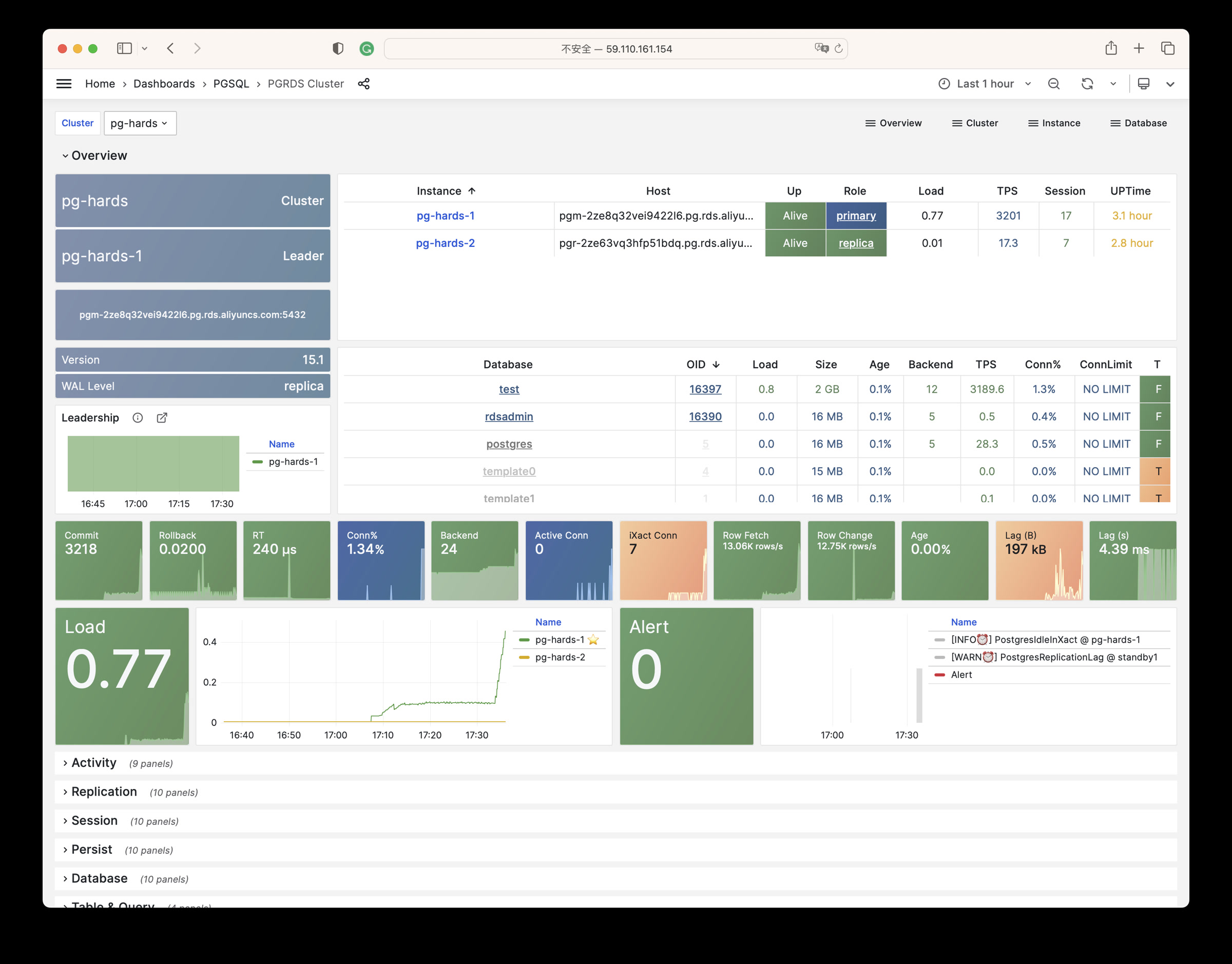

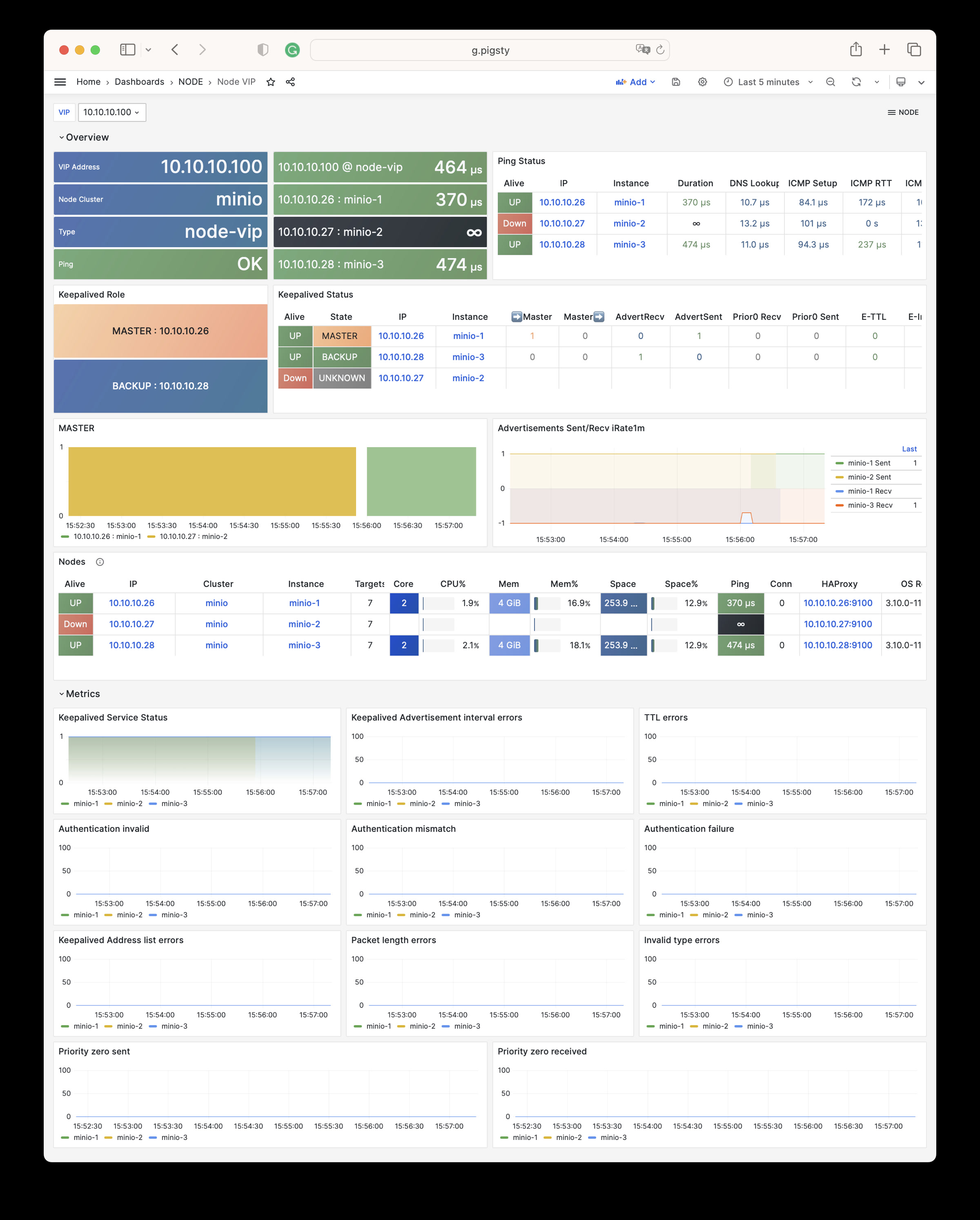

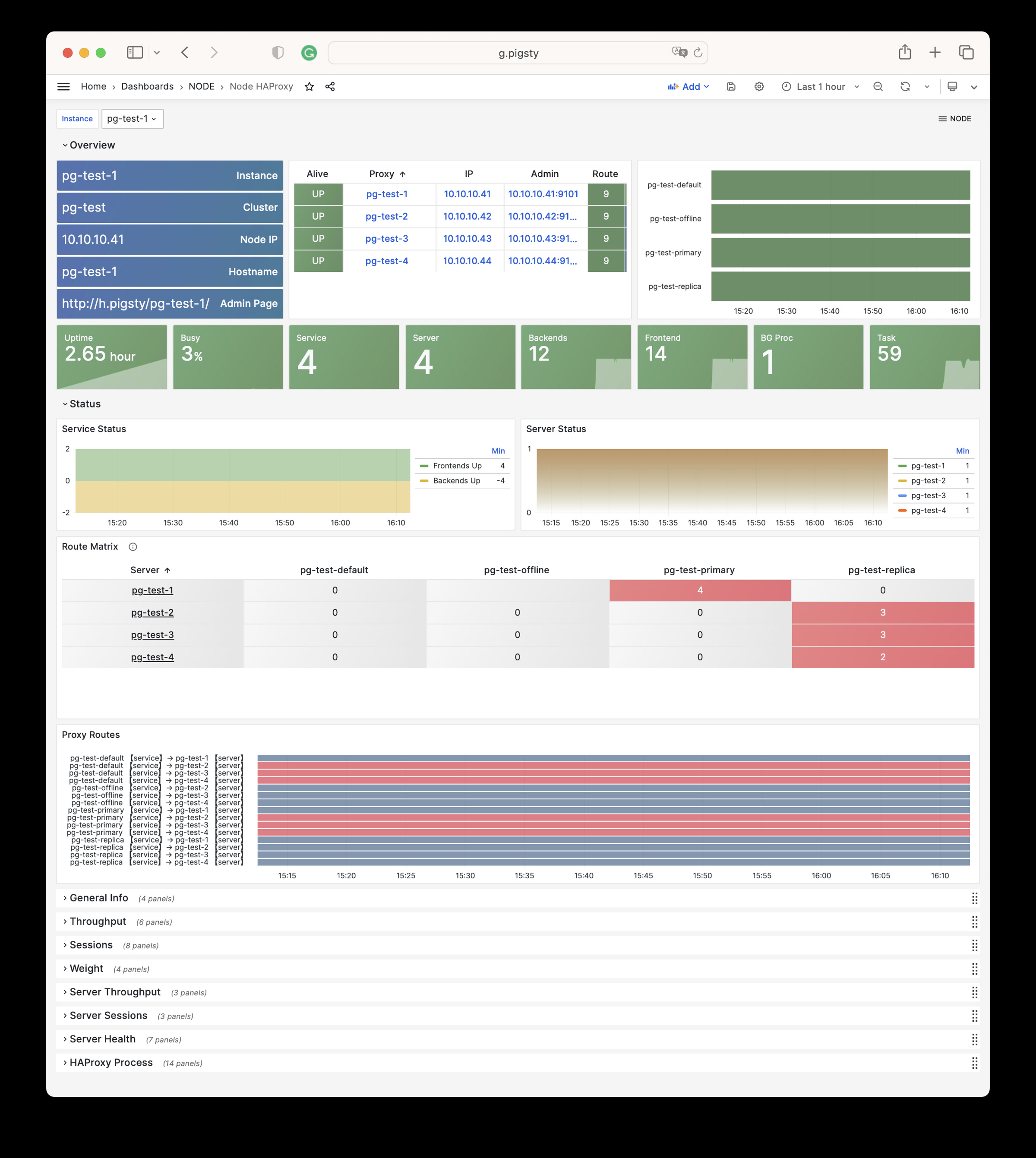

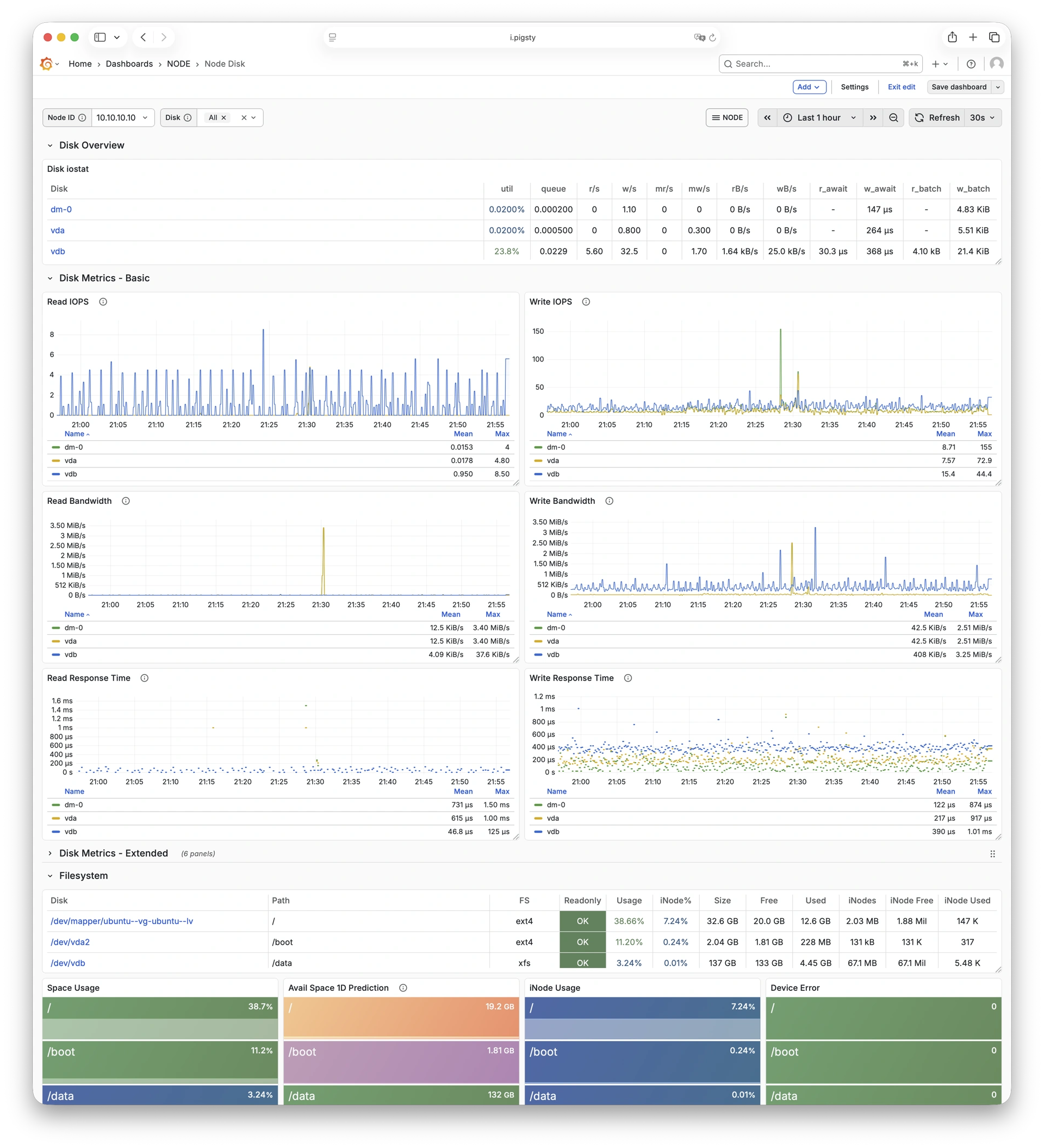

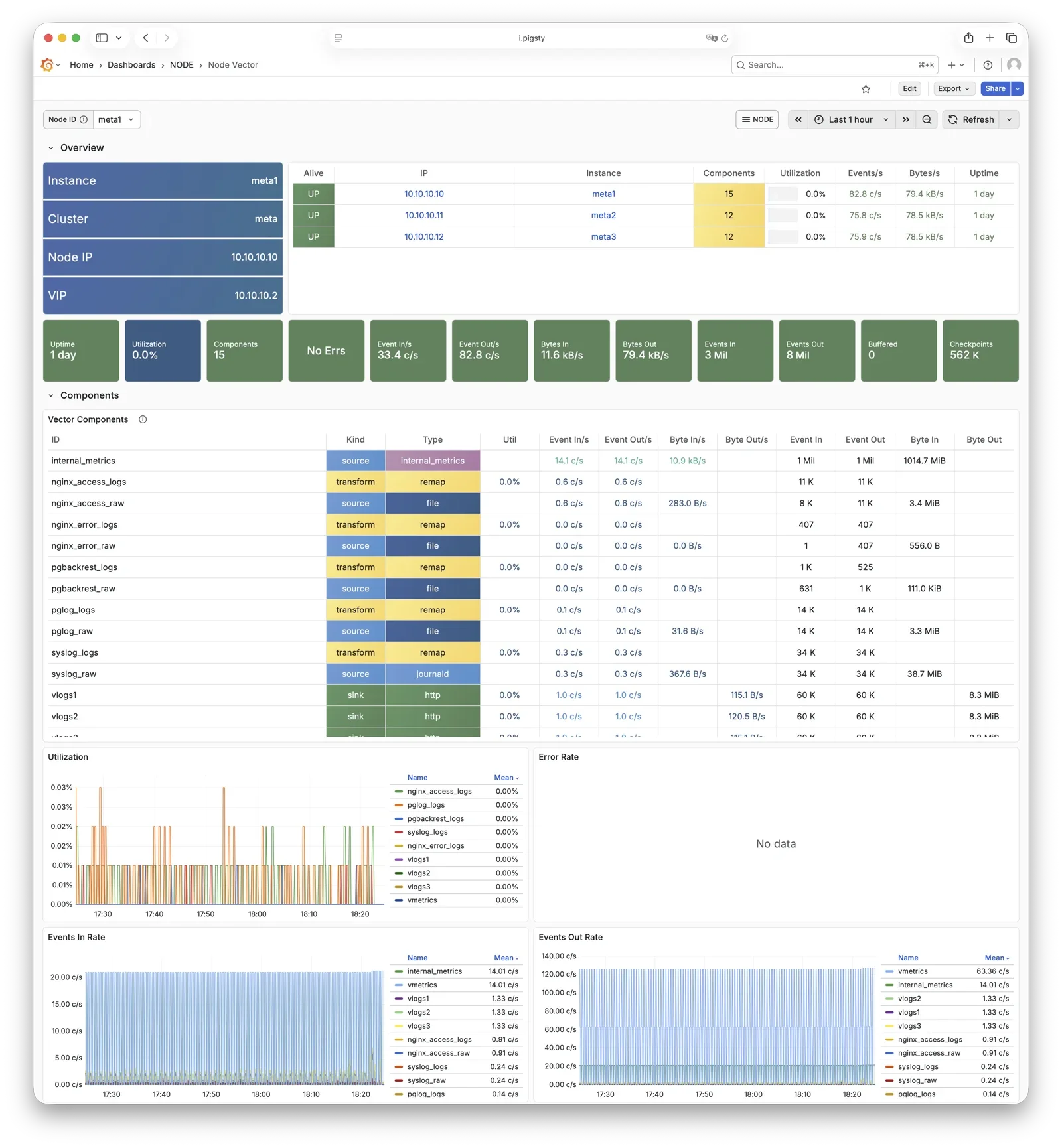

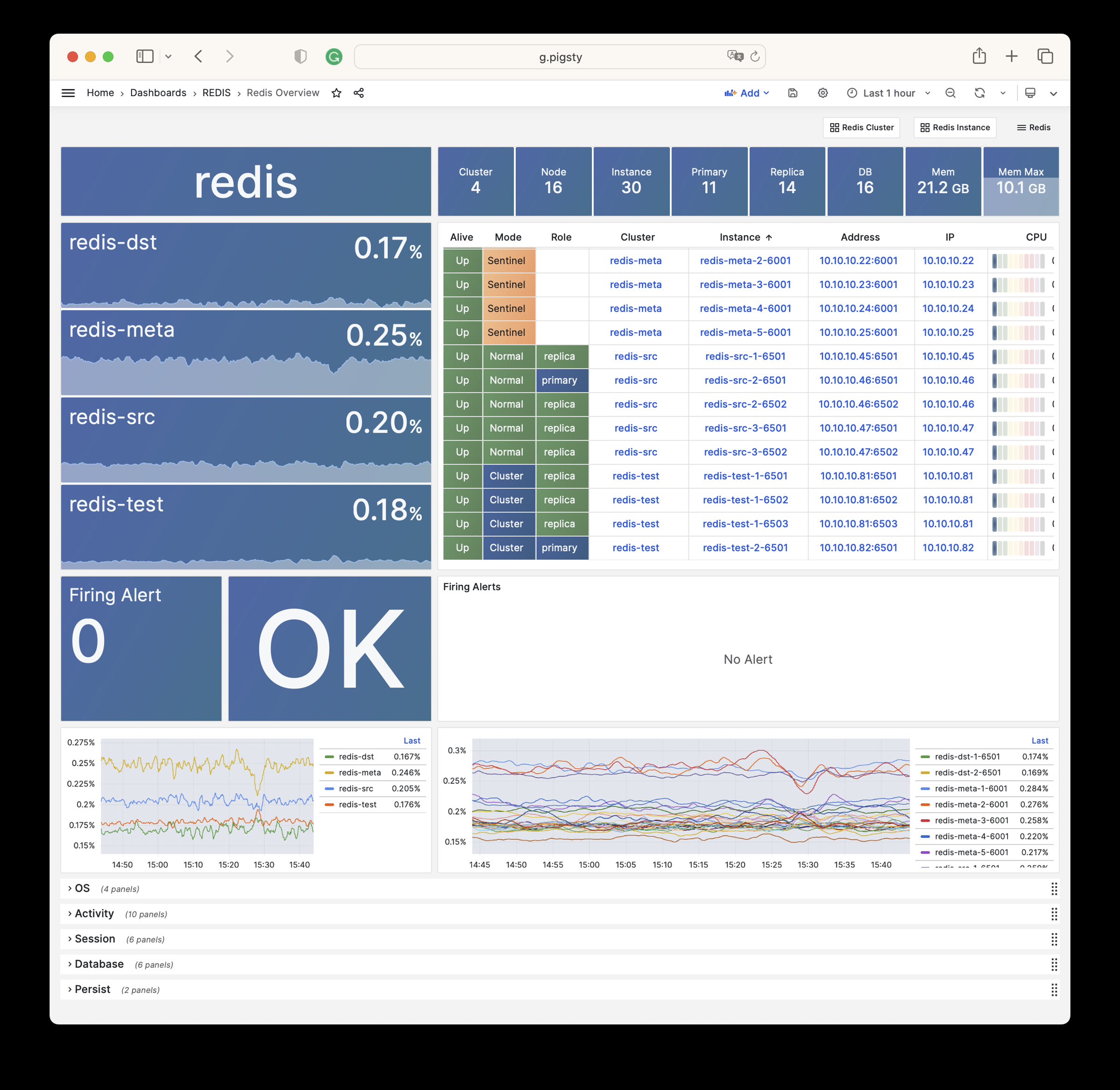

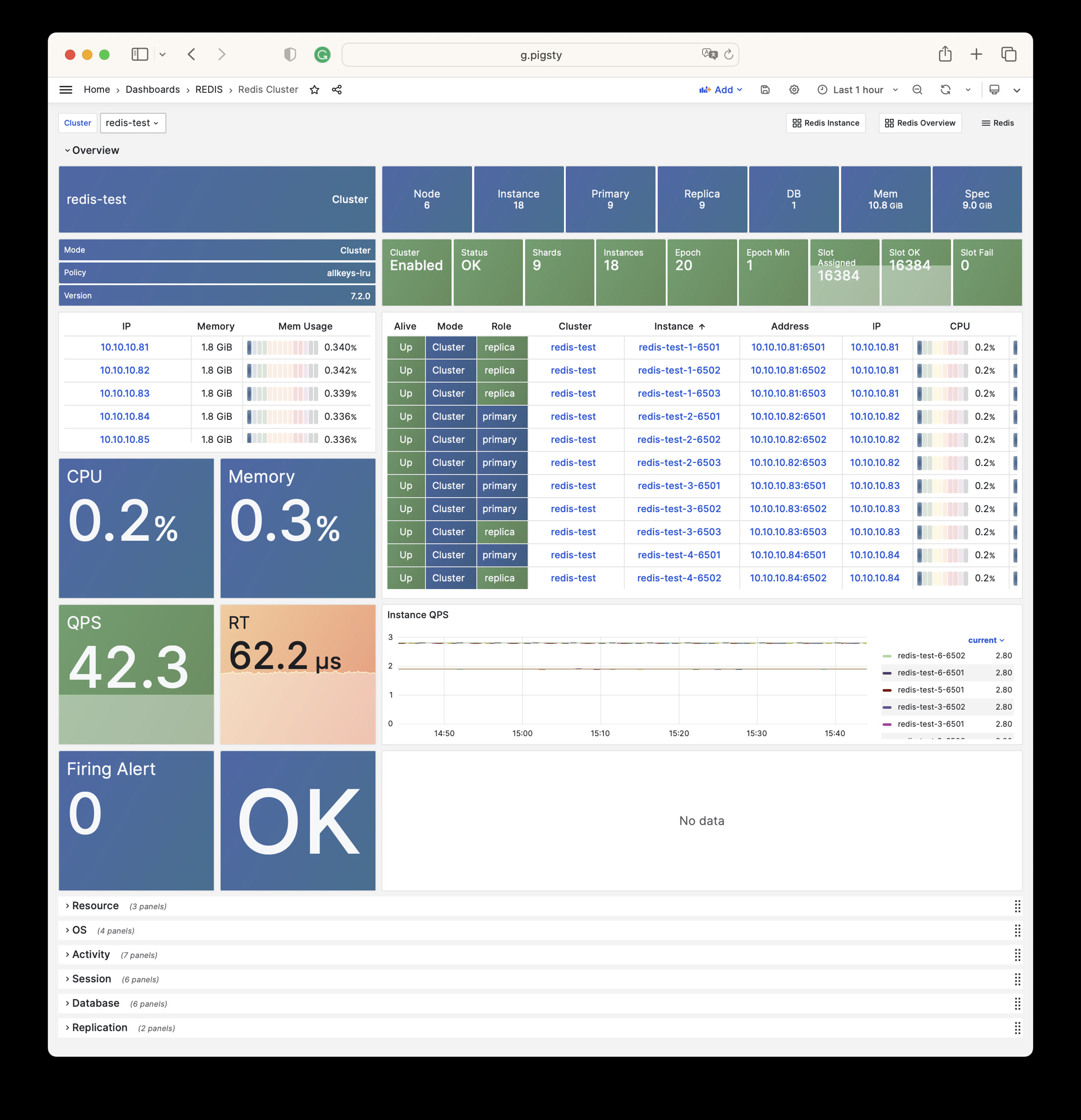

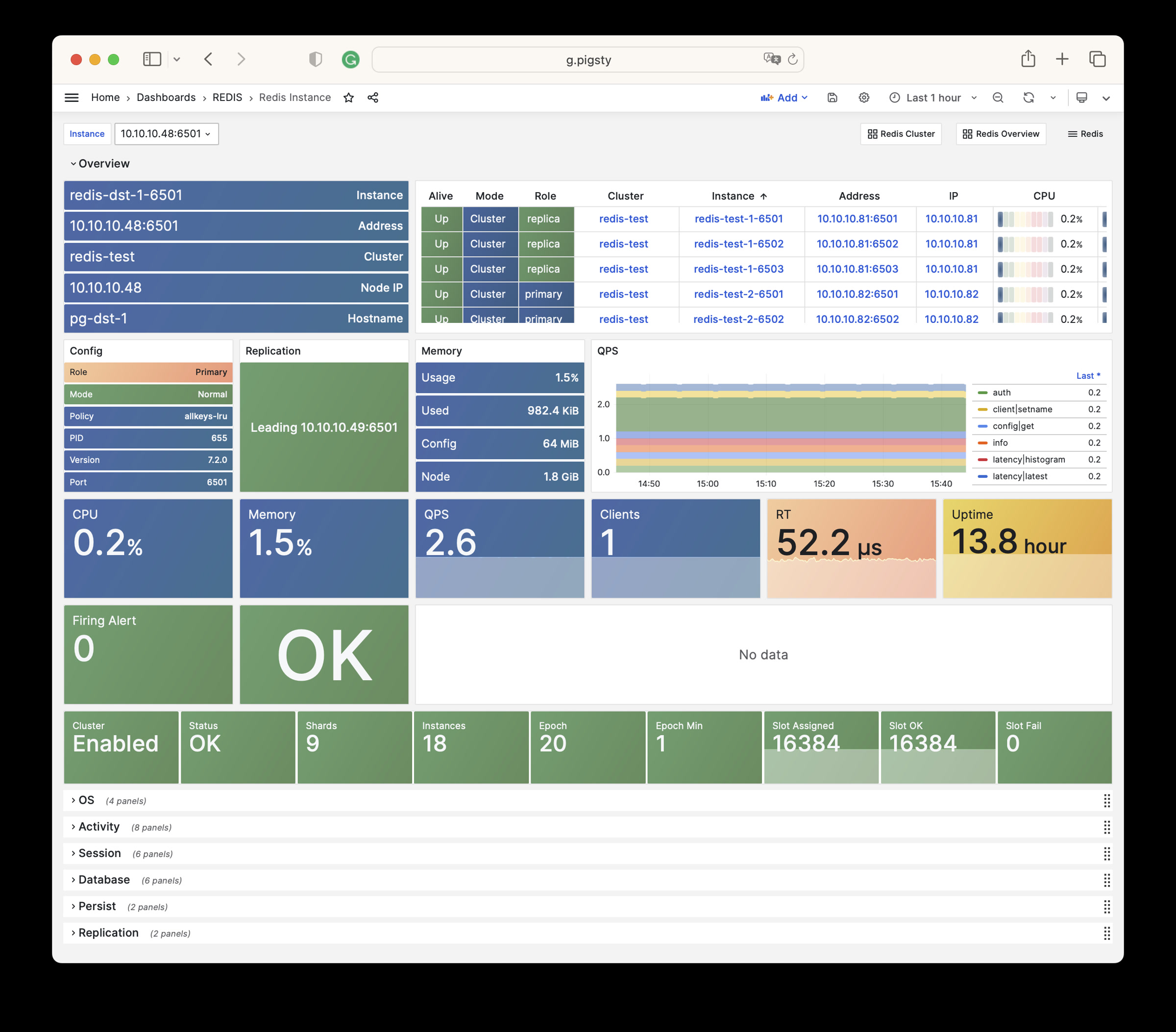

Pigsty 所管理的任何组件都会被自动纳入监控之中,包括主机节点,负载均衡 HAProxy,数据库 Postgres,连接池 Pgbouncer,元数据库 ETCD,KV缓存 Redis,对象存储 MinIO,……,以及整套监控基础设施本身。大量的 Grafana 监控面板与预置告警规则会让你的系统观测能力有质的提升,当然,这套系统也可以被复用于您的应用监控基础设施,或者监控已有的数据库实例或 RDS。

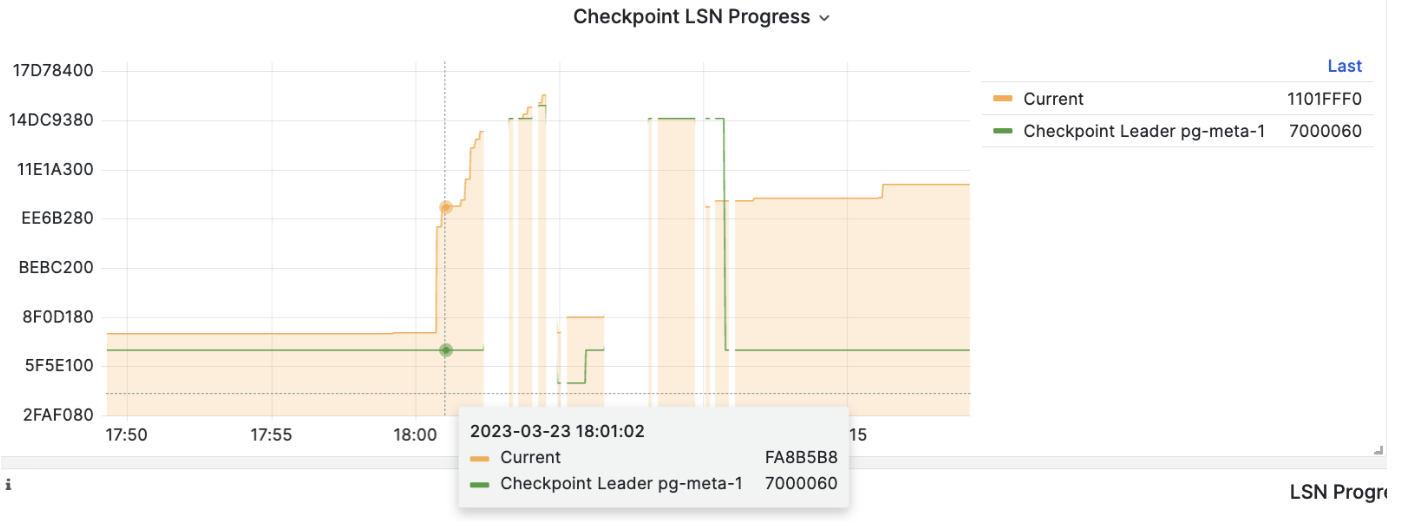

无论是故障分析还是慢查询优化、无论是水位评估还是资源规划,Pigsty 为您提供全面的数据支撑,真正做到数据驱动。在 Pigsty 中,超过三千类监控指标被用于描述整个系统的方方面面,并被进一步加工、聚合、处理、分析、提炼并以符合直觉的可视化模式呈现在您的面前。从全局大盘总览,到某个数据库实例中单个对象(表,索引,函数)的增删改查详情都能一览无余。您可以随意上卷下钻横向跳转,浏览系统现状与历史趋势,并预测未来的演变。

此外,Pigsty的监控系统模块部分还可以 独立使用

访问 截图画廊 在线演示

久经考验的可靠性 开箱即用的高可用与时间点恢复能力,确保你的数据库坚如磐石!

对于软件缺陷或人为误操作造成的删表删库,Pigsty 提供了开箱即用的 PITR 时间点恢复能力,无需额外配置即默认启用。只要存储空间管够,基于 pgBackRest 的基础备份与 WAL 归档让您拥有快速回到过去任意时间点的能力。您可以使用本地目录/磁盘,亦或专用的 MinIO 集群或 S3 对象存储服务保留更长的回溯期限,丰俭由人。

更重要的是,Pigsty 让高可用与故障自愈成为 PostgreSQL 集群的标配,基于 patroni, etcd, 与 haproxy 打造的 高可用故障自愈架构 ,让您在面对硬件故障时游刃有余:主库故障自动切换的 RTO < 45s(可配置),一致性优先模式下确保数据零损失 RPO = 0。只要集群中有任意实例存活,集群就可以对外提供完整的服务,而客户端只要连接至集群中的任意节点,即可获得完整的服务。

Pigsty 内置了 HAProxy 负载均衡器用于自动流量切换,提供 DNS/VIP/LVS 等多种接入方式供客户端选用。故障切换与主动切换对业务侧除零星闪断外几乎无感知,应用不需要修改连接串重启。极小的维护窗口需求带来了极大的灵活便利:您完全可以在无需应用配合的情况下滚动维护升级整个集群。硬件故障可以等到第二天再抽空善后处置的特性,让研发,运维与 DBA 都能安心睡个好觉。

许多大型组织与核心机构已经在生产环境中长时间使用 Pigsty ,最大的部署有 25K CPU 核心与 200+ PostgreSQL 超大规格实例;在这一部署案例中,六七年内经历了数十次硬件故障与各类事故,DBA 换了几茬,但依然可以保持比 99.999% 更高的可用性战绩。

简单易用可维护 Infra as Code, 数据库即代码,声明式的API将数据库管理的复杂度来封装。

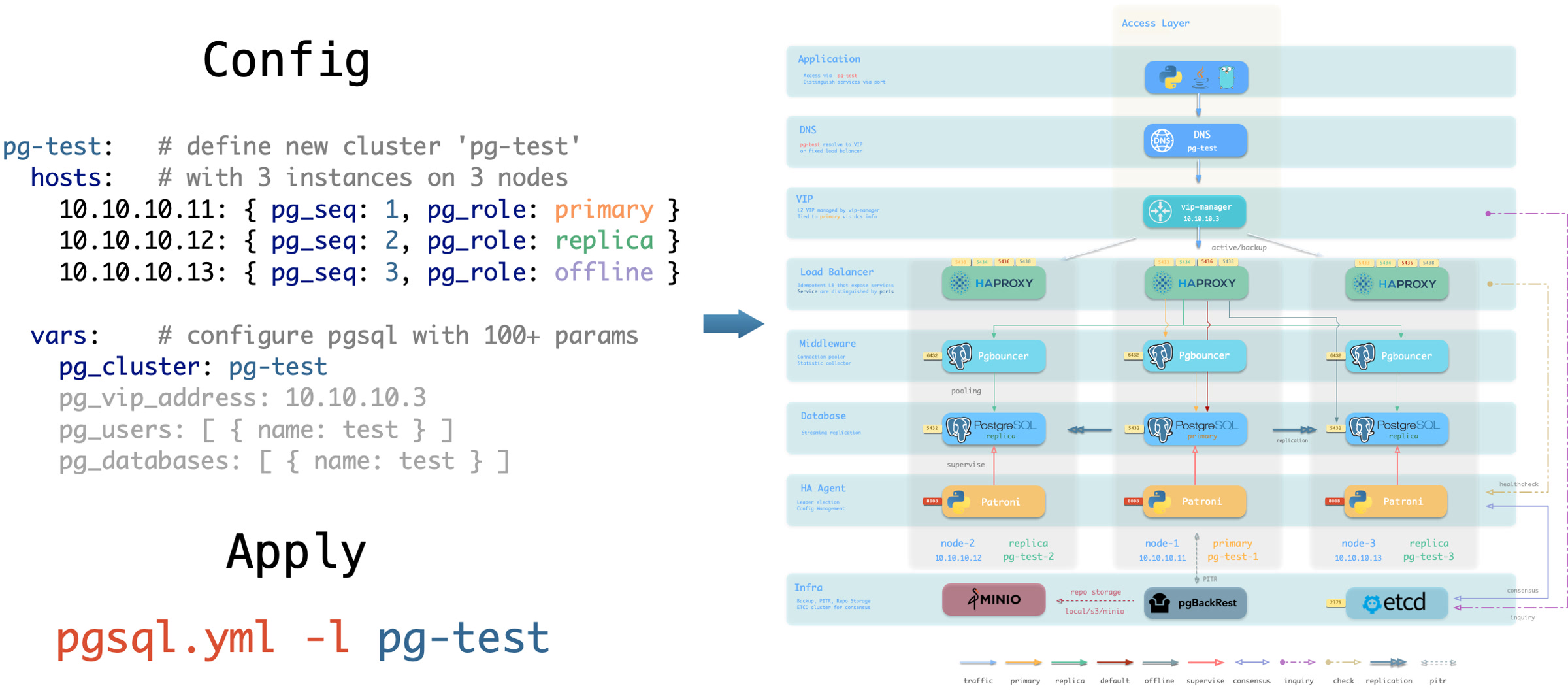

Pigsty 使用声明式的接口对外提供服务,将系统的可控制性拔高到一个全新水平:用户通过配置清单告诉 Pigsty “我想要什么样的数据库集群”,而不用去操心到底需要怎样去做。从效果上讲,这类似于 K8S 中的 CRD 与 Operator,但 Pigsty 可用于任何节点上的数据库与基础设施:不论是容器,虚拟机,还是物理机。

无论是创建/销毁集群,添加/移除从库,还是新增数据库/用户/服务/扩展/黑白名单规则,您只需要修改配置清单并运行 Pigsty 提供的幂等剧本,而 Pigsty 负责将系统调整到您期望的状态。

用户无需操心配置的细节,Pigsty将自动根据机器的硬件配置进行调优,您只需要关心诸如集群叫什么名字,有几个实例放在哪几台机器上,使用什么配置模版:事务/分析/核心/微型,这些基础信息,研发也可以自助服务。但如果您愿意跳入兔子洞中,Pigsty 也提供了丰富且精细的控制参数,满足最龟毛 DBA 的苛刻定制需求。

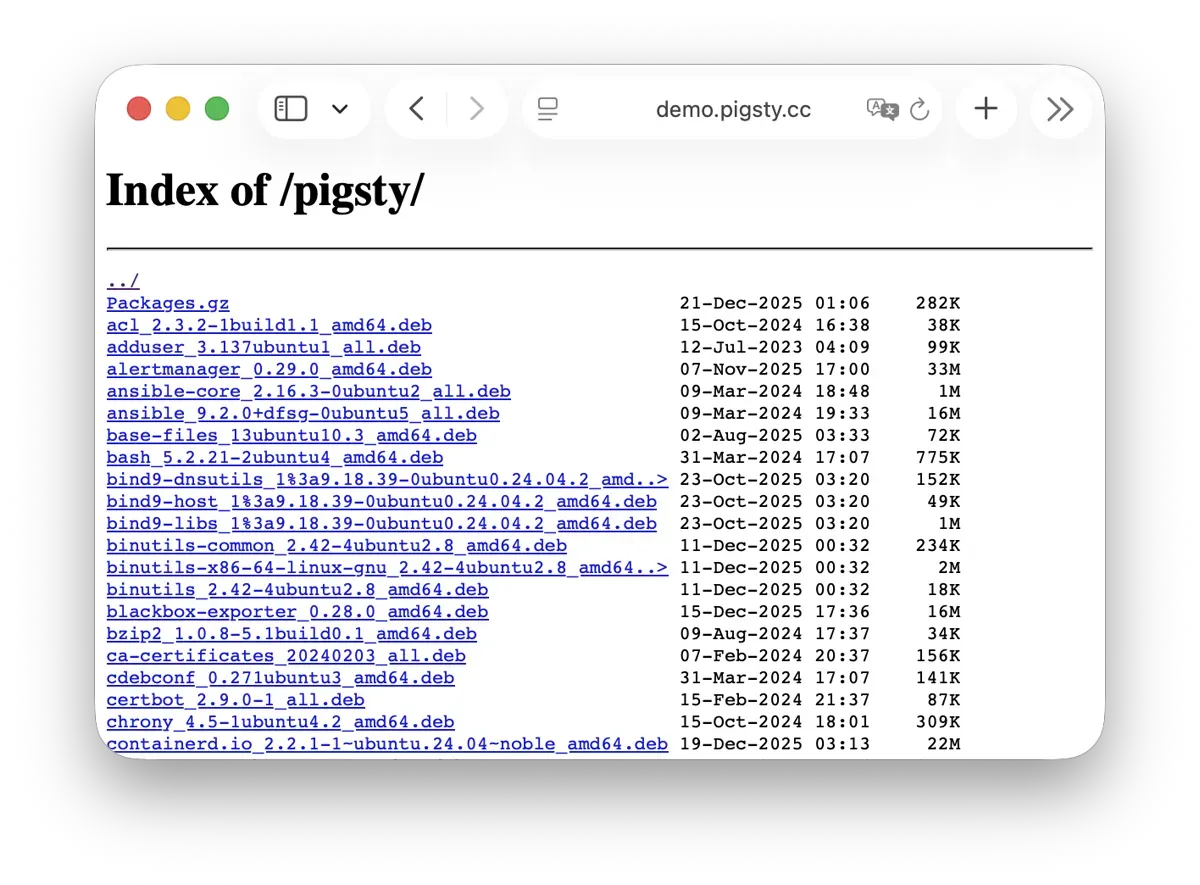

除此之外,Pigsty 本身的安装部署也是一键傻瓜式的,所有依赖被预先打包,在安装时可以无需互联网访问。而安装所需的机器资源,也可以通过 Vagrant 或 Terraform 模板自动获取,让您在十几分钟内就可以从零在本地笔记本或云端虚拟机上拉起一套完整的 Pigsty 部署。本地沙箱环境可以跑在1核2G的微型虚拟机中,提供与生产环境完全一致的功能模拟,可以用于开发、测试、演示与学习。

扎实的安全实践 加密备份一应俱全,只要硬件与密钥安全,您无需操心数据库的安全性。

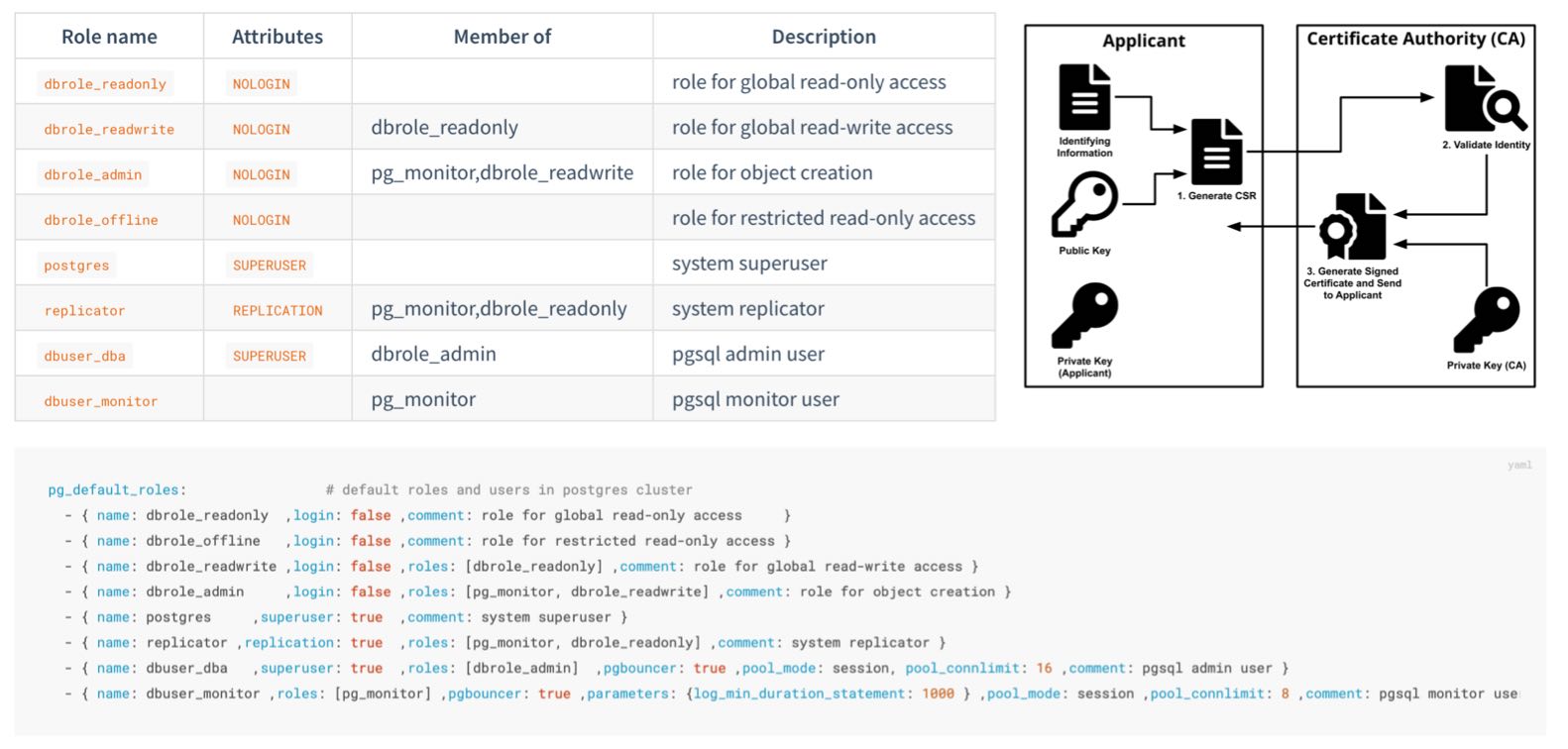

Pigsty 针对高标准,严要求的企业级场景设计 ,采用业界领先的 安全最佳实践 保护您的数据安全(机密性/完整性/可用性),默认配置下的安全性便足以满足绝大多数场景下的合规要求。

Pigsty 会创建自签名的 CA (或使用您提供的 CA)签发证书,加密网络通信。需要保护的敏感管理页面与API端点都受到密码保护。

数据库备份使用 AES 算法加密,数据库密码使用 scram-sha-256 算法加密,并提供插件强制执行密码强度策略。

Pigsty 提供了一套开箱即用,简单易用,便于扩展的 ACL HBA

Pigsty 默认启用数据库校验和避免静默数据腐坏,通过从库副本提供坏块兜底。提供 CRIT 数据零丢失配置模板,使用 watchdog 确保为高可用 Fencing 兜底。

您可以通过 audit 插件审计数据库操作,系统与数据库日志全部收集备查,以满足合规要求。

Pigsty 正确配置 SELinux 与防火墙配置,并遵循最小权限原则设计操作系统用户组与文件权限,确保系统安全基线符合合规要求。

而且在 Etcd,MinIO 等附属可选组件上的安全上也毫不妥协,etcd 与 minio 均使用 RBAC 模型与 TLS 加密通信,确保系统整体安全性。

合理配置的系统通过等保三级/SOC2毫无问题,只要您遵循安全性最佳实践,内网部署并合理配置安全组与防火墙,数据库安全性将不再是您的痛点。

广泛的应用场景 使用预置的Docker模板,一键拉起使用PostgreSQL的海量软件!

在各类数据密集型应用中,数据库往往是最为棘手的部分。例如 Gitlab 企业版与社区版的核心区别就是底层 PostgreSQL 数据库的监控与高可用,如果您已经有了足够好的本地 PG RDS,完全可以拒绝为软件自带的土法手造数据库组件买单。

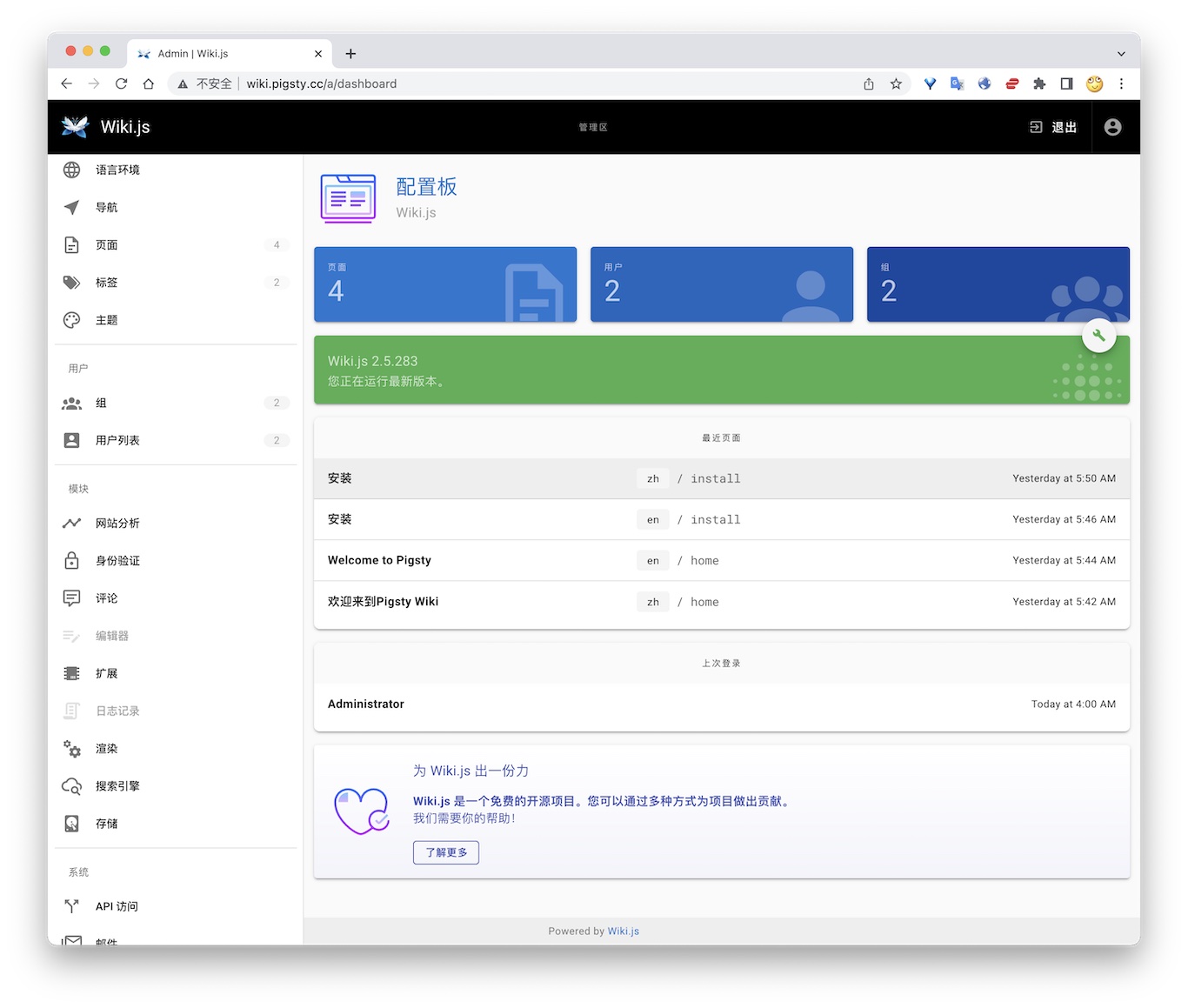

Pigsty 提供了 Docker 模块 Compose 模板

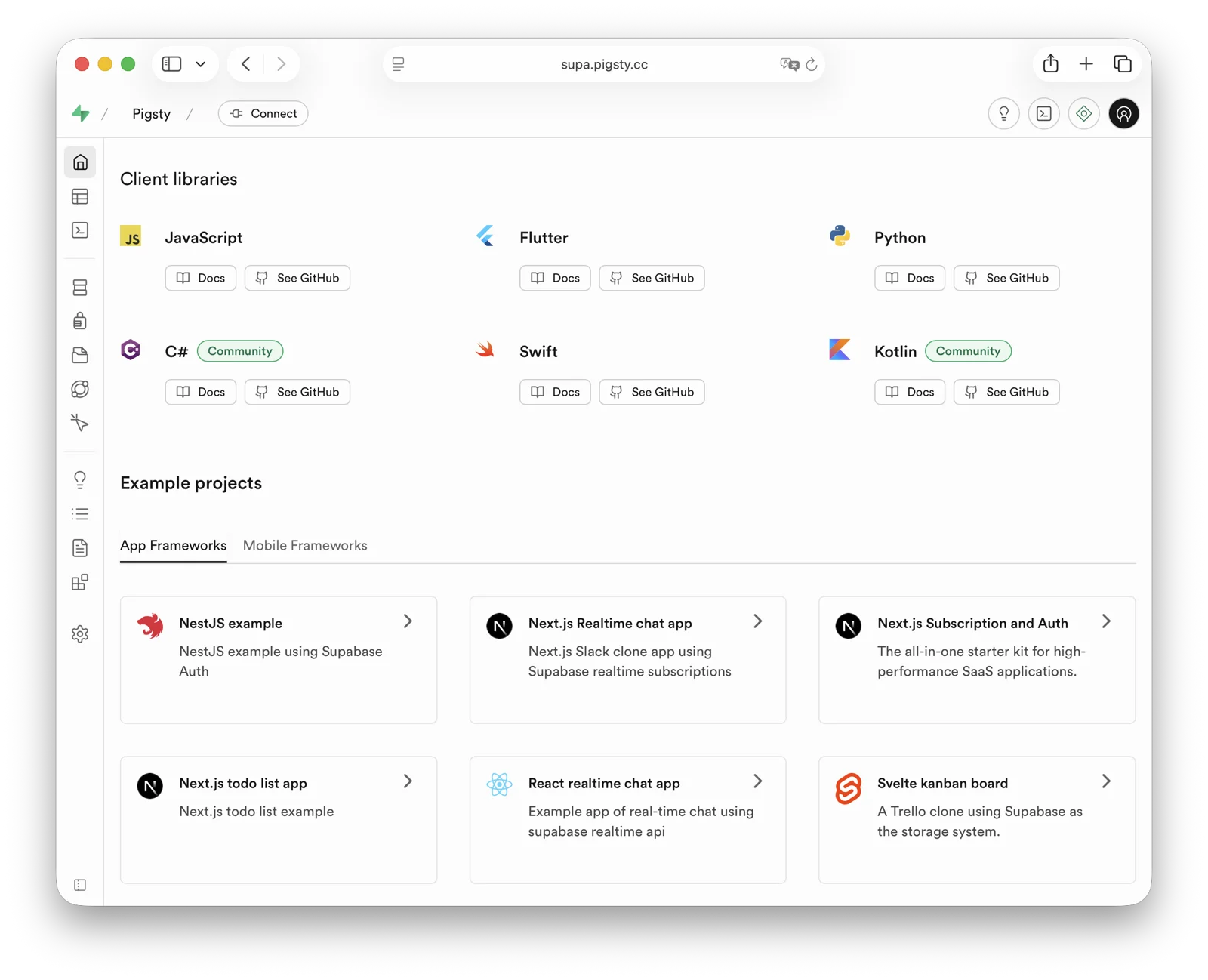

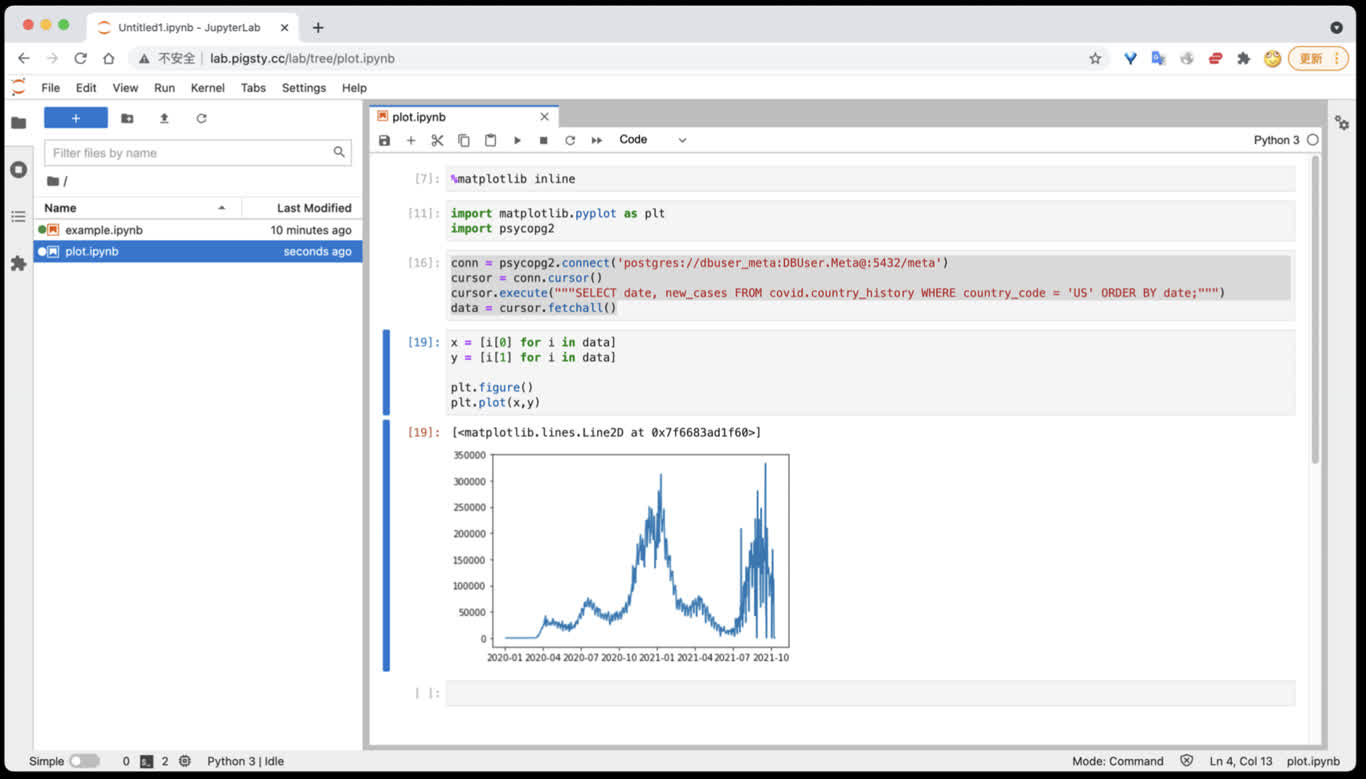

Pigsty 也提供了与 PostgreSQL 紧密联系的应用开发工具集:PGAdmin4、PGWeb、ByteBase、PostgREST、Kong、以及 EdgeDB、FerretDB、Supabase

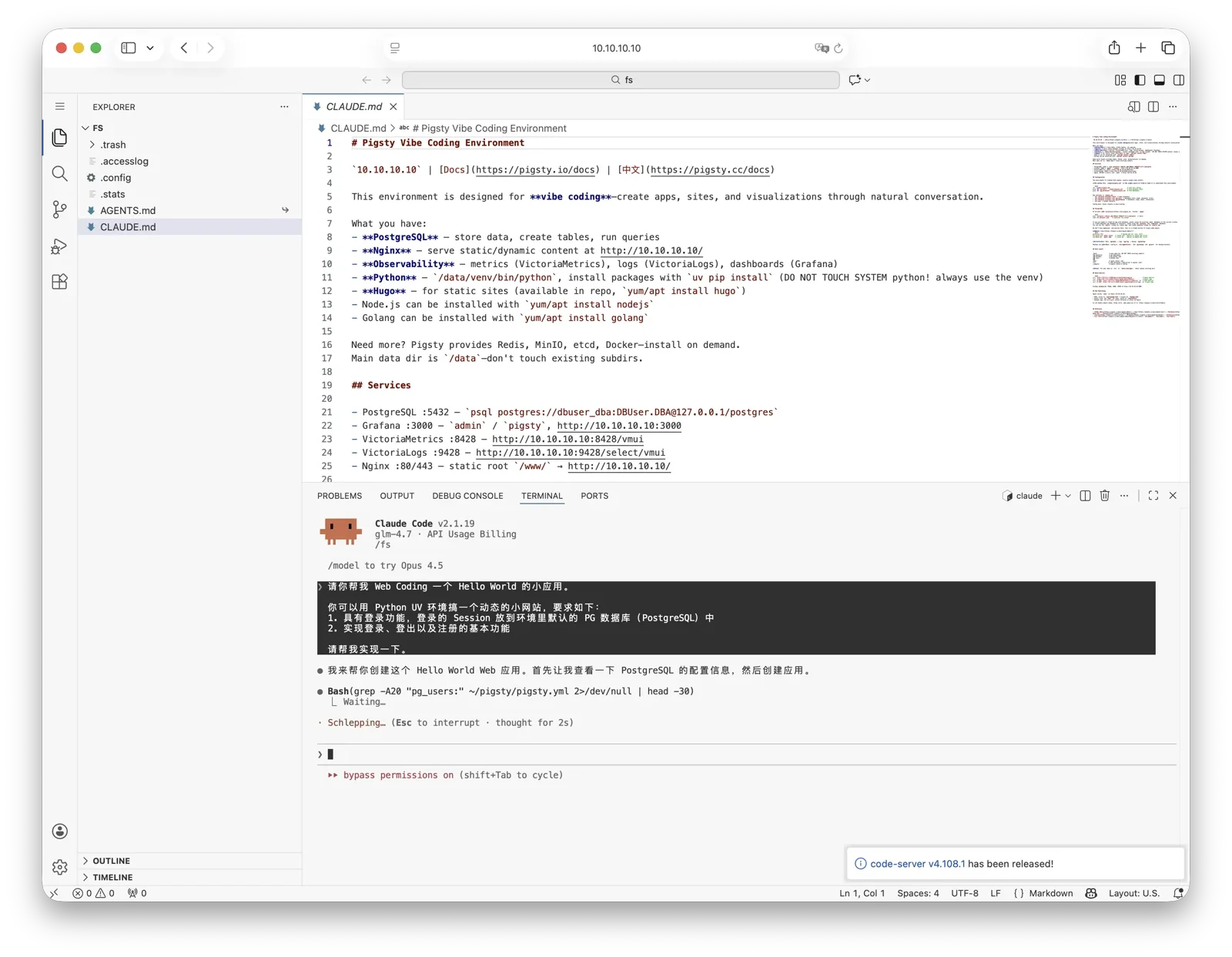

Pigsty 为您的 AI 应用提供了一个功能强大的运行时,您的 Agent 可以在这个环境中利用 PostgreSQL 与可观测性世界的强大能力,快速构建起一个数据驱动的智能体。

开源的自由软件 Pigsty是基于 Apache-2.0 开源的自由软件,由热爱 PostgreSQL 的社区成员用热情浇灌

Pigsty 是完全 开源免费 溢价

很多用户选择上云,正是因为自己搞不定数据库;很多用户使用 RDS,是因为别无他选。

我们将打破云厂商的垄断,为用户提供一个云中立的,更好的

Pigsty 本身旨在用数据库自动驾驶软件,替代大量无趣的人肉数据库运维工作,但再好的软件也没法解决所有的问题。

总会有一些的冷门低频疑难杂症需要专家介入处理。这也是为什么我们也提供专业的 订阅服务 用爱发电

2.2 - 历史沿革 Pigsty 项目的由来与动机,过去发展的历史,未来的目标与愿景。

历史起源 Pigsty 项目始于 2018 ~ 2019 年,起源于 探探

探探在技术上极有品味,使用 PostgreSQL 与 Go 作为核心技术栈。

探探整个系统架构参照 Instagram ,一切围绕 PostgreSQL 数据库设计。

直到几百万日活,几百万 TPS,几百 TB 数据的量级下,数据组件 只用了 PostgreSQL

探探这种深度使用 PostgreSQL 特性的非典型研发模式,对工程师与DBA的水平提出了极高的要求。

而 Pigsty ,就是我们用这种真实世界的大规模,高标准数据库集群场景打磨出的开源项目 ——

沉淀着我们作为顶尖 PostgreSQL 专家的经验与最佳实践。

发展过程 在最开始,Pigsty 并没有现在这样的愿景、目标与版图。而是为了提供一个供我们自己使用的 PostgreSQL 监控系统。

我们调研了市面上所有的方案,开源的、商业的、云的,datadog, pgwatch,…… ,没有一个能满足我们对于可观测性的需求。

因此我决定自己动手,基于 Grafana 与 Prometheus 自己动手打造一个,这就是 Pigsty 的前身与雏形。

Pigsty 作为监控系统的效果相当惊艳,帮助我们解决了无数管理问题。

随后,研发人员希望在本地的开发机上也有这样的监控系统,于是我们使用 Ansible 编写了置备剧本,将这套系统从一次性建设任务转变为了可重复使用,可复制的软件。

新版本允许用户使用 Vagrant 和 Terraform,用 Infra as Code 的方式快速拉起本地 DevBox 开发机,或生产环境服务器,并自动完成 PostgreSQL 与监控系统的部署。

接下来,我们重新设计了生产环境的 PostgreSQL 架构,引入了 Patroni 与 pgBackRest 解决了数据库的 高可用 时间点恢复 迁移

Pigsty 是我们做给自己使用的软件,“Eat dog food”最大的好处就是,我们自己既是开发者也更是用户 ——

我们自己作为甲方用户,非常了解自己需要什么,也不会在自己的需求上偷懒,更不用担心自己的工作全自动化后被开。

我们解决了一个又一个的问题,并将解决方案沉淀到 Pigsty 里。Pigsty 的定位,也从一个监控系统,逐渐发展成为一个开箱即用的 PostgreSQL 数据库发行版。

随即我们决定将 Pigsty 开源,并开始了一系列的技术分享与宣传,也开始有各行各业的外部用户使用起 Pigsty 并提出反馈意见。

全职创业 在 2022 年,Pigsty 项目获得了由陆奇博士发起的奇绩创坛的种子轮投资,我得以全职出来做这件事情。

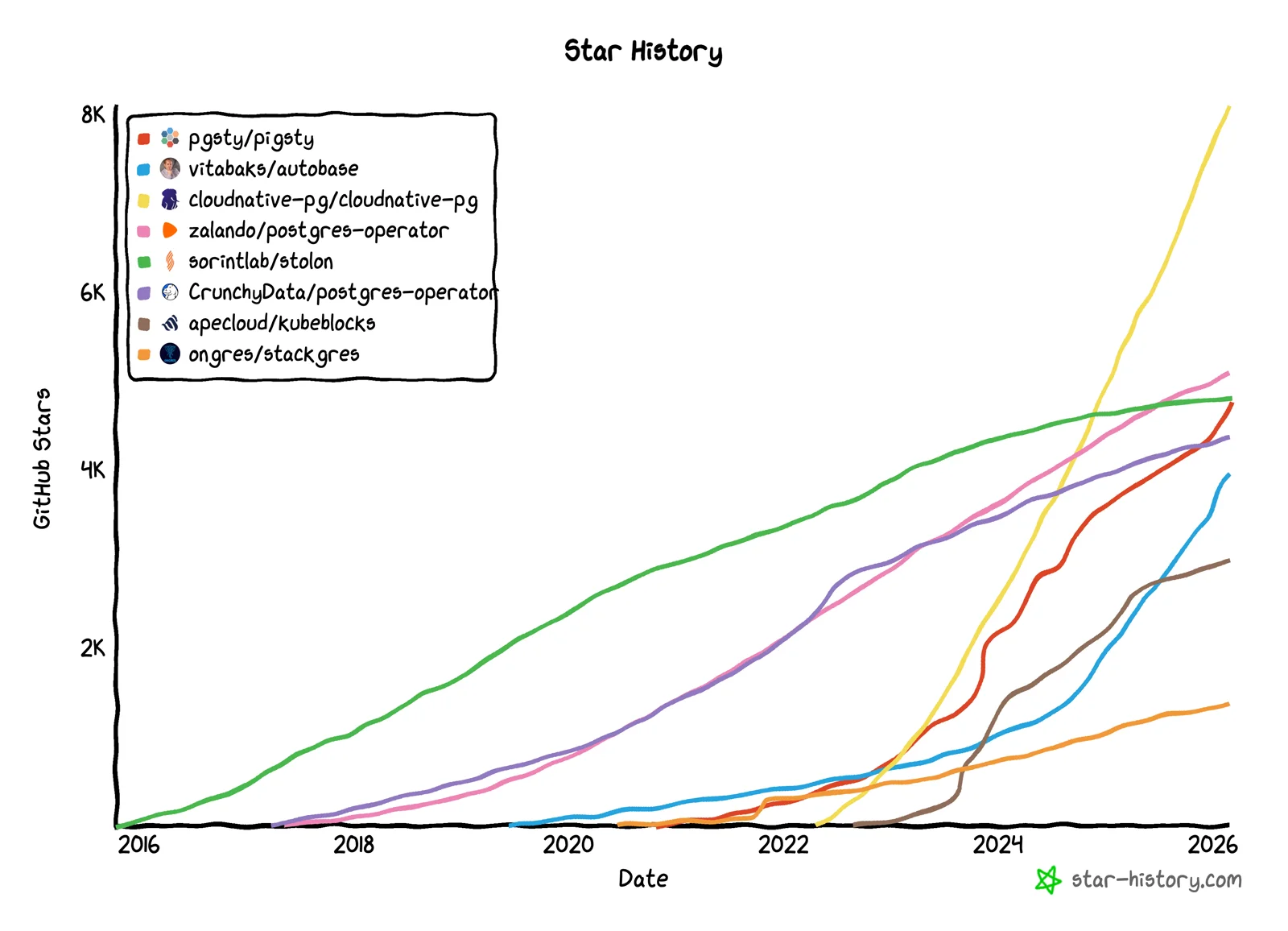

作为一个开源项目,Pigsty 的发展相当不赖,在全职创业这几年里,Pigsty 在 Github 上的 Star 数从几百增长到了 4600+;上了 HN 头条推荐,增长开始滚起雪球。

2025 年 11 月,Pigsty 荣获 PostgreSQL 生态大会颁发的 Magneto Award 。2026 年,Pigsty 子项目 PGEXT.CLOUD 投中 PGCon.Dev 2026 演讲。

Pigsty 成为第一个站上这个 PostgreSQL 核心生态大会舞台上的中国开源项目。

从前 Pigsty 只能跑在 CentOS 7 上,现今已经基本覆盖了所有主流 Linux 发行版 (EL, Debian, Ubuntu),支持 14 个操作系统平台。

支持的 PG 大版本覆盖 13 - 18,维护,收录整合了 PG 生态中的 444 扩展插件。

其中,我本人维护了这里超过一半(270+)的扩展插件,并提供开箱即用的 RPM/DEB 包。

算上 Pigsty 本身,“基于开源,回馈开源”,为 PG 生态做一些贡献。

Pigsty 的定位,也在不断发展的过程中,从一个 PostgreSQL 数据库发行版,进一步扩展到了 开源云数据库 。它真正对标的是云厂商的整个云数据库品牌。

公有云的反叛者 AWS、Azure、GCP、Aliyun 等公有云厂商为初创企业提供了许多便利,但它们是闭源的,并迫使用户以高额费用租赁基础资源。

我们认为,优秀的数据库服务,应该和优秀的数据库内核一样,普及到每一个用户手中,而不是必须花费高昂的代价去向赛博领主租赁。

云计算的敏捷与弹性价值主张很好,但它应该是自由、开源、普惠、本地优先的 ——

我们认为云计算宇宙中需要一个代表开源价值观的解决方案,在不牺牲云带来好处的前提下,将基础设施的控制权交还给用户。

因此,我们也在引领着一场 下云的运动与战役

我们的愿景 我希望,未来的世界人人都有自由使用优秀服务的事实权利,而不是只能被圈养在几个赛博领主公有云巨头厂商的地盘上当赛博佃户甚至赛博农奴。

这正是 Pigsty要做的事 —— 一个更好的,开源免费的RDS替代 。让用户能够在任何地方(包括云服务器)上,一键拉起比云RDS更好的数据库服务。

Pigsty 是对 PostgreSQL 的彻底补完,更是对云数据库的辛辣嘲讽 。

它本意是“猪圈”,但也是 P ostgres I n G reat STY le 的缩写,即“全盛状态下的 PostgreSQL ”。

Pigsty 本身是一款完全开源免费的软件,能够让您在没有数据库专家的情况下,自建水平达到 90 分的 PostgreSQL 数据库服务。

我们靠提供 精品咨询服务

建设良好的系统也许跑个几年都不会遇到需要 “兜底” 的问题,但数据库的问题一但出现就不是小问题。

很多时候,专家的经验更是能够一言化腐朽为神奇,而我们为有需求的客户提供这样的精品咨询

—— 我们认为这是一种更加公正、合理、可持续的模式。

关于团队 我是冯若航,Pigsty 的作者,Pigsty 的所有代码几乎都由我 一人开发

软件领域依然存在个人英雄主义,独一无二的个体才能够创造出独一无二的作品 —— 我希望 Pigsty 成为这样的作品。

如果您对我感兴趣,这里是我的个人主页:https://vonng.com/

《墨天轮风云人物访谈录 —— 冯若航 》

《90后,辞职创业,说要卷死云数据库 》

2.3 - 活动新闻 与 Pigsty 和 PostgreSQL 相关的活动事件与新闻,以及最新活动预告!

最近新闻 2026-02-28 : Pigsty v4.2 正式发布!七款内核批量更新

2026-02-12 : Pigsty v4.1 正式发布!第一批支持 PostgreSQL 18.2 的发行版

2026-02-04 : Extension for Everyone 主题入选 PGCon.Dev 2026 演讲!

2026-02-03 : Pigsty v4.0 正式发布! 迈入 Agent 时代!

2026-01-30 : PIG v1.0 正式发布! 与 PGEXT.CLOUD 扩展目录同步上线

2025-12-02 : Pigsty v3.7.0 发布! PG18 成为默认版本,437 扩展,EL10/Debian13 支持

2025-11-29 : Pigsty 荣获 PostgreSQL Magneto Award !

第八届 PostgreSQL 生态大会(杭州) 演讲主题:“A World-Grade Postgres Meta Distribution”、AI 数据库考量、PostgreSQL 交付最佳实践 2025-08-15 : Pigsty v3.6.1 发布! 例行 PG 小版本更新,PGDG 中国区域镜像

2025-08-04 : Pigsty v3.6.0 发布! PostgreSQL 元发行版

2025-06-16 : Pigsty v3.5.0 发布! PG18 Beta 支持,421 扩展,监控升级,代码重构

2025-04-21 : Pigsty v3.4 发布! MySQL 兼容性

2025-03-07 : Pigsty v3.3.0 发布! 404 扩展

2025-01 : Pigsty v3.2.x 发布系列(v3.2.0 ~ v3.2.2)

390 扩展,Omnigres,Mooncake,Citus13/PG17,扩展管理 CLI,Grafana 强化,ARM64 扩展补完 发布说明:v3.2.2 / v3.2.1 / v3.2.0 PostgreSQL 包管理器 pig 发布!

2024-11 : Pigsty v3.1.0 发布! PG 17 上位,Supabase 自建,ARM/Ubuntu24 支持

2024-08 ~ 2024-10 : Pigsty v3.0.x 发布系列(v3.0.0 ~ v3.0.4)

2024-08 : Pigsty 补充软件仓库,提供 254 个额外的开箱即用的二进制 RPM/DEB 扩展!

PGCon.Dev 2024 参会记!

2024-05 : Pigsty v2.7 发布!

2024-02 : Pigsty v2.6 发布!

版本发布 Pigsty 发布注记

版本 发布时间 摘要 地址 v4.2.0 2026-02-28 例行小版本更新,六大 PG 内核集中更新 v4.2.0 v4.1.0 2026-02-12 操作系统与数据库小版本更新,Agent Native CLI,批量 Bug 修复 v4.1.0 v4.0.0 2026-01-28 Victoria 可观测性,安全加固,JUICE/VIBE 模块,Apache-2.0 v4.0.0 v3.7.0 2025-12-02 PG18 成为默认,437 扩展,EL10/Debian13,PGEXT.CLOUD v3.7.0 v3.6.1 2025-08-15 例行 PG 小版本更新,PGDG 中国区域镜像 v3.6.1 v3.6.0 2025-07-30 pgactive,MinIO/ETCD 改进,安装简化,配置梳理 v3.6.0 v3.5.0 2025-06-16 PG18 Beta,421 扩展,监控升级,代码重构 v3.5.0 v3.4.1 2025-04-05 OpenHalo,OrioleDB,MySQL兼容性,pgAdmin改进 v3.4.1 v3.4.0 2025-03-30 备份增强,自动Certbot证书,Ivory跨平台,AGE扩展 v3.4.0 v3.3.0 2025-02-24 404扩展,Odoo/Dify/Supabase应用模板,DocumentDB支持 v3.3.0 v3.2.2 2025-01-23 390扩展,Omnigres支持,Mooncake,Citus13与PG17支持 v3.2.2 v3.2.1 2025-01-12 350扩展,Ivory4,Citus强化,Odoo模板 v3.2.1 v3.2.0 2024-12-24 扩展管理 CLI ,Grafana 强化,ARM64 扩展补完 v3.2.0 v3.1.0 2024-11-22 PG 17 作为默认大版本,配置简化,Ubuntu 24 与 ARM 支持,MinIO 改进 v3.1.0 v3.0.4 2024-10-30 PG 17 扩展,OLAP 全家桶,pg_duckdb v3.0.4 v3.0.3 2024-09-27 PostgreSQL 17,Etcd 运维优化,IvorySQL 3.4,PostGIS 3.5 v3.0.3 v3.0.2 2024-09-07 精简安装模式,PolarDB 15支持,监控视图更新 v3.0.2 v3.0.1 2024-08-31 例行问题修复,Patroni 4支持,Oracle兼容性改进 v3.0.1 v3.0.0 2024-08-25 333个扩展插件,可插拔内核,MSSQL,Oracle,PolarDB 兼容性 v3.0.0 v2.7.0 2024-05-20 扩展大爆炸,新增20+强力扩展插件,与多款Docker应用 v2.7.0 v2.6.0 2024-02-28 PG 16 作为默认大版本,引入 ParadeDB 与 DuckDB 等扩展 v2.6.0 v2.5.1 2023-12-01 例行小版本更新,PG16重要扩展支持 v2.5.1 v2.5.0 2023-09-24 Ubuntu/Debian支持:bullseye, bookworm, jammy, focal v2.5.0 v2.4.1 2023-09-24 Supabase/PostgresML支持与各种新扩展:graphql, jwt, pg_net, vault v2.4.1 v2.4.0 2023-09-14 PG16,监控RDS,服务咨询支持,新扩展:中文分词全文检索/图/HTTP/嵌入等 v2.4.0 v2.3.1 2023-09-01 带HNSW的PGVector,PG 16 RC1, 文档翻新,中文文档,例行问题修复 v2.3.1 v2.3.0 2023-08-20 主机VIP, ferretdb, nocodb, MySQL存根, CVE修复 v2.3.0 v2.2.0 2023-08-04 仪表盘 & 置备重做,UOS 兼容性 v2.2.0 v2.1.0 2023-06-10 支持 PostgreSQL 12 ~ 16beta v2.1.0 v2.0.2 2023-03-31 新增 pgvector 支持,修复 MinIO CVE v2.0.2 v2.0.1 2023-03-21 v2 错误修复,安全增强,升级 Grafana 版本 v2.0.1 v2.0.0 2023-02-28 架构大升级,兼容性、安全性、可维护性显著增强 v2.0.0 v1.5.1 2022-06-18 Grafana 安全性修复 v1.5.1 v1.5.0 2022-05-31 Docker 应用程序支持 v1.5.0 v1.4.1 2022-04-20 错误修复 & 英文文档完整翻译 v1.4.1 v1.4.0 2022-03-31 MatrixDB 支持,分离 INFRA/NODES/PGSQL/REDIS模块 v1.4.0 v1.3.0 2021-11-30 PGCAT 重整 & PGSQL 增强 & Redis Beta支持 v1.3.0 v1.2.0 2021-11-03 默认 PGSQL 版本升级至 14 v1.2.0 v1.1.0 2021-10-12 主页, JupyterLab, PGWEB, Pev2 & pgbadger v1.1.0 v1.0.0 2021-07-26 v1 正式版, 监控系统重整 v1.0.0 v0.9.0 2021-04-04 Pigsty 图形界面, 命令行界面, 日志集成 v0.9.0 v0.8.0 2021-03-28 服务置备,定制对外暴露的数据库服务 v0.8.0 v0.7.0 2021-03-01 仅监控部署,监控现有 PostgreSQL 实例 v0.7.0 v0.6.0 2021-02-19 架构增强,将PG与Consul解耦 v0.6.0 v0.5.0 2021-01-07 支持在配置中定义业务数据库/用户 v0.5.0 v0.4.0 2020-12-14 支持 PostgreSQL 13,添加官方文档 v0.4.0 v0.3.0 2020-10-22 虚拟机置备方案正式定稿 v0.3.0 v0.2.0 2020-07-10 PG监控系统第六版正式发布 v0.2.0 v0.1.0 2020-06-20 在生产仿真测试环境中验证通过 v0.1.0 v0.0.5 2020-08-19 离线安装模式:无需互联网访问即可交付 v0.0.5 v0.0.4 2020-07-27 将 Ansible 剧本重构为 Role Refactor playbooks into ansible roles v0.0.4 v0.0.3 2020-06-22 接口设计改进 v0.0.3 v0.0.2 2020-04-30 首次提交 v0.0.2 v0.0.1 2019-05-15 概念原型 v0.0.1

会议与演讲 日期 类型 活动 主题 2025-11-29 获奖&演讲 第八届 PostgreSQL 生态大会(杭州) PostgreSQL Magneto Award,世界级 Postgres 元发行版 2025-05-16 闪电演讲 PGConf.Dev 2025(蒙特利尔) Extension Delivery: 让您的 PGEXT 触达用户 2025-05-12 主题演讲 PGEXT.DAY, PGCon.Dev 2025 PostgreSQL 生态中缺失的包管理器与扩展仓库 2025-04-19 实战工坊 PostgreSQL 数据库技术峰会 使用 Pigsty 部署 PG 生态伙伴:Dify, Odoo, Supabase 2025-04-11 直播主持 OSCHINA 数智Talk 刷屏的 MCP 是炒作还是革命? 2025-01-15 直播分享 开源老将与新秀第四期 PostgreSQL 扩展吞噬数据库世界?PG包管理器 pig 与自建 RDS Pigsty 2025-01-09 颁奖典礼 OSCHINA 2024 年度杰出贡献专家 年度杰出贡献专家 2025-01-06 圆桌论坛 中国 PostgreSQL 数据库生态大会 PostgreSQL 扩展正在吞噬数据库世界 2024-11-23 播客 技术乱炖 Podcast 来自 Linux 基金会:为什么最近都在关注"卡脖子"? 2024-08-21 媒体专访 蓝色科技浪潮 Pigsty 作者冯若航专访:简化PG管理,推动中国开源社区 2024-08-15 技术大会 GOTC 全球开源技术峰会 PostgreSQL AI/ML/RAG 扩展生态与最佳实践 2024-07-12 主题演讲 第十三届 PG 中国技术大会 数据库世界的未来:扩展,服务,与 Postgres 2024-05-31 非正式会议 PGCon.Dev 2024 全球 PG 开发者大会 Unconference 内置 Prometheus 指标导出器 2024-05-28 专题研讨 PGCon.Dev 2024 全球 PG 开发者大会 扩展峰会 Extension in Core & Binary Packing 2024-05-10 直播辩论 三人行·云计算泥石流系列 第三期 公有云是骗局吗? 2024-04-17 直播辩论 三人行·云计算泥石流系列 第二期 云数据库是智商税吗? 2024-04-16 圆桌论坛 Cloudflare Immerse 深圳 赛博菩萨圆桌论坛 2024-04-12 技术大会 2024 数据技术嘉年华 Pigsty:解决 PostgreSQL 运维难题 2024-03-31 直播辩论 三人行·云计算泥石流系列 第一期 罗永浩卖云,我们却在下云? 2024-01-24 直播主持 OSCHINA 开源漫谈 第九期 DBA 会被云干掉吗? 2023-12-20 直播辩论 开源漫谈第七期 上云 or 下云,割韭菜还是降本增效? 2023-11-24 技术大会 大模型时代的向量数据库 圆桌讨论:大模型时代向量数据库新未来 2023-09-08 人物专访 墨天轮风云人物访谈 冯若航:不想当段子手的技术狂,不是一位好的开源创始人 2023-08-16 技术大会 DTCC 2023 DBA之夜:PostgreSQL vs MySQL的开源协议问题 2023-08-09 直播辩论 开源漫谈第一期 MySQL vs PostgreSQL,谁是世界第一? 2023-07-01 技术大会 SACC 2023 专题研讨会8:FinOps实践:云成本管理与优化 2023-05-12 线下活动 PostgreSQL中国社区 温州站线下沙龙 PG With DB4AI: 向量数据库 PGVECTOR & AI4DB: 数据库自动驾驶 Pigsty 2023-04-08 技术大会 数据库嘉年华 2023 更好的开源RDS替代:Pigsty 2023-04-01 技术大会 PostgreSQL中国社区 西安站线下沙龙 PG高可用与容灾最佳实践 2023-03-23 公开直播 Bytebase x Pigsty 管理 PostgreSQL 的最佳实践: Bytebase x Pigsty 2023-03-04 技术大会 PostgreSQL中国技术大会 炮打 RDS,Pigsty v2.0 发布 2023-02-01 技术大会 DTCC 2022 开源 RDS 替代:开箱即用、自动驾驶的数据库发行版 Pigsty 2022-07-21 直播辩论 云吞噬开源,那开源有机会反击吗? 云吞噬开源,那开源有机会反击吗? 2022-07-04 人物专访 专题采访:创造者说 90 后,辞职创业,说要卷死云数据库 2022-06-28 公开直播 贝斯的圆桌趴 |DBA 福音 - SQL 审核最佳实践 2022-06-12 公开路演 奇绩创坛 S22 路演日 好用省钱的数据库发行版 Pigsty 2022-06-05 视频直播 PG中文社区直播分享 Pigstyv1.5快速上手新特性介绍与生产集群搭建

2.4 - 发展规划 未来功能的规划,新功能的发布节奏,待办事项列表。

版本发布策略 Pigsty 使用语义化版本号,<主版本>.<次版本>.<修订号>。Alpha / Beta / RC 版本会在版本号后添加后缀,如 -a1,-b1,-c1。

主版本更新意味着不兼容的基础性变化与重大新特性;次版本更新通常表示普通功能特性更新,较小的API变动;修订版本更新意味着 Bug 修复与软件包版本更新。

Pigsty 计划每年发布一次主版本更新,次版本更新通常跟随 PostgreSQL 小版本更新节奏,在 PostgreSQL 新版本发布后最迟一个月内跟进。

Pigsty 通常每年计划 4 - 6 个小版本,完整发布历史请参考 发行注记

使用具体的版本号进行部署

Pigsty 使用 main 主干分支进行开发,请始终使用带有版本号的 Release

除非您清楚知道自己在做什么,否则请勿使用 GitHub 的 main 分支,总是检出特定版本使用。

列入考虑的新特性 这里是我们的 活跃议题 路线图

扩展插件与软件包 关于扩展支持的路线图,可以在这里找到:https://pgext.cloud/e/roadmap

考虑纳入 暂不考虑 2.5 - 加入社区 Pigsty 是一个 Build in Public 的项目,我们在 GitHub 上非常活跃,中文区用户主要活跃于微信群组中。

GitHub 我们的 GitHub 仓库地址是:https://github.com/pgsty/pigsty ,欢迎点个 ⭐️ 关注

我们欢迎任何人 提交新 Issue 或创建 Pull Request ,提出功能建议并参与 Pigsty 贡献。

请注意,关于 Pigsty 文档的问题,请在 github.com/Vonng/pigsty.cc 仓库中提交 Issue 。

微信群组 中文区用户主要活跃于微信群组中,目前有七个活跃的群组,1群-4群已经满员,其他群需要添加小助手微信拉入。

加入微信社群,请用搜索 “Pigsty小助手”,(微信号 pigsty-cc) 备注或发送 “加群” ,小助手会将您拉入群组中。

海外社群 Telegram: https://t.me/joinchat/gV9zfZraNPM3YjFh

Discord: https://discord.gg/j5pG8qfKxU

您也可以通过邮件联系我: rh@vonng.com

社区求助 当您使用 Pigsty 遇到问题时,可以向社区求助,您提供的信息越丰富,就越有可能在社区得到帮助。

请参考 社区求助指南 ,尽可能提供足够的信息,以便社区成员帮助您解决问题。以下是求助提问的参考模板:

发生了什么事? (必选项 )

Pigsty版本号与操作系统版本 (必选项 )

$ grep version pigsty.yml

$ cat /etc/os-release

$ uname -a

一些云厂商对标准操作系统发行版进行了定制,您可以告诉我们使用的是哪一家云厂商的什么操作系统镜像。

如果您在安装操作系统后对环境进行了定制与修改,或者在您的局域网中有特定的安全规则与防火墙配置,也请在提问时告知我们。

Pigsty配置文件

请不要忘记抹掉任何敏感信息:密码,内部密钥,敏感配置等。

cat ~/pigsty/pigsty.yml

你期待发生什么?

请描述正常情况下应该发生什么事情,实际发生的情况与期待的情况有何偏离?

如何复现此问题?

请尽可能详细地告诉我们复现此问题的方法与步骤。

监控截图

如果你在使用 Pigsty 提供的监控系统,可以提供 相关 的截图。

错误日志

请尽可能提供与错误有关的日志。请不要粘贴类似 “Failed to start xxx service” 之类没有信息量的内容 。

您可以从 Grafana / VictoriaLogs 中查询日志,或从以下位置获取日志:

Syslog: /var/log/messages (rhel) or /var/log/syslog (debian) Postgres: /pg/log/postgres/* Patroni: /pg/log/patroni/* Pgbouncer: /pg/log/pgbouncer/* Pgbackrest: /pg/log/pgbackrest/* journalctl -u patroni

journalctl -u <service name>

您已经搜索过 Issue/网站/FAQ了吗?

在 FAQ 中,我们提供了许多常见问题的解答,请在提问前检查

您也可以从 Github Issue 与 Discussion 中搜索相关问题:

有什么其他信息是我们需要知道的吗?

您提供的信息与上下文越丰富,我们越有可能帮助您解决问题。

2.6 - 隐私政策 Pigsty 软件与网站会收集哪些用户数据,以及我们将如何处理您的数据并保护您的隐私权?

Pigsty软件 当您安装 Pigsty 软件时,如果在网络隔离的环境中使用离线软件包安装,我们不会收到任何关于您的数据 。

如果您选择在线安装,那么在下载相关软件包时,我们的服务器或云供应商的服务器会自动在日志中记录来访机器的 IP 地址和/或主机名,和您下载的软件包名称。

除非法律要求,我们不会与其他组织共享这些信息。(实话说,吃饱了撑着才会去看这些东西)

Pigsty 使用的主域名为:pigsty.io pigsty.cc

Pigsty网站 当您访问我们的网站时,我们的服务器会自动在 Nginx 日志中记录您的 IP 地址和/或主机名。

仅当您决定通过完成调查或在我们的某个网站上注册为用户来向我们发送此类信息时,我们才会存储您的电子邮件地址、姓名和地点等信息

我们收集这些信息是为了帮助我们改进网站内容、定制网页布局以及出于技术和支持目的联系人员。除非法律要求,我们不会与其他组织共享您的电子邮件地址。

本网站使用 Google Analytics,这是 Google, Inc.(“Google”)提供的一项网络分析服务。谷歌分析使用“cookies”,即放置在您计算机上的文本文件,帮助网站分析用户如何使用该网站。

cookie 生成的有关您使用网站的信息(包括您的 IP 地址)将被传输至 Google 位于美国的服务器并由其存储。谷歌将使用这些信息来评估您对网站的使用情况,为网站运营商编制网站活动报告,并提供与网站活动和互联网使用相关的其他服务。

如果法律要求,或者第三方代表 Google 处理信息,Google 还可能会将此信息传输给第三方。 Google 不会将您的 IP 地址与 Google 持有的任何其他数据关联起来。

您可以通过在浏览器上选择适当的设置来拒绝使用 cookie,但请注意,如果您这样做,您可能无法使用本网站的全部功能。使用本网站即表示您同意 Google 以上述方式和目的处理有关您的数据。

如果您对此政策有任何疑问或意见,或要求删除个人数据,您可以通过发送邮件至 rh@vonng.com 与我们联系

2.7 - 开源协议 Pigsty 使用的开源协议 —— Apache-2.0,它授予您什么样的权利,又有哪些限制?

协议摘要 Pigsty 项目主体使用 Apache-2.0 开源许可证;Pigsty 文档网站使用 CC by 4.0 许可证。

项目协议地址:https://github.com/pgsty/pigsty/blob/main/LICENSE

Pigsty 项目主体 Pigsty 软件主体采用 Apache License 2.0

本协议授权您 本协议不提供 本协议的条件

Pigsty 文档网站 Pigsty 的文档与网站(包括但不限于:pigsty.cc pigsty.io pgsty.com Creative Commons Attribution 4.0 International (CC BY 4.0) 许可证。

CC BY 4.0 是一种知识共享许可证,允许您自由地分享与演绎本站的内容,但是您必须给出 适当的署名 指出是否有对原始内容进行了修改

本协议授权您 本协议不提供 本协议的条件

SBOM 清单 以下为 Pigsty 项目所使用或相关的开源软件及其开源协议。

451 个 PostgreSQL 扩展插件的许可证请参考 PostgreSQL 扩展许可证清单

必要性等级说明:

必选 :提供 Pigsty 关键性核心能力,不提供关闭停用选项建议 :Pigsty 默认启用 的组件,可以通过配置选项停用可选 :Pigsty 默认支持但不启用的组件,可通过配置启用Apache-2.0 许可证原文

Apache License

Version 2.0, January 2004

http://www.apache.org/licenses/

TERMS AND CONDITIONS FOR USE, REPRODUCTION, AND DISTRIBUTION

1. Definitions.

"License" shall mean the terms and conditions for use, reproduction,

and distribution as defined by Sections 1 through 9 of this document.

"Licensor" shall mean the copyright owner or entity authorized by

the copyright owner that is granting the License.

"Legal Entity" shall mean the union of the acting entity and all

other entities that control, are controlled by, or are under common

control with that entity. For the purposes of this definition,

"control" means (i) the power, direct or indirect, to cause the

direction or management of such entity, whether by contract or

otherwise, or (ii) ownership of fifty percent (50%) or more of the

outstanding shares, or (iii) beneficial ownership of such entity.

"You" (or "Your") shall mean an individual or Legal Entity

exercising permissions granted by this License.

"Source" form shall mean the preferred form for making modifications,

including but not limited to software source code, documentation

source, and configuration files.

"Object" form shall mean any form resulting from mechanical

transformation or translation of a Source form, including but

not limited to compiled object code, generated documentation,

and conversions to other media types.

"Work" shall mean the work of authorship, whether in Source or

Object form, made available under the License, as indicated by a

copyright notice that is included in or attached to the work

(an example is provided in the Appendix below).

"Derivative Works" shall mean any work, whether in Source or Object

form, that is based on (or derived from) the Work and for which the

editorial revisions, annotations, elaborations, or other modifications

represent, as a whole, an original work of authorship. For the purposes

of this License, Derivative Works shall not include works that remain

separable from, or merely link (or bind by name) to the interfaces of,

the Work and Derivative Works thereof.

"Contribution" shall mean any work of authorship, including

the original version of the Work and any modifications or additions

to that Work or Derivative Works thereof, that is intentionally

submitted to Licensor for inclusion in the Work by the copyright owner

or by an individual or Legal Entity authorized to submit on behalf of

the copyright owner. For the purposes of this definition, "submitted"

means any form of electronic, verbal, or written communication sent

to the Licensor or its representatives, including but not limited to

communication on electronic mailing lists, source code control systems,

and issue tracking systems that are managed by, or on behalf of, the

Licensor for the purpose of discussing and improving the Work, but

excluding communication that is conspicuously marked or otherwise

designated in writing by the copyright owner as "Not a Contribution."

"Contributor" shall mean Licensor and any individual or Legal Entity

on behalf of whom a Contribution has been received by Licensor and

subsequently incorporated within the Work.

2. Grant of Copyright License. Subject to the terms and conditions of

this License, each Contributor hereby grants to You a perpetual,

worldwide, non-exclusive, no-charge, royalty-free, irrevocable

copyright license to reproduce, prepare Derivative Works of,

publicly display, publicly perform, sublicense, and distribute the

Work and such Derivative Works in Source or Object form.

3. Grant of Patent License. Subject to the terms and conditions of

this License, each Contributor hereby grants to You a perpetual,

worldwide, non-exclusive, no-charge, royalty-free, irrevocable

(except as stated in this section) patent license to make, have made,

use, offer to sell, sell, import, and otherwise transfer the Work,

where such license applies only to those patent claims licensable

by such Contributor that are necessarily infringed by their

Contribution(s) alone or by combination of their Contribution(s)

with the Work to which such Contribution(s) was submitted. If You

institute patent litigation against any entity (including a

cross-claim or counterclaim in a lawsuit) alleging that the Work

or a Contribution incorporated within the Work constitutes direct

or contributory patent infringement, then any patent licenses

granted to You under this License for that Work shall terminate

as of the date such litigation is filed.

4. Redistribution. You may reproduce and distribute copies of the

Work or Derivative Works thereof in any medium, with or without

modifications, and in Source or Object form, provided that You

meet the following conditions:

(a) You must give any other recipients of the Work or

Derivative Works a copy of this License; and

(b) You must cause any modified files to carry prominent notices

stating that You changed the files; and

(c) You must retain, in the Source form of any Derivative Works

that You distribute, all copyright, patent, trademark, and

attribution notices from the Source form of the Work,

excluding those notices that do not pertain to any part of

the Derivative Works; and

(d) If the Work includes a "NOTICE" text file as part of its

distribution, then any Derivative Works that You distribute must

include a readable copy of the attribution notices contained

within such NOTICE file, excluding those notices that do not

pertain to any part of the Derivative Works, in at least one

of the following places: within a NOTICE text file distributed

as part of the Derivative Works; within the Source form or

documentation, if provided along with the Derivative Works; or,

within a display generated by the Derivative Works, if and

wherever such third-party notices normally appear. The contents

of the NOTICE file are for informational purposes only and

do not modify the License. You may add Your own attribution

notices within Derivative Works that You distribute, alongside

or as an addendum to the NOTICE text from the Work, provided

that such additional attribution notices cannot be construed

as modifying the License.

You may add Your own copyright statement to Your modifications and

may provide additional or different license terms and conditions

for use, reproduction, or distribution of Your modifications, or

for any such Derivative Works as a whole, provided Your use,

reproduction, and distribution of the Work otherwise complies with

the conditions stated in this License.

5. Submission of Contributions. Unless You explicitly state otherwise,

any Contribution intentionally submitted for inclusion in the Work

by You to the Licensor shall be under the terms and conditions of

this License, without any additional terms or conditions.

Notwithstanding the above, nothing herein shall supersede or modify

the terms of any separate license agreement you may have executed

with Licensor regarding such Contributions.

6. Trademarks. This License does not grant permission to use the trade

names, trademarks, service marks, or product names of the Licensor,

except as required for reasonable and customary use in describing the

origin of the Work and reproducing the content of the NOTICE file.

7. Disclaimer of Warranty. Unless required by applicable law or

agreed to in writing, Licensor provides the Work (and each

Contributor provides its Contributions) on an "AS IS" BASIS,

WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or

implied, including, without limitation, any warranties or conditions

of TITLE, NON-INFRINGEMENT, MERCHANTABILITY, or FITNESS FOR A

PARTICULAR PURPOSE. You are solely responsible for determining the

appropriateness of using or redistributing the Work and assume any

risks associated with Your exercise of permissions under this License.

8. Limitation of Liability. In no event and under no legal theory,

whether in tort (including negligence), contract, or otherwise,

unless required by applicable law (such as deliberate and grossly

negligent acts) or agreed to in writing, shall any Contributor be

liable to You for damages, including any direct, indirect, special,

incidental, or consequential damages of any character arising as a

result of this License or out of the use or inability to use the

Work (including but not limited to damages for loss of goodwill,

work stoppage, computer failure or malfunction, or any and all

other commercial damages or losses), even if such Contributor

has been advised of the possibility of such damages.

9. Accepting Warranty or Additional Liability. While redistributing

the Work or Derivative Works thereof, You may choose to offer,

and charge a fee for, acceptance of support, warranty, indemnity,

or other liability obligations and/or rights consistent with this

License. However, in accepting such obligations, You may act only

on Your own behalf and on Your sole responsibility, not on behalf

of any other Contributor, and only if You agree to indemnify,

defend, and hold each Contributor harmless for any liability

incurred by, or claims asserted against, such Contributor by reason

of your accepting any such warranty or additional liability.

END OF TERMS AND CONDITIONS

APPENDIX: How to apply the Apache License to your work.

To apply the Apache License to your work, attach the following

boilerplate notice, with the fields enclosed by brackets "[]"

replaced with your own identifying information. (Don't include

the brackets!) The text should be enclosed in the appropriate

comment syntax for the file format. We also recommend that a

file or class name and description of purpose be included on the

same "printed page" as the copyright notice for easier

identification within third-party archives.

Copyright (C) 2018-2026 Ruohang Feng, @Vonng (rh@vonng.com)

Licensed under the Apache License, Version 2.0 (the "License");

you may not use this file except in compliance with the License.

You may obtain a copy of the License at

http://www.apache.org/licenses/LICENSE-2.0

Unless required by applicable law or agreed to in writing, software

distributed under the License is distributed on an "AS IS" BASIS,

WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

See the License for the specific language governing permissions and

limitations under the License.

2.8 - 赞助我们 Pigsty 的赞助者,投资人名单,感谢你们对本项目的支持!

赞助我们 Pigsty 是一个开源免费的自由软件,由 PostgreSQL 社区成员用热情浇灌而成,旨在整合 PostgreSQL 生态的力量,推广 PostgreSQL 的普及。

如果我们的工作帮到了您,请考虑赞助或者支持一下我们的项目:

直接打钱赞助我们,用最直接有力的鼓舞表达您的真挚支持! 考虑采购我们的 技术支持服务 通过文章,讲座,视频分享您使用 Pigsty 的案例与经验。 允许我们在 “这些用户使用了Pigsty” 中提及您的组织。 向有需求的朋友,同事与客户提名/推荐我们的项目与服务。 关注我们的 微信公众号 天使投资人 Pigsty 是由 奇绩创坛

赞助者 感谢我们的赞助者 Vercel,为 Pigsty 网站提供了赞助与网站托管基础设施。

2.9 - 行业案例 Pigsty 在各个领域与行业的客户/应用案例

根据 Google Analytics PV 与下载量,Pigsty 目前有约 10 万用户 ,一半来自中国大陆,一半来自全球其他地区。

遍布互联网、云计算、金融、自动驾驶、制造业、科技创新、ISV 与军工等多个行业。

如果您在 使用 Pigsty 并且愿意与我们分享您的案例与 Logo,欢迎联系我们,我们提供一次的免费咨询支持。

互联网 探探 :两百台+物理机,用于 PostgreSQL 与 Redis 服务

哔哩哔哩 :用于支持 PostgreSQL 创新业务

云厂商 Bitdeer :比特小鹿,提供 PG DBaaS

Oracle OCI :使用 Pigsty 交付 PostgreSQL 集群。

金融行业 AirWallex :监控 200+ GCP PostgreSQL 数据库

影视行业 影视飓风 :自建 PG RDS / Victoria Metrics

自动驾驶 Momenta :自动驾驶,管理自建 PostgreSQL 集群

制造业 华峰集团 :使用 Pigsty 交付 PostgreSQL 集群作为化工时序数据仓库

科技创新 北京领雾科技 :云上 PostgreSQL 下云自建

Motphys :自建 PostgreSQL 支持 Gitlab

赛陇生物科技 :自建 Supabase

杭州零码科技 :自建 PostgreSQL

ISV 内蒙古豪德天沐科技有限公司

上海元芳

DSG

军工 北京某部队

上海某部队

电科36所

机械工业研究所

航天一院

2.10 - 订阅服务 Pigsty 专业版/企业版订阅服务:当您遇到与 PostgreSQL 和 Pigsty 有关的疑难杂症时,订阅服务可以为您兜底。

Pigsty 旨在聚集PG生态的合力,并用自动驾驶的数据库管控软件帮助用户用好世界上 最流行

尽管 Pigsty 本身已经解决了 PG 使用中的诸多问题。但想真正达到企业级服务的质量,原厂提供的专家支持与兜底服务不可或缺。

我们深知专业的商业支持服务对于企业客户的重要性,因此,Pigsty 企业版在开源版本的基础上提供了一系列增值服务,帮助用户更好地用好 PostgreSQL 与 Pigsty,供有需求的客户按需选用。

如果您有下列需求,欢迎考虑 Pigsty 订阅服务:

在关键场景中运行数据库,需要严格 SLA 保障兜底。 希望对 Pigsty 与 PostgreSQL 相关疑难杂症提供兜底。 希望获取关于 PostgreSQL / Pigsty 生产环境最佳实践的指导。 希望有专家帮助解读监控图表,分析定位性能瓶颈与故障根因,给出意见。 希望根据现有资源与业务需求,规划满足安全/容灾/合规要求的数据库架构。 需要将其他数据库迁移至 PostgreSQL 数据库,或对历史遗留实例迁移与改造。 建设基于Prometheus / Grafana 技术栈的可观测性体系,数据大盘,可视化应用。 希望支持国产信创操作系统/国产信创 ARM 芯片架构,提供中文/本地化界面支持。 下云并寻求 RDS for PostgreSQL 的开源替代 —— 云中立,无供应商锁定的解决方案。 希望获取关于 Redis / ETCD / MinIO,以及 TimescaleDB / Citus 等扩展的专业支持。 希望将 Pigsty 作为 SaaS / PaaS / DBaaS 对外销售,或基于此发行版提供技术服务/云服务。 订阅计划 除了 开源版 专业版 企业版

开源免费 无规模限制,无质保承诺

许可协议:Apache-2.0

PG支持:18

架构支持:x86_64

OS支持:三系最新小版本

EL 9.7 Debian 12.13 Ubuntu 22.04.5 功能:核心模块

SLA:无 SLA 承诺

社区公益支持答疑:

支持:无人天支持选项

仓库:全球CF托管仓库

起售价:150,000 ¥ / 年 普通用户的默认之选

许可协议:商业许可证

PG支持:17, 18

架构支持:x86_64,Arm64

OS支持:五系大小版本

EL 8 / 9 兼容 Debian 12 Ubuntu 22 / 24 功能:所有模块 (信创除外)

SLA:工作日时效内响应

提供专家咨询服务:

支持:每年包含 1 人天

交付:标准离线软件包

仓库:中国大陆镜像站

起售价:400,000 ¥ / 年 严格 SLA 的关键场景

许可协议:商业许可证

PG支持:12 - 18+

架构支持:x86_64,Arm64

OS支持:按需定制

EL, Debian, Ubuntu 云上 Linux 操作系统 国产操作系统与ARM 功能:所有模块

SLA:7 x 24 (< 1h)

提供企业级专家咨询服务:

软件缺陷修复 疑难杂症分析 专家答疑解惑 备份合规建议 升级路径支持 性能瓶颈定位 年度架构评估 扩展插件收录 DBaaS & OEM 用例 支持:每年包含 2 人天

仓库:中国大陆镜像站

交付:定制离线软件包

信创:PolarDB-O 支持

Pigsty开源版 Pigsty 开源版使用 Apache-2.0 Issue 。

针对开源版本,我们提供 PostgreSQL 18 在 EL 9.6,Debian 12.11,Ubuntu 22.04.5 三个精准操作系统发行版最新小版本上的预制标准离线软件包(作为对开源的支持,同时提供 Debian 12 的 Arm64 离线软件包)。

使用 Pigsty 开源版本,可以让初级研发工程师 / 运维工程师拥有专业 DBA 70%+ 的能力,在缺少数据库专家的情况下,也能够轻松搭建一个高可用,高性能,易维护,安全可靠的 PostgreSQL 数据库集群。

代号 操作系统发行版版本 x86_64Arm64PG17 PG16 PG15 PG14 PG13 EL9 RHEL 9 / Rocky9 / Alma9 el9.x86_64U22 Ubuntu 22.04 (jammy) u22.x86_64D12 Debian 12 (bookworm) d12.x86_64d12.aarch64

Pigsty专业版 专业版订阅: 起售价格 ¥ 150,000 / 年

Pigsty 专业版订阅提供了完整的功能模块,以及对于 Pigsty 本身的质保。关于 PostgreSQL 本身与扩展插件的缺陷,我们将尽最大努力通过 PostgreSQL 全球开发者社区进行反馈与修复。

Pigsty 专业版构建于开源版基础之上,完全兼容开源版本的所有功能,并提供额外的功能模块,与更为宽广的数据库 / 操作系统版本兼容选项:我们将针对五个主流操作系统发行版的 所有小版本 提供构建选项。

Pigsty 专业版包含了对 最近两个 PostgreSQL 大版本(18,17)的支持,提供两个大版本中的所有可用的扩展插件,确保您可以通过滚动升级的方式,平滑迁移到最新的 PostgreSQL 大版本上。

Pigsty 专业版订阅允许您使用中国大陆镜像站点软件仓库,无需翻墙代理即可访问;同时我们将针对您使用的精准操作系统大小版本定制离线软件安装包,确保在断网环境下也能正常安装交付,做到自主可控。

Pigsty 专业版订阅提供了标准的专家咨询服务,包括疑难杂症分析,DBA 答疑解惑,备份合规建议等,我们承诺在工作日(5x8)时效内响应您的问题,并且每年提供 1 人天支持,以及可选的人天加购选项。

Pigsty 专业版使用商业许可证,提供额外的功能模块、技术支持与质保服务。

Pigsty 专业版的起售价格 ¥150,000 / 年 ,相当于 9 vCPU 的 AWS 高可用 RDS PG 年费, 或月薪 一万元 的初级运维工程师。

代号 操作系统发行版版本 x86_64Arm64PG17 PG16 PG15 PG14 PG13 EL9 RHEL 9 / Rocky9 / Alma9 el9.x86_64el9.aarch64EL8 RHEL 8 / Rocky8 / Alma8 / Anolis8 el8.x86_64el8.aarch64U24 Ubuntu 24.04 (noble) u24.x86_64u24.aarch64U22 Ubuntu 22.04 (jammy) u22.x86_64u22.aarch64D12 Debian 12 (bookworm) d12.x86_64d12.aarch64

Pigsty企业版 企业版订阅: 起售价格 ¥ 400,000 / 年

Pigsty 企业版订阅包含 Pigsty 专业版订阅提供的全部服务内容,和以下增值服务项:

Pigsty 企业版订阅提供最为广泛的数据库/操作系统版本支持范围,包括对过保操作系统(EL7, U20, D11),国产操作系统,云厂商操作系统,以及过保数据库大版本(从 PG 13 开始)的延长支持,以及对 Arm64 架构芯片的完整支持。

Pigsty 企业版订阅提供了信创,国产化解决方案,允许您在 Pigsty 中使用 PolarDB v2.0 (此内核许可需单独采购)内核替换原生 PostgreSQL 内核,以满足国产化合规要求。

Pigsty 企业版订阅提供了更高标准的企业级咨询服务,承诺 7x24 提供 (< 1h) 的响应时间 SLA,并可提供更多种类的咨询支持:版本升级,性能瓶颈定位,年度架构评估,扩展插件收录等。

Pigsty 企业版订阅每年自带 2 人天支持,以及可选的人天加购选项,用于解决各种更为棘手复杂耗时的问题。

Pigsty 企业版允许您将 Pigsty 用于 DBaaS 用途,建设云数据库服务对外出售。

Pigsty 企业版的起步价格为 ¥400,000 / 年 ,相当于 24 vCPU 的 AWS 高可用 RDS 年费,或月薪 三万元 的运维专家。

代号 操作系统发行版版本 x86_64PG17 PG16 PG15 PG14 PG13 PG12 Arm64PG17 PG16 PG15 PG14 PG13 PG12 EL9 RHEL 9 / Rocky9 / Alma9 el9.x86_64el9.arm64EL8 RHEL 8 / Rocky8 / Alma8 / Anolis8 el8.x86_64el8.arm64U24 Ubuntu 24.04 (noble) u24.x86_64u24.arm64U22 Ubuntu 22.04 (jammy) u22.x86_64u22.arm64D12 Debian 12 (bookworm) d12.x86_64d12.arm64D11 Debian 11 (bullseye) d12.x86_64d11.arm64U20 Ubuntu 20.04 (focal) d12.x86_64u20.arm64EL7 RHEL7 / CentOS7 / UOS … d12.x86_64el7.arm64

Pigsty订阅说明 功能差异

Pigsty 专业版/企业版相比开源版本,包含以下额外功能:

命令行管理工具 : 解锁 Pigsty 命令行工具( pig )的完整功能系统定制能力 :针对精确的主流Linux操作系统发行版大小版本提供预制的离线安装包离线安装能力 :在没有互联网访问的环境中(断网环境)实现 Pigsty 的完整安装PG内核多版本 :允许用户自由指定并安装 PostgreSQL 生命周期内大版本的内核(13 - 17)内核替换能力 :允许用户使用其他 PostgreSQL 系兼容内核,替换原生 PG 内核,以及离线安装这些内核的能力扩展支持能力 :针对 451 个可用 PG Extension,提供 PG 13-18 在主流操作系统上开箱即用的安装能力。完整功能模块 :提供所有功能模块:Supabase MinIO DuckDB Kafka Kubernetes, VictoriaMetrics & VictoriaLogs 国产操作系统支持 :提供国产信创操作系统支持选项(仅限企业版订阅 )国产ARM架构支持 :提供国产 ARM64 架构支持选项(仅限企业版订阅 )中国大陆镜像仓库 :无需科学上网即可顺畅安装,提供境内 YUM/APT 仓库镜像与 DockerHub 访问代理。中文界面支持 :监控系统中文版界面支持(Beta)付费模式

Pigsty 订阅采用按年付费的模式,签订合同后,从合同约定日起计算一年的有效期。订阅合同到期前如果继续打款则视为自动续订。

连续订阅有折扣,第一次续签(第二年)享受 95 折优惠,第二次以及后续的续签享受订阅费用 9 折优惠,一次性订阅三年以上整体费用享受 85 折优惠。

在年度订阅合同终止后,您可以选择不续签订阅服务,Pigsty 将不再提供软件更新,技术支持,咨询服务,但您仍然可以继续使用已经安装版本的 Pigsty 专业版软件。

如果您订阅了 Pigsty 专业服务并选择不续订,在重新订阅时 无需 补齐中断期间的订阅费用,但所有折扣与优惠将重置。

Pigsty 的定价策略确保用户物有所值 —— 您可以立即获得顶尖 DBA 的数据库架构建设方案与管理最佳实践,并由其提供咨询答疑与服务支持兜底;

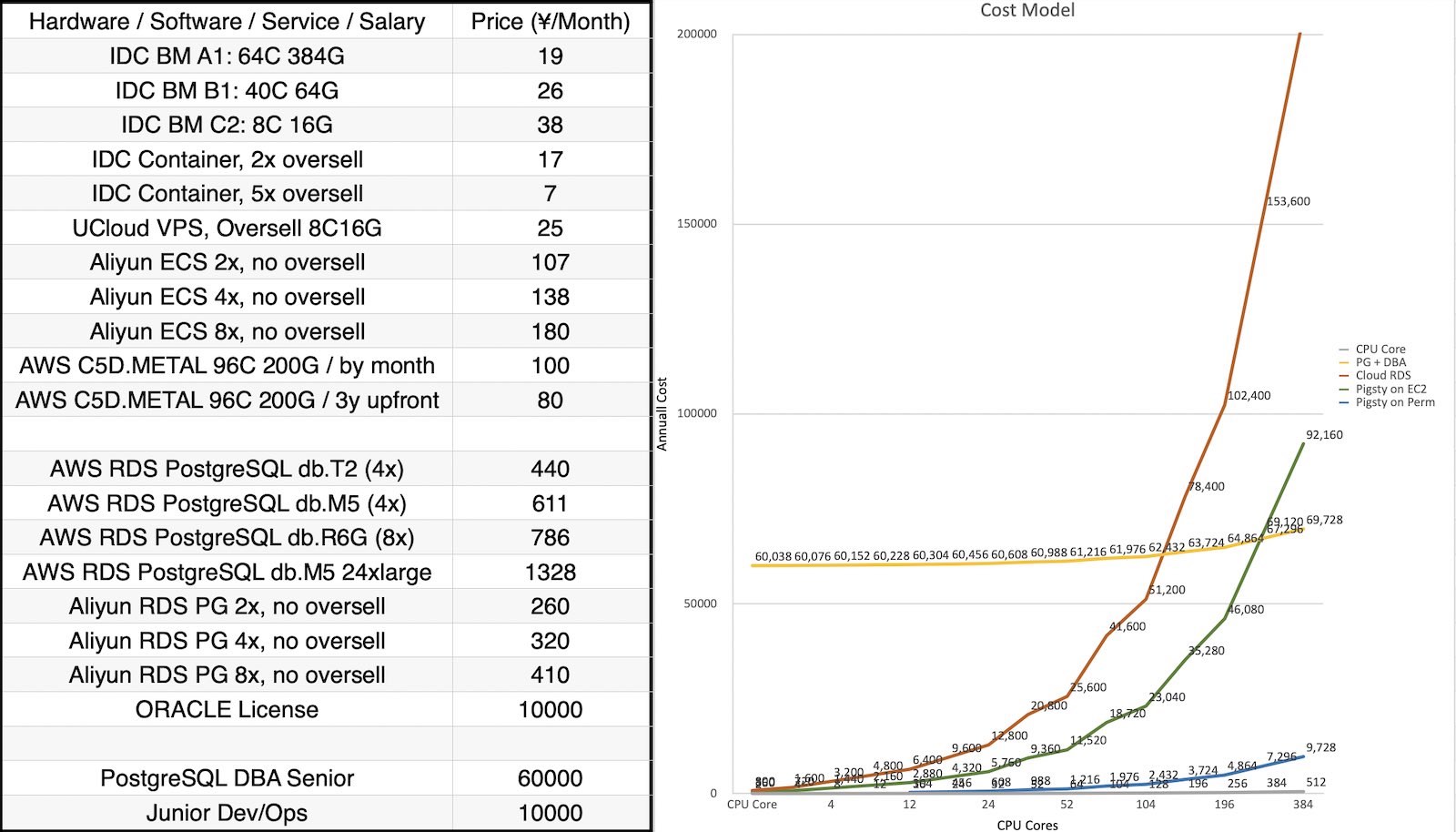

而付出的成本相比于全职雇佣数据库专家或使用云数据库极具竞争力。以下是市场上 企业级数据库专业服务市场定价参考 :

体面数据库专业服务的公允价格是 1 ~ 2 万元 / 年 ,计费单位为 vCPU ,即一个 CPU 线程(1 Intel 核 = 2 vCPU 线程)。

而 Pigsty 提供国内顶尖的 PostgreSQL 专家服务,并采用 按节点计费 的模式,在当下常见的高核数服务器节点上,能为用户带来无可比拟的 降本增效 体验。

Pigsty专家服务 除了 Pigsty 订阅,Pigsty 还提供按需采购的 Pigsty x PostgreSQL 专家服务 —— 业界顶级数据库专家坐堂问诊。

专家顾问:300,000 ¥ / 三年

在三年内,提供 10 次关于 PostgreSQL 与 Pigsty 的复杂案例处理,以及不限量答疑。

专家支持:30,000 ¥ / 人·天

业界顶级专家现场支持,可用于架构咨询,故障分析,问题排查,数据库体检,监控解读,迁移评估,教学培训,上下云参谋等连续耗时场景。

专家咨询:3000 ¥ / 例

咨询任何您想要了解的问题,关于 Pigsty, PostgreSQL,数据库,云计算,AI……

数据库老司机,云计算泥石流与您分享行业顶级洞察、认知与研判。

挂专家号:300 ¥ / 问题

给出一个关于 PostgreSQL / Pigsty / 数据库相关的问题的快速诊断意见与答复,不超过 5 分钟。

服务主体 Pigsty 目前由作者 冯若航 独资运营维护,商业主体为:

海南诸夏云数据有限公司 / 91460000MAE6L87B94 海口龙华辟技数据中心 / 92460000MAG0XJ569B 海口龙华越航科技中心 / 92460000MACCYGBQ1N PIGSTY® 与 PGSTY® 为海口龙华越航科技中心的注册商标。

商务咨询请发送邮件至 rh@vonng.com RuohangFeng。

Pigsty 是奇绩创坛 S22 被投项目,原主体 磐吉云数(北京)科技有限责任公司 已经清算剥离 Pigsty 业务,与 Pigsty 无关。

2.11 - 常见问题 解答关于 Pigsty 项目本身的常见问题。

Pigsty 是什么,不是什么? Pigsty 是一个 PostgreSQL 数据库发行版,本地优先的开源 RDS 云数据库解决方案。

Pigsty 不是数据库管理系统(DBMS),而是管理 DBMS 的工具,发行版,解决方案,与最佳实践。

类比:数据库是车,那么 DBA 是司机,RDS 是出租车服务,Pigsty 则是自动驾驶软件。

Pigsty 解决什么问题? 用好数据库的能力 极为稀缺:要么高薪聘请数据库专家自建(雇司机),或从云厂商以天价租赁 RDS(打车),但现在你有新的选项:Pigsty(自动驾驶)。

Pigsty 帮用户用好数据库:让用户在没有 DBA 的情况下,以不到 RDS 1 / 10 的成本,自建质量效率更优的本地云数据库服务!

Pigsty 的目标用户是谁? Pigsty 有两类典型目标用户,基本盘是 中大型公司 超大规模自建企业级/生产级 PostgreSQL RDS / DBaaS 服务。

Pigsty 通过极致的可定制性,可以实现最苛刻场景的数据库管理需求,并提供企业级的支持与服务保障。

与此同时,Pigsty 也针对个人开发者,缺乏 DBA 中小企业以及开源社区提供 “开箱即用” 的 PG RDS 自建方案。

Pigsty 为什么能帮您用好数据库? Pigsty 沉淀了顶尖专家在最复杂,最大规模的甲方 PostgreSQL 场景中打磨得到的经验与最佳实践,产品化为可复制的软件:

一次性解决扩展安装,高可用,链接池,监控,备份恢复,参数优化,IaC 批量管理,一键安装,自动化运维等诸多问题。提前规避诸多陷阱,避免重复踩坑。

Pigsty 为何比 RDS 好用? Pigsty 提供远超 RDS 的特性集与基础设施支持,包括 451 扩展插件与 8+ 内核支持。

Pigsty 提供 PG 生态中独一无二的专业级监控系统,与久经复杂场景打磨考验的架构最佳实践,简单易用。

且用探探,苹果,阿里等顶级甲方场景打磨而成,用激情与热爱持续浇灌,深度与成熟度绝非 RDS 大锅饭可比。

Pigsty 为何比 RDS 省钱? Pigsty 允许您使用 10 ¥/核·月的纯硬件资源,运行 400¥-1400¥/核·月的 RDS 云数据库,并省去 DBA 的工资。通常,成规模的 Pigsty 部署总拥有成本(TCO)能比 RDS 低 90% 以上。

Pigsty 能够同时降低软件许可/服务/人力的开销,自建无需加人,让您将成本花在刀刃上。

Pigsty 对研发有什么帮助? Pigsty 整合了 PG 生态最全的扩展(451),提供了 All in PG 解决方案:单一组件替代 Redis, Kafka, MySQL, ES, 向量数据库, OLAP / 大数据分析等专用组件。

极大提高研发效能与敏捷性的同时降低复杂度成本,而且研发能在 Pigsty 的加持下实现自助管理,自主 DevOps,无需 DBA。

Pigsty 对运维有什么帮助? Pigsty 故障自愈的高可用架构确保硬件故障无需当场处理,让运维与 DBA 睡个好觉;监控助力问题分析与性能优化;IaC 赋能超大规模集群自动化管理。

运维在 Pigsty 加持下能兼职 DBA ,而 DBA 则可以跳过系统建设阶段,节省大量工时并专注于高价值工作,或喝茶看报,学习PG。

Pigsty 的作者是谁? Pigsty 主体由冯若航一人开发,这是一位专注于 PostgreSQL 领域 10 年的开源贡献者,数据库专家与布道师,

曾任职于阿里,探探,苹果,全栈专家。现为一人公司创始人,提供专业咨询服务。

同时他也是技术 KOL,微信数据库个人公众号榜首 《非法加冯》 的主理人,全网粉丝六万+。

Pigsty 的生态位与影响力如何? Pigsty 全球 PostgreSQL 生态中最有影响力的中国开源项目,共有约十万用户,一半来自海外。

Pigsty 也是 PostgreSQL 生态最活跃的开源项目之一,目前在扩展分发与监控系统上占据碾压性优势。

PGEXT.Cloud

Pigsty 目前是 PostgreSQL 生态的主要发行版之一,也是云厂商 RDS 的挑战者,目前已经广泛应用于军工,政企,医疗,互联网,金融,制造业等各个行业。

Pigsty 适合什么规模的客户? Pigsty 源于超大规模 PostgreSQL 自动化管理的需求,但已针对易用性进行深度优化,缺乏专业 DBA 能力的个人开发者与中小型企业也可以轻松上手使用。

最大规模部署为 25K vCPU,450万QPS,六年+,最小规模部署可完整运行于 1c1g 虚拟机上作为 Demo / Devbox 使用。

Pigsty 提供哪些能力? Pigsty 专注于整合 PostgreSQL 生态,提供 PostgreSQL 的最佳实践,但同时也支持一系列与 PostgreSQL 配合良好的开源软件。例如:

Etcd, Redis, MinIO, DuckDB, Prometheus FerretDB, Babelfish, IvorySQL, PolarDB, OrioleDB OpenHalo, Supabase, Greenplum, Dify, Odoo, … Pigsty 适用于哪些场景? 运行大规模 PostgreSQL 集群用于业务 自建 RDS,对象存储,缓存,数仓,Supabase, … 自建 Odoo,Dify,Wiki,GitLab 等企业级应用 运行监控基础设施,监控现有数据库与主机 同时组合使用多种 PG 扩展插件 大屏开发与交互式数据应用 Demo,数据可视化,Web 建站 Pigsty 开源免费吗? Pigsty 是 100% 的开源软件 + 自由软件,在遵循开源许可证的前提下,您可以将其免费地,自由的用于各种商业目的。

我们珍视软件自由,对于非 DBaaS / OEM 用例,我们执行更为宽松的等效 Apache 2.0 许可证。请参阅许可证以获取更多详细信息。

Pigsty 提供商业支持吗? Pigsty 软件本身开源免费,并提供丰俭由人的商业订阅,为 Pigsty & PostgreSQL 提供质保。

订阅提供更宽广的 OS/PG/芯片架构支持范围,以及专家咨询与支持。

Pigsty 商业订阅交付业界顶尖的管理/技术经验/解决方案,

帮助您节省宝贵的时间,替您扛雷,并为疑难杂症兜底。

Pigsty 支持国产信创吗? Pigsty 软件本身不属于数据库,不受信创名录限制,且已有多个部队用例。但 Pigsty 开源版不提供任何形式的信创支持。

商业版订阅提供与阿里云合作的国产信创解决方案,支持使用具有信创资质的 PolarDB-O(需单独采购)作为 RDS 内核,能够运行于信创操作系统/芯片环境。

Pigsty 可以换 Logo 贴牌为自己的产品吗? 再分发 Pigsty 时,您必须保留原作品中的版权声明、专利声明、商标声明和归属声明,

并且需要在修改的文件中附上显著的变更说明,同时保留 LICENSE 文件的内容。

在此前提下,您可以更换 PIGSTY 的 Logo 与商标,但不得宣传为 “自己原创的作品”。

我们在企业版本中提供对 OEM 与贴牌的商业授权支持。

Pigsty 的服务主体 Pigsty 是奇绩创坛 S22 被投项目,原主体 磐吉云数(北京)科技有限责任公司 已经清算剥离 Pigsty 业务,与 Pigsty 无关。

Pigsty 目前由作者冯若航个人独资运营维护,商业主体为:

海南诸夏云数据有限公司 / 91460000MAE6L87B94 海口龙华辟技数据中心 / 92460000MAG0XJ569B 海口龙华越航科技中心 / 92460000MACCYGBQ1N PIGSTY® 与 PGSTY® 为海口龙华越航科技中心的注册商标。

2.12 - 发布注记 Pigsty 历史版本发布说明

Pigsty 当前的最新稳定版本为 v4.2.0

版本 发布日期 摘要 发布页面 v4.2.0 2026-02-28 例行小版本更新,六大 PG 内核集中更新 v4.2.0 v4.1.0 2026-02-12 大小版本更新支持,Agent-Native CLI,默认防火墙安全策略收紧 v4.1.0 v4.0.0 2026-01-28 Victoria 可观测性,安全加固,JUICE/VIBE 模块,容器支持,Apache-2.0 v4.0.0 v3.7.0 2025-12-02 PG18 成为默认,437 个扩展,EL10 与 Debian13 支持,PGEXT.CLOUD v3.7.0 v3.6.1 2025-08-15 例行 PG 小版本更新,PGDG 中国区域镜像,EL9,D13 存根 v3.6.1 v3.6.0 2025-07-30 pgactive,MinIO / ETCD 改进,安装简化,配置梳理 v3.6.0 v3.5.0 2025-06-16 PG18 beta,421 扩展,监控升级,代码重构 v3.5.0 v3.4.1 2025-04-05 OpenHalo & OrioleDB,MySQL兼容,pgAdmin改进 v3.4.1 v3.4.0 2025-03-30 备份改进,自动证书,AGE,Ivory 全平台,本地化,架构与参数改进 v3.4.0 v3.3.0 2025-02-24 404 扩展,扩展目录,App 剧本,Nginx 定制,DocumentDB 支持 v3.3.0 v3.2.2 2025-01-23 390扩展,Omnigres支持,Mooncake,Citus13与PG17支持 v3.2.2 v3.2.1 2025-01-12 350扩展,Ivory4,Citus强化,Odoo模板 v3.2.1 v3.2.0 2024-12-24 扩展管理 CLI ,Grafana 强化,ARM64 扩展补完 v3.2.0 v3.1.0 2024-11-24 PG 17 升默认大版本,配置简化,Ubuntu24与ARM 支持,Supabase,MinIO 改进 v3.1.0 v3.0.4 2024-10-30 PG 17 扩展,OLAP 全家桶,pg_duckdb v3.0.4 v3.0.3 2024-09-27 PostgreSQL 17,Etcd 运维优化,IvorySQL 3.4,PostGIS 3.5 v3.0.3 v3.0.2 2024-09-07 精简安装模式,PolarDB 15支持,监控视图更新 v3.0.2 v3.0.1 2024-08-31 例行问题修复,Patroni 4支持,Oracle兼容性改进 v3.0.1 v3.0.0 2024-08-25 333个扩展插件,可插拔内核,MSSQL,Oracle,PolarDB 兼容性 v3.0.0 v2.7.0 2024-05-20 扩展大爆炸,新增20+强力扩展插件,与多款Docker应用 v2.7.0 v2.6.0 2024-02-28 PG 16 作为默认大版本,引入 ParadeDB 与 DuckDB 等扩展 v2.6.0 v2.5.1 2023-12-01 例行小版本更新,PG16重要扩展支持 v2.5.1 v2.5.0 2023-09-24 Ubuntu/Debian支持:bullseye, bookworm, jammy, focal v2.5.0 v2.4.1 2023-09-24 Supabase/PostgresML支持与各种新扩展:graphql, jwt, pg_net, vault v2.4.1 v2.4.0 2023-09-14 PG16,监控RDS,服务咨询支持,新扩展:中文分词全文检索/图/HTTP/嵌入等 v2.4.0 v2.3.1 2023-09-01 带HNSW的PGVector,PG 16 RC1, 文档翻新,中文文档,例行问题修复 v2.3.1 v2.3.0 2023-08-20 主机VIP, ferretdb, nocodb, MySQL存根, CVE修复 v2.3.0 v2.2.0 2023-08-04 仪表盘 & 置备重做,UOS 兼容性 v2.2.0 v2.1.0 2023-06-10 支持 PostgreSQL 12 ~ 16beta v2.1.0 v2.0.2 2023-03-31 新增 pgvector 支持,修复 MinIO CVE v2.0.2 v2.0.1 2023-03-21 v2 错误修复,安全增强,升级 Grafana 版本 v2.0.1 v2.0.0 2023-02-28 架构大升级,兼容性、安全性、可维护性显著增强 v2.0.0 v1.5.1 2022-06-18 Grafana 安全性修复 v1.5.1 v1.5.0 2022-05-31 Docker 应用程序支持 v1.5.0 v1.4.1 2022-04-20 错误修复 & 英文文档完整翻译 v1.4.1 v1.4.0 2022-03-31 MatrixDB 支持,分离 INFRA/NODES/PGSQL/REDIS模块 v1.4.0 v1.3.0 2021-11-30 PGCAT 重整 & PGSQL 增强 & Redis Beta支持 v1.3.0 v1.2.0 2021-11-03 默认 PGSQL 版本升级至 14 v1.2.0 v1.1.0 2021-10-12 主页, JupyterLab, PGWEB, Pev2 & pgbadger v1.1.0 v1.0.0 2021-07-26 v1 正式版, 监控系统重整 v1.0.0 v0.9.0 2021-04-04 Pigsty 图形界面, 命令行界面, 日志集成 v0.9.0 v0.8.0 2021-03-28 服务置备,定制对外暴露的数据库服务 v0.8.0 v0.7.0 2021-03-01 仅监控部署,监控现有 PostgreSQL 实例 v0.7.0 v0.6.0 2021-02-19 架构增强,将PG与Consul解耦 v0.6.0 v0.5.0 2021-01-07 支持在配置中定义业务数据库/用户 v0.5.0 v0.4.0 2020-12-14 支持 PostgreSQL 13,添加官方文档 v0.4.0 v0.3.0 2020-10-22 虚拟机置备方案正式定稿 v0.3.0 v0.2.0 2020-07-10 PG监控系统第六版正式发布 v0.2.0 v0.1.0 2020-06-20 在生产仿真测试环境中验证通过 v0.1.0 v0.0.5 2020-08-19 离线安装模式:无需互联网访问即可交付 v0.0.5 v0.0.4 2020-07-27 将 Ansible 剧本重构为 Role v0.0.4 v0.0.3 2020-06-22 接口设计改进 v0.0.3 v0.0.2 2020-04-30 首次提交 v0.0.2 v0.0.1 2019-05-15 概念原型 v0.0.1

v4.2.0 亮点特性

离线小版本跟进 PostgreSQL 紧急小版本:18.3、17.9、16.13、15.17、14.22。 PostgreSQL 扩展总数达到 461 个。 PG 内核更新:Babelfish、AgensGraph、pgEdge、OriolePG、OpenHalo、Cloudberry。 Babelfish 模板切换到 Pigsty 自建维护的 PG17 兼容版本,移除对 WiltonDB 仓库的依赖。 更新 Supabase 镜像与自建模板至最新版本,使用自行维护的 MinIO 分支 pgsty/minio 主要变更

mssql 模板切换到 Babelfish PG17 默认:pg_version: 17,pg_packages: [babelfish, pgsql-common, sqlcmd],并移除额外 mssql repo 依赖。pg_home_map 调整:mssql 指向 /usr/babelfish-$v/,gpsql 指向 /usr/local/cloudberry,统一内核路径语义。package_map 新增 cloudberry 独立映射,并修复 babelfish* 组件别名到版本化包名(RPM/DEB)。Redis 默认主目录从 /data 调整为 /data/redis;部署阶段阻止旧默认值继续使用,redis_remove 增加旧路径兼容清理。 configure 支持 -o 绝对路径输出并自动建目录;区域探测改为三态(境内/境外/离线回退),修复 behind_gfw() 卡住问题。修复 Debian/Ubuntu 默认仓库 URL(updates/backports/security 对应关系)与中国区镜像组件字段,避免节点初始化拉包失败。 Supabase 应用栈例行升级(含 PostgREST 14.5、Vector 0.53.0 等)并补齐 S3 协议访问密钥变量。 Rich/Sample 模板显式补全 dbuser_meta 默认值;node.sh 中 systemd 自动补全逻辑简化。 pgbackrest 初始化增加重试(2 次、间隔 5 秒),缓解 stanza-create 与 archive-push 锁竞争失败。Vibe 模板更新:内置 @anthropic-ai/claude-code、@openai/codex、happy-coder 等 npm 工具,默认示例补入 age 扩展。 PG 软件更新

PostgreSQL 18.3, 17.9, 16.13, 15.17, 14.22 RPM Changelog 2026-02-27 DEB Changelog 2026-02-27 核心升级:timescaledb 2.25.0 -> 2.25.1,citus 14.0.0-3 -> 14.0.0-4,pg_search -> 0.21.9 新增/重建:pgedge 17.9,spock 5.0.5,lolor 1.2.2,snowflake 2.4,babelfish 5.5.0,cloudberry 2.0.0 内核配套:oriolepg 17.11 -> 17.16,orioledb beta12 -> beta14,openhalo 14.10 -> 1.0(14.18) 包名 旧版本 新版本 备注 timescaledb2.25.0 2.25.1 citus14.0.0-3 14.0.0-4 使用最新官方版本重新构建 age1.7.0 1.7.0 新增 PG 17 的 1.7.0 版本支持 pgmq1.10.0 1.10.1 当前没有该扩展包 pg_search0.21.7 / 0.21.6 0.21.9 RPM/DEB 旧版本不同 oriolepg17.11 17.16 OriolePG 内核更新 orioledbbeta12 beta14 配套 OriolePG 17.16 openhalo14.10 1.0 更新并重命名,14.18 pgedge- 17.9 新增多主边缘分布式内核 spock- 5.0.5 新增,pgEdge 核心扩展 lolor- 1.2.2 新增,pgEdge 核心扩展 snowflake- 2.4 新增,pgEdge 核心扩展 babelfishpg- 5.5.0 新增 BabelfishPG 包组 babelfish- 5.5.0 新增 Babelfish 兼容包 antlr4-runtime413- 4.13 新增 Babelfish 依赖运行时 cloudberry- 2.0.0 仅 RPM 构建 pg_background- 1.8 仅 DEB 构建

基础设施软件更新

名称 旧版本 新版本 grafana12.3.2 12.4.0 prometheus3.9.1 3.10.0 mongodb_exporter0.47.2 0.49.0 victoria-metrics1.135.0 1.136.0 victoria-metrics-cluster1.135.0 1.136.0 vmutils1.135.0 1.136.0 victoria-logs1.45.0 1.47.0 vlagent1.45.0 1.47.0 vlogscli1.45.0 1.47.0 loki3.6.5 3.6.7 promtail3.6.5 3.6.7 logcli3.6.5 3.6.7 grafana-victorialogs-ds0.24.1 0.26.2 grafana-victoriametrics-ds0.21.0 0.23.1 grafana-infinity-ds3.7.0 3.7.2 redis_exporter1.80.2 1.81.0 etcd3.6.7 3.6.8 dblab0.34.2 0.34.3 tigerbeetle0.16.72 0.16.74 seaweedfs4.09 4.13 rustfs1.0.0-alpha.82 1.0.0-alpha.83 uv0.10.0 0.10.4 kafka4.1.1 4.2.0 npgsqlrest3.7.0 3.10.0 postgrest14.4 14.5 caddy2.10.2 2.11.1 rclone1.73.0 1.73.1 pev21.20.1 1.20.2 genai-toolbox0.25.0 0.27.0 opencode1.1.59 1.2.15 claude2.1.37 2.1.59 codex0.104.0 0.105.0 code1.109.2 1.109.4 code-server4.108.2 4.109.2 nodejs24.13.1 24.14.0 pig1.1.2 1.3.0 stalwart- 0.15.5 maddy- 0.8.2

API变化

pg_mode 增加 agens 与 pgedge。mssql 默认配置改为 pg_version: 17 + pg_packages: [babelfish, pgsql-common, sqlcmd]。pg_home_map 与 package_map 的内核/包别名映射更新(Babelfish / OpenHalo / IvorySQL / Cloudberry / pgEdge 家族)。redis_fs_main 默认值改为 /data/redis,并新增部署保护与移除兼容策略。configure 输出路径与区域探测逻辑更新,增加离线回退告警;SSH 探测统一超时参数。grafana.ini.j2 跟进 Grafana 12.4 新配置项与废弃项调整。兼容性说明

存量 Redis 配置如果仍使用 redis_fs_main: /data,请先改为 /data/redis 再执行部署。 Grafana 12.4 后 data link 合并行为变化,本版本已将关键链接下沉到字段 override 规避冲突;如有自定义看板,建议同步检查。 26 个提交 ,122 文件变更,+2,116 / -2,215 行(v4.1.0..v4.2.0,2026-02-15 ~ 2026-02-28)

校验和

24a90427a7e7351ca1a43a7d53289970 pigsty-v4.2.0.tgz

d980edf5eeb0419d4f1aa7feb0100e14 pigsty-pkg-v4.2.0.d12.aarch64.tgz

24bc237d841457fbdcc899e1d0a3f87e pigsty-pkg-v4.2.0.d12.x86_64.tgz

e395b38685e2ecbe9c3a2850876d9b7b pigsty-pkg-v4.2.0.d13.aarch64.tgz

c5c8776f9bead9f29528b26058801f83 pigsty-pkg-v4.2.0.d13.x86_64.tgz

28ea40434bd06135fc8adc0df1c8407d pigsty-pkg-v4.2.0.el10.aarch64.tgz

58ad715ac20dc1717d1687daecfcf625 pigsty-pkg-v4.2.0.el10.x86_64.tgz

008f955439ea311581dd0ebcf5b8bd34 pigsty-pkg-v4.2.0.el8.aarch64.tgz

2acfd127a517b09f07540f808fe9547a pigsty-pkg-v4.2.0.el8.x86_64.tgz

58e62a92f35291a40e3f05839a1b6bc4 pigsty-pkg-v4.2.0.el9.aarch64.tgz

d311bfdf5d5f60df5fe6cb3d4ced4f9c pigsty-pkg-v4.2.0.el9.x86_64.tgz

c98972fe9226657ac1faa7b72a22498b pigsty-pkg-v4.2.0.u22.aarch64.tgz

44a174ee9ba030ac1ea386cf0b85f6e7 pigsty-pkg-v4.2.0.u22.x86_64.tgz

143e404f4681c7d0bbd78ef7982cd652 pigsty-pkg-v4.2.0.u24.aarch64.tgz

00dfa86f477f3adff984906211ab3190 pigsty-pkg-v4.2.0.u24.x86_64.tgz

v4.1.0 curl https://pigsty.cc/get | bash -s v4.1.0

72 个提交 ,252 文件变更,+5,744 / -5,015 行(v4.0.0..v4.1.0,2026-02-02 ~ 2026-02-13)

亮点特性

新增 7 个扩展,总计 451 个扩展支持。 pig 从传统脚本接口升级为 Agent-Native CLI (1.0.0 -> 1.1.0),支持主动暴露上下文并提供 JSON/YAML 输出。pig 新增 PostgreSQL / OS 大小版本更新 统一能力(覆盖 major/minor 升级流程)。pg_exporter 升级到 v1.2.0 (1.1.2 -> 1.2.0),并修复 PG17/18 指标链路与单位换算。防火墙默认安全策略更新:node_firewall_mode 默认改为 zone,node_firewall_public_port 默认从 [22,80,443,5432] 收敛为 [22,80,443]。 PostgreSQL 小版本更新:18.2、17.8、16.12、15.16、14.21。 EL 默认小版本更新到 EL 9.7 / EL 10.1,Debian 默认小版本更新到 12.13 / 13.3。 集中修复 PGSQL / PGCAT Grafana 看板可用性:$dsn 动态数据源、schema 级跳转、Age 指标、链接映射与语义一致性。 新增 Mattermost 一键应用模板,支持数据库、目录、门户与可选 PGFS/JuiceFS 方案。 重构 infra-rm 卸载逻辑,新增 deregister 分段清理能力,可回收 Victoria target、Grafana datasource、Vector 日志配置。 优化 PostgreSQL 默认 autovacuum 阈值,减少小表高频 vacuum/analyze。 修复 FD 上限链路:新增 fs.nr_open=8M 并统一 LimitNOFILE=8M,避免 systemd/setrlimit 导致服务启动失败。 调整 Vibe 默认体验:Jupyter 默认关闭,Claude Code 改由 npm 包统一安装管理。 版本更新

Pigsty 版本:v4.0.0 -> v4.1.0 pig CLI:1.0.0 -> 1.1.0(Agent-Native + 大小版本更新支持)pg_exporter:1.1.2 -> 1.2.0默认 EL 小版本:9.6/10.0 -> 9.7/10.1 默认 Debian 小版本:12.12/13.1 -> 12.13/13.3 扩展更新

RPM Changelog 2026-02-12 DEB Changelog 2026-02-12 timescaledb 2.24.0 -> 2.25.0 pg_search 0.21.4 -> 0.21.7 pgmq 1.9.0 -> 1.10.0 pg_textsearch 0.4.0 -> 0.5.0 pljs 1.0.4 -> 1.0.5 pg_track_optimizer 0.9.1(新增) nominatim_fdw 1.1.0(新增) pg_utl_smtp 1.0.0(新增) pg_strict 1.0.2(新增) pgmb 1.0.0(新增) pg_pwhash(新增支持) informix_fdw(新增支持) INFRA 组件版本

Infra Changelog 2026-02-12

软件包 版本 软件包 版本 victoria-metrics 1.135.0 victoria-logs 1.45.0 vector 0.53.0 grafana 12.3.2 alertmanager 0.31.1 etcd 3.6.7 duckdb 1.4.4 pg_exporter 1.2.0 pig 1.1.0 claude 2.1.37 opencode 1.1.59 uv 0.10.0 code-server 4.108.2 caddy 2.10.2 hugo 0.155.2 cloudflared 2026.2.0 headscale 0.28.0

API变化

io_method / io_workers 模板生效条件从 pg_version >= 17 更正为 pg_version >= 18。idle_replication_slot_timeout / initdb --no-data-checksums 的 PG18 守卫条件修正。maintenance_io_concurrency 生效范围放宽至 PG13+。autovacuum_vacuum_threshold:oltp/crit/tiny 从 50 提升到 500,olap 提升到 1000。autovacuum_analyze_threshold:oltp/crit/tiny 从 50 提升到 250,olap 提升到 500。checkpoint_completion_target 默认从 0.90 提升到 0.95。Node tuned 模板新增 fs.nr_open=8388608,并统一 fs.file-max / fs.nr_open / LimitNOFILE 层级关系。 postgres、patroni、minio 的 systemd LimitNOFILE 从 16777216 调整为 8388608。 node_sysctl_params 默认加入 fs.nr_open: 8388608。node_firewall_mode 默认值从 none 调整为 zone:默认启用防火墙,内网信任,公网仅开放 node_firewall_public_port;如需完全自管防火墙请设为 none。node_firewall_public_port 默认值从 [22,80,443,5432] 调整为 [22,80,443],数据库端口 5432 需要按需显式添加。注意防火墙规则为“只增不删”,存量节点若已放行 5432 需手工移除;单机体验模板(如 meta / vibe)会显式覆盖并保留 5432 以便远程使用。bin/validate 新增 pg_databases[*].parameters 与 pg_hba_rules[*].order 校验支持,并修复 HBA 错误未正确返回失败的问题。infra-rm.yml 新增 deregister、config、env 等分段标签。Vibe 默认 jupyter_enabled=false,npm_packages 默认加入 @anthropic-ai/claude-code、happy-coder,并新增 CLAUDE_CODE_EXPERIMENTAL_AGENT_TEAMS=1。 PgBouncer 参数别名收敛:pool_size_reserve -> pool_reserve,pool_max_db_conn -> pool_connlimit。 兼容性修复(去重归并)

注:同一问题的重复回补(反复引入后再次修复)仅计一次,以下按问题域归并。 修复 Redis replicaof 判空逻辑与 systemd 停止行为。 修复 pg_migration 脚本 schema/table/sequence 全限定、标识符 quoting 与日志格式字符串安全问题。 修复 pgsql role handler 重启对象与变量使用错误。 修复 blackbox 配置文件名清理项与 pgAdmin pgpass 文件格式。 pg_exporter 启动改为非阻断,避免 exporter 启动失败拖慢主流程。VIP 地址解析逻辑简化,未显式 CIDR 时默认掩码 24。 MinIO 健康检查重试从 3 提升到 5。 节点主机名设置改用 hostname 模块,替代 shell 调用。 修复 app/electric 与 app/pg_exporter 的 .env 格式为标准 KEY=VALUE。 修复 pigsty.yml 的 pg_crontab 语法错误。 更新 ETCD 文档,明确默认 TLS 与可选 mTLS 的语义差异。 修复 repo-add 参数传递、Debian 中国镜像组件兼容性、bin/psql.py 的 Python3 兼容性。 加固 redis exporter 凭据文件权限,减少敏感信息暴露风险。 pgsql-user.yml 隐藏用户凭据日志输出并对敏感步骤启用 no_log。修复 pg_monitor 注册 Victoria target 的 gate 条件。 pg_remove 备份清理改为集群级目录,避免误删其他集群备份。提交清单(v4.0.0..v4.1.0,共 72,2026-02-02 ~ 2026-02-13)

7410de401 v4.1.0 release

fa31213ce conf(node): default firewall to zone with single-node 5432 override

bb8382c58 update default extension list to 451

770d01959 hide user credential in pgsql-user playbook

7219a896c pg_monitor: fix victoria registration gate conditions

084c98432 remove one cluster in backup dir during pg_remove

7005617f1 pgsql: drop legacy pgbouncer pool parameter aliases

f8165a886 docs(roles): fix typos and align juice role documentation

06a589218 chore(meta): normalize platform versions for current lint schema

e0a208248 fix(roles): harden redis exporter file permissions

fd0469881 terraform/vagrant: parameterize aliyun region/zone, fix vagrant scripts

74c59aabe grafana: fix dashboard links, descriptions, and overrides

443e58724 conf: clean legacy params and fix template references

536c4b39d adjust grafana dashboard dead links

f3b9866ce grafana(pgsql): fix panel typos and title consistency

bcb69be11 grafana(pgsql): fix drilldown links and variable mappings

1ce4374a1 grafana: fill pglog panel titles and normalize wording

2d127f9f4 grafana: fix minio traffic metrics and pigsty dashboard links

9d3ca0118 grafana: align victoria instance dashboards with query scope

55bc61622 grafana: fix infra dashboard copy, links, and table semantics

607b75535 grafana(node): fix panel drilldown links and clean dashboard metadata

1321de532 grafana(redis): fix dashboard links and blocked-clients panel semantics

91e0c8437 fix(grafana): correct Redis alert drill-down dashboard links

0fde78c02 fix(tooling): improve Python3 compatibility and enforce vagrant scale lower bound

fa3454a52 fix(bootstrap): use Debian-compatible components for CN apt mirror

36c95c749 fix(cli): restore repo-add execution and HBA validation failure propagation

797385929 add macbook local vagrant image override

f9c928e32 fix(grafana): restore reverted dashboard bugfixes

c11af8b6a Bump version to v4.1.0

307a236ba update extension list

f17024807 override el9/u24 vagrant box for convient testing

c2ada1283 terraform: bump Aliyun Debian images to 12.13/13.3

25bd8210f fix(node): add daemon_reload to systemd tasks for keepalived, chronyd, and cron

6f2576fd0 fix(node): set default fs.nr_open via node_sysctl_params

43a71245e add pg_bgwriter_buffers_backend for pg 17-

da832a47b fix(monitor): keep checkpointer metrics for checkpoint stats

90434ca8a fix(monitor): add pg_bgwriter fallback for checkpointer metrics

e2d75e787 fix(monitor): use pg_checkpointer metrics for checkpoint stats

a0b7474f8 fix grafana dashboard metrics and lengend

27ddacbc6 vagrant: refresh box selector and OS shortcuts

26e108788 fix(monitor): correct unit for time metrics scaled by pg_exporter

ee90044b5 fix(pgsql): correct min_parallel scan size params in oltp/crit templates

d439464b2 pgsql: fix pg_version guards for PG18-only settings

26320f120 docs: recommend RockyLinux 10.1

1e9b9f33a terraform: bump Aliyun Rocky images to 9.7/10.1

d6e9c7122 monitor: optimize table/index bloat estimators

42d45d32e fix(grafana): align panel semantics across node/infra/redis

3972d2c45 fix(grafana/pgsql): align dashboard semantics for query monitoring

cb52375ac bump checkpoint_completion_target from 0.90 to 0.95

13115a95d fix legend in pgsql-persist checkpoint panel

102cd2edb fix(pg_migration): make template logging format-safe

c402f0e6d fix: correct io_method/io_workers version guard from PG17 to PG18

3bf676546 vibe: disable jupyter by default and install claude-code via npm_packages

613c4efa9 fix: set fs.nr_open in tuned profiles and reduce LimitNOFILE to 8M

07e499d4d new app conf template matter most

4cc68ed61 Refine infra removal playbook

7cfb98f69 fix: app docker .env file format

9b36b1875 Fix config templates and validation

318d85e6e Simplify VIP parsing and make pg_exporter non-blocking

571cd9e70 Use hostname module for nodename

de98f073c Fix blackbox config filename and pgpass format

4bff01100 Fix redis replicaof guard and systemd stop

38445b68d minio: increase health check retries

c99854969 docs(etcd): clarify TLS vs mTLS

41229124a fix pgsql roles typo

e575d17c6 fix pg_migration scripts to use fully qualified identifiers

ec4207202 fix pgsql-schema broken links

a237e6c99 tune autovacuum threshold to reduce small table vacuum frequency

e80754760 fix pgcat-database links to pgcat-table https://github.com/pgsty/pigsty/issues/690

0060f5346 fix pgsql-database / pgsql-databases age metric fix https://github.com/pgsty/pigsty/issues/695

43cdf72bc fix pigsty.yml typo

0d9db7b08 fix: update datasource to $dsn - fix https://github.com/pgsty/pigsty/issues/692#issuecomment-3835461620

致谢

感谢 @l2dy 为本项目提出诸多改进意见与 Issue。 校验和

8bc75e8df0e3830931f2ddab71b89630 pigsty-v4.1.0.tgz

da10de99d819421630f430d01bc9de62 pigsty-pkg-v4.1.0.d12.aarch64.tgz

e1f2ed2da0d6b8c360f9fa2faaa7e175 pigsty-pkg-v4.1.0.d12.x86_64.tgz

382bb38a81c138b1b3e7c194211c2138 pigsty-pkg-v4.1.0.d13.aarch64.tgz

13ceaa728901cc4202687f03d25f1479 pigsty-pkg-v4.1.0.d13.x86_64.tgz

92d061de4d495d05d42f91e4283e7502 pigsty-pkg-v4.1.0.el10.aarch64.tgz

be629ea91adf86bbd7e1c59b659d0069 pigsty-pkg-v4.1.0.el10.x86_64.tgz

c14be706119ba33dd06c71dda6c02298 pigsty-pkg-v4.1.0.el8.aarch64.tgz

0c8b6952ffc00e3b169896129ea39184 pigsty-pkg-v4.1.0.el8.x86_64.tgz

cfcc63b9ecc525165674f58f9365aa19 pigsty-pkg-v4.1.0.el9.aarch64.tgz

34f733080bfa9c8515d1573c35f3e870 pigsty-pkg-v4.1.0.el9.x86_64.tgz

ad52ce9bf25e4d834e55873b3f9ada51 pigsty-pkg-v4.1.0.u22.aarch64.tgz

300b2185c61a03ea7733248e526f3342 pigsty-pkg-v4.1.0.u22.x86_64.tgz

2e561e6ae9abb14796872059d2f694a8 pigsty-pkg-v4.1.0.u24.aarch64.tgz

c462bb4cb2359e771ffcad006888fbd4 pigsty-pkg-v4.1.0.u24.x86_64.tgz

v4.0.0 curl https://pigsty.cc/get | bash -s v4.0.0

318 个提交 ,604 文件变更,+118,655 / -327,552 行,发布页面: https://github.com/pgsty/pigsty/releases/tag/v4.0.0

亮点特性

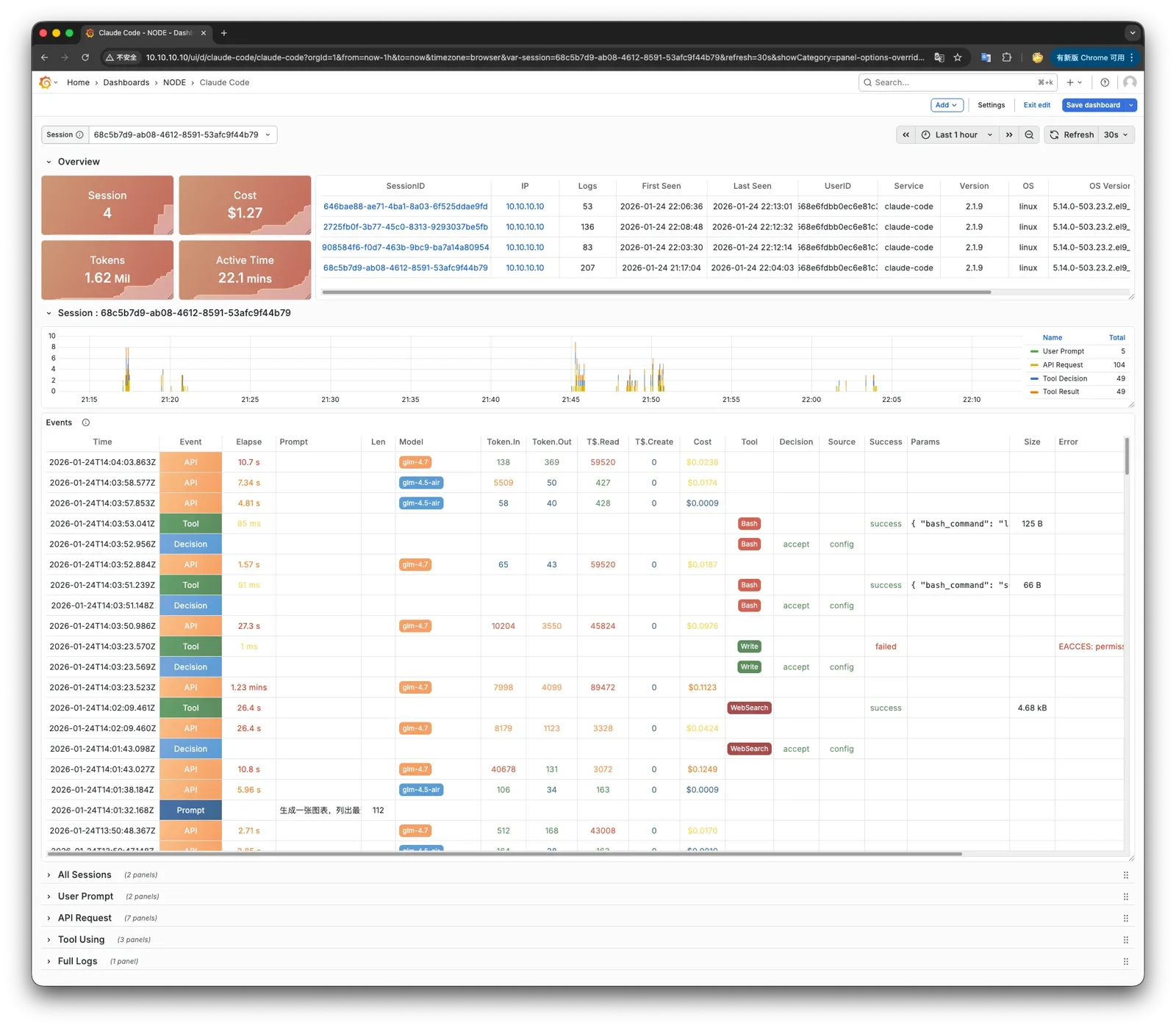

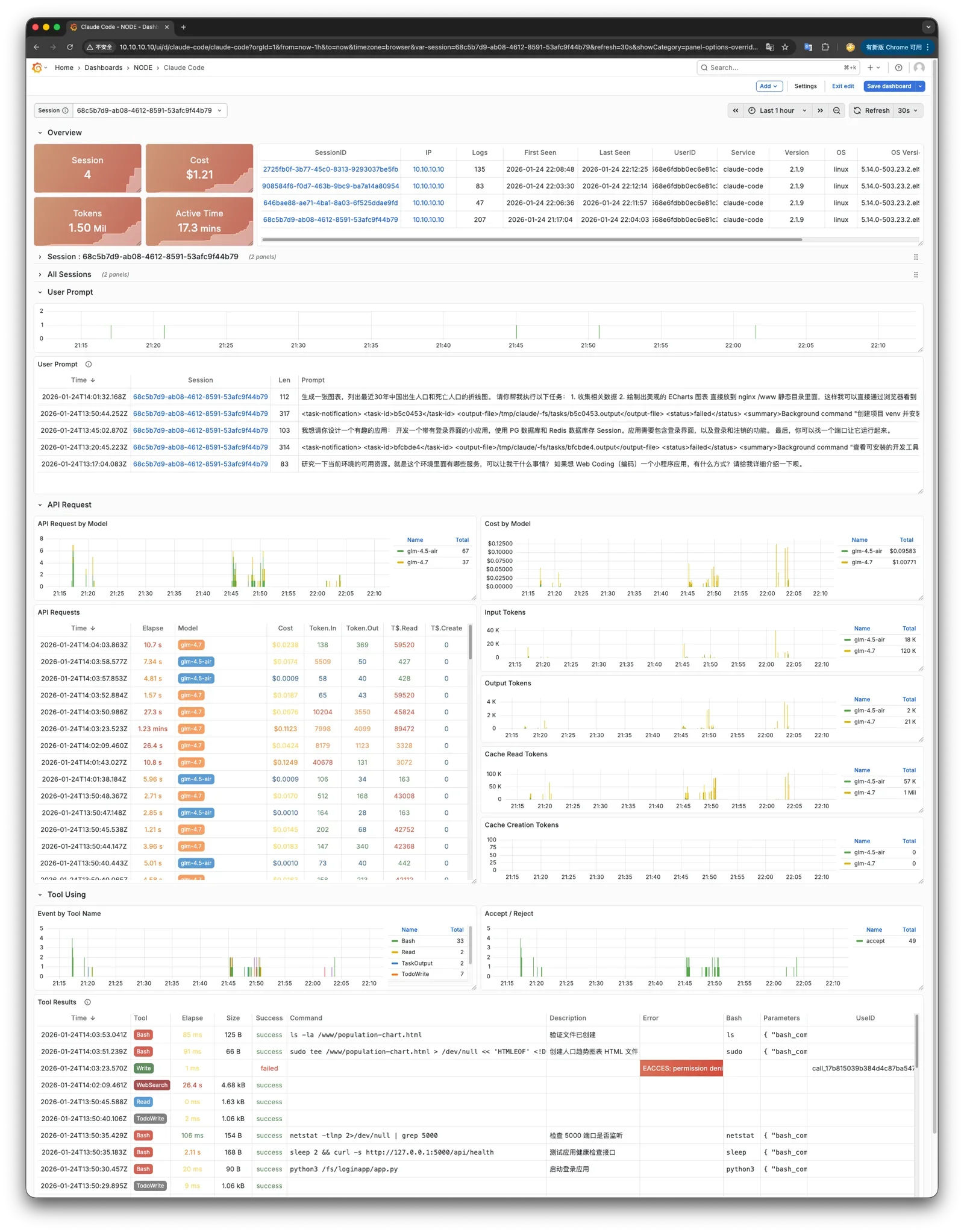

可观测性革命 : Prometheus → VictoriaMetrics(10x 性能提升),Loki + Promtail → VictoriaLogs + Vector安全加固 : 自动生成强密码、etcd RBAC、防火墙/SELinux 模式、权限收紧、Nginx Basic Auth容器支持 :支持在 Docker 容器中运行 Pigsty 本身新增模块 :JUICE,提供将 PG 挂载为文件系统并进行 PITR 的能力新增模块 :VIBE,提供 Claude Code、JupyterLab、VS Code Server、Node.js 的配置与可观测性数据库管理 : pg_databases state(create/absent/recreate)、strategy 瞬间克隆数据库PITR 与分叉 : /pg/bin/pg-fork CoW 瞬间克隆、pg-pitr 增强支持 PITR 前备份高可用增强 : pg_rto_plan 提供四档 RTO 预置参数(fast/norm/safe/wide),pg_crontab 定时任务多云 Terraform : AWS、Azure、GCP、Hetzner、DigitalOcean、Linode、Vultr、腾讯云模板许可证变更 : AGPL-3.0 → Apache-2.0基础设施软件包更新

MinIO 开始使用 pgsty/minio fork RPM/DEB

软件包 版本 软件包 版本 victoria-metrics 1.134.0 victoria-logs 1.43.1 vector 0.52.0 grafana 12.3.1 alertmanager 0.30.1 etcd 3.6.7 duckdb 1.4.4 pg_exporter 1.1.2 pgbackrest_exporter 0.22.0 blackbox_exporter 0.28.0 node_exporter 1.10.2 minio 20251203 pig 1.0.0 claude 2.1.19 opencode 1.1.34 uv 0.9.26 asciinema 3.1.0 prometheus 3.9.1 pushgateway 1.11.2 juicefs 1.4.0 code-server 4.100.2 caddy 2.10.2 hugo 0.154.5 cloudflared 2026.1.1 headscale 0.27.1

新增模块

JUICE 模块 :JuiceFS 分布式文件系统,使用 PostgreSQL 作为元数据引擎,支持利用 PITR 恢复文件系统VIBE 模块 :AI 辅助编程沙箱环境(整合了 Code-Server、JupyterLab、Node.js 与 Claude Code)Code-Server:浏览器中的 VS Code JupyterLab:交互式计算环境 Node.js:JavaScript 运行时环境 Claude Code:AI 编程助手 CLI 配置,内置 OpenTelemetry 可观测性 PostgreSQL 扩展

新扩展 : pg_textsearch 0.4.0, pg_clickhouse 0.1.3, pg_ai_query 0.1.1, etcd_fdw , pg_ttl_index 0.1.0, pljs 1.0.4, pg_retry 1.0.0, pg_weighted_statistics 1.0.0, pg_enigma 0.5.0, pglinter 1.0.1, documentdb_extended_rum 0.109, mobilitydb_datagen 1.3.0

重要更新 : timescaledb 2.24.0, pg_search 0.21.4, citus 14.0.0, documentdb 0.109, age 1.7.0, pg_duckdb 1.1.1, vchord 1.0.0, vchord_bm25 0.3.0, pg_biscuit 2.2.2, pg_anon 2.5.1, wrappers 0.5.7, pg_vectorize 0.26.0, pg_session_jwt 0.4.0, pg_partman 5.4.0, pgmq 1.9.0, pg_bulkload 3.1.23, pg_timeseries 0.2.0, pg_convert 0.1.0, pgBackRest 2.58

破坏性变更

可观测性栈

旧组件 新组件 Prometheus VictoriaMetrics Loki VictoriaLogs Promtail Vector

参数变更

移除 替代 node_disable_firewallnode_firewall_mode (off/none/zone)node_disable_selinuxnode_selinux_mode (disabled/permissive/enforcing)pg_pwd_enc已移除,统一使用 scram-sha-256 infra_pip_packagesnode_pip_packagescode_home/jupyter_homevibe_data

默认值变更

参数 变化 grafana_cleantrue → false effective_io_concurrency1000 → 200 install.yml重命名为 deploy.yml

可观测性

使用全新的 VictoriaMetrics 替代 Prometheus,用几分之一的资源实现数倍的性能 使用全新的日志收集方案:VictoriaLogs + Vector,取代 Promtail + Loki 统一调整了所有组件的日志格式,PG 日志使用 UTC 时间戳(log_timezone) 调整了 PostgreSQL 日志的轮换方式,使用按周循环截断日志轮转模式 在 PG 日志中记录超过 1MB 的临时文件分配,在特定模版中启用 PG 17/18 日志新参数 新增了 Nginx / Syslog / PG CSV / Pgbackrest / Grafana / Redis / etcd / MinIO 等日志的 Vector 解析配置 注册数据源现在会在所有 Infra 节点上进行,Victoria 数据源将自动注册入 Grafana 新增 grafana_pgurl 参数,允许指定 Grafana 使用 PG 作为后端存储元数据库 新增 grafana_view_password 参数,指定 Grafana Meta 数据源使用的密码 pgbackrest_exporter 的默认选项现在设置 120 秒的内部缓存间隔(原本为 600s)grafana_clean 参数的默认值现在由 true 改为 false,即默认不清除新增指标收集器 pg_timeline,收集更实时的时间线指标 pg_timeline_id pg_exporter 更新至 1.1.2,新增 pg_timeline 采集器,修复大量历史遗留问题新增 node-vector 仪表盘,监控 Vector 日志收集器状态 新增 node-juice 仪表盘,监控 JuiceFS 分布式文件系统状态 新增 claude-code 仪表盘,监控 Claude Code AI 编程助手使用情况 PGSQL Cluster/Instance 仪表盘新增版本横幅显示 所有仪表盘使用 compact JSON 格式,大幅减少文件体积 接口改进

install.yml 剧本现在重命名为 deploy.yml 以更符合语义新增 vibe.yml 剧本,用于部署 VIBE AI 编程沙箱环境 pg_databases 数据库制备功能改进添加删库能力:可以使用 state 字段指定 create, absent, recreate 三种状态 添加克隆能力:数据库定义中使用 strategy 参数指定克隆方法 支持较新版本引入的 locale 配置参数:locale_provider,icu_locale,icu_rules,builtin_locale 支持 is_template 参数,将数据库标记为模板数据库 添加了更多类型检查,避免了字符类参数的注入 允许在 extension 中指定 state: absent 以删除扩展 pg_users 用户制备功能改进,新增参数 admin,类似 roles,但是带有 ADMIN OPTION 权限可以转授pg_hba 支持 order 字段,允许指定 HBA 规则的排序优先级,支持 IPv6 的 localhost 访问新增 infra_extra_services 参数用于首页额外服务入口导航 参数优化

pg_io_method 参数:auto, sync, worker, io_uring 四种方式可选,默认 workermaintenance_io_concurrency 设置为 100(如果使用 SSD)effective_io_concurrency 从 1000 减小为 200file_copy_method 参数为 PG18 默认设置为 clone,提供瞬间克隆数据库的能力idle_replication_slot_timeout 默认 7d,crit 模板 3dlog_lock_failures:oltp, crit 模版开启track_cost_delay_timing:olap, crit 模版开启log_connections:oltp/olap 开启认证日志,crit 开启全部日志新增 pg_rto_plan 参数,整合 Patroni 与 HAProxy 的 RTO 相关配置(fast/norm/safe/wide) pg_crontab 参数:为 postgres dbsu 配置定时任务对于 PG17+,如果 pg_checksums 开关关闭,在 Patroni 初始化集群时显式禁用校验和 Crit 模板启用 Patroni 严格同步模式 PITR 默认 archive_mode 改为 preserve,确保恢复后保留归档能力 pg-pitr 支持恢复前自动备份数据修复了 duckdb.allow_community_extensions 总是生效的问题 允许通过 node_firewall_intranet 指定 HBA 信任的 “内网网段” 现在 pg_hba 与 pgbouncer_hba 支持 IPv6 的 localhost 访问 架构改进

在 Infra 节点上,设置固定的 /infra 软连接指向 Infra 数据目录 /data/infra 现在 Infra 的数据默认放置于 /data/infra 目录下,这使得在容器中使用更为便利 本地软件仓库现在放置于 /data/nginx/pigsty,/www 现在作为软链接指向 /data/nginx 确保兼容 DNS 解析记录现在放置于 /infra/hosts 目录下,解决了 Ansible SELinux 竞态问题 默认首页域名从 h.pigsty 更名为 i.pigsty,新增中文首页支持 新增了 /pg/bin/pg-fork 脚本,用于快速创建 CoW 副本数据库实例 调整 /pg/bin/pg-pitr 脚本,现在可以用于实例级别的 PITR 恢复,支持恢复前自动备份 新增 /pg/bin/pg-drop-role 脚本,用于安全删除用户角色 新增 bin/pgsql-ext 脚本,用于安装 PostgreSQL 扩展 恢复 pg-vacuum 和 pg-repack 脚本 新增剧本 juice.yml:部署 JuiceFS 分布式文件系统实例 新增剧本 vibe.yml:部署 VIBE AI 编程沙箱环境(含 Code-Server、JupyterLab、Claude Code) 显式安装 cron/cronie 包,确保定时任务功能在最小化安装的系统上可用 UV Python 包管理器从 infra 模块迁移至 node 模块,新增 node_uv_env 参数指定虚拟环境路径 pg_remove/pg_pitr 移除 etcd 元数据的任务,现在不再依赖 admin_ip 管理节点,而在 etcd 集群上执行36 节点仿真模板 simu 简化为 20 节点的版本 适配上游变化,移除 PGDG sysupdate 仓库,移除 EL 系统上所有 llvmjit 的相关包 为 EPEL 10 / PGDG 9/10 仓库使用操作系统完整版本号(major.minor) 允许在仓库定义中指定 meta 参数,覆盖 yum 仓库的定义元数据 确保 Vagrant libvirt 模板默认带有 128GB 磁盘,以 xfs 挂载于 /data 确保 pgbouncer 不再将 0.0.0.0 监听地址修改为 * 新增 10 节点、Citus 等 Vagrant 配置模板 恢复 EL7 系统兼容性支持 多云 Terraform 模板:AWS、Azure、GCP、Hetzner、DigitalOcean、Linode、Vultr、腾讯云 安全改进

configure 现在支持 -g 参数自动生成随机强密码,避免使用默认密码带来的安全隐患更改了 MinIO 模块的默认密码,避免与众所周知的默认密码冲突 移除 node_disable_firewall,新增 node_firewall_mode,支持 off, none, zone 三种模式 移除 node_disable_selinux,新增 node_selinux_mode,支持 disabled, permissive, enforcing 三种模式 为 HAProxy、Nginx、DNSMasq、Redis 等组件配置了正确的 SELinux 上下文 启用了针对 etcd 的 RBAC,每个集群现在只能管理自己的 PostgreSQL 数据库集群 etcd root 密码现在放置于 /etc/etcd/etcd.pass 文件中,仅对管理员可读 将 admin_ip 添加到 Patroni API 允许访问的 IP 列表白名单中 总是创建 admin 系统用户组,patronictl 配置收紧为仅限 admin 组用户访问 新增 node_admin_sudo 参数,允许指定/调整数据库管理员的 sudo 权限模式(all/nopass) 收回了所有非 root 用户对可执行脚本的拥有权限 新增 Nginx Basic Auth 支持,可以为 Nginx Server 设置可选的 HTTP Basic Auth 修复 ownca 证书有效期问题,确保了 Chrome 可以识别自签名证书 新增 vip_auth_pass 参数用于 VRRP 认证 修复了若干 ansible copy content 字段为空时报错的问题 修复了 pg_pitr 中遗留的一些问题,确保 Patroni 集群恢复时没有竞态条件 使用 mode 0700 保护 files/pki/ca 目录 问题修复

修复 ownca 证书有效期 Chrome 兼容性问题 修复 Vector 0.52 syslog_raw 解析问题 修复 pg_pitr 多副本 clonefrom 时序问题 修复 Ansible SELinux dnsmasq 竞态条件 修复 EL9 aarch64 patroni & llvmjit 问题 修复 Debian groupadd 路径问题 修复空 sudoers 文件生成问题 修复 pgbouncer pid 路径(/run/postgresql) 修复 duckdb.allow_community_extensions 始终生效问题 因上游问题隐藏 EL8 上的 pg_partman 扩展 修复 HAProxy 服务模板变量路径 修复 Redis remove 任务变量名 移除 MinIO reload handler 无效处理器 修正 vmetrics_port 默认值为 8428 修复 pg-failover-callback 脚本处理所有 Patroni 回调事件 修复 pg-vacuum 事务块处理逻辑 添加 PG16+ 并行逻辑复制支持 修复 FerretDB 证书配置和服务重启策略 修正 Polar Exporter 监控指标类型定义 修复代理环境变量未传递问题 修复移除模式下 postgres 服务配置 更新 Docker 默认数据目录路径 修复 EL10 系统上的缓存问题 修复 etcd/MinIO 移除时 systemd 服务和 DNS 条目清理 新增参数

参数 类型 默认值 说明 node_firewall_modeenum none (v4.0) 防火墙模式:off/none/zone(v4.1 起默认 zone) node_selinux_modeenum permissive SELinux 模式 node_firewall_intranetstring - HBA 信任的内网网段 node_admin_sudoenum nopass 管理员 sudo 权限级别 pg_io_methodenum worker I/O 方法:auto/sync/worker/io_uring pg_rto_plandict - RTO 预设:fast/norm/safe/wide pg_crontablist [] postgres dbsu 定时任务 vip_auth_passstring - VRRP 认证密码 grafana_pgurlstring - Grafana PG 后端连接字符串 grafana_view_passwordstring DBUser.Viewer Grafana Meta 数据源密码 infra_extra_serviceslist [] 首页额外服务入口 juice_cachepath /data/juice JuiceFS 共享缓存目录 juice_instancesdict {} JuiceFS 实例定义 vibe_datapath /fs VIBE 工作空间目录 code_enabledbool true 是否启用 Code-Server code_portport 8443 Code-Server 监听端口 code_datapath /data/code Code-Server 数据目录 code_passwordstring Vibe.Coding Code-Server 登录密码 code_galleryenum openvsx 扩展市场:openvsx/microsoft jupyter_enabledbool true 是否启用 JupyterLab jupyter_portport 8888 JupyterLab 监听端口 jupyter_datapath /data/jupyter JupyterLab 数据目录 jupyter_passwordstring Vibe.Coding JupyterLab 登录 Token jupyter_venvpath /data/venv Python 虚拟环境路径 claude_enabledbool true 是否启用 Claude Code 配置 claude_envdict {} Claude Code 额外环境变量 nodejs_enabledbool true 是否启用 Node.js 安装 nodejs_registrystring '' npm registry,自动配置中国镜像 node_uv_envpath /data/venv 节点 UV 虚拟环境路径,空则跳过 node_pip_packagesstring '' UV 虚拟环境中安装的 pip 包

兼容性

操作系统 x86_64 aarch64 EL 8/9/10 ✅ ✅ Debian 11/12/13 ✅ ✅ Ubuntu 22.04/24.04 ✅ ✅

PostgreSQL : 13, 14, 15, 16, 17, 18

校验和

9f42b8c64180491b59bd03016c26e8ca pigsty-v4.0.0.tgz

db9797c3c8ae21320b76a442c1135c7b pigsty-pkg-v4.0.0.d12.aarch64.tgz

1eed26eee42066ca71b9aecbf2ca1237 pigsty-pkg-v4.0.0.d12.x86_64.tgz

03540e41f575d6c3a7c63d1d30276d49 pigsty-pkg-v4.0.0.d13.aarch64.tgz

36a6ee284c0dd6d9f7d823c44280b88f pigsty-pkg-v4.0.0.d13.x86_64.tgz

f2b6ec49d02916944b74014505d05258 pigsty-pkg-v4.0.0.el10.aarch64.tgz

73f64c349366fe23c022f81fe305d6da pigsty-pkg-v4.0.0.el10.x86_64.tgz

287f767fbb66a9aaca9f0f22e4f20491 pigsty-pkg-v4.0.0.el8.aarch64.tgz

c0886aab454bd86245f3869ef2ab4451 pigsty-pkg-v4.0.0.el8.x86_64.tgz

094ab31bcf4a3cedbd8091bc0f3ba44c pigsty-pkg-v4.0.0.el9.aarch64.tgz

235ccba44891b6474a76a81750712544 pigsty-pkg-v4.0.0.el9.x86_64.tgz

f2791c96db4cc17a8a4008fc8d9ad310 pigsty-pkg-v4.0.0.u22.aarch64.tgz

3099c4453eef03b766d68e04b8d5e483 pigsty-pkg-v4.0.0.u22.x86_64.tgz

49a93c2158434f1adf0d9f5bcbbb1ca5 pigsty-pkg-v4.0.0.u24.aarch64.tgz

4acaa5aeb39c6e4e23d781d37318d49b pigsty-pkg-v4.0.0.u24.x86_64.tgz

v3.7.0 亮点特性

PostgreSQL 18 深度支持,成为默认 PG 大版本,扩展已就位! 新增 EL10 / Debian 13 操作系统支持,总数达 14 个! 新增 PostgresQL 扩展数量,总数达到 437 个! 支持了 Ansible 2.19 破坏性重构以后的版本! Supabase,PolarDB, IvorySQL, Percona 内核更新至最新版本! 优化了 PG 默认参数的设置逻辑,更充分利用资源。 版本更新

PostgreSQL 18.1, 17.7, 16.11, 15.15, 14.20, 13.23 Patroni 4.1.0 Pgbouncer 1.25.0 pg_exporter 1.0.3 pgbackrest 2.57.0 Supabase 2025-11 PolarDB 15.15.5.0 FerretDB 2.7.0 DuckDB 1.4.2 Etcd 3.6.6 pig 0.7.4 更多软件版本更新信息,请参考:

API变化

为并行执行的相关参数设置了更合理的优化策略,详见 调参说明 在 rich 与 full 模板中,不再默认安装 citus 扩展,因为 citus 尚未支持 PG 18 PG 参数模板中,新增 duckdb 系列扩展存根。 为 min_wal_size, max_wal_size, max_slot_wal_keep_size 设置 200,2000,3000 GB 的封顶上限值。 为 temp_file_limit 设置 200 GB 的封顶上限,OLAP 设置为 2 TB。 适当增大连接池默认链接数量 新增 prometheus_port 参数,且默认值为 9058,避开与 EL10 RHEL Web Console 端口的冲突。 修改 alertmanager_port 参数的默认值为 9059,避开与 Kafka SSL 端口的潜在冲突。 新增 pg_pkg 的 pg_pre 子任务,在安装 PG 包前移除 el9+ 上导致 LLVM 冲突的 bpftool, python3-perf 在 Debian / Ubuntu 的默认仓库定义中新增 llvm 仓库模块 修复了 infra-rm.yml 移除软件包的逻辑 兼容性修复

修复了 Ubuntu/Debian 信任 CA 时 Warning 返回码错误的问题。 修复了 Ansible 2.19 引入的大量兼容性问题,确保在新老版本上正常运行。 为 seq 类变量添加了 int 类型转换,确保兼容 将大量 with_items 修改为 loop 语法,确保兼容 为密钥交换变量添加一层列表嵌套,避免在新版本下针对字符串进行字符迭代。 将 range 用例显式转换为 list 后使用 修改了 name,port 等标记保留的变量命名 将 play_hosts 修改为 ansible_play_hosts 为部分字符串类型添加了 string 强制类型转换,避免运行时错误。 EL10 逻辑适配: 修复了 EL10 缺少 ansible-collection-community-crypto 无法生成密钥的问题 修复了 EL10 缺少 ansible 逻辑包的问题 移除 modulemd_tools flamegraph timescaledb-tool 使用 java-21-openjdk 替代 java-17-openjdk aarch64 YUM 仓库名称问题 Debian 13 逻辑适配 使用 bind9-dnsutils 替代 dnsutils Ubuntu 24 修复 临时移除了上游依赖崩溃的 tcpdump 包 校验和

e00d0c2ac45e9eff1cc77927f9cd09df pigsty-v3.7.0.tgz

987529769d85a3a01776caefefa93ecb pigsty-pkg-v3.7.0.d12.aarch64.tgz

2d8272493784ae35abeac84568950623 pigsty-pkg-v3.7.0.d12.x86_64.tgz

090cc2531dcc25db3302f35cb3076dfa pigsty-pkg-v3.7.0.d13.x86_64.tgz

ddc54a9c4a585da323c60736b8560f55 pigsty-pkg-v3.7.0.el10.aarch64.tgz

d376e75c490e8f326ea0f0fbb4a8fd9b pigsty-pkg-v3.7.0.el10.x86_64.tgz

8c2deeba1e1d09ef3d46d77a99494e71 pigsty-pkg-v3.7.0.el8.aarch64.tgz

9795e059bd884b9d1b2208011abe43cd pigsty-pkg-v3.7.0.el8.x86_64.tgz

08b860155d6764ae817ed25f2fcf9e5b pigsty-pkg-v3.7.0.el9.aarch64.tgz

1ac430768e488a449d350ce245975baa pigsty-pkg-v3.7.0.el9.x86_64.tgz

e033aaf23690755848db255904ab3bcd pigsty-pkg-v3.7.0.u22.aarch64.tgz

cc022ea89181d89d271a9aaabca04165 pigsty-pkg-v3.7.0.u22.x86_64.tgz

0e978598796db3ce96caebd76c76e960 pigsty-pkg-v3.7.0.u24.aarch64.tgz

48223898ace8812cc4ea79cf3178476a pigsty-pkg-v3.7.0.u24.x86_64.tgz

v3.6.1 curl https://repo.pigsty.cc/get | bash -s v3.6.1

亮点特性

PostgreSQL 17.6, 16.10, 15.14, 14.19, 13.22, 以及 18 Beta 3 支持 在中国大陆地区使用 Pigsty 提供的 PGDG APT/YUM 镜像解决更新断供问题。 新的网站首页: https://pgsty.com 增加了 el10, debian 13 的实现存根,以及 el10 的 Terraform 镜像 基础设施软件包更新

Grafana 12.1.0 pg_exporter 1.0.2 pig 0.6.1 vector 0.49.0 redis_exporter 1.75.0 mongo_exporter 0.47.0 victoriametrics 1.123.0 victorialogs: 1.28.0 grafana-victoriametrics-ds 0.18.3 grafana-victorialogs-ds 0.19.3 grafana-infinity-ds 3.4.1 etcd 3.6.4 ferretdb 2.5.0 tigerbeetle 0.16.54 genai-toolbox 0.12.0 数据库软件包更新

API变更

从 node_kernel_modules 默认值中移除 br_filter 内核模块。 在添加 PGDG YUM 源时使用操作大版本号,不再使用小版本号。 校验和

045977aff647acbfa77f0df32d863739 pigsty-pkg-v3.6.1.d12.aarch64.tgz

636b15c2d87830f2353680732e1af9d2 pigsty-pkg-v3.6.1.d12.x86_64.tgz

700a9f6d0db9c686d371bf1c05b54221 pigsty-pkg-v3.6.1.el8.aarch64.tgz

2aff03f911dd7be363ba38a392b71a16 pigsty-pkg-v3.6.1.el8.x86_64.tgz

ce07261b02b02b36a307dab83e460437 pigsty-pkg-v3.6.1.el9.aarch64.tgz

d598d62a47bbba2e811059a53fe3b2b5 pigsty-pkg-v3.6.1.el9.x86_64.tgz

13fd68752e59f5fd2a9217e5bcad0acd pigsty-pkg-v3.6.1.u22.aarch64.tgz

c25ccfb98840c01eb7a6e18803de55bb pigsty-pkg-v3.6.1.u22.x86_64.tgz

0d71e58feebe5299df75610607bf428c pigsty-pkg-v3.6.1.u24.aarch64.tgz

4fbbab1f8465166f494110c5ec448937 pigsty-pkg-v3.6.1.u24.x86_64.tgz

083d8680fa48e9fec3c3fcf481d25d2f pigsty-v3.6.1.tgz

v3.6.0 curl https://repo.pigsty.cc/get | bash -s v3.6.0

亮点特性

全新文档站: https://doc.pgsty.com 新增 pgsql-pitr 剧本与备份/恢复教程,改善 PITR 体验, 新增内核支持:Percona PG TDE (PG17) 优化 Supabase 自建体验,更新至最新版本,并解决了一系列官方模板的问题 简化安装步骤,默认使用在线安装,更加高效简单,bootstrap 过程(安装ansible)嵌入安装脚本中 设计改进

改善了 Etcd 模块的实现,新增独立的 etcd-rm.yml 剧本与扩缩容 SOP 脚本。 改善了 MinIO 模块的实现,支持 HTTP 模式,创建不同属性的三个桶供开箱即用 重新调整梳理了所有配置模板,使用更为便利 针对中国大陆使用速度更快的 Docker Registry 镜像站 优化了 tuned 操作系统参数模板,针对现代硬件与 NVMe 磁盘优化 新增扩展 pgactive 用于多主复制与亚秒级故障切换 调整 pg_fs_main / pg_fs_backup 默认值,简化文件目录结构设计 问题修复

修复了 pgbouncer 配置文件的错误 by @housei-zzy 修复了 OrioleDB 在 Debian 平台上的问题 修复了 tuned shm 配置参数的问题 离线软件包直接使用 PGDG 源,避免使用断开同步的镜像站点 修复了 IvorySQL libxcrypt 依赖的问题 替换了破损与缓慢的 EPEL 软件仓库站点 修复了 haproxy_enabled 标记位的功能 基础设施软件包更新

新增 Victoria Metrics / Victoria Logs 相关包

genai-toolbox 0.9.0 (new) victoriametrics 1.120.0 -> 1.121.0 (重构) vmutils 1.121.0 (重命名 victoria-metrics-utils) grafana-victoriametrics-ds 0.15.1 -> 0.17.0 victorialogs 1.24.0 -> 1.25.1 (重构) vslogcli 1.24.0 -> 1.25.1 vlagent 1.25.1 (新增) grafana-victorialogs-ds 0.16.3 -> 0.18.1 prometheus 3.4.1 -> 3.5.0 grafana 12.0.0 -> 12.0.2 vector 0.47.0 -> 0.48.0 grafana-infinity-ds 3.2.1 -> 3.3.0 keepalived_exporter 1.7.0 blackbox_exporter 0.26.0 -> 0.27.0 redis_exporter 1.72.1 -> 1.77.0 rclone 1.69.3 -> 1.70.3 数据库软件包更新

PostgreSQL 18 Beta2 更新 pg_exporter 1.0.1,更新至最新依赖并提供 Docker 镜像 pig 0.6.0,更新了最新扩展与仓库列表,带有 pig install 子命令 vip-manager 3.0.0 -> 4.0.0 ferretdb 2.2.0 -> 2.3.1 dblab 0.32.0 -> 0.33.0 duckdb 1.3.1 -> 1.3.2 etcd 3.6.1 -> 3.6.3 ferretdb 2.2.0 -> 2.4.0 juicefs 1.2.3 -> 1.3.0 tigerbeetle 0.16.41 -> 0.16.50 pev2 1.15.0 -> 1.16.0 PG扩展包更新

OrioleDB 1.5 beta12 OriolePG 17.11 plv8 3.2.3 -> 3.2.4 postgresql_anonymizer 2.1.1 -> 2.3.0 pgvectorscale 0.7.1 -> 0.8.0 wrappers 0.5.0 -> 0.5.3 supautils 2.9.1 -> 2.10.0 citus 13.0.3 -> 13.1.0 timescaledb 2.20.0 -> 2.21.1 vchord 0.3.0 -> 0.4.3 pgactive 2.1.5 (new) documentdb 0.103.0 -> 0.105.0 pg_search 0.17.0 API变更

pg_fs_backup:重命名为 pg_fs_backup,默认值为 /data/backups。pg_rm_bkup:重命名为 pg_rm_backup,默认值为 true。pg_fs_main:现在默认值调整为 /data/postgres。nginx_cert_validity:新增参数,用于控制 Nginx 自签名证书的有效期,默认为 397d。minio_buckets:默认值调整为创建名为 pgsql、meta、data 的三个桶。minio_users:移除 dba 用户,新增 s3user_meta 和 s3user_data 用户,分别对应 meta 和 data 桶。minio_https:新增参数,允许配置 MinIO 使用 HTTP 模式。minio_provision:新增参数,允许跳过 MinIO 置备阶段(跳过桶和用户的创建)。minio_safeguard:新增参数,启用后会在执行 minio-rm.yml 时中止操作。minio_rm_data:新增参数,控制在执行 minio-rm.yml 时是否删除 minio 数据目录。minio_rm_pkg:新增参数,控制在执行 minio-rm.yml 时是否卸载 minio 软件包。etcd_learner:新增参数,允许 etcd 以学习者身份初始化。etcd_rm_data:新增参数,控制在执行 etcd-rm.yml 时是否删除 etcd 数据目录。etcd_rm_pkg:新增参数,控制在执行 etcd-rm.yml 时是否卸载 etcd 软件包。校验和

df64ac0c2b5aab39dd29698a640daf2e pigsty-v3.6.0.tgz

cea861e2b4ec7ff5318e1b3c30b470cb pigsty-pkg-v3.6.0.d12.aarch64.tgz

2f253af87e19550057c0e7fca876d37c pigsty-pkg-v3.6.0.d12.x86_64.tgz

0158145b9bbf0e4a120b8bfa8b44f857 pigsty-pkg-v3.6.0.el8.aarch64.tgz

07330d687d04d26e7d569c8755426c5a pigsty-pkg-v3.6.0.el8.x86_64.tgz

311df5a342b39e3288ebb8d14d81e0d1 pigsty-pkg-v3.6.0.el9.aarch64.tgz

92aad54cc1822b06d3e04a870ae14e29 pigsty-pkg-v3.6.0.el9.x86_64.tgz

c4fadf1645c8bbe3e83d5a01497fa9ca pigsty-pkg-v3.6.0.u22.aarch64.tgz

5477ed6be96f156a43acd740df8a9b9b pigsty-pkg-v3.6.0.u22.x86_64.tgz

196169afc1be02f93fcc599d42d005ca pigsty-pkg-v3.6.0.u24.aarch64.tgz

dbe5c1e8a242a62fe6f6e1f6e6b6c281 pigsty-pkg-v3.6.0.u24.x86_64.tgz

v3.5.0 亮点特性

支持 PG 18 (Beta),扩展更新,总数达到 421 个 OrioleDB 与 OpenHalo 内核在全平台上可用 可使用 pig do 子命令代替 bin 脚本 Supabase 自建加强,解决若干遗留问题,例如复制延迟与密钥分发 代码重构与架构优化,优化了 Postgres 与 Pgbouncer 默认参数 更新了 Grafana 12, pg_exporter 1.0 与相关插件,翻修面板 curl https://repo.pigsty.cc/get | bash -s v3.5.0

支持 PostgreSQL 18 通过 pg_exporter 1.0.0 支持 PG18 监控指标 通过 pig 0.4.1 支持 PG18 安装 Alias。 提供 pg18 配置模板 重构 pgsql 模块 PGSQL 重构,将 PG 监控抽离为单独的 pg_monitor 角色,移除 clean 逻辑 去除冗余重复的任务,合并同类项,精简配置。移除 dir/utils 任务块 所有扩展默认安装至 extensions 模式中(与 supabase 安全实践保持一致) 重命名模板文件,移除所有 .j2 后缀 为所有模板中的 monitor 函数添加 SET 命令清空 search_path,遵循 Supabase 安全最佳实践。 调整 pgbouncer 默认参数,增大默认链接池大小,设置链接池清理查询。 新增参数 pgbouncer_ignore_param ,允许配置 pgbouncer 忽略的参数列表 新增任务 pg_key 用于生成 pgsodium 所需的服务端密钥 针对 PG 17 默认启用 sync_replication_slots 重新调整了子任务标签,使其更符合配置小节的拆分逻辑 重构 pg_remove 模块 重命名参数:pg_rm_data, pg_rm_bkup, pg_rm_pkg 用于控制删除的内容 重新调整角色代码结构,使用更清楚的标签进行划分 新增 pg_monitor 模块 pgbouncer_exporter 现在不再和 pg_exporter 共享配置文件新增了 TimescaleDB, Citus,pg_wait_event 的监控指标。 使用 pg_exporter 1.0.0 ,更新了 PG16/17/18 相关监控指标。 使用更为紧凑,全新设计的指标收集器配置文件。 Supabase 加强 (感谢来自 @lawso017 的贡献!) 将 Supabase 容器镜像与数据库模式更新至最新版本 现在默认支持 pgsodium 服务端密钥加载 通过 supa-kick 定时任务解决 logflare 无法及时更新复制进度的问题 为 monitor 模式中的函数添加 set search_path 子句以遵循安全最佳实践 CLI 新增 pig do 命令,允许通过命令行工具替代 bin/ 中的 Shell 脚本 监控系统更新 更新 Grafana 大版本至 12.0.0,更新相关插件/数据源软件包 更新 Postgres 数据源 uid 命名方式(以适应新的 uid 长度限制与字符限制) 新增了 Static Datasource 更新了现有 Dashboard,修复若干遗留问题 基础设施软件包更新

pig 0.4.2 duckdb 1.3.0 etcd 3.6.0 vector 0.47.0 minio 20250422221226 mcli 20250416181326 pev 1.5.0 rclone 1.69.3 mtail 3.0.8 (new) 可观测性软件包更新

grafana 12.0.0 grafana-victorialogs-ds 0.16.3 grafana-victoriametrics-ds 0.15.1 grafana-infinity-ds 3.2.1 grafana_plugins 12.0.0 prometheus 3.4.0 pushgateway 1.11.1 nginx_exporter 1.4.2 pg_exporter 1.0.0 pgbackrest_exporter 0.20.0 redis_exporter 1.72.1 keepalived_exporter 1.6.2 victoriametrics 1.117.1 victoria_logs 1.22.2 数据库软件包更新

PostgreSQL 17.5, 16.9, 15.13, 14.18, 13.21 PostgreSQL 18beta1 支持 pgbouncer 1.24.1 pgbackrest 2.55 pgbadger 13.1 Postgres 扩展包更新